- •200106 «Информационно-измерительная техника и технологии»

- •Введение

- •1.2. Сигналы

- •1.3. Преобразование измерительных сигналов

- •1.4. Спектр периодических сигналов

- •1.5. Модуляция

- •1.5.1. Амплитудная модуляция

- •1.5.2. Частотная модуляция

- •1.5.3. Фазовая модуляция

- •1.5.4. Двукратные виды модуляции

- •1.6. Квантование

- •1.6.1. Квантование по уровню

- •1.6.2. Квантование по времени

- •1.6.3. Квантование по уровню и времени

- •1.7. Кодирование

- •1.7.1. Цифровые коды

- •1.7.2. Помехи

- •1.8. Модель канала

- •Раздел 2 измерительные каналы и их разделение

- •2.1. Канал связи и его характеристики

- •2.2. Согласование канала с источником информации

- •2.3. Линии связи для передачи измерительной информации

- •2.4. Структуры линий связи

- •2.5. Многоканальные системы для передачи измерительной информации

- •2.6. Погрешность систем с частотным разделением каналов

- •2.7. Погрешности систем с временным разделением каналов

- •Раздел 3 принципы обработки данных

- •3.1. Виды погрешностей

- •3.2. Обработка результатов измерений. Оценки измеряемой величины

- •3.3. Обработка результатов прямых равноточных измерений

- •3.4. Обработка результатов косвенных измерений

- •3.5. Обработка результатов совместных измерений

- •3.6. Обработка результатов неравноточных измерений

- •3.7. Проверка статистических гипотез

- •3.7.1. Проверка соответствия гипотезы и экспериментальных данных

- •3.7.2. Исключение резко отклоняющихся значений

- •3.8. Построение эмпирических распределений

- •3.9. Критерии согласия

- •3.9.1. Критерий согласия Пирсона

- •3.9.2. Критерий согласия Колмогорова

- •Раздел 4 планирование многофакторного эксперимента

- •4.1. Задачи планирования эксперимента

- •4.2. Пассивные эксперименты

- •4.3. Дисперсионный анализ

- •4.4. Регрессионный анализ

- •4.5. Активный эксперимент

- •4.6. Полный факторный эксперимент

- •4.7. Дробный факторный эксперимент

- •4.8. Устранение влияния временного дрейфа

- •4.9. Проведение факторного эксперимента и обработка его результатов

- •4.10. Оптимизация

- •4.11. Рандомизация

- •Раздел 5 введение в алгоритмическую теорию измерений

- •5.1. Вводные замечания

- •5.2. Развитие понятий числа и измерения величин

- •5.3. Теория шкал и алгоритмические измерения

- •5.4. Алгоритмы измерения в номинальной шкале, аддитивной и порядка

- •5.5. Моделирование цифровых алгоритмических измерений

- •5.6. Эквивалентность между фильтрацией и алгоритмическим измерением

- •5.7. Моделирование сигналов. Дискретизация

- •5.7.1. Модели дискретизации аналогового сигнала

- •5.7.2. Дискретизация с усреднением

- •5.7.3. Дискретизация сигналов конечной длительности

- •5.8. Цифровое представление информации

- •5.9. Системы счисления с иррациональными основаниями

- •5.9.1. Золотая пропорция

- •5.9.2. Числа Фибоначчи

- •5.9.4. Код золотой p-пропорции

- •5.10. Общий алгоритм метрологического кодирования

- •5.10.1. Алгоритм Стахова

- •5.10.2.Фибоначчиевы алгоритмы цифрового метрологического кодирования

- •Раздел 6 введение в информационную теорию измерений

- •6.1. Основные положения теории информации

- •6.1.1. Энтропия

- •6.1.2. Единицы измерения энтропии

- •6.1.3. Условная энтропия (энтропия помехи)

- •6.1.4. Суммирование нескольких погрешностей

- •6.1.5. Явление «краевой эффект». Приближенность информационных оценок каналов передачи информации

- •6.1.6. Основные положения теории информации для характеристики процесса измерения

- •6.2. Сущность измерения

- •6.2.1. Понятие натурального ряда однородных величин

- •6.2.2. Понятие шкалы реперов измеряемой величины

- •6.2.3. Измерение как сужение интервала неопределенности

- •6.3. Измерительные преобразования, функциональные шкалы, единицы измеряемой величины

- •6.3.1. Функциональная шкала измеряемой величины

- •6.3.2. Понятие единицы измерения

- •6.3.3. Метод построения измерительных устройств

- •6.4. Измерительные преобразования и преобразователи

- •6.5. Энтропийное значение погрешности

- •6.5.1. Математическое определение энтропийного значения погрешности

- •6.5.2. Эффективное значение погрешности

- •6.6. Сравнение энтропийного и среднеквадратического значений погрешности для плавных симметричных одномодальных законов распределения погрешностей

- •6.7. Энтропийное значение погрешности – основной критерий точности приборов и измерений

- •6.8. Определение энтропийного значения погрешности на практике

- •6.9. Суммирование погрешностей измерительных устройств

- •6.10. Статистическое суммирование погрешностей при наличии корреляции

- •6.11. Энтропийное значение результирующей погрешности

- •6.12. Суммирование погрешностей с равномерными законами распределения вероятностей

- •6.13. Суммирование погрешностей при равномерном и нормальном законах распределения составляющих результирующей погрешности

- •6.14. Суммирование погрешностей при произвольной степени корреляции и произвольных законах распределения вероятностей составляющих результирующей погрешности

- •И объемов (n) выборок

- •Интервала

- •Оглавление

6.7. Энтропийное значение погрешности – основной критерий точности приборов и измерений

Любые методы определения или нормирования точности измерительных устройств или измерений сводятся к установлению значений характеризующих их погрешностей. Однако при экспериментальном определении эти значения выступают как частные реализации случайной величины, которая в полной мере может быть охарактеризована лишь законом распределения вероятностей, а более сжато – ее предельным, среднеквадратическим или энтропийным значением.

Если при этом признается бесспорным исходное положение о том, что основным результатом, ради получения которого используются измерительные устройства, является измерительная информация, то в качестве основного критерия качества этих устройств должен быть выбран критерий, однозначно связанный именно с количеством получаемой измерительной информации.

С точки зрения теории информации точность измерений однозначно определяется лишь значением энтропийной погрешности измерения, равной , где – энтропийный коэффициент, зависящий от вида закона распределения вероятностей погрешности, – среднеквадратическое значение погрешности, определяемое дисперсией, т.е. мощностью погрешности. При этом точность измерения с позиций теории информации не может быть определена лишь каким-то одним из этих двух показателей, а обусловлена их совокупностью.

В

этих условиях возникает чрезвычайно

важный как в практическом, так и в

теоретическом плане вопрос о правомерности

использования для оценки точности

приборов или измерений максимального

,

доверительного

,

доверительного

или среднеквадратического

значений

погрешности. Действительно, если основной

ценностью результата измерения является

содержащаяся в нем информация о значении

измеряемой величины, а критерии точности

в виде

,

или

не позволяют однозначно ее определить,

то такие критерии должны быть признаны

некорректными. Решением вопроса является

использование такого критерия эффективного

значения погрешности, который однозначно

связан с информационным качеством

результата измерения. Этим критерием

служит энтропийное значение погрешности

.

или среднеквадратического

значений

погрешности. Действительно, если основной

ценностью результата измерения является

содержащаяся в нем информация о значении

измеряемой величины, а критерии точности

в виде

,

или

не позволяют однозначно ее определить,

то такие критерии должны быть признаны

некорректными. Решением вопроса является

использование такого критерия эффективного

значения погрешности, который однозначно

связан с информационным качеством

результата измерения. Этим критерием

служит энтропийное значение погрешности

.

6.8. Определение энтропийного значения погрешности на практике

Энтропийное значение погрешности определяется выражением . Оно позволяет вычислить энтропийную погрешность по значению условной энтропии , т.е. энтропии закона распределения погрешности .

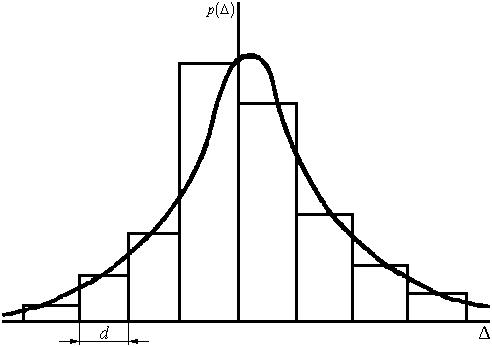

Однако при оценке точности измерительных устройств экспериментатор располагает не самим законом распределения погрешности , а лишь некоторым конечным числом n конкретных значений случайной величины , подчиняющихся этому закону. На основании этого ограниченного числа результатов может быть построена лишь ступенчатая гистограмма (рис. 6.8.1), в той или иной степени приближающаяся к действительному закону распределения . Поэтому практически желательно иметь формулу для вычисления энтропийного значения погрешности исходя из такой приближенной гистограммы.

Рис. 6.8.1.Ступенчатая гистограмма

Если

гистограмма состоит из т

столбцов с

границами

,

,

,

...,

,

,

,

...,

,

,

,

...,

,

...,

и каждый столбец

шириной

и каждый столбец

шириной

включает в

себя

результатов, то плотность вероятности

на протяжении каждого из столбцов

остается постоянной и равной

включает в

себя

результатов, то плотность вероятности

на протяжении каждого из столбцов

остается постоянной и равной

. (6.8.1)

. (6.8.1)

Энтропия такого ступенчатого распределения

(6.8.2)

(6.8.2)

Если ширина всех столбцов гистограммы одинакова, т.е. di = d, то

(6.8.3)

(6.8.3)

Таким

образом, энтропия гистограммы определяется

как взятая с обратным знаком сумма

произведений вероятности случайной

величины на логарифм этой вероятности,

а член

обеспечивает

независимость значения величины энтропии

от произвольного выбора величины d

ступеньки

гистограммы.

обеспечивает

независимость значения величины энтропии

от произвольного выбора величины d

ступеньки

гистограммы.

Для расчетов это выражение можно представить как

(6.8.4)

(6.8.4)

тогда энтропийное значение погрешности будет равно

(6.8.5)

(6.8.5)

Исследование

(6.8.5) показывает, что полученная оценка

является смещенной, но это смещение

убывает по мере увеличения n

и m.

При этом m

и d

могут выбираться произвольно, но с

ограничением

,

так как

наличие интервалов

,

так как

наличие интервалов

или

или

не изменяет энтропии, так как 11

= 1 и при определении энтропии полагают

00

= 1.

не изменяет энтропии, так как 11

= 1 и при определении энтропии полагают

00

= 1.

Пользоваться (6.8.5) можно только тогда, когда общее число наблюдений п настолько велико, что может быть разбито на т (по крайней мере 57) интервалов шириной di, в крайние из которых еще попадает по 12 наблюдения. Это приводит к тому, что вычислить энтропийное значение погрешности исходя из основного определения можно лишь, располагая серией из 3050 наблюдений. Это и понятно, так как для определения энтропийного значения погрешности требуется такой объем испытаний п, при котором уверенно определяется вид закона распределения вероятностей погрешностей, а следовательно, и его энтропия. Поэтому метод прямого вычисления энтропийного значения погрешности может быть использован только при обстоятельном исследовании характеризуемой погрешности, что связано с достаточно большой затратой времени.

Однако, используя связь между энтропийным и среднеквадратическим значениями погрешности через энтропийный коэффициент в виде , можно приближенно определить энтропийную погрешность. Идея заключается в том, что большая серия наблюдений необходима лишь для установления вида закона распределения, т.е. для определения величины энтропийного коэффициента , в то время как для установления ее дисперсии или среднеквадратического значения , достаточно относительно короткой серии, состоящей из 1530 наблюдений. Если надо вычислить энтропийное значение погрешности для ряда однотипных измерений, то обстоятельное исследование (50200 наблюдений) может быть проведено один раз с целью установления значения энтропийного коэффициента . Предполагая, что значение остается неизменным, все последующие испытания могут состоять из серий по 1530 наблюдений, проводимых только для определения среднеквадратического значения погрешности, а энтропийное значение погрешности может вычисляться как .

Более простой метод определения энтропийной погрешности состоит в предварительной классификации измерений по значениям присущего им энтропийного коэффициента. Например, даже из небольшой статистики исследования можно выделить определенные группы измерений с характерными для них значениями энтропийного коэффициента. Конечно, малая статистика не достаточна для присвоения тем или иным группам измерений определенных значений энтропийного коэффициента. Для этого подобная работа должна быть проделана в более крупном масштабе с целью получения более представительной статистики. Однако сам метод нахождения энтропийной погрешности реальных измерений по заранее выбираемому значению энтропийного коэффициента (из ряда 1,6; 1,7; 1,8) и по , получаемой из небольшой серии испытаний, по-видимому, целесообразен.

Можно также

использовать упрощенный метод определения

энтропийного значения погрешности

как

,

где в качестве предельного округленного

значения энтропийного коэффициента

для любых измерений принимается

значение

,

где в качестве предельного округленного

значения энтропийного коэффициента

для любых измерений принимается

значение .

.