- •Аннотация

- •От автора

- •ПРЕДИСЛОВИЕ

- •ВВЕДЕНИЕ

- •1. СИСТЕМЫ И ПРОЦЕССЫ

- •2. ПОРЯДОК, НЕПОРЯДОК, БЕСПОРЯДОК И ХАОС

- •3. ТЕРМОДИНАМИКА

- •3.1 Начала термодинамики

- •3.2 Равновесная термодинамика

- •4. НЕРАВНОВЕСНАЯ ТЕРМОДИНАМИКА

- •4.1 Диссипативные структуры, системы и среды

- •4.2 Термодинамика необратимых процессов

- •4.3 Линейная неравновесная термодинамика

- •4.4 Нелинейная неравновесная термодинамика

- •4.5 Статистическая термодинамика

- •5. ЭНТРОПИЯ

- •5.1 Определение и свойства энтропии

- •5.2 Энтропия в химической термодинамике

- •5.3 Энтропия в статистической физике

- •5.3.1 Энтропия Больцмана-Планка

- •5.3.2 Энтропия Гиббса

- •5.4 Тсаллис (Цаллис) энтропия (Революция в термодинамике)

- •6. ГЕОМЕТРИЯ ФРАКТАЛОВ

- •6.1 Элементы геометрии фракталов

- •6.2 Размерности фракталов

- •6.3 Примеры фракталов

- •6.4 Фракталы и энтропия

- •7. ИНФОРМАТИКА

- •7.1 Информация, информатика и информационные технологии

- •7.2 Теория информации

- •7.2.1 Информация Хартли

- •7.2.2 Энтропия Шеннона

- •7.3 Отрицательная энтропия, антиэнтропия, экстропия

- •7.4 Алгоритмическая теория информации

- •7.4.1 Энтропия Колмогорова

- •7.4.2 Эпсилон-энтропия

- •7.5 Энтропия Кульбака-Лернера

- •7.6 Энтропия Реньи

- •7.7 Квантовая информатика

- •7.7.1 Некоторые положения квантовой механики

- •7.7.2 Энтропия фон Неймана

- •7.7.3 Линейная энтропия

- •7.7.4 Сравнение энтропий Реньи, Цаллиса и Неймана

- •7.7.5 Энтропия Холево

- •8. СИНЕРГЕТИКА

- •8.1 Синергизм и синергетика

- •8.2 Детерминизм, случайность и неопределённость

- •8.3 Простые и сложные системы

- •8.4 Анализ систем

- •8.5 Параметры порядка (управляющие параметры)

- •8.6 Процессы самоорганизации

- •9. СИСТЕМЫ И ЗАКОНЫ ИХ ЭВОЛЮЦИИ

- •9.1 Статические системы

- •9.2 Динамические системы

- •9.3 Линейные динамические системы

- •9.4 Нелинейные динамические системы

- •9.5 Эволюция динамической системы

- •9.6 Математическое описание эволюции динамической системы

- •10. ОБЫКНОВЕННЫЕ ДИФФЕРЕНЦИАЛЬНЫЕ УРАВНЕНИЯ В ОПИСАНИИ ДИНАМИЧЕСКИХ СИСТЕМ

- •10.1 Обыкновенные дифференциальные уравнения

- •10.2 Фазовое пространство и пространство состояний

- •10.3 Линейные ОДУ на плоскости

- •10.4 Нелинейные дифференциальные уравнения

- •11. ОТОБРАЖЕНИЯ

- •11.1 Системы с дискретным временем в отображениях

- •11.2 Итерации в исследовании динамических систем

- •11.3 Графические методы нахождения неподвижных точек и исследования их свойств

- •11.4 Многопараметрические отображения

- •11.5 Примеры некоторых важные отображений

- •12. ОСОБЫЕ ТОЧКИ ФАЗОВЫХ ПОРТРЕТОВ ДИНАМИЧЕСКИХ СИСТЕМ

- •12.1 Дифференциальные уравнения и особые точки

- •12.2 Классификация точек равновесия

- •12.3 Фазовые портреты и особые точки нелинейных ОДУ

- •12.4 Многомерные системы

- •13. РЕГУЛЯРНЫЕ АТТРАКТОРЫ И РЕПЕЛЛЕРЫ

- •13.1 Типы аттракторов

- •13.2 Фазовый объём

- •13.3 Репеллеры

- •13.4 Осциллятор и осцилляции

- •14. УСТОЙЧИВОСТЬ ДИНАМИЧЕСКИХ СИСТЕМ

- •14.1 Устойчивые и неустойчивые равновесия

- •14.2 Устойчивость по Ляпунову (метод первого приближения)

- •14.3 Показатель Ляпунова

- •14.4 Устойчивость нелинейной системы

- •14.5 Метод функций Ляпунова

- •14.6 Функция Ляпунова и энтропия

- •14.7 Асимптотическая устойчивость

- •14.8 Устойчивость особых точек

- •14.9 Устойчивость особых точек

- •14.10 Устойчивость решений дискретных уравнений

- •15. БИФУРКАЦИИ

- •15.1 Бифуркации: основные понятия и классификация

- •15.2 Элементы теории бифуркаций

- •15.3 Простейшие бифуркации

- •16. БИФУРКАЦИИ ЦИКЛОВ

- •16.1 Предельные циклы

- •16.2 Устойчивость предельных циклов

- •16.3 Бифуркации устойчивых предельных циклов

- •16.5 Бифуркация рождения пары устойчивых замкнутых траекторий.

- •16.6 Транскритическая (обмена устойчивостью между циклами) бифуркация.

- •16.7 Бифуркация исчезновения (рождения) пары замкнутых траекторий.

- •16.8 Бифуркация удвоения периода цикла

- •16.9 Бифуркация рождения (гибели) двумерного тора.

- •16.10 Гомоклиническая бифуркация рождения/исчезновения цикла

- •17. ДИНАМИЧЕСКИЙ ХАОС

- •17.1 Хаос статистический и динамический

- •17.2 Предсказание статического поведения системы

- •17.3 Сценарии перехода к хаосу

- •17.4 Примеры систем с хаосом

- •18. ХАОС В ЛИНЕЙНЫХ ОДНОМЕРНЫХ СИСТЕМАХ

- •18.1 Бифуркационные диаграммы

- •18.2 Лестница Ламерея

- •18.3 Отображение Бернулли

- •18.4 Треугольное отображение

- •18.5 Отображение «тент»

- •18.6 Канторов репеллер

- •18.7 Детерминированная диффузия

- •19. ХАОС В ЛОГИСТИЧЕСКОМ ОТОБРАЖЕНИИ

- •19.1 Переход к хаосу через удвоение периода

- •19.2 Логистическое уравнение

- •19.3 Дискретное логистическое уравнение

- •19.4 Логистическое отображение

- •19.5 Бифуркационная диаграмма логистического отображения

- •19.6 Цикл периода 3

- •19.7 Фазовые диаграммы логистического отображения

- •19.8 Аттракторы и фракталы в логистическом отображении

- •20. ХАОС В НЕЛИНЕЙНЫХ ОДНОМЕРНЫХ ОТОБРАЖЕНИЯХ

- •20.1 Отображение xn+1=С+xn2.

- •20.2 Отображение xn+1=а-xn2.

- •20.3 Подобие окон периодической динамики

- •20.4 Порядок Шарковского

- •20.5 Универсальность Фейгенбаума

- •20.6 Устойчивость циклов одномерных отображений

- •20.7 Топологическая энтропия

- •20.8 Синус-отображение

- •21. ХАОС В НЕЛИНЕЙНЫХ ДВУМЕРНЫХ ОТОБРАЖЕНИЯХ

- •21.1 Отображение Эно (Henon map)

- •21.2 Отображение подковы и отображение пекаря

- •21.3 Отображение «кот Арнольда» (Arnold’s cat map)

- •22. НЕРЕГУЛЯРНЫЕ АТТРАКТОРЫ

- •22.1 Хаос в консервативных и диссипативных системах

- •22.2 Регулярные и хаотические аттракторы

- •22.3 Квазиаттракторы

- •22.4 Хаотически аттракторы

- •22.5 Негиперболические хаотические аттракторы

- •22.6 Фрактальные аттракторы

- •22.7 Характеристика нерегулярных аттракторов

- •22.8 Странные нехаотические аттракторы

- •22.9 Сингулярные аттракторы

- •22.10 Многомерные нерегулярные аттракторы

- •22.11 Дикие аттракторы

http://profbeckman.narod.ru/

"Информация есть информация и ничто другое. И этого достаточно!". Кому-то достаточно, а кому-то нет.

Информация, наряду с материей, энергией, пространством и временем, является первичным понятием нашего мира и поэтому в строгом смысле не может быть определена. Тем не менее, определения есть и их довольно много: автор этого учебника располагает коллекцией из 500 оригинальных определений термина "информация", предложенных (и непрерывно предлагаемых) различными учёными.

Философы отнесли понятие «информация» к первичным и неопределяемым понятиям (к таким, как точка, множество, время, энтропия.

Тем не менее, существуют официальные определения.

По международным стандартам:

Информация – знания о предметах, фактах, идеях т.д., которыми могут обмениваться люди в рамках конкретного контекста (ISO/IEC 10746-2:1996); знания относительно фактов, событий, вещей, идей и понятий, которые в определённом контексте имеют конкретный смысл (ISO/IEC 2382:2015).

По российскому ГОСТу 7.0-99:

Информация – сведения, воспринимаемые человеком и (или) специальными устройствами как отражение фактов материального или духовного мира в процессе коммуникации.

По российскому федеральному закону от 27 июля 2006 года № 149-ФЗ «Об информации, информационных технологиях и о защите информации» (Статья 2):

Информация – сведения (сообщения, данные) независимо от формы их представления.

Наиболее распространены два определения информации:

1)любые сведения, данные, сообщения, передаваемые посредством сигналов;

2)уменьшение неопределенности в результате передачи сведений, данных, сообщений; в этом качестве информация противопоставляется энтропии.

Мы будем придерживаться определений, данных К. Шенноном:

Информация – сведения (сообщения, данные) независимо от формы их представления; снятая неопределённость наших знаний о чём-то; мера изменения во времени и пространстве структурного разнообразия систем.

Согласно вероятностному подходу:

Информация – это сведения об объектах и явлениях окружающей среды, их параметрах, свойствах и состоянии, которые уменьшают имеющуюся о них степень неопределённости и неполноты знаний.

Именно в этом смысле информация противостоит энтропии.

Заметим, что философия определения понятия информация отличается чрезвычайной противоречивостью. На одном полюсе – безграничный панинформизм, т.е. утверждение, что весь мир и все его свойства созданы из информации. На другом – отрицание существования информации как действительности, т.е. информация – субъективная реальность. Между ними – признание информации третьим атрибутом материи, равнозначным веществу и энергии; утверждение о независимости информации от какого бы то ни было материального носителя; трактовка её как структуры с необычными для физического мира свойствами; признание в одном случае первичности информации и вторичности материи, а в другом – материальность информации и т.д.

Мы находимся в мире, в котором всё больше и больше информации и всё меньше и меньше смысла.

Жан Бодрийяр. Симулякры и симуляция

7.2 Теория информации

Л. Больцман (1877), давая статистико-физическое определение энтропии, заметил, что энтропия характеризует недостающую информацию о системе. То есть, энтропия есть мера нашего незнания о системе. Таким образом, Больцман был первым, кто понял

http://profbeckman.narod.ru/

информационный смысл энтропии. И только спустя 80 лет теоретико-информационная трактовка энтропии стала общепринятой. Оказалось, что энтропия – информативный параметр, количественно характеризующий состояние системы. Информационная энтропия была положена в основание новой науки – информатики.

Перечислим некоторые основные свойства информации:

–Дискретность. Информация состоит из сообщений. Сообщение – это дискретный сигнал или последовательность дискретных сигналов, которые приходят из окружающего мира в рассматриваемую открытую систему и на которые эта система способна реагировать, то есть так или иначе изменять свое состояние.

–Нематериальность. Информация нематериальна, но она проявляется в связи с материальными носителями самой разной природы: букв, написанных на бумаге, последовательности аминокислот в генетическом коде и т.п. Информация сама по себе без носителя, без структуры, невозможна, но и структура без информации невозможна.

–Закодированнность. Информация всегда закодирована: сообщения в виде знаков, символов, сигналов могут быть восприняты только получателем, способным их распознать. Лишь люди, владеющие одним и тем же кодом, способны обмениваться информацией и понимать друг друга.

–Универсальность и объективность. Универсальность информации заключается в том, что это понятие одинаково применимо как к живому, так и к не живому миру. Примеры: рост кристаллов — зародыши кристаллов несут информацию молекулам, как им выстраиваться в определенном порядке; молекулы ДНК несут генетическую информацию о том, как строить организм. Информация объективна, она не связана с воспринимающим субъектом; она присутствует и функционирует в природе как объективный фактор.

–Аддитивность. Это свойство означает, что если к имеющейся информации добавляется новая, то полученная информация равна сумме старой и новой.

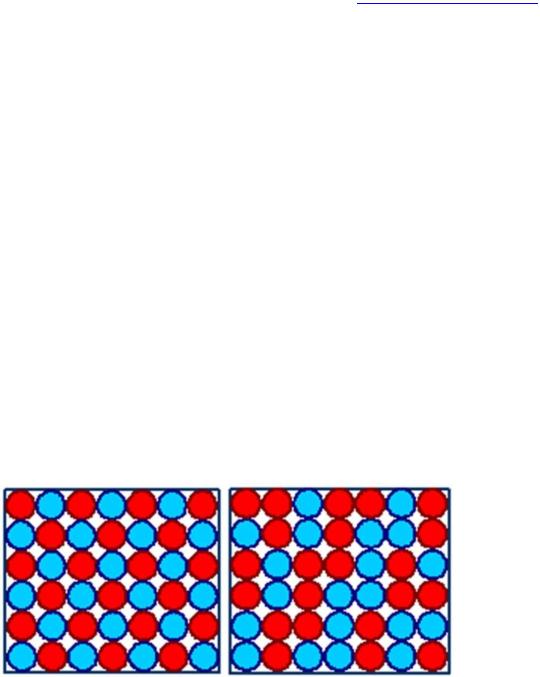

Рис. 1. Иллюстрация различия пространственного и информационного порядков: с

точки зрения топологии шары упакованы в полном порядке, но с точки зрения информации (цвета) слева – порядок, справа – беспорядок.

Информация – предельно общая характеристика степени зависимости некоторых переменных. Её можно сравнить с корреляцией, но если корреляция характеризует лишь линейную связь переменных, то информация характеризует любую связь. Даже, если связь неизвестна, то это не мешает рассчитывать информацию и количественно сравнивать между собой разнотипные зависимости. Однако невозможно, зная количество информации, написать уравнение связи переменных.

Информация в первую очередь имеет дело со случайными событиями, которые обычно описываются в рамках теории вероятности. Случайное событие означает отсутствие полной уверенности в его наступлении, что, в свою очередь, создает неопределенность в исходах опытов, связанных с данным событием. Информатика позволяет ввести такую количественную меру неопределенности. Уменьшение неопределенности всегда связано с выбором одного или нескольких элементов (альтернатив) из некоторой их совокупности. Взаимная обратимость понятий вероятности

http://profbeckman.narod.ru/

и неопределенности послужила основой для использования понятия вероятности при измерении степени неопределенности в теории информации. Чем меньше вероятность какого-либо события, тем большую неопределенность снимает сообщение о его появлении и, следовательно, тем большую информацию оно несёт.

Измерить количество смысловой информации невозможно. Однако часто можно пренебречь качественными особенностями информации, выразить её количество числом, а также сравнить количество информации, содержащееся в различных группах данных. Физическую (термодинамическую, статистическую) и техническую (шенноновскую) информации, уменьшающие энтропию и неопределённость, измерить можно. Следует подчеркнуть, что и в физическом, и в техническом подходах к определению количества информации не обсуждается ценность того или иного информационного сообщения.

Задача этой главы продемонстрировать, что энтропия и информация являются противоположностями, которые дополняют друг друга.

7.2.1 Информация Хартли

Аддитивную логарифмическую меру информации впервые предложил Р. Хартли в

1928 г.

Предположим, что какое-то событие имеет m равновероятных исходов. Таким событием может быть, например, появление любого символа из алфавита, содержащего m таких символов. Какое количество информации можно передать при помощи такого алфавита? Оценки можно сделать, определив число N возможных сообщений, которые могут быть переданы при помощи этого алфавита. Если сообщение формируется из одного символа, то N=m, если из двух, то N=m2. Если сообщение содержит n символов (n – длина сообщения), то N=mn. Мера количества информации найдена, но она не удобна. При наличии алфавита, состоящего из одного символа, т.е. когда m=1, возможно появление только этого символа. Следовательно, неопределенности в этом случае не существует, и появление этого символа не несет никакой информации. Между тем, значение N при m=1 не обращается в нуль. Для двух независимых источников сообщений (или алфавита) с N1 и N2 числом возможных сообщений общее число возможных сообщений N=N1N2, в то время как логичнее было бы считать, что количество информации, получаемое от двух независимых источников, должно быть не произведением, а суммой составляющих величин.

Теорема Хартли: Если в заданном множестве {M}, состоящем из N элементов, содержится элемент х, о котором известно только, что он принадлежит этому множеству {M}, то, чтобы найти х, необходимо получить об этом множестве количество информации, равное log2N бит.

Полное доказательство теоремы дано А. Реньи.

Хартли предложил информацию Y, приходящуюся на одно сообщение, определять

логарифмом общего числа возможных сообщений N: |

|

Y(N) = logN |

(1) |

Если все множество возможных сообщений |

состоит из одного (N=m=1), то |

Y(N)=log1=0, что соответствует отсутствию информации в этом случае. При наличии независимых источников информации с N1 и N2 числом возможных сообщений Y(N)=logN=logN1N2=logN1+logN2, т.е. количество информации, приходящееся на одно сообщение, равно сумме количеств информации, которые были бы получены от двух независимых источников, взятых порознь. Формула, предложенная Хартли, удовлетворяет предъявленным требованиям. Поэтому её можно использовать для измерения количества информации. Если возможность появления любого символа алфавита равновероятна (а мы здесь предполагали, что это именно так), то эта вероятность р=1/m. Если N=m, то

Y=log N=log m=log (1/p)=–log p, |

(2) |

т.е. количество информации на каждый равновероятный сигнал равно минус логарифму вероятности отдельного сигнала.

http://profbeckman.narod.ru/

Формула Хартли (2) определяет собственную информацию.

Собственная информация – статистическая функция дискретной случайной величины. Это случайная величина, отличающаяся от её среднего значения (информационной энтропии).

Формула (2) позволяет, в принципе, определить количество информации. Однако для практических целей необходимо задаться единицей его измерения. Единицы измерения информации зависят от основания логарифма.

Замечание. Выбор основания логарифма существенного значения не имеет, т.к. логарифм легко преобразуется логарифма от одного основания к другому: logbn=logba·logan; переход к другому основанию состоит во введении одинакового для обеих частей выражения (2) постоянного множителя logba, что равносильно изменению масштаба (т.е. размера единицы) измерения неопределенности.

При использовании натурального логарифма единицей информации является нат (для вычисления энтропии в битах нужно разделить на ln2 значение в натах; 1 нат=log2e=1,443 бит). Если используются десятичные логарифмы, то единицей степени неопределенности будет служить неопределенность опыта с 10 равновероятными исходами (таким является, например, опыт, состоящий в извлечении шара из урны с десятью перенумерованными шарами). Такая единица степени неопределенности называется дитом; и она в 3,32 раза больше двоичной единицы, т.к. log210 = 3,32.

В случае логарифма с основанием 2 единицей измерения является бит. Это название предложил Джон Тьюки. Бит (BIT – аббревиатура от BInary digiT). Тьюки избрал бит для обозначения одного двоичного разряда, способного принимать значение 0 или 1.

Единицами кодированной информации являются бит и байт.

Бит – минимальная единица измерения количества передаваемой или хранимой информации, соответствующая одному двоичному разряду, способному принимать значений

0 или 1; один разряд двоичного кода (двоичная цифра).

Байт – в запоминающих устройствах – наименьшая адресуемая единица данных в памяти компьютера, обрабатываемая как единое целое. По умолчанию байт считается равным 8 битам. Обычно в системах кодирования данных байт представляет собой код одного печатного или управляющего символа.

Введение бита позволило использовать для анализа информационных событий аппарат математической логики. Один бит равен количеству информации, получаемой в результате осуществления одного из двух равновероятных событий; он соответствует одному элементарному событию, которое может произойти или не произойти. Бит — двоичный логарифм вероятности равновероятных событий или сумма произведений вероятности на двоичный логарифм вероятности при равновероятных событиях. Бит не только единица количества информации, но и единицей измерения степени неопределенности, содержащаяся в одном опыте, имеющем два равновероятных исхода. Один бит вовсе не является минимальным количеством информации: информация может быть и меньше бита.

Количество информации равно количеству двоичных символов 0 или 1.

Если информация – это устраненная неопределенность, то в простейшем случае неопределенности выбор будет производиться между двумя взаимоисключающими друг друга равновероятными сообщениями, например между двумя качественными признаками: положительным и отрицательным импульсами, импульсом и паузой и т.п. Количество информации, переданное в этом простейшем случае, наиболее удобно принять за единицу количества информации. Именно такое количество информации может быть получено, если применить формулу (2) и взять логарифм по основанию 2.

Тогда Y=–log2p=–log21/(1/2)=log22=1.

При наличии нескольких источников информации общее количество информации

равно

|

http://profbeckman.narod.ru/ |

k |

|

Y Y1 Y2 ... Yk Yi . |

(3) |

i1 |

|

Здесь Yi – количество информации от источника i. Всего k источников.

На количество информации, получаемой из сообщения, влияет фактор неожиданности его для получателя. Он зависит от вероятности получения того или иного сообщения. Чем меньше эта вероятность, тем сообщение более неожиданно и более информативно. Сообщение, вероятность которого высока (низкая степень неожиданности), несёт немного информации. Формула Хартли позволяет определить количество информации в сообщении только для случая, когда появление символов равновероятно и они статистически независимы. На практике эти условия выполняются редко. При определении количества информации необходимо учитывать не только количество разнообразных сообщений, которые можно получить от источника, но и вероятность их получения.

Для случайной величины X, имеющей конечное число значений:

n

pi 1

i1

собственная информация определяется формулой Хартли Y(X)=-logPX(X).

Пример. Мера информации Хартли используется для измерения количества информации, содержащегося в последовательности из n символов из алфавита A мощности m. Она равна: Y=n log2m бит. Хартли предполагал, что все символы алфавита A могут встретиться с равной вероятностью (частотой) в любом месте сообщения. Любое сообщение длины n в алфавите A содержит одинаковое количество информации. Информационная энтропия – мера неопределенности источника информации, который может выдать одно из m значений (символов алфавита). Чем больше мощность алфавита (m), тем больше энтропия (неопределенность).

С практической точки зрения, энтропия по Хартли – количество бит, которое необходимо для передачи одного значения от источника приемнику, а количество информации – общее количество бит, необходимое для передачи всего сообщения. Неопределенность знания о результате некоторого события – это количество возможных результатов (исходов) этого события. Сообщение об одном из двух равновероятных результатов некоторого события несёт 1 бит информации.

Глубина сообщения q – количество различных элементов (символов, знаков), принятых для представления сообщений. В каждый момент времени реализуется только один какойлибо элемент. Например, если сообщение представляется символами - буквами русского алфавита, то q=32 (для простоты буква ё во внимание не принимается), английского - q=26. Если сообщение - десятичные числа, то q=10 (десятичные цифры - элементы - 0, 1, 2, 3, 4, 5, 6, 7, 8, 9).

Длина сообщения n – количество позиций, необходимых и достаточных для представления сообщений заданной величины. Если символы сообщения - цифры, то сами сообщения - числа и их последовательности.

При заданных глубине и длине сообщения количество всех возможных сообщений

N=qn.

Пример 1. Всего трехбуквенных русских слов N=323=32768. В это количество включены и "совершенно невозможные" слова, например "ааа" или "ььы.

Пример 2. Трехзначных десятичных чисел всего N = 103= 1000.

Пример 3. Определить, какое количество информации в битах содержит книга, написанная на русском языке, содержащая 200 страниц (каждая страница содержит 2000 символов). Согласно мере Хартли Y=n log2q = 200 · 2000 · log232 = 2000000 бит. Здесь n - длина сообщения в знаках: n=200 страниц 2000 знаков/страница = 400000 знаков. Ответ: книга содержит 2-х мегабит (Мбит) информации.

Собственную информацию можно понимать как «меру неожиданности» события

— чем меньше вероятность события, тем больше информации оно содержит.