- •В.М.Лазебник экономическая кибернетика

- •Содержание

- •Введение

- •Раздел I

- •Структура кибернетики

- •Принципы построения кибернетических систем различных прикладных направлений

- •1.2. Экономическая кибернетика Предмет, цели и задачи курса

- •Структура и состав экономической кибернетики

- •История кибернетики и информационных наук

- •1.3. Кибернетические системы Система и ее основные характеристики

- •Классификация систем

- •Целостность, эмерджентность и синергизм

- •Контрольные вопросы и задания к главе 1 «Кибернетика и кибернетические системы»

- •Глава 2. Моделирование

- •2.1. Модели и моделирование

- •Основные схемы процесса моделирования

- •Классификация моделей

- •История моделирования Появление моделей относится к глубокой древности, и восходит по времени к бронзовому веку (XV-XX в.В. До н. Э.).

- •Совместное использование моделей различных типов

- •2.2. Последовательность разработки и использования математических моделей Процесс моделирования

- •6. Разработка программы, реализующей алгоритм модели на компьютере.

- •Контрольные вопросы и задания к главе 2

- •Реализация управления

- •Разомкнутые системы управления

- •Внешние и внутренние возмущения

- •Анализ свойств разомкнутой системы управления

- •3.2. Замкнутые системы управления

- •Коэффициенты передачи и передаточные функции замкнутой системы управления

- •Анализ свойств замкнутой системы управления

- •Выводы:

- •Типы обратных связей и сферы их применения Обратные связи могут быть:

- •Структурная схема и процессы в системе отрицательной обратной связи показаны на рис.3.6

- •3.3. Классификация систем управления и виды задач управления Классификация систем управления

- •Виды задач управления

- •Понятие гомеостазиса

- •3.4. Закон необходимого разнообразия и его следствия для систем управления Энтропия систем и закон необходимого разнообразия

- •Свойства систем управления, основанные на законе необходимого разнообразия

- •3.5. Управление сложными системами Иерархические системы управления

- •Централизованное и децентрализованное управление сложными системами

- •Анализ децентрализованных систем управления

- •Контрольные вопросы и задания к главе 3 «Управление»

- •Глава 4. Информация

- •4.1. Основные категории информации и ее классификация Определение понятия информации

- •Основные категории информации – данные и знания

- •Основные свойства информации

- •Виды информации

- •Основные требования, предъявляемые к качеству информации

- •Классификация информации

- •4.2. Экономическая информация и экономическая семиотика Экономическая информация

- •Экономическая семиотика

- •Основные элементы системы передачи информации

- •4.3. Измерение количества информации Основные подходы к измерению количества информации

- •Объемный метод измерения количества информации

- •Энтропийный подход к измерению количества информации

- •Вопрос 2: Число х больше шести?

- •Вопрос 3: Число х меньше шести?

- •Количество информации, получаемое от отдельного сообщения

- •Семантический подход к определению количества информации

- •4.4. Ценность информации Определение ценности информации

- •Человек и информация

- •Бытовые – искажение информации в отчетах, в докладах начальству, в отношениях мужчины и женщины, и т.П.

- •4.5. Кодирование информации Кодирование

- •Криптография

- •Десятичное кодирование информации

- •Двоичное кодирование информации

- •Избыточность информации

- •Контрольные вопросы и задания к главе 4 «Информация»

- •Глава 5. Моделирование экономических систем

- •5.1. Системные свойства экономики Основные системные свойства экономики

- •Структуры и модели рыночной экономики

- •5.2. Моделирование и принятие решений Принятие решений

- •Методы обоснования решений

- •Количественные методы позволяют установить насколько один результат лучше другого.

- •5.3. Критерии качества и критерии принятия решений

- •Требования, предъявляемые к критериям качества

- •Классификация и формы критериев качества Классификация критериев качества

- •Математические формы критериев качества

- •Статистические задачи

- •5.4. Примеры математических моделей экономических систем

- •Модель оценки экономической эффективности системы массового обслуживания

- •Часть 1.Модель определения характеристик смо.

- •Часть 2.Модель определения экономической эффективности смо.

- •Модели динамических систем Модель динамического звена первого порядка

- •Модель динамического звена второго порядка

- •Модель экономического роста

- •Модели финансовых операций Первая модель

- •Вторая модель

- •Третья модель

- •Четвертая модель

- •Пятая модель

- •Шестая модель

- •Контрольные вопросы и задания к главе 5 «Моделирование экономических систем»

- •Раздел II

- •Оптимизационные задачи

- •Оптимизация систем массового обслуживания

- •Оптимизация систем управления запасами

- •6.2. Оптимальное распределение ресурсов между несколькими этапами и между несколькими объектами Последовательная (многоэтапная) оптимизация с использованием метода динамического программирования

- •Уравнение оптимальности Беллмана имеет вид

- •Оптимизация маршрута

- •Оптимальное распределение ресурсов между несколькими объектами

- •Приравниваем производные нулю

- •Контрольные вопросы и задания к главе 6 «Оптимизация экономических систем»

- •Глава 7. Наилучшие решения в условиях неопределенности и многокритериальности

- •7.1. Наилучшие решения в условиях частичной и полной неопределенности Игры с «природой»

- •Наилучшие решения в условиях частичной неопределенности

- •Наилучшее решение в условиях полной неопределенности

- •Матрица выигрышей

- •7.2. Наилучшие решения в условиях многокритериальности

- •Контрольные вопросы и задания к главе 7 «Наилучшие решения в условиях неопределенности и многокритериальности»

- •Раздел III искусственный интеллект

- •Глава 8. Системы искусственного интеллекта

- •8.1. Основные положения по построению систем искусственного интеллекта

- •Зависимость типа системы управления от сложности объекта управления и влияния случайных факторов

- •История систем ии

- •Виды неопределенностей

- •8.2. Нечеткие системы

- •Нечеткие системы в управлении

- •Контрольные вопросы и задания к главе 8 «Системы искусственного интеллекта»

- •Глава 9. Нейронные сети, экспертные системы и генетические алгоритмы

- •9.1. Нейронные сети Принципы построения и основные свойства нейронных сетей

- •Представление знаний в нейронных сетях

- •Применение нейронных сетей в экономике

- •Пример решения задачи прогнозирования

- •9.2. Экспертные системы Принципы построения и функционирования экспертных систем

- •Пример применения экспертных систем в экономике и финансах – экспертная система для кредитных операций

- •Представление знаний в экспертных системах

- •9.3. Генетические алгоритмы

- •Контрольные вопросы и задания к главе 9 «Нейронные сети, экспертные системы и генетические алгоритмы»

- •Раздел IV

- •Структурная схема простой смо. Основные обозначения. Характеристики важнейших параметров Структурная схема простой смо

- •Основные обозначения

- •Характеристики важнейших параметров

- •Задачи исследования смо

- •Методология разработки аналитических моделей смо

- •Обозначения моделей смо

- •10.3. Потоки событий Характер величин и процессов в смо

- •Смо с детерминированными потоками

- •Случайные потоки событий

- •10.4. Марковские случайные процессы Графы состояний смо

- •Марковские процессы

- •Стационарный режим динамического процесса

- •Законы распределения, определяющие описание и формирование простейшего потока

- •Закон Пуассона

- •Исходные данные

- •Алгоритм решения задачи

- •Решение

- •Экспоненциальный (показательный) закон распределения

- •Закон равномерной плотности

- •10.5. Уравнения Колмогорова Дифференциальные и алгебраические уравнения Колмогорова

- •Общие формулы решения системы алгебраических уравнений Колмогорова для схемы ''рождения и гибели''

- •10.6. Модель Эрланга Одноканальная смо с отказами

- •Многоканальная смо с отказами

- •10.7. Имитационное моделирование систем массового обслуживания Метод статистических испытаний (метод Монте-Карло)

- •Исследование смо с применением метода статистических испытаний

- •Методика и пример формирования простейшего потока

- •Контрольные вопросы и задания к главе 10 «Модели и методы исследования систем массового обслуживания»

- •Глава 11. Анализ и синтез системы массового обслуживания Характеристика задач анализа и синтеза смо

- •Определение вероятностей отказа и обслуживания Основные формулы для смо Эрланга

- •Пример расчетов по формулам Эрланга

- •Построение графиков вероятности отказа и обслуживания на основе расчетных данных

- •Построение графиков вероятностей отказа и обслуживания на основе табличных данных

- •Графики вероятностей отказа

- •Графики вероятностей обслуживания

- •Определение показателей качества смо с отказами

- •Показатели качества обслуживания заявки

- •Показатели качества обслуживания заявки

- •Пример расчета характеристик смо с ожиданием

- •Расчетные параметры:

- •Показатели качества функционирования

- •Показатели качества обслуживания заявки

- •Компьютерные программы и таблицы вероятностей отказа для смо с ограниченным временем ожидания

- •Сопоставление смо с отказами и смо с ожиданием

- •11.3. Методика оценки экономической эффективности смо Постановка задачи оценки экономической эффективности

- •Уравнения блока оценки экономической эффективности

- •Уравнения полной модели оценки экономической эффективности смо

- •Модель смо

- •Блок оценки экономической эффективности

- •Вариант №2 кафе «десерт»

- •Определение показателей экономической эффективности смо на момент окупаемости Результаты расчетов

- •Составление итоговой таблицы результатов расчетов по оценке экономической эффективности смо

- •Сопоставление вариантов смо по основным экономическим характеристикам

- •11.5. Синтез системы массового обслуживания и принятие решения об инвестировании Составление таблицы результатов расчетов по оценке экономической эффективности смо

- •Ранжирование вариантов и выводы

- •Определение взаимосвязи параметров смо с экономическими параметрами системы

- •Контрольные вопросы и задания к главе 11 «Анализ и синтез системы массового обслуживания »

- •Приложения п.1. Программа курса «Экономическая кибернетика»

- •Раздел IV. Информация

- •Раздел V. Моделирование

- •Раздел VI. Системы массового обслуживания (смо)

- •Раздел VII. Оптимизация и принятие решений

- •Раздел VII. Искусственный интеллект

- •П.2. Задание на подготовку реферата «Замкнутые системы управления»

- •П.3. Задание на подготовку реферата «Системы массового обслуживания»

- •Часть 1. Определение характеристик смо.

- •Вероятность обслуживания

- •Часть 2. Оценка экономической эффективности смо.

- •Результаты расчетов

- •Ранжирование, анализ вариантов и выводы

- •П.4. Равномерно распределенные случайные числа

- •П 5. Вероятности отказа для смо Эрланга

- •П 6. Компьютерные программы для смо Эрланга п 6.1. Программы на языке Паскаль

- •П.6.3. Программа на языке Visual Basic для расчета экономической эффективности смо

- •П 7. Вероятности отказа для смо с ограниченным временем ожидания

- •П 8. Компьютерная программа для смо с ограниченным временем ожидания

- •Литература

6.2. Оптимальное распределение ресурсов между несколькими этапами и между несколькими объектами Последовательная (многоэтапная) оптимизация с использованием метода динамического программирования

Метод динамического программирования (ДП) – это метод оптимизации, приспособленный к операциям, в которых процесс принятия решения может быть разбит на этапы (шаги). Такие операции называются многошаговыми (многоэтапными).

Развитие ДП относится к 50-м годам XXвека. В 1953г. американский математик Р. Беллман сформулировал принцип оптимальности многошаговых решений. В основе метода ДП теория марковских процессов, разработанная русским ученым А.А. Марковым.

Значительный вклад в решение подобных оптимизационных задач внес Л.В. Понтрягин, предложивший так называемый «принцип максимума Понтрягина»

Типичными задачами ДП является:

задача последовательного распределения средств между предприятиями;

задачи календарного планирования;

задачи распределения инвестиций во времени;

задачи замены оборудования;

задачи отыскания оптимальной последовательности обработки изделий на станках и т.п.

Метод ДП основан на принципе оптимальности Р. Беллмана.

Принцип оптимальности Р. Беллмана формулируется следующим образом:

Независимо от того, каким образом система пришла в данное состояние, последующие решения должны быть оптимальными.

Независимость от «прошлого» является характерной для так называемых марковских систем, примерами которых может быть кошелёк, склад и т.п.

Основное функциональное уравнение ДП строится на основе того, что решение на каждом шаге должно выбираться с учетом всех последствий в будущем, т.е. решение должно максимизировать сумму выигрыша на данном шаге и условного оптимального выигрыша на последующих шагах.

Решение задач ДП начинается с последнего (конечного) шага и развивается в направлении начального состояния.

Дело в том, что решение на последнем шаге выбирается исходя только из характеристик этого шага.

Последовательность действий в методе ДП состоит в том, что для каждого состояния определяется условный оптимальный выигрыш и условное оптимальное управление (решение).

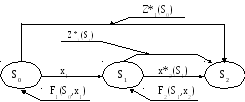

Рассмотрим идеи метода ДП на примере, в котором система может находиться в трех состояниях (S0,S1,S2) и необходимо принять два решения (х1, х2) по переводу оптимальным образом системы первый раз из состоянияS0вS1и затем второй раз изS1вS2.

Графическое представление системы показано на рис.6.10.

Рис. 6.10. Схема принятия решений при двух этапах

Приведенный рисунок соответствует уравнению Беллмана для двух этапов (шагов) принятия решения.

Z*1(S0) = max {F1(S0,x1) + Z*2 (S1)}

х1

Здесь:

S0– начальное состояние;

S1– промежуточное состояние;

S2– конечное состояние;

х1и х2– возможные решения соответственно на 1-ом и 2-ом шаге;

х*1и х*2– оптимальные решения соответственно на 1-ом и 2-ом шаге;

F1иF2– значения выигрышей (целевой функции) при произвольном управленииxи соответствующих состоянияхS0иS1;

Z*1иZ*2– условные оптимальные выигрыши соответственно на 1-ом и 2-ом шаге.