- •Введение

- •Основные понятия и определения

- •Типы данных

- •1.1.1. Понятие типа данных

- •1.2.2. Внутреннее представление базовых типов в оперативной памяти

- •1.2.2. Внутреннее представление структурированных типов данных

- •1.2.3. Статическое и динамическое выделение памяти

- •Абстрактные типы данных (атд)

- •Понятие атд

- •1.2.2. Спецификация и реализация атд

- •Структуры данных

- •1.3.1. Понятие структуры данных

- •1.3.2. Структуры хранения — непрерывная и ссылочная

- •1.4.3. Классификация структур данных

- •Алгоритмы

- •1.4.1. Понятие алгоритма

- •1.4.2. Способы записи алгоритмов.

- •1.4.3. Введение в анализ алгоритмов Вычислительные модели

- •Задача анализа алгоритмов

- •Время работы алгоритма

- •Время выполнения в худшем и среднем случае

- •1.4.3. Введение в рекурсию

- •Первые примеры

- •1.5.1. Введение в «длинную» арифметику

- •1.5.2. Рекурсия

- •1.5.3. Поразрядные операции. Реализация атд «Множество»

- •2. Линейные структуры данных

- •2.1. Атд "Стек", "Очередь", "Дек"

- •2.2. Реализация стеков

- •2.2.1. Непрерывная реализация стека с помощью массива

- •2.2.2. Ссылочная реализация стека в динамической памяти

- •2.2.3. Примеры программ с использованием стеков

- •2.3. Реализация очередей

- •2.3.2. Непрерывная реализация очереди с помощью массива

- •2.3.2. Ссылочная реализация очереди в динамической памяти

- •2.3.3. Ссылочная реализация очереди с помощью циклического списка

- •2.3.4. Очереди с приоритетами

- •2.3.5. Пример программы с использованием очереди

- •2.4. Списки как абстрактные типы данных

- •2.4.1. Модель списка с выделенным текущим элементом

- •2.4.2. Однонаправленный список (список л1)

- •2.4.3. Двунаправленный список (список л2)

- •2.4.4. Циклический (кольцевой) список

- •2.5. Реализация списков с выделенным текущим элементом

- •2.5.1. Однонаправленные списки Ссылочная реализация в динамической памяти на основе указателей

- •2.5.2. Двусвязные списки

- •2.5.3. Кольцевые списки

- •2.5.4. Примеры программ, использующих списки Очередь с приоритетами на основе линейного списка

- •Задача Иосифа (удаление из кольцевого списка)

- •2.6. Рекурсивная обработка линейных списков

- •2.6.1. Модель списка при рекурсивном подходе

- •2.6.2. Реализация линейного списка при рекурсивном подходе

- •3. Иерархические структуры данных

- •3.1. Иерархические списки

- •3.1.1 Иерархические списки как атд

- •3.1.2. Реализация иерархических списков

- •3.2. Деревья и леса

- •3.2.1. Определения

- •3.2. Способы представления деревьев

- •3.2.3. Терминология деревьев

- •3.2.4. Упорядоченные деревья и леса. Связь с иерархическими списками

- •3.3. Бинарные деревья

- •3.3.1. Определение. Представления бинарных деревьев

- •3.3.2. Математические свойства бинарных деревьев

- •3.4. Соответствие между упорядоченным лесом и бинарным деревом

- •3.5. Бинарные деревья как атд

- •3.6. Ссылочная реализация бинарных деревьев

- •3.6.1. Ссылочная реализация бинарного дерева на основе указателей

- •3.6.2. Ссылочная реализация на основе массива

- •3.6.3. Пример — построение дерева турнира

- •3.7. Обходы бинарных деревьев и леса

- •3.7.1. Понятие обхода. Виды обходов

- •3.7.2. Рекурсивные функции обхода бинарных деревьев

- •3.7.3. Нерекурсивные функции обхода бинарных деревьев

- •3.7.4. Обходы леса

- •3.7.5. Прошитые деревья

- •3.8. Применения деревьев

- •3.8.1. Дерево-формула

- •3.8.2. Задача сжатия информации. Коды Хаффмана

- •4. Сортировка и родственные задачи

- •4.1. Общие сведения

- •4.1.1. Постановка задачи

- •4.1.2. Характеристики и классификация алгоритмов сортировки

- •4.2. Простые методы сортировки

- •4.2.1. Сортировка выбором

- •4.2.2. Сортировка алгоритмом пузырька

- •4.2.3.Сортировка простыми вставками.

- •4.3. Быстрые способы сортировки, основанные на сравнении

- •4.3.1. Сортировка упорядоченным бинарным деревом

- •Анализ алгоритма сортировки бинарным деревом поиска

- •4.3.2. Пирамидальная сортировка

- •Первая фаза сортировки пирамидой

- •Вторая фаза сортировки пирамидой

- •Анализ алгоритма сортировки пирамидой

- •Реализация очереди с приоритетами на базе пирамиды

- •4.3.2. Сортировка слиянием

- •Анализ алгоритма сортировки слиянием

- •4.3.3. Быстрая сортировка Хоара

- •Анализ алгоритма быстрой сортировки

- •4.3.4. Сортировка Шелла

- •4.3.5. Нижняя оценка для алгоритмов сортировки, основанных на сравнениях

- •4.4. Сортировка за линейное время

- •4.4.1. Сортировка подсчетом

- •4.4.2. Распределяющая сортировка от младшего разряда к старшему

- •4.4.3. Распределяющая сортировка от старшего разряда к младшему

- •5. Структуры и алгоритмы для поиска данных

- •5.1. Общие сведения

- •5.1.1. Постановка задачи поиска

- •5.1.2. Структуры для поддержки поиска

- •5.1.3. Соглашения по программному интерфейсу

- •5.2. Последовательный (линейный) поиск

- •5.3. Бинарный поиск в упорядоченном массиве

- •5.4. Бинарные деревья поиска

- •5.4.1. Анализ алгоритмов поиска, вставки и удаления Поиск

- •Вставка

- •Удаление

- •5.4.3. Реализация бинарного дерева поиска

- •5.5. Сбалансированные деревья

- •Определение и свойства авл-деревьев

- •Вращения

- •Алгоритмы вставки и удаления

- •Реализация рекурсивного алгоритма вставки в авл-дерево

- •5.5.2. Сильноветвящиеся деревья

- •Бинарные представления сильноветвящихся деревьев

- •5.5.3. Рандомизированные деревья поиска

- •5.6. Структуры данных, основанные на хеш-таблицах

- •5.6.2. Выбор хеш-функций и оценка их эффективности

- •Модульное хеширование (метод деления)

- •Мультипликативный метод

- •Метод середины квадрата

- •5.6.2. Метод цепочек

- •5.6.3. Хеширование с открытой адресацией

- •5.6.4. Пример решения задачи поиска с использованием хеш-таблицы

Задача анализа алгоритмов

Основной задачей анализа алгоритма является получение зависимости того или иного показателя эффективности от размера входных данных (размера входа, размера задачи). Сразу возникает вопрос – как измерять размер входа? Это зависит от конкретной задачи. В одних случаях размером разумно считать число элементов на входе (например, поиск элемента в массиве или его сортировка). Иногда размер входа измеряется не одним числом, а несколькими (например, число вершин и число рёбер в графе). В некоторых случаях более естественно считать размером входа общее число бит, необходимое для представления всех входных данных. Последний способ рассматривается как основной в теории вычислений.

Зависимость времени выполнения алгоритма от размера задачи называется временнóй сложностью алгоритма, а зависимость необходимого размера памяти от размера задачи — пространственной (емкостной) сложностью алгоритма.

Время работы алгоритма

Пусть n – размер входа (для задач, где размер входа задаётся несколькими числами, рассуждения будут аналогичны). Определим более точно, что понимать под временем работы алгоритма. Поскольку алгоритм – это ещё не программа для конкретной вычислительной машины, время его работы нельзя измерять, например, в секундах. Обычно под временем работы алгоритма понимают число элементарных операций, которые он выполняет. При этом, если алгоритм записан на каком-то псевдокоде или языке высокого уровня, предполагается, что выполнение одной строки требует не более чем фиксированного числа операций (если, конечно, это не словесное описание каких-то сложных действий).

Примечание. Действуя более формально, мы могли бы записать алгоритм с помощью инструкций предполагаемой вычислительной модели, назначить каждой из них некую стоимость и вывести выражение для стоимости алгоритма. Однако, это достаточно трудоёмко и в большинстве случаев не требуется.

Поскольку почти любой алгоритм содержит ветвления, время его выполнения зависит не только от количества входных данных, но и от самих значений этих данных. В связи с этим записать аналитическую зависимость T(n) невозможно. Для сравнения различных алгоритмов обычно определяют время их выполнения для наихудшего или для среднего случая. Рассмотрим это подробнее.

Время выполнения в худшем и среднем случае

Существуют алгоритмы, время работы которых зависит только от размера входных данных, но не зависит от самих данных (например, поиск суммы элементов заданного массива). Однако чаще всего для разных входных данных одного и того же размера алгоритм работает разное время. Поэтому говорят о времени выполнения алгоритма в наихудшем случае (т.е. максимальное время выполнения по возможным входным данным) и о времени выполнения в среднем. Время выполнения в среднем можно определить по-разному:

среднее время работы алгоритма по всем возможных вариантам входных данных;

ожидаемое время его работы по всем возможным вариантам входных данных с учетом вероятности их появления

Недостатки есть и у того, и у другого способов:

Первый способ не учитывает, что в реальных задачах данные часто распределены неравномерно.

При втором способе получается, что мы анализируем алгоритм не в общем виде, а применительно к некой предполагаемой области.

Чаще всего при анализе времени работы алгоритма ограничиваются наихудшим случаем. Причины этого в следующем:

Время выполнения в наихудшем случае обычно найти гораздо проще, чем в среднем.

Зная верхнюю границу, мы можем быть уверены, что алгоритм не будет работать дольше ни на каких входных данных.

Для многих алгоритмов плохие случаи (или близкие к ним) могут происходить очень часто

Зачастую «средний случай» почти так же плох, как и наихудший. Например, сортировка вставками или любой другой квадратичный алгоритм сортировки.

Тем не менее, время выполнения в среднем также иногда анализируют – например, для тех алгоритмов, где оно существенно отличается от наиухудшего, и при этом вероятность появления «плохих» входных данных достаточно мала (алгоритм быстрой сортировки Хоара и др.)

Для примера найдём время выполнения алгоритма сортировки массива методом пузырька для худшего случая. Сортировка методом пузырька выполняется следующим образом. Двигаясь от конца массива к началу, мы на каждом шаге сравниваем очередные два соседних элемента. Если первый элемент больше второго, то меняем их местами. Таким образом, после первого прохода по массиву самый маленький элемент поднимется на самый верх массива и займёт нулевую позицию. Второй цикл сортировки выполняется для оставшейся части массива (без первого элемента), в результате следующий по величине элемент окажется в первой позиции массива, и т.д.

Отметим около каждой строки её стоимость (число операций) и число раз, которое эта строка выполняется.

void bubble(int *a, int n) { int i,j,temp; 1 for( i=0; i<n-1; i++)

2 for (j=n-1; j>i;j--) 3 if (a[j-1]>a[j])

4 { temp:=a[j-1];

5 a[j-1]:=a[j];

6 a[j]:=temp; } }

|

стоимость

c1

c2

c3

c4

c5

c6

|

Число раз

N

|

В худшем случае массив изначально упорядочен по убыванию, и условие в строке 3 всегда истинно, в результате чего строки 4-6 всегда выполняются.

Общее время работы получается следующим: T(n)=c1n+c2 +(c3+c4+c5+c6) =

=c1n+c2 +(c3+c4+c5+c6) = (с2+c3+c4+c5+c6)n2/2+(c1+(c2-c3-c4-c5-c6)/2)n-c2

Асимптотические оценки сложности алгоритмов

В большинстве случаев нет необходимости находить точное число действий, выполняемых алгоритмом. Интерес представляет общий вид зависимости времени работы алгоритма от размера входных данных, стремящегося в пределе к бесконечности – т.е. асимптотическая временная сложность (аналогично можно рассматривать асимптотическую пространственную сложность). Так, для вышерассмотренного примера T(n) имеет вид an2+bn+c. Однако, можно огрубить данную зависимость ещё сильней и сказать, что T(n) имеет порядок n2. Слагаемые низшего порядка не учитываются, поскольку при больших входных данных они играют незначительную роль. Мультипликативную константу при старшем члене зачастую также опускают. Причины этого в следующем:

Мультипликативная константа может зависеть от разных факторов, не связанных непосредственно с алгоритмом – например, от мастерства программиста, качества компилятора и других факторов.

Для подавляющего большинства известных алгоритмов эта константа находится в разумных пределах. Это означает, что алгоритмы, которые более эффективны асимптотически, оказываются более эффективными и при тех сравнительно небольших размерах входных данных, для которых они используются на практике. Для примера рассмотрим два алгоритма сортировки. Пусть первый алгоритм выполняет сортировку массива из n чисел за 2·n2 операций, второй – за 100·n·log2n операций. Хотя при совсем маленьких значениях n первый алгоритм работает быстрее, с увеличением n второй алгоритм становится значительно более эффективным. Так, при n=10000 второй алгоритм работает в 15 раз быстрее первого, при n=100000 – в 120 раз, а при n=1000000 – более чем в 1000 раз.

Примечание

Асимптотические оценки всё-таки достаточно грубо характеризуют алгоритм, и в ряде случаев при анализе алгоритма (особенно при сравнении алгоритмов одного порядка сложности) стремятся получить и более точные оценки, например, сколько раз выполнится та или иная специфическая операция. Так, для алгоритмов сортировки часто рассматриваются такие характеристики, как число сравнений элементов и число замен.

Рассмотрим теперь

данные понятия более строго. Запись

f(n)=Θ(g(n))

(читается как “тэта от g от n”), где g(n)

- некоторая функция, означает следующее:

найдутся такие константы c1,c2>0

и такое число n0, что c1g(n)![]() f(n)

c2g(n)

для всех n

f(n)

c2g(n)

для всех n![]() n0.

Функция g(n) в этом случае является

асимптотически точной оценкой для

f(n). На рис. 1.4а. показана иллюстрация

данного определения.

n0.

Функция g(n) в этом случае является

асимптотически точной оценкой для

f(n). На рис. 1.4а. показана иллюстрация

данного определения.

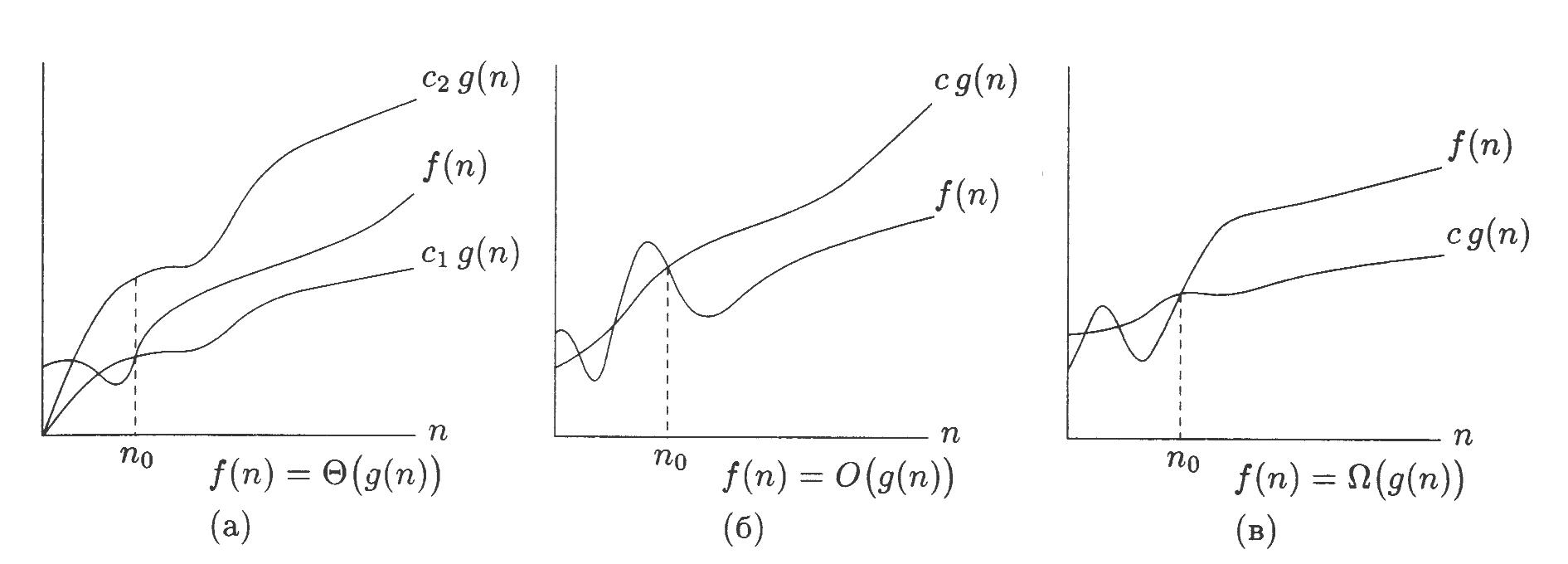

Рис .1.4. Иллюстрации к определениям f(n)=Θ(g(n)), f(n)=O(g(n), f(n)=Ω(g(n)) (рисунок взят из [9]).

Здесь и далее предполагается, что функции f и g неотрицательны по крайней мере для достаточно больших n.

Пример 1. Покажем, что (n+1)2=Θ(n2). Нам нужно найти такие константы c1 и c2, что для всех достаточно больших n будут выполняться неравенства: c1n2 (n+1)2, (n+1)2 c2n2.

Возьмём c1=1, тогда первое неравенство, очевидно, верно для всех n 1. Возьмём c2=4. Тогда имеем:

(n+1)2

4n2

![]() (n+1)2-4n2

0

(n+1-2n)(n+1+2n)

0

(1-n)(3n+1)

0.

(n+1)2-4n2

0

(n+1-2n)(n+1+2n)

0

(1-n)(3n+1)

0.

Полученное неравенство также выполняется для всех n 1. Таким образом, действительно (n+1)2=Θ(n2).

Пример 2. Покажем,

что 3n![]() Θ(2n).

Для этого убедимся, что неравенство

3n

c22n

не может выполняться для всех достаточно

больших n ни для какого

фиксированного c2.

Имеем:

Θ(2n).

Для этого убедимся, что неравенство

3n

c22n

не может выполняться для всех достаточно

больших n ни для какого

фиксированного c2.

Имеем:

3n c22n (3/2)n c2.

Какая бы большая ни была константа c2, выражение (3/2)n при достаточно больших n всё равно превысит её. Отсюда следует, что 3n Θ(2n).

К сожалению, далеко не всегда для алгоритма легко получить точную асимптотическую оценку, и приходится удовлетворяться оценками менее точными. Говорят, что f(n)=O(g(n)) (читается “О большое от g от n”), если найдётся такая константа c>0 и такое число n0, что f(n) cg(n) для всех n n0 (рис. 1.4,б). Функция g(n) представляет собой верхнюю асимптотическую оценку функции f(n) (где f(n) - например, время работы или другая характеристика алгоритма).

Зная оценку времени выполнения алгоритма T(n)=O(g(n)), мы можем сказать, что число операций алгоритма не превышает g(n), умноженному на некоторую константу. Однако, мы не знаем, действительно ли алгоритм будет выполнять столько операций – возможно, на самом деле их значительно меньше. Например, для алгоритма сортировки пузырьком, рассмотренного выше, можно сказать, что T(n)=O(n4). Однако, оценка T(n)=O(n3) характеризует алгоритм более точно, а T(n)=O(n2) - ещё точней (она совпадает с точной асимптотической оценкой). При анализе алгоритма нужно стремиться получить верхнюю оценку как можно ниже.

Аналогично определяется нижняя асимптотическая оценка. Говорят, что f(n)=Ω(g(n)), если найдётся такая константа c>0 и такое число n0, что f(n) cg(n)) для всех n n0 (рис. 1.4в). Зная, что временя выполнения алгоритма T(n)=Ω(g(n)), мы можем сказать, что число операций алгоритма не меньше, чем g(n), умноженное на некоторую константу. Однако, данная характеристика не показывает, насколько действительно больше операций выполняет алгоритм в действительности. При анализе алгоритма нужно стремиться получить как можно более высокую нижнюю оценку.

Точная асимптотическая оценка времени работы алгоритма находится где-то между его нижней и верхней оценками. В частности, несложно показать, что если T(n)=O(g(n)) и T(n)=Ω(g(n)), то T(n)=Θ(g(n)).

Примечание

Иногда нижняя граница определяют несколько по-другому [3]: говорят, что f(n)=Ω(g(n)), если существует такая константа c, что f(n) cg(n)) для бесконечно большого количества значений n. Например, алгоритм, который выполняет n операций для чётных значений n и n2 для нечётных, с этой точки зрения будет иметь максимальную нижнюю границу Ω(n2), тогда как для ранее данного определения – только Ω(n). Однако, для большинства практических алгоритмов оценки совпадают.

Наиболее часто встречающиеся асимптотические оценки

В следующей таблице приведены некоторые наиболее часто встречающиеся асимптотические оценки сложности. Для каждой из них также приводится примерное время работы соответствующей программы на некоторых входных данных, а также его изменение при увеличении размера входных данных в 10 раз (будем считать, что 10 миллионов простых операций выполняются примерно за 1 секунду).

Таблица1.1

Типичные временные оценки сложности

Оценка |

Пояснение и примеры типичных задач |

Время работы при n=10 |

Время работы при n=100 |

Θ(1) |

Время выполнения алгоритма не зависит от объёма входных данных |

100 нс |

100 нс |

Θ(log n) |

Логарифмическое время. Например, двоичный поиск, поиск в сбалансированном дереве и др. |

332 нс |

664 нс |

Θ(n) |

Линейное время. Например, каждый элемент массива обрабатывается постоянное число раз. |

1 мкс |

10 мкс |

Θ(n∙log n) |

Обычно характерно для программ, использующих стратегию ”разделяй и властвуй”, например, алгоритмы быстрой сортировки или сортировка слиянием |

3,32 мкс |

66,44 мкс |

Θ(nk) |

Полиномиальная сложность. Большое число разнообразных алгоритмов. |

10 мкс (для k=2) |

1 с (для k=2) |

Θ(kn) |

Экспоненциальная сложность. Характерна для переборных алгоритмов. |

102 мкс (для k=2) |

4,2·1015 лет (для k=2) |

Θ(n!) |

Факториальная сложность. Также может встретиться в переборных алгоритмах. |

0,363 с |

1,08·10146 лет |