Корольов / Теория связи

.pdfопорных генераторов или путем передачи сведений о фазе сигналов и моментах отсчетов ti ,ti +T по отдельному каналу связи.

Наряду с оптимальными методами обработки принимаемых сигналов в настоящее время находят широкое распространение квазиоптимальные (подоптимальные) правила приема. Это происходит по разным причинам. Во-первых, кроме статистических, существуют другие критерии, например, стоимость, габариты, вес и т. д., которые могут существенно повлиять на принцип построения всего комплекса связи в целом. Во-вторых, оптимальные методы обработки иногда бывает трудно реализовать. Например, трудно построить согласованный фильтр для достаточно сложных сигналов или учесть некоторые параметры, необходимые для разработки оптимальных методов. В-третьих, некоторые неоптимальные методы мало уступают оптимальным, но отличаются большей простотой, универсальностью и экономичностью.

Конечно, при любом неоптимальном построении приемного устройства вероятность ошибки повышается и для того, чтобы сохранить качество связи, приходится повышать мощность передатчика или уменьшать дальность связи.

Величина η , показывающая, во сколько раз необходимая мощность сиг-

нала Pc в одной системе больше мощности сигнала в другой системе, называет-

ся энергетическим проигрышем первой системы относительно второй. Обычно энергетический проигрыш выражают в децибелах [6]:

η[дБ]=10 lg |

Pc1 |

. |

(3.68) |

|

|||

|

Pc2 |

||

|

|

||

3.5.2. Квазиоптимальные методы приема

Методы обработки сигналов, у которых энергетический проигрыш (3.64) относительно оптимальных не превышает нескольких единиц децибел, принято называть квазиоптимальными (подоптимальными, субоптимальными). Как правило, квазиоптимальные методы обработки отличаются тем, что вместо оптимальных фильтров применяют более простые полосовые фильтры а операция интегрирования заменяется фильтрацией.

141

В современных системах связи наибольшее применение находят схемы квазиоптимального приема, использующие сигналы ОФМн. Среди методов приема ОФМн сигналов наибольшее распространение получили методы сравнения фаз, обеспечивающие некогерентный прием, и методы сравнения полярностей при когерентном приеме.

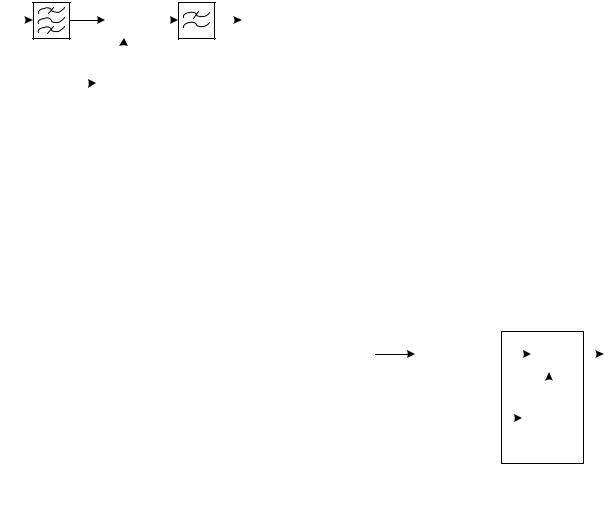

Структурная схема демодулятора ОФМн сигналов по методу сравнения фаз представлена на рис. 3.18. В фазовом детекторе (ФД) производится сравне-

ние фаз принятого Ui (t) |

и предыдущего U j (t −τзадерж ) сигналов. Формирование |

||||||||||||

Ui (t ) |

|

|

|

|

|

y(t ) выходных сигналов y(t) после ФД осуществ- |

|||||||

|

|

|

|

|

|||||||||

|

|

|

|

|

|

|

|

|

|

|

|

|

ляется так же, как и в схеме приема ФМн |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|||

|

|

|

|

|

|

|

U j (t − τзадерж ) |

||||||

|

|

|

|

|

|

|

|||||||

|

|

|

|

|

τзадерж |

|

|

|

|

сигналов. Так как в этой схеме в качестве |

|||

|

|

|

|

|

|

|

|

|

опорного напряжения для ФД используется |

||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|||

|

|

|

|

|

|

|

|

|

|

|

|||

|

|

|

|

|

|

|

|

|

|

|

|

|

принятый сигнал, то появление обратной ра- |

|

|

|

|

|

|

|

|

|

|

|

|

|

боты принципиально исключается. |

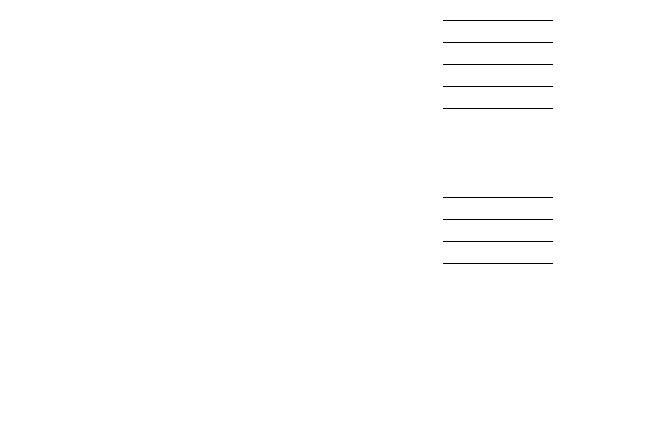

Демодулятор ОФМн сигналов по методу сравнения полярностей функционально состоит из двух частей: когерентного демодулятора ФМн сигналов и относительного декодера, или схемы сравнения полярностей (рис. 3.19). Принимаемый сигнал сначала обрабатывается когерентным демодулятором ФМн и,

конечно, на его выходе наблюдается обрат- |

|

|

|

|

|

y(t ) |

|||||

U (t ) |

|

|

|

|

|

|

|

|

|

||

|

|

|

|

|

|

|

|

|

|||

ная работа. Однако относительный декодер |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

(линия задержки (ЛЗ) и устройство сравне- |

|

|

|

|

|

|

|

|

|||

|

|

|

|

|

|

|

|

|

|||

|

|

|

|

|

|

τзадерж |

|

|

|||

ния (УС)) устраняет ее. Это происходит по- |

|

|

|

||||||||

|

|

|

|

|

|

|

|||||

тому, что в УС сравниваются полярности |

|

|

|

|

|

|

|

||||

|

|

|

|

|

|

|

|||||

настоящей и предыдущей посылок и выра- |

|

|

|

|

|

|

|

||||

батывается выходной сигнал по следующе- |

|

|

|

|

|

|

|

||||

му правилу: если полярности совпадают вырабатываются положительное напряжение; если полярности соседних посылок разные – отрицательное. Обратная работа изменяет полярность как настоящей, так и предыдущей посылок и поэтому не сказывается на полярности сигнала на выходе УС.

Отношение мощности сигнала к мощности шума на выходе полосового

142

фильтра рассчитывается по формуле [6]:

|

|

|

|

|

|

|

|

|

|

|

|

|

2 |

|

|

|

Pc |

= Pc |

Pc вх |

= |

Pc вхT |

= |

h |

, |

|||||||

|

|||||||||||||||

|

|

|

|

|

|

|

|

|

|

||||||

P |

N |

0 |

∆F |

N |

0 |

∆FT |

∆FT |

||||||||

|

ш вых |

|

|

|

|

|

|

|

|

|

|

||||

где ∆F - полоса пропускания фильтра. Поскольку на выходе оптимального фильтра отношение равно h2:

|

2 |

|

Рс |

|

|

Рс Т |

, то |

|

h |

|

|

= |

|||||

|

|

|

||||||

|

= |

|

|

N0 |

||||

|

|

|

Рш ОПТ |

|

|

|||

энергетический проигрыш квазиоптимального метода

η = ∆FT .

Чем уже полоса пропускания фильтра ∆F , тем меньше энергетический проигрыш квазиоптимальной схемы. Однако чрезмерное уменьшение ширины полосы пропускания фильтра приводит к увеличению длительности переходных процессов в устройстве; действие предыдущей посылки начинает сказываться на последующей. Вероятность ошибки увеличивается. Оптимальная с

точки зрения помехоустойчивости ширина полосы пропускания ∆Fопт T2 . По-

этому энергетический проигрыш в лучшем случае составляет около 2 дБ. Учитывая энергетический проигрыш ∆FT , который получается при заме-

не согласованных фильтров полосовыми фильтрами, получим следующие оценки вероятностей ошибок в подоптимальных схемах [6]

|

|

|

1 |

|

|

|

|

Pc |

T |

|

|

1 |

|

|

||

pош |

= |

|

|

|

− |

|

= |

|

− |

|||||||

|

|

|

|

|

|

|

|

|||||||||

2 |

exp |

4N0 |

|

|

|

2 |

exp |

|||||||||

|

|

|

|

|

|

|

∆FT |

|

|

|

||||||

|

1 |

|

|

|

|

Pc |

|

для ЧМн; |

|

|||||||

pош = |

|

|

− |

|

|

|

||||||||||

|

|

|

|

|

||||||||||||

2 |

exp |

|

|

|

|

|

||||||||||

|

|

|

|

2N0 ∆F |

|

|

|

|

|

|

||||||

Pc |

|

для АМн; |

|

||||

|

|

||||||

|

|

||||||

|

|

|

|||||

4N0 ∆F |

|

|

|

|

|

||

|

1 |

|

|

Pc |

|

для ОФМн. |

|

pош = |

|

− |

|

||||

|

|

||||||

2 |

exp |

|

|

||||

|

|

|

N0 ∆F |

|

|||

Сравнивая помехоустойчивость оптимального и квазиоптимального приема дискретных сигналов видим, что переход к квазиоптимальному приему сигналом ЧМн приводит к увеличению вероятности ошибки вследствие уменьшения h2 в ∆FT раз.

Контрольные вопросы

1. Как ставится задача обнаружения сигнала на фоне помех?

143

2.В чем сущность критерия среднего риска?

3.В чем состоит сущность критерия максимального правдоподобия?

4.Нарисуйте и поясните по схеме работу оптимального корреляционного приемника.

5.Нарисуйте и поясните по схеме работу оптимального приемника на согласованных фильтрах.

6.Определите значение отношения сигнал/шум обеспечивающего вероятность ошибки рош =10−5 , для рассмотренных методов манипуляции.

7.Сравните потенциальную помехоустойчивость систем с АМн, ЧМн, ФМн и ОФМн.

8.В чем состоит сущность квазиоптимальных алгоритмов приема?

144

ГЛАВА 4. ТЕОРИЯ ПЕРЕДАЧИ ИНФОРМАЦИИ 4.1. Информационные характеристики источника сообщений

Из определения информации как совокупности неизвестных для получателя сведений следует, что в общем случае дать оценку количества информации довольно затруднительно, так как всякое подлежащее передаче сообщение имеет свое содержание, свой смысл и определенную ценность для получателя. Одно и то же сообщение может давать одному получателю много информации, другому мало. Однако содержательная сторона несущественна для теории и техники связи и поэтому не учитывается при определении количественной меры информации.

4.1.1. Количественное определение информации

В основу измерения количества информации положены вероятностные характеристики передаваемых сообщений, которые не связаны с конкретным содержанием сообщений, а отражают степень их неопределенности. Естественно, что чем меньше вероятность сообщения, тем больше информации оно несет.

Количество информации I (xi ) в отдельно взятом единичном сообщении xi

определяется величиной, обратной вероятности появления сообщения вычисляется в логарифмических единицах [2]:

|

1 |

|

= −logb (p(xi )). |

|

|

|

|

(4.1) |

|||

|

|||||

I (xi )= logb p(x ) |

|||||

|

i |

|

|

|

|

Логарифмическая мера, впервые предложенная в 1928 г. английским ученым Р. Хартли, обладает свойством аддитивности, что соответствует нашим интуитивным представлениям об информации. Кроме того, при p(xi )=1 количе-

ство информации, вычисленное по (4.1), равно нулю, что соответствует принятому определению информации.

Если источник выдает зависимые сообщения xi = x1,..., xm , то они характе-

ризуются условными вероятностями |

|

xi |

|

|

. И в этом случае количество |

|

|

|

|||

|

|

||||

p x ,..., x |

|

|

|||

|

|

1 |

m |

|

|

информации вычисляется по формуле (4.1) с подстановкой в нее условных вероятностей сообщений.

145

Единицы измерения количества информации.

Выбор основания логарифмов в формуле (4.1) определяет единицы измерения количества информации. При использовании десятичного логарифма (b =10) информация измеряется в десятичных единицах – дитах. В случае ис-

пользования натуральных логарифмов единицей измерения является натуральная единица – нат.

Более удобно в системах, работающих с двоичными кодами, использовать основание логарифма b = 2 , и тогда информация измеряется в двоичных единицах – дв.ед. Весьма часто вместо двоичных единиц используется эквивалентное название – бит, возникшее как сокращенная запись английских слов binary digit (двоичная цифра). 1 бит это количество информации, которое передается единичным символом сообщения, вероятность передачи которого

I (xi )= −log2 (0,5)= −log2 12 = −log2 (2−1 )=1 (бит).

В настоящее время термин бит в информатике, вычислительной и импульсной технике употребляется не только как единица количества информации, но и для обозначения числа двоичных символов 0 и 1, поскольку они обычно равновероятны и каждый из них несет 1 бит информации.

Количество информации в сообщении, составленном из n символов, определяется по формуле [2]:

m

I (x, n)= −n ∑p(xi ) log2 p(xi ),

i=1

где i = {1,..., m} – номер символа xi из алфавита источника; p(xi ) – вероятность передачи i -го символа.

4.1.2. Энтропия и производительность дискретного источника сообщений

Энтропия источника сообщений

Для большинства реальных источников сообщения имеют разные вероятности. Например, в тексте буквы А, О, Е встречаются сравнительно часто, а Щ, Ы – редко. Согласно экспериментальным данным, для букв русского алфавита

146

характерны безусловные вероятности, сведенные в табл. 4.1.

|

|

|

|

|

Таблица 4.1 |

|

|

Безусловные вероятности букв русского алфавита |

|

|

|||

|

|

|

|

буква |

|

|

буква |

вероятность |

буква |

вероятность |

вероятность |

||

пробел |

0,175 |

М |

0,026 |

Ч |

|

0,012 |

О |

0,090 |

Д |

0,025 |

Й |

|

0,010 |

Е |

0,072 |

П |

0,023 |

Х |

|

0,009 |

А |

0,062 |

У |

0,021 |

Ж |

|

0,007 |

И |

0,062 |

Я |

0,018 |

Ю |

|

0,006 |

Т |

0,053 |

Ы |

0,016 |

Ш |

|

0,006 |

Н |

0,053 |

З |

0,016 |

Ц |

|

0,004 |

С |

0,045 |

Ь,Ъ |

0,014 |

Щ |

|

0,003 |

Р |

0,040 |

Б |

0,014 |

Э |

|

0,003 |

В |

0,038 |

Г |

0,013 |

Ф |

|

0,002 |

Л |

0,035 |

К |

0,028 |

|

|

|

При разных вероятностях сообщения несут различное количество информации I (xi ). При решении большинства практических задач необходимо знать среднее количество информации, приходящееся на один элемент сообщения. Это среднее количество информации при общем числе элементов сообщения источника n и числе символов алфавита m равно:

|

I (x, n) |

m |

|

|||

H (X )= |

= −∑p(xi ) log2 p(xi ) (бит/сообщение). |

(4.2) |

||||

n |

|

|

||||

|

|

|

i=1 |

|

||

Величину H (X ) |

называют энтропией источника сообщений. Термин «эн- |

|||||

тропия» заимствован из термодинамики, где она характеризует среднюю неопределенность состояния системы молекул вещества. В теории информации этот термин введен в 1948 г. американским ученым К. Шенноном [49] и далее более строго определен советскими математиками А.Я. Хинчиным [46, 47, 48]и А.Н. Колмогоровым [27]. Физически энтропия H (X ) выражает среднюю неоп-

ределенность состояния источника сообщений и является объективной информационной характеристикой источника. Энтропия всегда положительна и принимает максимальное значение при равновероятных сообщениях [2]:

m |

1 |

|

|

1 |

|

|

|

Hmax (X )= −∑ |

|

log2 |

|

|

|

= log2 (m). |

(4.3) |

m |

|

||||||

i=1 |

|

m |

|

|

|||

Минимальное значение энтропии Hmin (X )= 0 соответствует случаю, когда

одна из вероятностей p(xi )=1, а остальные равны нулю, т.е. имеется полная оп-

147

ределенность.

Для источника с зависимыми сообщениями энтропия тоже вычисляется как математическое ожидание количества информации на один элемент этих сообщений. Следует заметить, что полученное в этом случае значение энтропии будет меньше, чем для источника независимых сообщений. Это следует из того, что при наличии зависимости сообщений неопределенность выбора уменьшается и, соответственно, уменьшается энтропия. Так, в тексте после сочетания "чт" вероятнее всего, что третьей буквой будет "о" и маловероятно появление в качестве третьей буквы "ж" или "ь". В среднем, сочетание "что" несет меньше информации, чем эти буквы в отдельности.

Наиболее широкое применение в дискретных системах передачи информации получили двоичные источники. Двоичные источники характеризуются передачей только двух возможных сообщений. Причем, если вероятность передачи одного из них p(x1 ), то вероятность передачи другого p(x2 )=1 − p(x1 ).

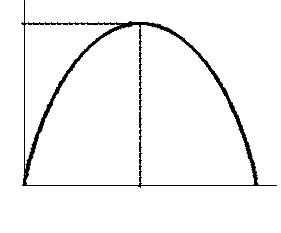

Определим энтропию двоичного источника. Из формулы (4.2) получим:

|

2 |

p(xi )= −p(x1 ) log2 |

p(x1 )− p(x2 ) log2 p(x2 )= |

|

|

H (X )= −∑p(xi ) log2 |

(4.4) |

||

|

i=1 |

|

|

|

|

= −p(x1 ) log2 p(x1 )−[1− p(x1 )] log2 [1− p(x1 )]. |

|

||

H (X ) |

|

|

График зависимости (4.4) пред- |

|

1 |

|

|

ставлен на рис. 4.1. Как следует из |

|

|

|

|

графика, энтропия двоичного ис- |

|

|

|

|

точника изменяется в пределах от |

|

|

|

|

нуля до единицы. Энтропия равна |

|

|

|

|

нулю, когда вероятность передачи |

|

0 |

0,5 |

p(xi ) |

одного из символов равна нулю или |

|

|

|

|

единице, т.е. передается только од- |

|

но сообщение. Получение же одного единственно возможного сообщения никакой новой информации не дает. Энтропия двоичного источника будет максимальна, если существует наибольшая неопределенность, т.е. p(x2 )= p(x1 )= 0,5 . При этом H (X )= log2 m =1 .

но сообщение. Получение же одного единственно возможного сообщения никакой новой информации не дает. Энтропия двоичного источника будет максимальна, если существует наибольшая неопределенность, т.е. p(x2 )= p(x1 )= 0,5 . При этом H (X )= log2 m =1 .

148

Избыточность источника сообщений

Избыточными в источнике являются сообщения, которые несут малое, иногда нулевое, количество информации. Наличие избыточности означает, что часть сообщений можно и не передавать по каналу связи, а восстановить на приеме по известным статистическим связям. Так и поступают при передаче телеграмм, исключая из текста союзы, предлоги, знаки препинания, поскольку они легко восстанавливаются по смыслу телеграммы на основании известных правил построения фраз.

Количественно избыточность оценивается коэффициентом избыточности:

χ = |

Hmax ( X ) − H ( X ) |

=1 − |

H ( X ) |

, |

(4.5) |

|

Hmax ( X ) |

||||||

|

Hmax ( X ) |

|

|

|

где H (X ) – энтропия источника; Hmax (X )= log2 m – максимальная энтропия источника с алфавитом из m сообщений.

Избыточность при передаче сообщений имеет свои положительные и отрицательные стороны. Увеличение избыточности приводит к увеличению времени передачи сообщений, излишней загрузке каналов связи. За определенный промежуток времени по каналу передается меньшее количество информации, чем это возможно; поэтому одной из задач теории информации и техники кодирования является задача сокращения избыточности.

Однако при увеличении избыточности появляется возможность повышения помехоустойчивости передачи сообщений. Так, избыточность текста позволяет исправлять отдельные ошибки или восстанавливать пропущенные буквы или даже слова в телеграмме. У русского и всех европейских языков избыточность с учетом всех статистических зависимостей букв примерно одинакова χ = 0,5 . Она сформировалась в результате длительной, общественной практики на основе требований исправления искажения слов и фраз под воздействием различных мешающих факторов. Для систем связи устанавливается компромиссное значение избыточности, которое обеспечивает заданную скорость и надежность передачи сообщений.

149

Производительность источника сообщений

Для источников сообщений с фиксированной скоростью важным параметром является его производительность H ′(X ), определяемая выражением:

H′(X)= T1 H(X) [бит/с],

где T – интервал времени для передачи элементарного сообщения. Физический смысл производительности – количество информации, выда-

ваемое источником в среднем за единицу времени (одну секунду) его непрерывной работы.

4.2. Пропускная способность дискретного канала 4.2.1. Количество информации переданной по дискретному

каналу

Основной задачей систем связи является передача информации от источника к получателю. Решение этой задачи сопряжено с определенными трудностями, связанными не только с представлением информации в виде сообщения, пригодного для восприятия и обработки, но и с преобразованием данного сообщения в сигнал, пригодный

|

H (X |

) C |

|

I(Y , X )= H (X )− H (X Y ) |

H (Y |

) |

для передачи по линии связи. |

|

|

||||||

|

|

|

|

H (X Y ) H (Y X ) |

Представим графически процесс |

||

|

|

|

|

передачи информации по каналу |

|||

|

|

|

|

|

|

|

связи (рис.4.2) и учтем при этом |

|

|

|

|

|

|

|

возможное влияние помех. |

|

|

Пусть дискретный канал определяется: |

|

||||

|

|

X = {xi } |

– алфавитом источника сообщений; |

||||

|

|

Y = {y j } |

– алфавитом получателя сообщений; |

||||

|

|

H (X Y ) |

– «потерями» информации; |

|

|||

|

|

H (Y X ) |

– ложной информацией, создаваемой помехами; |

||||

I (Y , X ) – количеством информации, переданной по каналу.

150