- •1.Случайные величины.Распределение вероятностей.Аксиома измерений.

- •2. Закон больших чисел. Теорема Бернулли

- •7. Пуассоновский импульсный процесс

- •8.Случайные функции: их задание, сходимость, непрерывность и стационарность.

- •9. Моменты случайных функций

- •10. Эргодические случайные процессы

- •11. Функция автокорреляции

- •12. Спектральные характеристики случайных процессов

- •13. Корреляционная теория случайных последовательностей

- •14. Спектр процесса на выходе линейной системы

- •15. Распределение вероятностей на выходе линейной системы. Теорема о нормализации

- •16. Узкополосный гауссов процесс

- •17. Спектр колебаний с флуктуирующей частотой

- •19. Нелинейное безинерциальное преобразование. Корреляц-ые фии на выходе генератора гармоник

- •20. Марковские процессы .Уравнение Смолуховского

- •21. Марковский процесс с дискретными состояниями

- •22. Двумерные случайные блуждания

- •23. Уравнение Фоккера-Планка-Колмогорова

- •24. Стохастические дифференциальные уравнения. Случайные функции с независимыми приращениями

- •25. Усреднение точного решения стохастического дифференциального уравнения

- •26. Уравнение для средних и его связь с уравнением фпк.

- •27. Уравнение Лиувилля.Случайный телеграфный сигнал.

- •28. Тепловой шум в линейных диссипативных системах. Теорема Найквиста

- •29. Дробовой и фликкер-шум. Шумы полупроводниковых приборов

- •30. Шумы усилителей

- •31. Корреляционные и спектральные характеристики случайного поля

- •32. Эмв в статистически неоднородной среде

- •33. Анализ случайной дифракции методом мма

- •34. Плоская случайная волна в диспергирующей среде

- •35. Корреляционная функция одномодового и многомодового лазерного излучения

2. Закон больших чисел. Теорема Бернулли

Р/м

СВ ,

имеющую конечную дисперсию 2

и среднее, равное

![]() .

Для любого числа

.

Для любого числа

Поскольку вне интервала

![]() величина

величина

![]() заведомо больше

заведомо больше![]() ,

получим:

,

получим:

Положив a = , получим

|

|

(1.13) |

Р/м теперь СВ N, которая является средним арифметическим набора из N попарно независимых случайных величин I

![]() дисперсии

этих величин конечны D()

C.

Очевидно, дисперсия величины N

также будет ограничена:

дисперсии

этих величин конечны D()

C.

Очевидно, дисперсия величины N

также будет ограничена:

Используя неравенство Чебышева, мы можем записать

![]()

Тогда

![]()

Таким образом, для всякого > 0 выполняется равенство

|

|

(1.14) |

закон больших чисел или теоремой Чебышева, для всякого > 0

![]()

то последовательность N сходится к числу a по вероятности. Сходимость по вероятности обозначается следующим образом:

![]() Рассматривая

серию из N

испытаний, появлению некоторого события

A

в испытании с номером i

поставим в соответствие i

= 1, в противном случае будем считать i

= 0. Тогда

Рассматривая

серию из N

испытаний, появлению некоторого события

A

в испытании с номером i

поставим в соответствие i

= 1, в противном случае будем считать i

= 0. Тогда

![]()

частота появления события A. получим

![]()

Согласно теореме Чебышева (1.14), можно записать

|

или

|

(1.15) |

Таким образом, частота появления события A сходится по вероятности к величине p –вероятности события A в математическом смысле. Доказанное утверждение носит название теоремы Бернулли Другими словами, частотное определение вероятности является вполне корректным способом установления соответствия между чисто математическим понятием (вероятностью p), для которого вводятся утверждения и доказываются теоремы, и экспериментально наблюдаемой частотой появления событий.

Другая запись теоремы Бернулли:

![]()

то есть среднее арифметическое сходится по вероятности к математическому ожиданию. Более сильным утверждением является теорема Бореля,

|

|

(1.16) |

Помимо определенной выше сходимости по вероятности существует еще ряд определений сходимости. Если для последовательности случайных величин i выполняется равенство

![]()

говорят, что последовательность сходится к числу a почти наверняка. Если же

![]()

говорят, что последовательность i сходится к числу a в среднеквадратичном смысле и обозначают такой предел следующим образом:

![]()

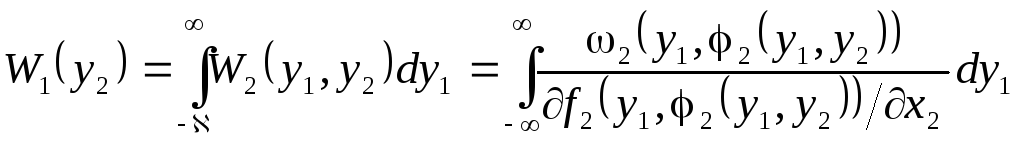

3. Совместные и условные распределения.Р/м две зависимые СВ– и . Пусть событие A заключается в том, что x, а событие B – в том, что y. Тогда можно рассмотреть вероятность события AB: P{AB}=P{ x, y} = F2(x, y). Введенная здесь функция F2(x, y) называется двумерной интегральной функцией распределения вероятностей и обладает очевидными свойствами:F2(x, ) = F1(x), F2(, y) = F1(y), F2(– , y) = F2(x, – ) = 0. Если F2(x, y) – дважды дифференцируема, можно ввести двумерную функцию плотности вероятности:

![]()

Выражения для двумерной ф-ии плотности вер-сти

![]()

![]()

|

|

(1.17) |

Если

СВ

и

независимы, то F2(x,

y)

= F1(x)F1(y)

и 2(x,

y)

= 1(x)1(y).

Для зависимых величин

и

можно записать условную вероятность

того, что одна из них находится ниже

уровня y,

если другая заключена в интервал

![]() Опираясь на соотношения (1.2) и (1.17),

получим:

Опираясь на соотношения (1.2) и (1.17),

получим:

В

пределе при

![]() получим

получим

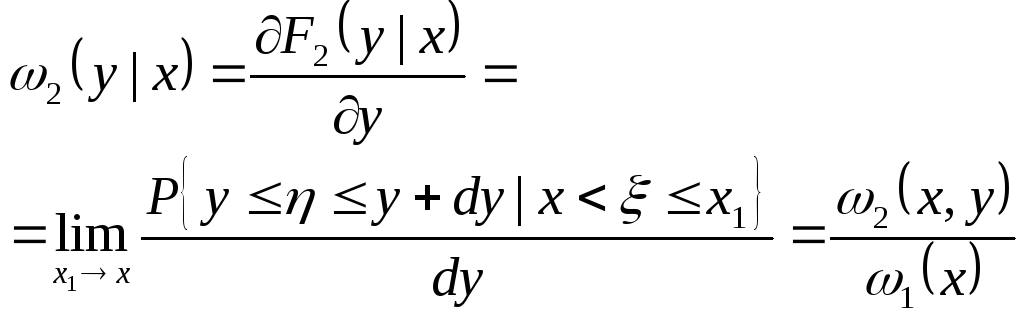

Полученная функция F2(y| x) называется условной интегральной вероятностью распределения величины при условии = x. Введем также двумерную условную функцию плотности вероятности:

|

|

(1.18) |

формула полной вероятности:

|

или

|

(1.19) |

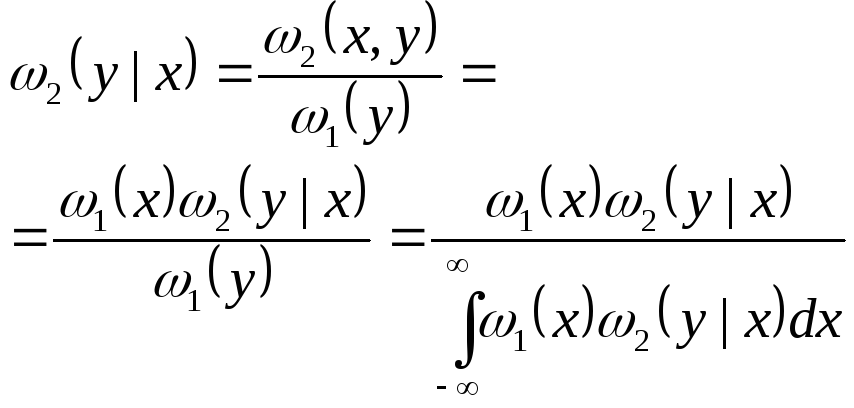

То. можно записать:

|

|

(1.20) |

аналог формулы Байеса для двумерной условной функции плотности вероятности.

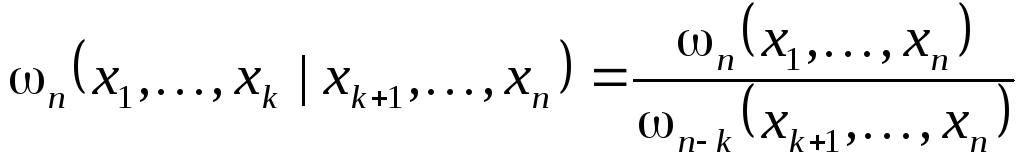

Р/м общий случай. Для совокупности из n СВ 1,…, n введем n-мерную интегральную вероятность

![]()

и n-мерную функцию плотности вероятности

![]()

Очевидно, для n независимых случайных величин выполняется соотношение

![]()

Если

трактовать совокупность случайных

величин 1,…,

n

как компоненты случайного вектора

![]() в некоторомn-мерном

пространстве, можно рассмотреть событие

A,

заключающееся в том, что конец вектора

в некоторомn-мерном

пространстве, можно рассмотреть событие

A,

заключающееся в том, что конец вектора

![]() попал в некоторую областьG

этого пространства. Тогда

попал в некоторую областьG

этого пространства. Тогда

![]()

![]()

Для совокупности СВ опеделены моменты:

центральныемоменты

центральныемоменты

и смешанные моменты

![]() Смешанный

центральный момент второго порядка

называется ковариацией:

Смешанный

центральный момент второго порядка

называется ковариацией:

![]()

Если 1 и 2 независимы, то cov(1,2) = 0. Коэффициентом корреляции R(1, 2) называется ковариация, нормированная следующим образом:

Ясно,

что коэффициент корреляции безразмерен

и |R(1,

2)|

< 1. Если R(1,

2)

= 0, то говорят, что случайные величины

1

и 2

некоррелированы.

Заметим, что независимые случайные

величины всегда некоррелированы, а вот

обратное утверждение неверно. Случайные

величины 1

и 2

называются ортогональными,

если m2(1,

2)

= 0.

Ясно,

что коэффициент корреляции безразмерен

и |R(1,

2)|

< 1. Если R(1,

2)

= 0, то говорят, что случайные величины

1

и 2

некоррелированы.

Заметим, что независимые случайные

величины всегда некоррелированы, а вот

обратное утверждение неверно. Случайные

величины 1

и 2

называются ортогональными,

если m2(1,

2)

= 0.

Вводятся условные моменты

Р/м

классический пример – многомерное

нормальное распределение

Р/м

классический пример – многомерное

нормальное распределение

Здесь

D

– главный определитель корреляционной

матрицы с элементами dij

= R(i,

j)

= dji

(i

j),

dii

= 1, |dij|

1, а Dij

– алгебраическое дополнение элемента

dij.

Можно показать, что

![]() и

и![]()

Рассмотрим более подробно двумерное нормальное распределение:

|

|

(1.21) |

где R = R(i, j). Вторые центральные моменты

Рассмотрим случайную точку на плоскости (x1, x2), координаты которой 1 и 2 – независимые случайные величины, распределенные в соответствии с функцией плотности вероятности (1.21) с нулевыми средними и одинаковыми дисперсиями . Найдем вероятность попадания

точки в круг радиуса с центром в начале координат (рис. 1.5):

Соответствующая этой интегральной вероятности функция плотности имеет вид

|

|

(1.22) |

и называется распределением Рэлея (рис. 1.6)

Рис. 1.6. Распределение Рэлея

Рис. 1.5. Случайная точка на плоскости

4. Характеристические функции По определению характеристической функцией называется среднее от комплексной экспоненты <exp(ju)>:

![]()

Характеристическая функция является Фурье-образом функции плотности вероятности 1(x).обратное ПФ

|

|

(1.24) |

Характеристическая функция ограничена по модулю:

![]()

Р/м среднее произвольной функции СВ f():

Где

![]() –Фурье-образ

исходной функции f().

–Фурье-образ

исходной функции f().

Поскольку характеристическая функция, так же, как и функция плотности вероятности, однозначно описывает распределение вероятностей, с ее помощью можно найти моменты случайной величины. Р/м n-производную характеристической функции

![]()

Отсюда

![]()

Разлагая в определении характеристической функции (1.23) экспоненту в ряд по степеням x, получим:

|

|

(1.25) |

Часто в ряд разлагают не саму характеристическую функцию, а ее логарифм

|

|

(1.26) |

Коэффициенты ряда (*) n() называются семиинвариантами и являются рациональными функциями моментов случайной величины . Так, например 0() = 0, 1() = m1, 2() = M2 = 2, 3() = M3, 4() = M4 – 3M22 и т. д.

Характеристическая функция одномерного нормального распределения (1.12) равна

а все семиинварианты, начиная с номера n = 3, равны нулю. Характеристическая функция суммы независимых случайных величин = + равна произведению характеристических функций (u) = (u)(u), а семиинварианты равны сумме соответствующих семиинвариантов m() = m() + m(). Эти соотношения позволяют записать выражения для функции плотности вероятности суммы независимых случайных величин. Поскольку Фурье-образ произведения равен свертке Фурье-образов, получаем

|

|

(1.27) |

Это выражение называется формулой композиции.

Для

n-мерной

случайной величины

![]() можно ввестиn-мерную

характеристическую функцию:

можно ввестиn-мерную

характеристическую функцию:

![]()

5. Центральная предельная теорема ЦПТ была доказана Ляпуновым и формулируется следующим образом: Пусть 1,…, N – независимые СВ, средние значения которых равны соответственно <i> = ai, дисперсии ограничены и равны M2(i) = i2 < C < . Если для любого > 0 выполняется равенство

то случайная величина

![]() имеет

распределение, равномерно сходящееся

к нормальному при N

независимо от распределения слагаемых.

имеет

распределение, равномерно сходящееся

к нормальному при N

независимо от распределения слагаемых.

Приведем доказательство ЦПТ для случая, когда все случайные величины 1,…, n распределены одинаково с равными средними <i> = a и дисперсиями M2(i) = 2. Примером такого случая может служит выборка одной случайной переменной (t). Введем новые величины i = i – a, для которых <i> = 0, D(i) = 2, D(i/N) = 2/N2 = N2/N. Теперь построим случайную величину

![]() и

запишем выражение для ее характеристической

функции с учетом формулы (1.25):

и

запишем выражение для ее характеристической

функции с учетом формулы (1.25):

При N это выражение эквивалентно следующему:

![]()

![]()

что при N эквивалентно выражению

Для СВ с ненулевым средним

N = N + a при этом имеем

Таким образом, распределение выборочного среднего случайной величины равномерно сходится к нормальному с тем же средним и дисперсией, в N раз меньшей.

Необходимым условием ЦПТ является ограниченность дисперсий исходных процессов 1,…, n. пример-распределение Коши

![]()

у которого не существует моментов всех четных порядков (в том числе – второго). Соответствующая этому распределению характеристическая функция равна

![]()

что для суммы N случайных величин дает

![]() Таким

образом, функция плотности вероятности

суммы равна

Таким

образом, функция плотности вероятности

суммы равна

![]() то

есть опять получается распределение

Коши. Для выполнения ЦПТ часто достаточно

не независимости случайных величин, а

их некоррелированности или даже убывания

коэффициента корреляции с достаточно

высокой скоростью, то есть

то

есть опять получается распределение

Коши. Для выполнения ЦПТ часто достаточно

не независимости случайных величин, а

их некоррелированности или даже убывания

коэффициента корреляции с достаточно

высокой скоростью, то есть

![]()

6. Функция случайной величины Под функцией случайной величины (ФСВ) мы будем понимать детерминированную функцию, зависящую от какого-либо параметра (от времени, координаты и т. д.) и конечного числа случайных величин. Например

![]() –

–

функция случайной величины, зависящая от времени.

Рис. 2.1. Случайная импульсная последовательность

Классическим примером ФСВ является последовательность возникающих в случайные моменты времени импульсов одинаковой формы со случайной высотой (рис. 2.1), которая может быть описана в виде

![]()

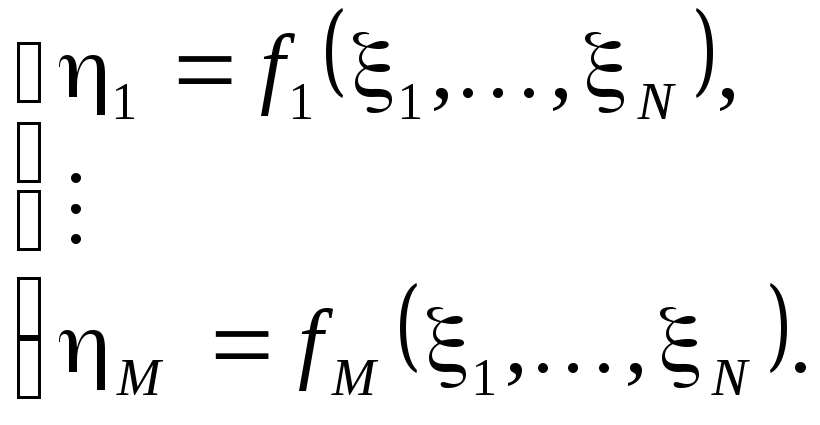

Пусть задано совместное распределение вероятностей N(x1,…,xN) совокупности случайных величин 1,…, N и задана совокупность M однозначных непрерывных функций N переменных вида

Необходимо найти совместное распределение вероятностей WN(y1,…,yN) случайных величин 1,…, M. В одномерном случае задача сводится к нахождению распределения W1(y) случайной величины = f(), если известно распределение 1(x).Рассмотрим одномерную задачу и предположим, что функция f(x) дифференцируема и существует обратная функция x = g(y), то есть связь величин и взаимно однозначна. Тогда, очевидно, при df/dx > 0 вероятность P{ y} = P{ x = g(y)}, а при df/dx < 0 вероятность P{ y} = P{ x = g(y)}. Используя определение функции плотности вероятности (1.6), получим:

Объединяя

эти равенства, получим

Объединяя

эти равенства, получим

|

|

|

В качестве примера рассмотрим линейную зависимость = f() = a + b, где в качестве случайного выступает гауссов процесс с нулевым средним и дисперсией 2 получим:

![]() Р/м

случай, когда функция y

= f(x)

такова, что обратная ей функция x

= g(y)

неоднозначна, то есть одному значению

y

соответствует несколько значений g(y)

– x1,

x2

и т. д.. В этом случае событию y

y

+ dy

соответствует одно из взаимоисключающих

событий: x1

x1

+ dx1,

x2

x2

+ dx2

и т. д., запишем

Р/м

случай, когда функция y

= f(x)

такова, что обратная ей функция x

= g(y)

неоднозначна, то есть одному значению

y

соответствует несколько значений g(y)

– x1,

x2

и т. д.. В этом случае событию y

y

+ dy

соответствует одно из взаимоисключающих

событий: x1

x1

+ dx1,

x2

x2

+ dx2

и т. д., запишем

|

|

|

Примером

такого случая может служить квадратичное

преобразование

= 2,

![]() того же гауссова процесса с нулевым

средним. Функция плотности вероятности

процесса

будет иметь вид:

того же гауссова процесса с нулевым

средним. Функция плотности вероятности

процесса

будет иметь вид:

Еще один вариант реализуется, когда из одной случайной величины получаются две – 1 = f1() и

2 = f2(), причем существует обратная функция = g1(1). Тогда 2 = f2(g1(1)) = F(1), а условное распределение имеет вид

![]()

что с учетом (1.20) дает возможность записать

Аналогично, если известна двумерная функция плотности вероятности (x1, x2) и зависимости

1 = f1(1, 2) и 2 = f2(1, 2) при наличии обратных функций (не обязательно однозначных) 1 = g1(1, 2) и 2 = g2(1, 2), двумерная функция W2(y1, y2) может быть записана в виде

|

|

|

Здесь индекс k определяет номер неоднозначности обратных функций, а величина

-якобиан

преобразования. При однозначных

преобразованиях в этом выражении будет

только один член.

-якобиан

преобразования. При однозначных

преобразованиях в этом выражении будет

только один член.

Распределение одной СВ, являющейся функцией двух других, то есть = 2 = f2(1, 2), положив 1 = 1. Тогда