- •1 Аксиоматика множеств действительных чисел

- •Действительные числа

- •Изображение вещественных чисел бесконечными десятичными дробями

- •Изоморфизм

- •Мощность множества

- •2 Ограниченные и неограниченные множества

- •Ограниченные множества

- •Верхняя и нижняя грань

- •Теорема Архимеда

- •Метод математической индукции

- •3 Предел числовой последовательности

- •Числовые последовательности

- •Свойства бесконечно малых числовых последовательностей

- •Связь бесконечно больших и бесконечно малых последовательностей

- •Предел числовой последовательности

- •4 Сходящиеся последовательности

- •Свойства сходящихся числовых последовательностей

- •Предельный переход и неравенства

- •Теорема о двух милиционерах

- •5 Монотонные последовательности

- •Определение

- •Теорема Вейерштрасса

- •Число Эйлера

- •Система стягивающихся сегментов

- •6 Частичные пределы последовательности

- •Подпоследовательности

- •Частичные пределы

- •Критерий сходимости числовой последовательности

- •7 Критерий Коши

- •Фундаментальная последовательность

- •Критерий Коши

- •Телескопический признак сходимости

- •Покрытие множеств

- •Предельные точки множеств

- •9 Предел функции

- •Определения

- •Предел функции в точке по Коши

- •Предел функции в точке по Гейне

- •Эквивалентность формулировок

- •Односторонние пределы

- •10 Теоремы, связанные с понятием предела функции

- •Арифметические операции с пределами

- •Предел композиции функций

- •Предельный переход и неравенства

- •11 Критерий Коши существования предела функции

- •Критерий Коши

- •Асимптотическое сравнение функций

- •Свойства отношения эквивалентности

- •Замечательные пределы

- •Первый замечательный предел

- •Второй замечательный предел

- •Таблица эквивалентностей

- •12 Непрерывность функции

- •Понятие непрерывности

- •Свойства непрерывных функций

- •Арифметические операции над непрерывными функциями

- •Непрерывность композиции функций

- •Классификация точек разрыва

- •Точки разрыва монотонной функции

- •13 Локальные и глобальные свойства непрерывных функций

- •Локальные свойства

- •Локальная ограниченность функции, имеющей конечный предел

- •Сохранение знака непрерывной в точке функции

- •Глобальные свойства

- •Прохождение непрерывной функции через 0 при смене знаков

- •Прохождение непрерывной функции через любое промежуточное значение

- •Критерий непрерывности монотонной функции

- •14 Теоремы Вейерштрасса

- •Первая теорема Вейерштрасса

- •Вторая теорема Вейерштрасса

- •Производная функции

- •Понятие производной

- •Односторонние производные

- •Геометрическая интерпретация производной

- •Дифференцируемость функции

- •16 Теоремы о дифференцируемости функций I

- •Правила дифференцирования

- •Функции, заданные параметрически

- •17 Теоремы о дифференцируемых функциях II

- •18 Теоремы о дифференцируемых функциях III

- •19 Производные высших порядков

- •Определение

- •Формула Лейбница

- •Инвариантность формы дифференциала

- •Инвариантность первого дифференциала

- •Нарушение инвариантности для дифференциалов высших порядков

- •Дифференцирование функции, заданной параметрически

- •20 Равномерная непрерывность

- •Равномерная непрерывность

- •Модуль непрерывности и колебание функции на отрезке

- •21 Раскрытие неопределенностей

- •Первое правило Лопиталя

- •Второе правило Лопиталя

- •Применение на практике

- •22 Формула Тейлора

- •Постановка задачи

- •Формула Тейлора с остаточным членом в форме Пеано и Лагранжа

- •Единственность разложения

- •Разложение по формуле Маклорена

- •23 Исследование функций методами дифференциального исчисления I

- •Условия монотонности функций

- •Условия точек экстремума

- •Асимптота графика функции

- •Выпуклость функции и точки перегиба

- •Геометрическая интерпретация выпуклости

- •Точки перегиба

- •25 Функции нескольких переменных

- •Определения

- •Классификация точек

- •Открытые и замкнутые множества

- •Окрестность точки

- •Предел функции

- •Функции двух переменных

- •Непрерывность

- •Частные производные ФНП и ее дифференциал

- •Необходимые условия дифференцируемости

- •Достаточное условие дифференцируемости

- •27 Дифференцируемость сложной функции нескольких переменных

- •Дифференцируемость сложной функции

- •Инвариантность формы первого дифференциала и правила дифференцирования

- •28 Частные производные и дифференциалы высших порядков

- •Смешанные производные

- •Второй дифференциал ФНП

- •29 Геометрический смысл частных производных и полного дифференциала

- •Частная производная первого порядка

- •Касательная плоскость

- •Производная по направлению

- •Градиент

- •30 Неявные функции

- •Понятие неявной функции

- •Теорема о существовании и дифференцируемости неявной функции

- •Теорема о разрешимости системы неявных функций

- •31 Безусловный экстремум функции нескольких переменных I

- •32 Безусловный экстремум функции нескольких переменных II

- •Необходимое условие локального экстремума в терминах второй производной

- •Критерий Сильвестра

- •Достаточное условие локального экстремума для функции двух переменных

- •Формула Тейлора и замена переменных для ФНП

- •Формула Тейлора в многомерном случае

- •Замена переменных в дифференциальных уравнениях

- •33-34 Условный локальный экстремум

- •Метод исключения для нахождения точек условного экстремума

- •Метод неопределенных множителей Лагранжа

- •Достаточные условия существования условного экстремума по методу Лагранжа

- •35 Первообразная функция и неопределенный интеграл I

- •Основные определения

- •Свойства неопределенного интеграла

- •Методы интегрирования

- •36 Первообразная функция и неопределенный интеграл II

- •Разложение многочлена на множители

- •Комплексные числа

- •Разложение многочлена на множители

- •Интегрирование рациональных дробей

- •37 Первообразная функция и неопределенный интеграл III

- •Некоторые тригонометрические выражения

- •Квадратичные иррациональности

- •38 Определенный интеграл Римана I

- •Разбиение отрезка

- •Свойства измельчения

- •Определенный интеграл

- •Необходимое условие интегрируемости

- •Критерий интегрируемости функции по Риману

- •39 Определенный интеграл Римана II

- •Интегральные суммы Дарбу

- •Достаточные признаки интегрируемости

- •Свойства интегрируемых функций

- •Безымянное свойство

- •Аддитивность

- •Линейность интеграла

- •Интегрируемость произведения

- •Неотрицательность определенного интеграла

- •Интегрируемость модуля

- •Ну и еще два свойства

- •40 Определенный интеграл Римана III

- •Теоремы о среднем

- •Первая теорема о среднем

- •Вторая теорема о среднем

- •Связь между определенным и неопределенным интегралами

- •Основная формула интегрального исчисления

- •Замена переменной в определенном интеграле

- •Интегрирование по частям

- •41 Несобственные интегралы

- •Несобственные интегралы I рода

- •Несобственные интегралы II рода

- •Сходимость в смысле главного значения

- •Критерий Коши сходимости несобственных интегралов I рода

- •42 Признаки сравнения несобственных интегралов

- •Простейшие признаки сравнения

- •Абсолютная и условная сходимость

- •Признак Дирихле

- •Признак Абеля

- •43 Приложения интегрального исчисления к вычислению площадей

- •Многоугольные фигуры

- •Свойства площади

- •Квадрируемость фигуры

- •Критерии квадрируемости

- •Криволинейная трапеция

- •Параметрически заданная кривая

- •Площадь фигуры в полярной системе координат

- •Понятие кривой на плоскости и в пространстве

- •Длина дуги кривой

- •Объем тела вращения

- •Дифференцирование под знаком интеграла

- •Теория

- •Примеры

- •Вопросы для самопроверки перед коллоквиумом

- •45 Численные методы

- •Метод бисекции

- •Нахождение всех корней полинома

- •Метод Ньютона

- •Метод золотого сечения

- •Градиентный спуск

- •Приближенное вычисление определенных интегралов

- •Метод прямоугольников

- •Метод трапеций

- •Метод Симсона

- •Различные равенства и неравенства

- •Тригонометрические тождества

- •Классика

- •Гиперболические функции

- •Предел числовой последовательности

- •Функции

- •Функции нескольких переменных

- •Таблица производных

- •Ряды Маклорена

- •Таблица неопределенных интегралов

- •Методы интегрирования

- •Интегрирование рациональных функций

- •Метод неопределенных коэффициентов

- •Метод Остроградского

- •Рационализация интегралов

- •Обобщенная формула интегрирования по частям

- •Более нестандартные примеры

- •Определенные и несобственные интегралы

Однако если выбрать 0 = −1, то метод быстро сойдется. Чтобы облегчить выбор начального приближения, сформулируем следующую теорему.

Теорема 45.1 (Достаточное условие сходимости метода Ньютона). Если ( ) · ( ) < 0, причем ′( ) и ′′( ) отличны от 0 и сохраняют определенные знаки при 6 6 , то исходя из начального приближения 0, удовлетворяющего неравенству ( 0) · ′′( 0) > 0, можно вычислить единственный корень уравнения ( ) = 0 с любой степенью точности.

Заметим, что данное условие не является необходимым. Однако в данном случае мы не сможем выбрать такие и , чтобы условие выполнялось при 0 = 0. Заметим, что если выбрать = −5, = −1, 0 = −1, то условие выполняется и метод действительно сходится.

Таким образом, не стоит применять его бездумно. Но при должном анализе метод Ньютона сослужит хорошую службу.

4Метод золотого сечения

Сейчас мы рассмотрим метод (а также его небольшую модификацию), который позволяет искать минимум (максимум) некоторой непрерывной унимодальной функции. Функция ( ) называется унимодальной на отрезке [ , ], если , 6 6 : [ , ) ( ) ( ( ) ) и ( , ] ( ) ( ( ) ). Иными словами, функция унимодальна, если [ , ], такое, что при < функция не убывает (не возрастает), а при > функция не возрастает (не убывает). Несмотря на то, что унимодальные функции встречаются не так часто, а исследование на унимодальность зачастую нетривиально, этот метод может быть полезен. Например, если мы можем разбить исходную область поиска функции X на отрезки, на которых они унимодальна, то для нахождения глобального минимума достаточно выбрать минимум из найденных значений на каждом отрезке.

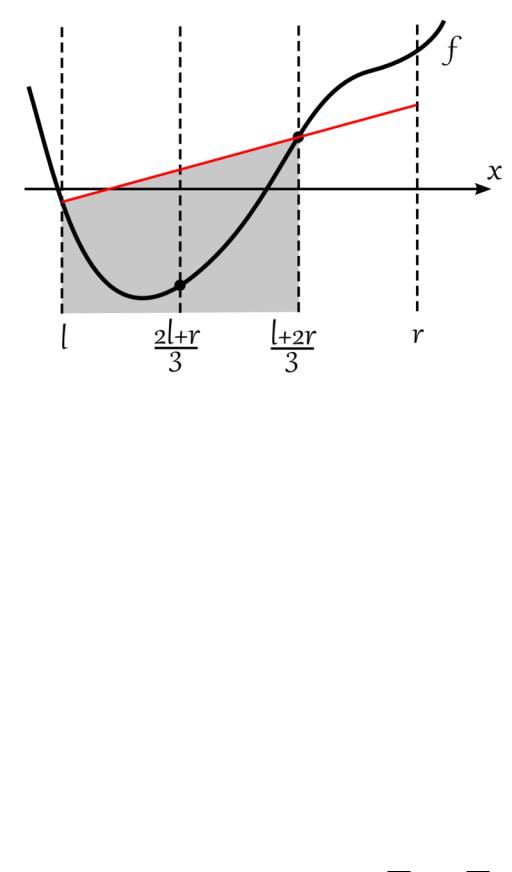

Для начала рассмотрим более простой тернарный поиск. Будем считать, что функция( ): [ , ] →R непрерывна на отрезке [ , ] и унимодальна на нем, причем ! : [ , ], ̸=( ) > ( ) (насчет строгости данного неравенства будет сказано ниже). Как и раньше, мы хотим найти минимум с некоторой точностью . Метод очень похож на метод бисекции: мы также сужаем границы поиска до тех пор, пока не найдем с нужной погрешностью искомую точку.

1.Если выполняется − < , то искомый минимум найден (в качестве его можно взять,

например, точку ′ = +2 ). Посчитаем значения функции в точках = 2 3+ и = +23 . Теперь рассмотрим несколько вариантов:

( ) > ( ). Это возможно в двух случаях. Если < и > , то искомый минимум лежит где-то на отрезке [ , ] (а точнее на [ , ]). Если же < и < , то минимум лежит на отрезке [ , ] (а точнее на [ , ]). Поскольку мы можем не знать точно, какой из случаев имеет место, то выберем такие новые границы для отрезка [ ′, ′], чтобы по-прежнему в любом случае выполнялось ′ 6 6 ′. В качестве такого нового отрезка подходит [ , ]. Иными словами, необходимо поставить = .

( ) < ( ). Этот случай абсолютно симметричен предыдущему. Если < и> , то искомый минимум лежит на отрезке [ , ]. Это продемонстрировано на рисунке ниже. В случае > и > минимум также лежит на отрезке [ , ]. Значит, необходимо поставить = .

149

( ) = ( ). Вот тут стоит быть внимательным. Если мы точно знаем, что функция строго унимодальна, т.е. она сначала строго убывает, а потом строго возрастает, то данное равенство возможно лишь в случае < и > , а значит, в качестве новых границ поиска следует задать = , = . Заметим, что ради упрощения этот случай можно отнести к любому из вышеперечисленных, поскольку какие бы новые границы мы не взяли, отрезок [ , ] будет принадлежать любой из них. Однако если мы не можем гарантировать строгую унимодальность, то тернарный поиск неприменим. Действительно, в таком случае возможно еще 2 варианта: < , < и> , > . И тут уже нельзя совершенно точно сказать, какие новые границы поиска следует задать. Если взять их за [ , ], то в случае > , > искомый минимум выйдет за пределы отрезка. Если же принять [ , ], то это же самое произойдет при < , < .

2.После установки новых границ поиска вернемся к шагу 1.

Оценим скорость работы данного метода. После каждой итерации рассматриваемый отрезок уменьшается в 1.5 раза. Поэтому необходимое количество шагов для достижения нужной

точности можно оценить как = log3 ( − ) . Несмотря на то, что тернарный поиск работает

2

медленнее, чем метод бисекции, решаемая им задача сложнее. Внимательный читатель может заметить, что эту задачу можно решить, найдя производную функции, а затем ее 0 с помощью метода бисекции. Но такой вариант решения не подходит, т.к. мы не можем быть уверены, что ′( ) и ′( ) вообще существуют. Второй недостаток тернарного поиска заключается в том, что на каждом шаге необходимо вычислять значение функции в двух точках, что не очень эффективно. Поэтому оптимизируем данный поиск.

Заметим, что сходимость метода не зависит от выбора и на каждом шаге. Достаточно лишь выполнения условия < . Мы выбираем и как = 2 3+ и = +23 лишь для того, чтобы каждый раз делить отрезок [ , ] на 3 равные части, чтобы получать в некотором плане сбалансированное разбиение. Но, как мы сейчас выясним, это не самое оптимальное решение.

Попробуем подобрать такое разбиение отрезка на три части, чтобы на следующей итерации поиска одна из точек нового разбиения совпала с одной из точек текущего разбиения. Тогда

150

в следующий раз не придется считать функцию в двух точках, так как в одной она уже была посчитана. Пусть и — точки, которые мы хотим выбрать, — расстояние от до , ′ — расстояние от до , а ′′ — расстояние от до . Потребуем, чтобы выполнялось

′′ |

′ |

= |

+ ′ = ′′ |

|

|

+ |

|

|

|

|

|

′+ ′′ = |

|

|

′ + ′′ = |

|

|

|

||

|

′ |

= |

= ′ |

|

|

|

|

|||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

′′′ |

= |

|

′′ = ′ |

|

|

|

||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

В данном случае, — это то отношение, |

в котором мы разбиваем отрезок. Получаем |

|||||||||

|

|

|

√ |

|

|

|||||

уравнение + 1 |

= 2, единственным положительным |

корнем которого является = |

1+ 5 |

. |

||||||

|

||||||||||

|

|

|

|

|

|

|

|

2 |

|

|

Это не что иное, как золотое сечение. Теперь научимся вычислять точки и , пользуясь найденным отношением. Заметим, что достаточно найти и ′, тогда = + , = + + ′.

Как мы уже знаем, ′ + ′′ = . С другой стороны, ′ + ′′ = − − . Т.е. = +1− . Для суммы получаем следующее: + ′ = − − ′′ = − − = − − +1− .

Значит, = + +1− и = − +1− . Таким образом, метод золотого сечения выглядит следующим образом:

1.Вычисляем и , пользуясь указанными выше формулами, а также 1 = ( ) и 2 = ( ).

2.Если − < , то искомый минимум найден. Теперь рассмотрим несколько вариантов, как

ив тернарном поиске.

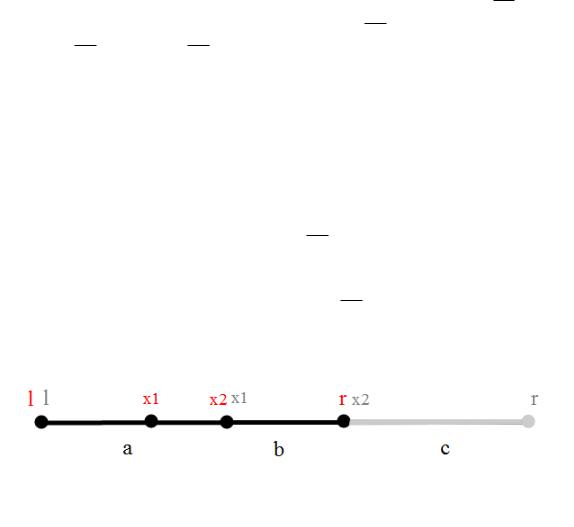

Если 1 > 2, то, как мы уже знаем, в качестве новых границ поиска следует поставить [ , ], поэтому сдвинем границу = . После такого сужения отрезка точка

должна перейти в точку , а значит следует поставить = и 1 = 2. Осталось лишь пересчитать значения для : = − +1− , 2 = ( ).

1 < 2, симметричный предыдущему случай. Новыми границами станут [ , ], т.е.

примем = . После этого сужения перейдет в , значит поставим = , 2 = 1. И вычислим новые значения для : = + +1− , 1 = ( ). Этот случай продемонстрирован на рисунке ниже. В наших обозначениях, 1 это , 2 это , а , , соответственно расстояния , ′, ′′.

1 = 2. Аналогично троичному поиску, мы можем рассматривать этот случай в одном из двух вышеперечисленных, если функция строго унимодальна.

3.Вернемся к шагу 2.

Таким образом, вычислить значение функции в двух точках нужно лишь на самой первой итерации, на каждой следующей мы пользуемся уже ранее посчитанными значениями. На каждом шаге область поиска сужается в ≈ 1.62 > 1.5 раз, т.е данный метод и сходится быстрее, нежели тернарный поиск.

151

5Градиентный спуск

Атеперь изучим метод поиска локального минимума функции многих переменных. Пусть есть точка 0, в окрестности которой мы хотим найти локальный минимум, и функция (¯). Рассмотрим последовательность точек:

1 = 0 − 0 ( 0),2 = 1 − 1 ( 1),

. . .

+1 = − ( ).

Здесь 0, 1, . . . , — некоторые вещественные числа, о выборе которых речь пойдет ниже. Вспомним, что такое градиент . Условно говоря, это направление наибыстрейшего роста функции. Аналогично можно заключить, что − — это направление наибыстрейшего уменьшения функции. Таким образом, мы можем ожидать, что ( 0) > ( 1) > . . . > ( +1), т.е. данная последовательность сходится к искомому локальному минимуму. В качестве критерия остановки метода можно взять (как и обычно) неравенство | ( ) − ( +1)| < .

Теперь обсудим самое главное, а именно выбор на -ом шаге. От этого во многом зависит сходимость метода. Существует 3 способа это делать:

0 = 1 = · · · = = , где = . Заметим, что в этом случае должно быть достаточно малым, чтобы метод не «скакал» вокруг искомого минимума. При неудачном выборе метод может никогда не сойтись. Однако для постоянного шага существует критерий остановки спуска:

Теорема 45.2. Пусть (¯) дифференцируема и ограничена снизу, а для градиента выполняется условие:

R : ′, ′′ E( ) | ( ′) − ( ′′)| 6 | ′ − ′′|.

Тогда , : 0 < < 2 ( +1) < ( ), причем lim ( ) = 0.

→∞

Иными словами, если выполняется условие теоремы, то метод сойдется при соответствующем выборе либо к локальному минимуму, либо (если минимума в окрестности нет)

к inf (¯).

+1 = , т.е. используется дробление шага. Мы не будем подробно анализировать данный способ, т.к. его анализ достаточно сложен. Следует отметить, что этот способ обладает обычно большей скоростью сходимости нежели предыдущий.

= arg |

min ( − ( )), т.е. на каждом шаге ищется такое , что величина |

[0,+∞)

( ) − ( ) минимальна. Иными словами, мы выбираем так, чтобы следующая итерация была точкой минимума функции на направлении − ( ). Это проиллюстрировано на приведенном ниже рисунке. Заметим, кстати, что в этом методе направления соседних шагов ортогональны.

152