- •Загальні поняття економетричних моделей. Задачі економетрії.

- •Кореляційно-регресійний аналіз в економіці. Функціональний та кореляційний зв’язки.

- •2) Визначення тісноти зв'язку (задача кореляційного аналізу).

- •Функція регресії. Регресор. Регресат. Причини обов'язкової присутності в регресійних моделях випадкового фактора.

- •Просторові дані. Часові ряди. Особливості часових рядів. Кореляційне поле.

- •Застосування методу Фостера-Стюарта з метою виявлення закономірного зв’язку між змінними

- •Методи вибору найкращої функції регресії

- •Економетрична модель. Специфікація моделі регресії.

- •Економетрична модель. Параметризація рівняння регресії.

- •Моделі часових рядів. Регресійні моделі з одним рівнянням.

- •Моделі часових рядів. Системи незалежних, рекурсивних, взаємозалежних рівнянь.

- •Порівнянність та однорідність даних. Повнота даних та стійкість.

- •Сутність методу найменших квадратів

- •Застосування методу максимальної правдоподібності з метою оцінювання параметрів економетричної моделі

- •Поняття кореляція. Кореляційний момент або коваріація. Коефіцієнт кореляції. Вибірковий кореляційний момент. Стандартна похибка.

- •Якісна оцінка коефіцієнтів кореляції за шкалою Чеддока. Розподіл Фішера-Іейтса.

- •Поняття кореляції. Оцінка значимості коефіцієнта кореляції з використанням t-критерію Стьюдента.

- •Матриця коефіцієнтів парної кореляції. Вибірковий коефіцієнт множинної кореляції та коефіцієнт детермінації. Вибірковий частинний коефіцієнт кореляції.

- •Проблема мультиколінеарності. Застосування алгоритму Фаррера-Глобера.

- •Індекс кореляції. Методика розрахунку кореляційного відношення.

- •Побудова економетричної моделі на основі покрокової регресії.

- •«Істинне» рівняння регресії. Парна регресія. Систематична та випадкова складові.

- •Умови Гаусса-Маркова.

- •Властивості оцінок параметрів регресійного рівняння: незміщеність, обґрунтованість, ефективність та інваріантність.

- •Оцінки найменших квадратів. Верифікація моделі. Стандартна похибка рівняння. Оцінений коефіцієнт детермінації.

- •Оцінки найменших квадратів. Перевірка значущості та довірчі інтервали. Прогнозування за лінійною моделлю.

- •Множинна регресія. Специфікація багатофакторної моделі. Помилки специфікації множинної регресії.

- •Мультиколінеарність. Практичні наслідки мультиколінеарності та методи її усунення.

- •Оцінка якості моделі множинної регресії. Перевірка виконання передумов мнк. Перевірка гіпотези про нормальний розподіл залишків регресії

- •Етапи побудови економетричної моделі.

- •Оцінка якості прогнозів за регресійними моделями

- •Нелінійна регресія відносно пояснюючих змінних. Нелінійна регресія по параметрам, що оцінюються. Внутрішньо лінійна та нелінійна функції.

- •Особливості параметризації нелінійної регресії. Вибір аналітичної форми дослідження.

- •Фіктивні змінні. Ілюстрація використання фіктивної змінної. Множинні сукупності фіктивних змінних.

- •Оцінка якості моделі. Дослідження відповідності моделі емпіричним даним. Оцінка точності моделі.

- •Поняття гомоскедастичності та гетероскедастичності залишків. Наслідки порушень припущення про гомоскедастичність.

- •Методи виявлення гетероскедастичності. Тест Голдфельда-Квандта. Тест рангової кореляції Спірмена.

- •Трансформування початкової моделі з гетероскедастичністю.

- •Зважений метод найменших квадратів.

- •Оцінювання параметрів регресії за допомогою узагальненого методу найменших квадратів (методу Ейткена).

- •Поняття автокореляції. Автокореляція залишків. Лагові затримки.

- •Природа автокореляції та її наслідки. Методи усунення автокореляції.

- •Тестування наявності автокореляції. Критерій Дарбіна-Уотсона. Критерій фон Неймана.

- •Коефіцієнти автокореляції та їх застосування. Автокореляційна функція та корелограма.

- •Оцінка параметрів моделі з автокорельованими залишками. Метод Ейткена.

- •Оцінка параметрів моделі з автокорельованими залишками. Метод Кочрена-Оркатта.

- •Прогноз на основі моделі з автокорельованими залишками.

- •Узагальнені економетричні моделі.

- •Поняття лагу і лагових змінних.

- •Дистрибутивно-лагові моделі. Авторегресійні моделі.

- •Моделі розподіленого лагу. Узагальнена модель розподіленого лагу.

- •Оцінка параметрів лагових моделей. Метод послідовного збільшення кількості лагів.

- •Перетворення Койка (метод геометричної прогресії).

- •Модель адаптивних сподівань. Модель часткового коригування.

- •Оцінювання параметрів методом Ейткена.

- •Динамічний та часовий ряди. Систематичні та випадкові компоненти часового ряду. Стаціонарність часового ряду.

- •Фільтрація компонент часового ряду. Ts, ds, тренд-сезонні, нелінійні часові ряди.

- •Дослідження автокореляційної функції часового ряду.

- •Методи фільтрації сезонної компоненти.

- •Прогнозування тенденції часового ряду за механічними методами та аналітичними методами.

- •Адаптивні методи прогнозування.

- •Метод декомпозиції часового ряду. Розрахунок сезонної хвилі.

- •Системи одночасних економетричних рівнянь. Ендогенні та екзогенні змінні.

- •Структурна та зведена форми економетричної моделі. Повна економетрична модель.

- •Ідентифікованість моделі. Необхідна та достатня умови ідентифікованості системи.

- •Непрямий метод найменших квадратів.

- •Двокроковий та трикроковий методи найменших квадратів.

- •Прогноз ендогенних змінних і загальні довірчі інтервали.

«Істинне» рівняння регресії. Парна регресія. Систематична та випадкова складові.

Після кореляційного аналізу проводиться регресійний аналіз, основною задачею якого є дослідження залежності змінної, що вивчається, від різних факторів та відображення їх взаємозв’язку у формі регресійної моделі.

Нехай

маємо набір значень двох змінних

–

пояснювальна змінна та

–

пояснювальна змінна та

–

пояснююча змінна, кожна з яких містить

n

спостережень. Нехай між ними теоретично

існує деяка лінійна залежність

–

пояснююча змінна, кожна з яких містить

n

спостережень. Нехай між ними теоретично

існує деяка лінійна залежність

, (3.1)

, (3.1)

Це рівняння будемо називати «істинним» рівнянням регресії.

Однак в дійсності між змінними спостерігається не настільки жорсткий зв'язок. Окремі спостереження будуть відхилятися від від лінійної залежності в силу різних причин. Враховуючи можливі відхилення лінійне рівняння зв’язку двох змінних (парну регресію) представимо у вигляді

, (3.2)

, (3.2)

де  –

постійна величина (або вільний член

рівняння);

–

постійна величина (або вільний член

рівняння);

–

коефіцієнт регресії, що визначає нахил

лінії. вздовж якої розсіяні дані

спостереження;

–

коефіцієнт регресії, що визначає нахил

лінії. вздовж якої розсіяні дані

спостереження;

–

випадкова змінна (випадкова складова,

залишок або збурення).

–

випадкова змінна (випадкова складова,

залишок або збурення).

Випадкова

складова відображає той факт, що зміна

буде неточно описуватися зміною

,

оскільки присутні інші фактори,

невраховані в даній моделі. Таким чином

в рівнянні (3.2) значення кожного

спостереження

представлено як сума двох частин –

систематичної

,

оскільки присутні інші фактори,

невраховані в даній моделі. Таким чином

в рівнянні (3.2) значення кожного

спостереження

представлено як сума двох частин –

систематичної

та випадкової

.

В свою чергу систематичну частину можна

представити у вигляді рівняння

та випадкової

.

В свою чергу систематичну частину можна

представити у вигляді рівняння

. (3.4)

. (3.4)

Можна сказати, що загальним моментом для будь-якої економетричної моделі є розбиття залежної змінної на дві частини – пояснену та випадкову.

Умови Гаусса-Маркова.

1. Математичне

сподівання випадкових відхилень

![]() повинно дорівнювати нулеві (незміщеність

оцінок):

повинно дорівнювати нулеві (незміщеність

оцінок):

![]() . (3.5)

. (3.5)

Ця умова вимагає,

щоб випадкові відхилення в середньому

не впливали на залежну змінну Y,

тобто в кожному конкретному спостереженні

відхилення

![]() може набувати додатні або від’ємні

значення, але не повинно спостерігатися

систематичне зміщення відхилень в

переважній більшості в бік одного знаку.

може набувати додатні або від’ємні

значення, але не повинно спостерігатися

систематичне зміщення відхилень в

переважній більшості в бік одного знаку.

Із врахуванням вищесказаного, використовуючи рівняння (3.2), будемо мати:

![]() (3.6)

(3.6)

2. Дисперсія

випадкових відхилень

![]() повинна бути сталою величиною

повинна бути сталою величиною

,

,

![]() . (3.7)

. (3.7)

Ця вимога передбачає, що не зважаючи на те, що при кожному конкретному спостереженні випадкове відхилення може виявитися відносно великим чи малим, це не повинно складати основу для апріорної причини, тобто причини, що не базується на досвіді, що спонукала б велику похибку.

Моделі,

для яких виконується умова (3.7), називають

гомоскедастичними

(рівнозмінними).

Моделі,

для яких не виконується умова (2) (![]() ),

називають гетероскедастичними.

),

називають гетероскедастичними.

Величина

,

звичайно, не відома і одна з задач

регресійного аналізу полягає в оцінці

стандартного відхилення випадкової

складової.

,

звичайно, не відома і одна з задач

регресійного аналізу полягає в оцінці

стандартного відхилення випадкової

складової.

3. Випадкові

відхилення

та

![]() ,

,

![]() повинні бути незалежними одне від

одного.

повинні бути незалежними одне від

одного.

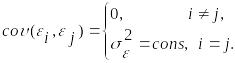

Виконання цієї умови припускає, що між будь-якими випадковими відхиленнями відсутній систематичний зв’язок, тобто величина та знак будь-якого випадкового відхилення не буде являтися причиною величини та знаку будь-якого іншого випадкового відхилення. Цю умову можна записати так

(3.8)

(3.8)

Тут

![]() є математичний запис коваріаційного

(кореляційного) моменту.

є математичний запис коваріаційного

(кореляційного) моменту.

4. Випадковий

вектор відхилень

![]() повинен бути незалежним від регресорів

повинен бути незалежним від регресорів

![]() матриці

матриці

![]() .

.

Ця умова виконується

автоматично, коли пояснюючі змінні

![]() не є стохастичними величинами в заданій

моделі.

не є стохастичними величинами в заданій

моделі.

Наявність таких властивостей оцінок гарантує, що останні не мають систематичної похибки (незміщеність), надійність їх підвищується зі збільшенням обсягу вибірки (обґрунтованість), вони є найкращими серед інших оцінок параметрів, лінійних відносно ендогенної змінної (ефективність). Крім того, оцінка перетворених параметрів (оцінка функції від параметра) може бути отримана в результаті аналогічного перетворення оцінки параметра (інваріантність).