- •1. Основные определения.

- •2. Этапы обращения информации.

- •3. Понятие сигнала и его модели.

- •4. Формы представления детерминированных сигналов.

- •5. Представление сигнала в виде взвешенной суммы базисных функций. Понятие дискретного спектра сигнала и спектральной плотности.

- •6. Ортогональное представление сигналов.

- •7. Временная форма представления сигнала.

- •8. Частотная форма представления сигнала.

- •9. Спектры периодических сигналов.

- •10. Распределение энергии в спектре периодичного сигнала.

- •11. Спектры непериодических сигналов.

- •12. Распределение энергии в спектре непериодического сигнала. Равенство Парсеваля.

- •13. Соотношение между длительностью импульсов и шириной их спектра.

- •14. Спектральная плотность мощности детерминированного сигнала.

- •15. Функция автокорреляции детерминированного сигнала.

- •16. Случайный процесс как модель сигнала. Понятие ансамбля и пространства состояний. Виды случайных процессов.

- •17. Вероятностные характеристики случайного процесса.

- •18. Стационарные и эргодические случайные процессы.

- •19. Спектральное представление случайных сигналов.

- •20. Частотное представление стационарных случайных сигналов. Дискретные спектры.

- •21. Частотное представление стационарных случайных сигналов. Непрерывные спектры.

- •22. Основные свойства спектральной плотности.

- •23. Дискретизация непрерывных величин.

- •24. Квантование по времени. Теорема Котельникова.

- •25. Понятие модуляции.

- •26. Амплитудная модуляция.

- •27. Частотная модуляция.

- •28. Фазовая модуляция.

- •29. Модуляция импульсного тока.

- •30. Кодоимпульсные сигналы.

- •31. Многократная модуляция.

- •32. Количество информации в дискретных сообщениях. Энтропия дискретного источника.

- •33. Свойства энтропии.

- •34. Условия энтропии и ее свойства.

- •35. Передача информации от дискретного источника. Частное количество информации.

- •37. Частная условная энтропия. Условная энтропия источника. Апостериорная энтропия источника.

- •38. Количество информации в переданном сообщении дискретным источником.

- •39. Энтропия квантовой величины.

- •40. Количество информации в непрерывном сообщении. Априорная (безусловная) и апостериорная (условная) дифференциальные энтропии. Симметричность выражения количества информации.

- •43. Количество и скорость передачи информации при нормальном распределении сигнала и помехе (погрешности).

- •42. Количество информации, передаваемое за определенное время. Скорость передачи информации.

- •41. Количество передаваемой информации с учетом наличия аддитивной помехи.

- •44. Количество и скорость передачи информации при равномерном распределении сигнала и нормальном распределении помехи (погрешности).

- •45. Дифференциальная энтропия равномерно распределенной погрешности. Энтропийная погрешность.

- •46. Код, кодирование, кодовые сигналы.

- •47. Системы счисления.

- •48. Числовые коды.

- •49. Коды, не обнаруживающие возможных искажений.

- •50. Коды, обнаруживающие ошибки.

- •51. Информационная способность кода и избыточность.

- •52. Коды с коррекцией искажений.

37. Частная условная энтропия. Условная энтропия источника. Апостериорная энтропия источника.

Найдем среднее количество информации, содержащееся в любом принятом элементе сообщений относительно переданного (реализованного) источником. До получения конкретного элемента сообщения средняя неопределенность, имеющаяся у адресата, относительно реализации источником любого элемента сообщения равна энтропии источника. Ее называют априорной энтропией источника.

Средняя неопределенность относительно любого состояния источника, остающаяся у адресата после получения конкретного элемента сообщения j, характеризуется частной условной энтропией Hj(z):

![]() (31)

(31)

Это случайная величина, зависящая от того, какой конкретно элемент принят.

Средняя неопределенность по всему ансамблю принимаемых элементов сообщений равна условной энтропии источника HW(Z):

![]() (32)

(32)

Эту энтропию называют апостериорной энтропией источника информации.

Таким образом, при наличии помех среднее количество информации, содержащееся в каждом принятом элементе сообщения, относительно любого переданного равно разности априорной и апостериорной энтропий источника:

![]() (33)

(33)

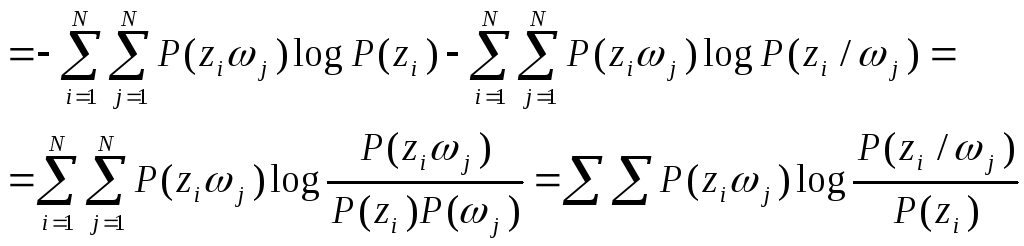

Подставив выражения

H(Z)

и HW(Z)

из (6) и (32) в (33) и проведя несложные

преобразования, получим формулу для

количества информации непосредственно

через вероятности:

![]()

(34)

Справка. Учитывая,

что сумма условных вероятностей P(zi/j)

отвечает условию нормирования, т.е.

![]() ,

можем записать:

,

можем записать:

В общем случае HW(z) есть величина дезинформации вносимой помехами (шумами).

Можно показать, что справедливо и другое выражение

![]() (35)

(35)

Доказано, что

![]() ,

т.е. среднее количество информации не

может быть отрицательным.

,

т.е. среднее количество информации не

может быть отрицательным.

При подсчете количества информации удобно применение двоичных логарифмов. Пусть объект имеет два возможных состояния. Тогда для передачи сообщений о состоянии объекта можно применить элементарный двухпозиционный сигнал. Если вероятности обоих состояний объекта равны между собой, т.е. Pi=1/2, то при пользовании двоичными логарифмами энтропия источника H(Z)=1. Этой же величине равно количество информации I, если в канале нет помех. В данном случае один элементарный сигнал несет одну двоичную единицу информации.

С помощью k элементарных двоичных сигналов можно передать сообщение об объекте, имеющем 2k возможных состояний. Если все эти состояния равновероятны, то каждое сообщение из k символов имеет количество информации, равное k двоичным единицам. Этим объясняется удобство применения двоичных логарифмов. Двоичная единица информации называется битой.

38. Количество информации в переданном сообщении дискретным источником.

Рассмотрим информационные характеристики непрерывных сообщений.

Если величина u непрерывна, она имеет бесконечное множество возможных значений. Введем для нее понятие энтропии с помощью предельного перехода.

Заменим бесконечное множество значений «u» конечным числом N значений, взятых через равные интервалы:

![]() .

.

Для k-го

значения измеряемой величины uk

получим выражение

![]() .

Вероятность появления k-го

значения находим из плотности распределения

по формуле

.

Вероятность появления k-го

значения находим из плотности распределения

по формуле

![]() .

Это выражение тем точнее, чем меньше

.

Это выражение тем точнее, чем меньше

![]() .

.