- •1. Основные определения.

- •2. Этапы обращения информации.

- •3. Понятие сигнала и его модели.

- •4. Формы представления детерминированных сигналов.

- •5. Представление сигнала в виде взвешенной суммы базисных функций. Понятие дискретного спектра сигнала и спектральной плотности.

- •6. Ортогональное представление сигналов.

- •7. Временная форма представления сигнала.

- •8. Частотная форма представления сигнала.

- •9. Спектры периодических сигналов.

- •10. Распределение энергии в спектре периодичного сигнала.

- •11. Спектры непериодических сигналов.

- •12. Распределение энергии в спектре непериодического сигнала. Равенство Парсеваля.

- •13. Соотношение между длительностью импульсов и шириной их спектра.

- •14. Спектральная плотность мощности детерминированного сигнала.

- •15. Функция автокорреляции детерминированного сигнала.

- •16. Случайный процесс как модель сигнала. Понятие ансамбля и пространства состояний. Виды случайных процессов.

- •17. Вероятностные характеристики случайного процесса.

- •18. Стационарные и эргодические случайные процессы.

- •19. Спектральное представление случайных сигналов.

- •20. Частотное представление стационарных случайных сигналов. Дискретные спектры.

- •21. Частотное представление стационарных случайных сигналов. Непрерывные спектры.

- •22. Основные свойства спектральной плотности.

- •23. Дискретизация непрерывных величин.

- •24. Квантование по времени. Теорема Котельникова.

- •25. Понятие модуляции.

- •26. Амплитудная модуляция.

- •27. Частотная модуляция.

- •28. Фазовая модуляция.

- •29. Модуляция импульсного тока.

- •30. Кодоимпульсные сигналы.

- •31. Многократная модуляция.

- •32. Количество информации в дискретных сообщениях. Энтропия дискретного источника.

- •33. Свойства энтропии.

- •34. Условия энтропии и ее свойства.

- •35. Передача информации от дискретного источника. Частное количество информации.

- •37. Частная условная энтропия. Условная энтропия источника. Апостериорная энтропия источника.

- •38. Количество информации в переданном сообщении дискретным источником.

- •39. Энтропия квантовой величины.

- •40. Количество информации в непрерывном сообщении. Априорная (безусловная) и апостериорная (условная) дифференциальные энтропии. Симметричность выражения количества информации.

- •43. Количество и скорость передачи информации при нормальном распределении сигнала и помехе (погрешности).

- •42. Количество информации, передаваемое за определенное время. Скорость передачи информации.

- •41. Количество передаваемой информации с учетом наличия аддитивной помехи.

- •44. Количество и скорость передачи информации при равномерном распределении сигнала и нормальном распределении помехи (погрешности).

- •45. Дифференциальная энтропия равномерно распределенной погрешности. Энтропийная погрешность.

- •46. Код, кодирование, кодовые сигналы.

- •47. Системы счисления.

- •48. Числовые коды.

- •49. Коды, не обнаруживающие возможных искажений.

- •50. Коды, обнаруживающие ошибки.

- •51. Информационная способность кода и избыточность.

- •52. Коды с коррекцией искажений.

33. Свойства энтропии.

-

Энтропия является вещественно и неотрицательной величиной (очевидно).

-

Энтропия – величина ограниченная. Для слагаемых – Pi log Pi при 0<Pi1 ограниченность очевидна. Остается выяснить предел

:

:

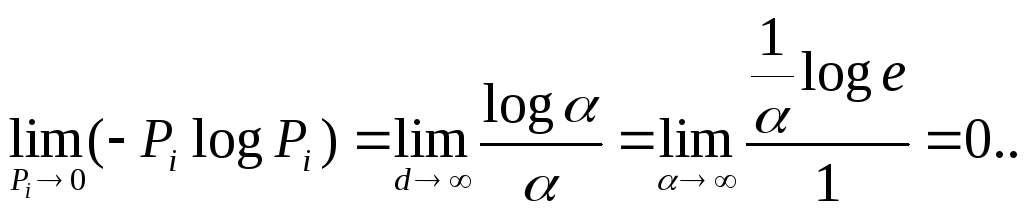

Обозначив

![]() и воспользовавшись правилом Лопиталя,

получим

и воспользовавшись правилом Лопиталя,

получим

-

Энтропия обращается в нуль лишь в том случае, если вероятность одного из состояний равна единице, а остальных - нулю, то есть состояние источника полностью определена.

-

Энтропия максимальна, когда все состояния источника равновероятны (доказывается методом множителей Лагранжа):

![]() (6)

(6)

-

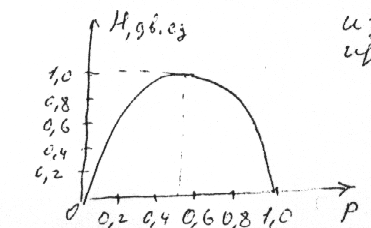

Энтропия источника «u» с двумя состояниями u1 и u2 изменяется от 0 до 1, достигая максимум при равенстве вероятностей:

![]()

График зависимости H(U) в функции P приведен на рис. 1.

![]() (7)

(7)

Отметим, что H(U) непрерывно зависит от вероятностей состояний, что вытекает из непрерывности функций – P log P.

Рис. 1.

Рис. 1.

-

Энтропия объединения нескольких статистически независимых источников информации равна сумме энтропий исходных источников.

Не теряя общности, ограничимся двумя источниками u и v.

Под объединением двух источников понимают обобщенный источник информации (u , v) характеризующийся вероятностями P(ui , vj) всех возможных комбинаций состояния ui , vj источников u и v. Аналогично трактуется объединение ансамблей.

В соответствии с определением энтропия объединения

![]() (8)

(8)

Здесь P(ui,vj)

вероятности совместной реализации

состояния

![]()

В случае статистической независимости источников u и v

![]()

тогда

![]()

![]()

Учитывая, что

![]() и

и

![]() ,

получим

,

получим

![]() (9)

(9)

Соответственно энтропия объединения нескольких не зависимых источников U, V, . . ., Z

![]() (10)

(10)

Свойства 7 и 8 для справки. 7. Энтропия характеризует среднюю неопределенность выбора одного состояния из ансамбля. При ее вероятности используют только вероятности состояний, полностью игнорируя содержательную сторону. Поэтому она не может служить средством решения любых задач, связанных с неопределенностью. Например, при использовании этой меры для оценки неопределенности действия лекарства приводящего к полному выздоровлению в 90% случаев и к частичному улучшению здоровья в 10%, оно получится такой же, как и у лекарства, вызывающего в 90% случаев смерть, а в 10% ухудшения здоровья.

8. Энтропия как мера неопределенности согласуется с экспериментальными данными, полученными при изучении психологических реакций человека.

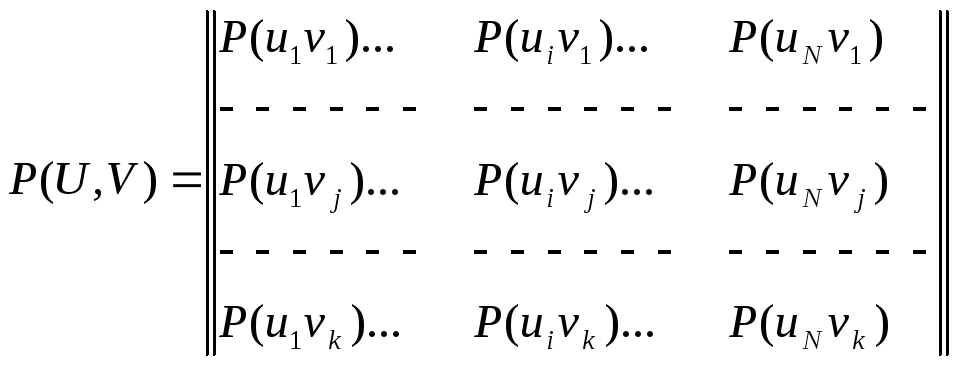

34. Условия энтропии и ее свойства.

Определим энтропию

двух статистически связанных ансамблей

U

и V.

Объединение ансамблей характеризуется

матрицей P(UV)

вероятностей P(uivj)

всех возможных комбинаций состояний

![]() ансамбля U

и

ансамбля U

и

![]() ансамбля V:

ансамбля V:

(11)

(11)

Суммируя столбцы и строки матрицы (11) получим информацию об ансамблях U и V исходных источников u и v:

![]()

![]()

Вероятности P(uivj) совместной реализации равны

![]() (12)

(12)

где

![]() и

и

![]() - условные вероятности:

- условные вероятности:

![]() - вероятность

реализации состояний ui

ансамбля U

при условии, что реализовалось состояние

vj

ансамбля V,

- вероятность

реализации состояний ui

ансамбля U

при условии, что реализовалось состояние

vj

ансамбля V,

![]() - определяется аналогично. Тогда выражение

(8) для энтропии объединения принимает

вид

- определяется аналогично. Тогда выражение

(8) для энтропии объединения принимает

вид

(13)

(13)

Обозначим и назовем сумму

![]() (14)

(14)

частной условной энтропией ансамбля. Оно представляет собой случайную величину, характеризующую неопределенность, приходящуюся на одно состояние ансамбля V при условии, что реализовалось конкретное состояние ui ансамбля U.

При усреднении по всем состояниям ансамбля U получаем среднюю неопределенность, приходящуюся на одно состояние ансамбля V при известных состояниях ансамбля U:

![]() (15)

(15)

или

![]() (16)

(16)

Величину HU(V)

называют полной условной или просто

условной

энтропией ансамбля V

по отношению к ансамблю U.

![]()

Подставляя(16) в (13) получим

![]() (17)

(17)

Выражая в (8) P(uivj) через другую условную вероятность в соответствии с (12), найдем

![]() (18)

(18)

где

![]() (19)

(19)

и

![]() (20)

(20)

Т.о. энтропия объединения двух статистически связанных ансамблей U и V равна безусловной энтропии одного ансамбля условная энтропия другого относительно первого.

Распространяя правило (17) на объединение любого числа зависимых ансамблей, получим

![]() (21)

(21)

В объединении ансамблей и условная энтропия любого ансамбля всегда меньше или равна безусловной энтропии этого же ансамбля.

![]() (22)

(22)

![]() (очевидно) (23)

(очевидно) (23)

Тогда

![]() (24)

(24)

Для нескольких ансамблей

![]() (25)

(25)

Наличие сведений о результатах реализации состояний одного ансамбля никак не может увеличить неопределенность выбора состояния из другого ансамбля. Эта неопределенность может только уменьшаться, если существует связь в реализациях состояний из обоих ансамблей.

В случае отсутствия статистической связи

![]()

![]() (26)

(26)

Если связь однозначна, то

![]()

![]() (27)

(27)

т.к. условные

вероятности

![]() и

и

![]() в этом случае

принимают значения равные нулю или

единице.

в этом случае

принимают значения равные нулю или

единице.

У яснению

соотношений между рассмотренными

энтропиями дискретных источников

информации (ансамблей) способствует их

графическое отображение (рис. 2).

яснению

соотношений между рассмотренными

энтропиями дискретных источников

информации (ансамблей) способствует их

графическое отображение (рис. 2).