- •Екзаменаційний білет № 1

- •2. Вирішення багатокрітеріальних задач.

- •3. Математичне описування динамічних систем.

- •Екзаменаційний білет № 2

- •3. Моделювання систем за допомогою безперервних марківських ланцюгів.

- •Екзаменаційний білет № 3

- •1. Планування. Управління ресурсами, боротьба з взаємоблокуванням.

- •3. Вирішення багатокрітеріальних задач.

- •Екзаменаційний білет № 4

- •1. Файлові системи. Принципи побудови файлових систем.

- •2. Основні нормальні форми. Характеристика і приклади відносин, що знаходяться в 1нф, 2нф, 3нф.

- •Id, category, product1, product2, product3

- •3. Моделювання систем за допомогою дискретних марківських ланцюгів.

- •Екзаменаційний білет № 5

- •1. Поняття асемблера, компілятора, транслятора, інтерпретатора.

- •2. Основні оператори мови маніпулювання даними. Оператор вибірки даних (одно- і багатотабличні запити оператора select).

- •3. Поняття системи масового обслуговування. Класифікація систем масового обслуговування.

- •Классификация смо и их основные элементы

- •Екзаменаційний білет № 6

- •1. Завантажувачі. Завдання завантажувачів. Принципи побудови завантажувачів.

- •2. Технологія Ethernet.

- •3. Стадії та етапи створення асу тп.

- •Екзаменаційний білет № 7

- •1. Принципи об’єктно-орієнтованого програмування (парадигми програмування, поняття класу).

- •2. Технологія Token Ring.

- •3. Склад і коротка характеристика розділів технічного проекта.

- •Екзаменаційний білет № 9

- •1. Інкапсуляція. Поняття, сфери застосування.

- •2. Характеристика протоколу hdlc.

- •3. Методи боротьби з помилками, що виникають в каналах передачі даних. Завадостійке кодування. Екзаменаційний білет № 10

- •1. Поліморфізм. Поняття, сфери застосування.

- •2. Методи доступу в мережу.

- •3. Основні параметри завадостійких кодів. Принципи виявлення та виправлення помилок.

- •Екзаменаційний білет № 11

- •1. Принципи розробки розподілених клієнт-серверних програм. Особливості розробки мережевих програм з використанням сокетів.

- •2. Характеристика протоколу ip. Адресація в ip-мережах.

- •3. Циклічні коди. Алгоритми кодування і декодування. Циклические коды.

- •Свойства циклических кодов по обнаружению ошибок

- •Екзаменаційний білет № 12

- •1. Багаторівнева комп’ютерна організація – структура й призначення рівнів.

- •2. Характеристика протоколу tcp.

- •3. Статичні методи стиснення інформації. Алгоритм арифметичного стиснення.

- •Екзаменаційний білет № 13

- •1. Схема комп’ютера з єдиною шиною. Основні характеристики та принципи роботи шини комп’ютера.

- •2. Стадії та етапи створення асу тп.

- •3. Оптимальне кодування інформації. Алгоритми формування коду Хофмана та Шенона-Фано.

- •Екзаменаційний білет № 14

- •1. Структура процесора, внутрішні блоки, види регістрів.

- •2. Склад і коротка характеристика розділів технічного проекта.

- •3. Аналого-числові перетворення безперервного сигналу на базі теореми Котельникова в.А.

- •Екзаменаційний білет № 15

- •1. Команди процесора, структура команд. Цикл Фон-Неймана.

- •2. Склад і зміст проектних рішень з технічного забезпечення.

- •3. Протоколи фізичного рівня.

- •Екзаменаційний білет № 16

- •1. Структуру пам’яті комп’ютера. Елементи статичної та динамічної пам’яті.

- •2. Склад і задачі організацій, що беруть участь у роботах зі створення асу тп.

- •3. Характеристика протоколу ip. Адресація в ip-мережах.

- •Екзаменаційний білет № 17

- •1. Переривання, типи, алгоритм обробки переривання процесором.

- •2. Перелік видів випробувань асу тп та їх короткий зміст.

- •3. Характеристика протоколу tcp.

- •Екзаменаційний білет № 18

- •1. Загальні характеристики канального рівня.

- •2. Поняття системи масового обслуговування. Класифікація систем масового обслуговування.

- •Классификация смо и их основные элементы

- •3. Пропускна спроможність двійкового каналу зв’язку з перешкодами та без перешкод.

- •Екзаменаційний білет № 19

- •1. Загальні відомості з теорії систем. Класифікація систем.

- •2. Математичне описування динамічних систем.

- •3. Загальні характеристики канального рівня.

- •Екзаменаційний білет № 20

- •1. Поняття вимірювальної шкали. Види шкал.

- •2. Основні параметри завадостійких кодів. Принципи виявлення та виправлення помилок.

- •3. Стадії та етапи створення асу тп.

- •Екзаменаційний білет № 21

- •1. Показники якості та ефективності та крітерії їх оцінювання.

- •2. Структура процесора, внутрішні блоки, види регістрів.

- •3. Основні параметри завадостійких кодів. Принципи виявлення та виправлення помилок.

- •Екзаменаційний білет № 22

- •1. Вирішення задачі вибору.

- •2. Поняття операційної системи.

- •3. Розрахунок вартості проектних робіт ресурсним методом.

- •Екзаменаційний білет № 23

- •1. Декомпозиція. Компроміси між повнотою та простотою.

- •2. Характеристика протоколу hdlc.

- •3. Застосування елементних кошторисних норм для розрахунку вартості пусконалагоджувальних робіт.

- •Екзаменаційний білет № 24

- •1. Агрегування. Види агрегування.

- •2. Методи доступу в мережу.

- •3. Багатократні та комбіновані методи модуляції.

3. Оптимальне кодування інформації. Алгоритми формування коду Хофмана та Шенона-Фано.

Оптимальное (эффективное) кодирование

Для полного использования пропускной способности канала необходимо осуществить эффективное кодирование, которое обеспечит устранение избыточности в сообщениях, что приходят от источника. Кодирование при котором обеспечивается полное использование пропускной способности канала называется оптимальным.

Первая теорема Шеннона дает ответ на вопрос, всегда ли можно осуществить оптимальное кодирование: если есть канал с пропускной способностью С, то сообщение из любого источника с энтропией Н(х)можно закодировать так, что окажется возможным передавать эти сообщения со скоростью как угодно близкой к С/Н(х) сообщений в секунду (С двоичных единиц за секунду. Рассмотрим справедливость теоремы для двоичного канала связи.

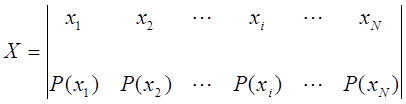

Пусть алфавит источника сообщений создает конечную систему.

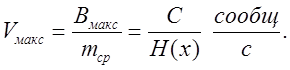

Для сообщения хiдлинна кодовой комбинации равнаmi, а вероятность ее появления Р(хі). Количество информации что содержится в i-м сообщении равноIxi=-logP(xi). Пропускная способность канала будет полностью использована, если на каждыйдвоичный символ будет приходится один бит информации. Это будет в том случае, когда количество двоичных символов в кодовой комбинации будет равно количеству информации что содержится в ней. Таким образом, условием опримального кодирования является равенство.

![]()

Усреднив это сообщение повсем возможным сообщениям получим:

Меньше чем Н(х) средняя длинна сообщения быть не может.

Максимальная скорость что может быть достигнута в двоичном канале без помех равна:

Оптимальные коды:

Код Шеннона-Фано

Все множество возможных сообщений записывается в порядке уменьшения вероятности их появления, а потом разбивается на две группы так, что бы суммы вероятностей в одной и во второй группе были примерно одинаковы. Первой цифрой для одной (н-р верхней) группы выбирается ноль, а для другой – единица или наоборот. После этого каждая группа разделяется на две подгруппы с приме6рно одинаковыми суммарными вероятностями, причем в верхних подгруппах следующей цифрой выбирают ноль, а в нижних – единицу.

Процесс повторяется до тех пор пока в каждой подгруппе не останется по одному сообщению. Оптимальность обеспечивается: 1) ни одна кодовая комбинация не может быть началом другой 2) так как при каждом разбиении мы приписываем к одной подгруппе ноль, а к другой единице, обеспечивается равномерное распределение нулей и единиц – необходимое условие полного использования пропускной способности канала, 3) При каждом разделении сообщений на две группы с примерно равными суммарными вероятностями, эти вероятности в сообщении каждой группы примерно вдвое меньше начальных. Поэтому сообщение хi, что послеk разбивок останется единственным в своей группе будет примерно равно Р(хi)=1/2k, откудаk=-log2P(xi). Но число знаков в кодовой комбинации (mi) равно числу разбивок, таким образом ее длинна равна:

![]()

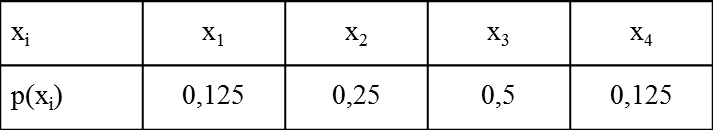

Что отвечает условию оптимального кодирования. Пример:

При решении практических задач не всегда удается разделить таблицу на две части с одинаковой вероятностью. Этот не достаток устраняется при использовании кода Хаффмана.

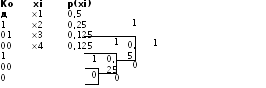

Код Хаффмана

Аналогично к коду Шеннона-Фано при использовании кода Хаффмана строится таблица в порядке уменьшения вероятности появления сообщений. Сообщения хnи хn-1соединяются в одну группу с вероятностью Р(х)=Р(хn)+Р(хn-1). Такое объединение повторяется до тех пор пока Р(х) не станет равно 1.

При

кодировании кодом Хаффмана строится

таблица

Отличие в кодировании в том, что в коде Шеннона-Фано формирование начинается со старшого (лівого) разряда. В коде Хаффмана кодове комбинации котируються начиння с младшего (правого) разряда.