- •Мониторинг в школе: интерпретация и использование результатов

- •Введение

- •Глава 1. Качество школьного ОбразоваНия

- •1.1. Понятие «школьное образование»

- •Вопросы для размышления

- •1.2. Проблема оценки качества школьного образования

- •Вопросы для размышления

- •1.3. Образовательная деятельность школы

- •Вопросы для размышления

- •1.4. Качество школьного образования

- •Вопросы для размышления

- •Глава 2. Методы оценки качества школьного ОбразоваНия

- •2.1. Требования к средствам диагностики для оценки школьного образования

- •Вопросы для размышления

- •2.2. Диагностика школьных учебных достижений

- •Вопросы для размышления

- •2.3. Диагностика развития личности школьников

- •Вопросы для размышления

- •2.4. Диагностика психологической комфортности обучения в школе

- •Вопросы для размышления

- •Глава 3. Мониторинг качества образования в школе

- •3.1. Принципы организации мониторинга качества образования в школе

- •Вопросы для размышления

- •3.2. Технология оценки качества школьного образования

- •Вопросы для размышления

- •3.3. Система оценки качества образования в школе

- •6А биология 24.10.2002

- •Раздел 1 2 3 4 всего

- •02В образовательный потенциал 20.11.2002

- •Раздел 1 2 3 всего

- •11А мотивация 31.10.2003

- •6В школьная тревожность 20.11.2002

- •Группа из 9а психологический климат 14.04.2003

- •Фактор 1 2 3 4 5 6 7 8 9 10 11 12 13 в целом

- •Вопросы для размышления

- •Глава 4. Результаты мониторинга в школе

- •4.1. Оценка качества образовательной деятельности школ

- •Вопросы для размышления

- •4.2. Оценка качества образования ученика

- •Вопросы для размышления

- •4.3. Оценка качества образования класса

- •Вопросы для размышления

- •4.4. Оценка результатов образовательной деятельности учителя

- •Вопросы для размышления

- •Заключение

- •Литература

- •Содержание

Вопросы для размышления

Используете ли Вы результаты Единого государственного экзамена при оценке качества образования в Вашей работе или из интереса? Знаете ли Вы – как обрабатываются результаты тестирования, как определяется балл выпускника?

Что, по Вашему мнению, лучше – использовать известные и проверенные методы диагностики или пользоваться новыми методами и постоянно их улучшать? Почему?

В чем, по Вашему мнению, достоинства и недостатки компьютерных технологий в оценке качества образования?

Можно ли, по Вашему мнению, обойтись при диагностике учебных достижений в школе без тестов? Почему?

Можно ли, по Вашему мнению, применять одинаковые методы оценки для лучших школ мегаполисов и малокомплектных сельских школ?

2.2. Диагностика школьных учебных достижений

Способность учащихся к деятельности определяется в школе их учебными достижениями: по предметам, в предметных областях и, наконец, их компетентностями. Решение вопроса об успешности очередного этапа школьного обучения принимается обычно учителем после оценивания результатов обучения. Для адекватной оценки результатов необходимы четко обозначенные цели каждого этапа образования, детально структурированное содержание результатов и, наконец, диагностические средства для оценки этих результатов. В современной российской школе после десятилетия независимого развития школьных образовательных программ перечисленные условия в большинстве случаев не соблюдаются даже для таких этапов, как учебный год. Отсутствие достаточно точно определенных целей, содержания и методов проверки результатов приводит к тому, что оценка учителя является скорее интуитивной и в большей мере отражает отношение учителя к ученику и его работе в школе, чем результаты этой работы.

Сегодня, когда на первое место выходит индивидуальное развитие учащегося в процессе образования, оценка достижений учащегося призвана прежде всего стимулировать развитие образовательного процесса, обеспечивая «самоорганизацию» школьников в процессе обучения посредством адекватной самооценки ими собственных учебных достижений. Такая оценка должна производиться по возможности объективно и дифференцированно – с учетом уровня развития каждого учащегося.

Известный специалист в области применения современных технологий в образовании В.П. Беспалько подчеркивает необходимость точного обозначения «диагностичных целей обучения», имея в виду, прежде всего, возможность оценки результатов образовательного процесса, так как, по его мнению, “…отсутствие диагностичных целей обучения и субъективный контроль качества знаний учащихся не требуют от учителя каких-либо поисков путей совершенствования дидактического процесса”, “превращает все … меры” по улучшению этого процесса в пустые формальности, которые практически не воздействуют на сложившийся в опыте учителя процесс обучения”.

Сегодня российское образование активно интегрируется в мировую образовательную систему. С начала 90-х годов Россия принимает большое участие в международных исследованиях достижений в области образования. В отчетах Центра оценки качества образования ИОСО РАО приведены выводы специалистов по математике и естествознанию, анализировавших результаты тестирования 1995 и 1999 гг. по математике: «Оценка выполнения математической части теста по видам деятельности показала, что наши учащиеся имеют более высокие результаты в применении известных алгоритмов и процедур, результаты явно ниже при проверке понимания содержательного смысла математических понятий и при решении задач. В сравнении с другими странами явно ниже результаты выполнения заданий, связанных с анализом информации, представленной в различной форме (таблиц, диаграмм, графиков), характерной для средств массовой информации». Большинство сравнительных исследований последних лет сопровождалось аналогичными выводами. Эти результаты не являются столь уж неожиданными, так как наша школа в массе своей использует, согласно характеристике И.Я. Лернера, два дидактических метода: «информационно-рецептивный и репродуктивный». «Оба эти метода были и остаются» для большинства учителей «самыми экономными и целесообразными».

Принимая в целом указанные результаты, нельзя не отметить, что содержание и методика тестирования, в течение многих лет применявшиеся в мире, оказались относительно новыми для России. Кроме того, как уже отмечалось выше, внешние обстоятельства часто оказывают на школу большее влияние, чем сама школа. Этот факт был подтвержден также в рамках международных исследований. Ни в одном международном исследовании не выделено ни одного фактора, связанного с содержанием образования или методикой обучения, который бы оказывал одинаковое влияние на результаты обучения во всех странах. Наоборот, итоги анализа убедительно свидетельствуют о том, что социально-экономические условия и культурные традиции стран могут оказывать более сильное влияние на результаты обучения, чем целенаправленная деятельность школы. Система образования в каждой стране является уникальной по характеру взаимодействия различных факторов, поэтому одновременно с адаптацией образовательного процесса к мировым требованиям российскому образованию необходимо искать собственные способы повышения его качества, уровня результатов.

С учетом отсутствия практического опыта формирования у учащихся предметных и межпредметных компетентностей вряд ли имеет смысл сегодня серьезно говорить об оценке их уровня в России. Для обеспечения достаточной общности результатов целесообразно ограничиться поэтому в части учебных достижений привычной оценкой знаний, умений и навыков учащихся по основным предметам базисного учебного плана.

Для диагностики учебных достижений учащихся при оценке качества школьного образования, необходимо обеспечить объективность результатов и их адекватность действительному состоянию дел в школе. Массовое применение методов оценки требует наличия четкого и понятного их описания, развитой постоянной системы обучения использованию этих методов, строгого контроля за правильностью проведения обследования, пресечения возможных нарушений.

Объективная оценка учебных достижений наболее «технологично» – просто и валидно, обеспечивается с помощью тестовых заданий закрытого типа: с множественным выбором правильных ответов из предлагаемых, установлением соответствия, с кратким открытым ответом. Результат диагностики учебных достижений такими заданиями получается в виде доли (процента) правильно выполненных заданий из числа предложенных.

Хорошо известна работа с такими заданиями Федерального Центра тестирования. Стал повседневной практикой Единый государственный экзамен [5]. Активно развивается Итоговая государственная аттестация учащихся 9-х классов.

Большая работа ведется и на уровне регионов. В Москве тестирование по таким заданиям много лет проводит лаборатория аттестационных технологий Института открытого образования. В петербургских школах подобные задания хорошо известны по многолетней работе лаборатории под руководством А.Н. Майорова [22], технологии КАС ДОУ “Аттестация” С.В. Климина, аттестационному обследованию школ по «петербургской» технологии обследования.

Адекватность оценки учебных достижений в значительной мере определяется содержанием тестовых заданий по предметам, их подбором при формировании тестовых тетрадей для обследования. Задания должны соответствовать наиболее важным элементам содержания образования за проверяемый его этап. Важно, что речь идет не столько о содержании излагаемого учителем содержания предмета, сколько о содержании результатов образования: сформированных у учащихся «способностей к деятельности» и «психических функций». Следовательно, необходимо в первую очередь создать структуру таких элементов по всем проверяемым предметам, а затем – обеспечить каждый из этих элементов соответствующими заданиями. Адекватность оценки обеспечивается лишь при наличии для всех контролируемых элементов содержания образования достаточного числа заданий.

Для оценки учебных достижений по основным предметам школьной программы с более чем 500-1000 элементами содержания по каждому, необходим структурированный банк с десятками тысяч тестовых заданий. Однако создать такой банк заданий в короткое время и апробировать все задания с целью их сертификации до начала обследования в существующих сегодня в России условиях практически невозможно.

В Санкт-Петербурге, например, в первые годы регулярного проведения тестирования набор заданий менялся каждое полугодие. Обследования в течение первых трех полугодий были проведены на заданиях разработчиков технологии КАС ДОУ «Аттестация» под руководством С.В. Климина, а к каждому следующему – разрабатывались заново методистами и специалистами Санкт-Петербургского государственного Университета педагогического мастерства: П.А. Барановым, Д.Н. Муриным, Степановой Г.Н. и др. В короткие сроки они предоставили большое число заданий для тестирования по всему кругу выбранных предметов. При этом структура тем, выбор тех или иных тем для тестирования, распределение заданий по темам и другие особенности разрабатываемых заданий практически не обсуждались. Формирование тестовых тетрадей – совокупностей заданий по вариантам, для обследования производилось чисто формально. Сложность заданий и их пригодность для целей дифференцированной оценки учебных достижений практически не проверялись, а результаты отдельных проверок не использовались. После 2000 года достаточно ограниченный набор заданий – по несколько десятков заданий для каждого предмета, долгое время практически не обновлялся. По одним и тем же заданиям были проверены тысячи учеников в течение двух лет. Да и сегодня положение изменилось не сильно, что существенно снижает доверие к результатам оценки.

Рассмотрим в качестве примера опыт применения тестовых заданий при обследовании в Санкт-Петербурге.

Количество заданий в тесте существенно менялось в зависимости от предмета и ступени школы. Для всех предметов начальной школы и таких предметов в старших классах, как математика или физика, число заданий в тесте было 5-7, только по иностранным языкам число заданий в тесте доходило до 20 и более. Малое число заданий в тестах (менее 10) и низкий уровень их сложности не позволяет, как показал опыт, правильно осуществлять дифференцированную оценку учебных достижений по предметам.

Дифференцированная оценка школьных достижений происходит оптимальным образом, если наибольшая часть обследованных показывает результат, близкий к среднему (20..80%), а доля обследованных с очень высокими (80..100%) и очень низкими (0..20%) результатами невелика. При таком распределении результатов удается разделить группы учащихся с разными уровнями учебных достижений: близким к норме (среднему) – «удовлетворительным» или «хорошим», значительно превышающим норму – «отличным», и значительно ниже нормы – «неудовлетворительным».

Если тесты слишком просты, то большинство обследуемых выполняет почти все правильно, получает одинаково высокий результат и затруднительно выделить из них лучших и худших. Наоборот, если тесты слишком сложны, то почти все показывают одинаково низкие результаты, а выделить лучших и худших оказывается так же трудно

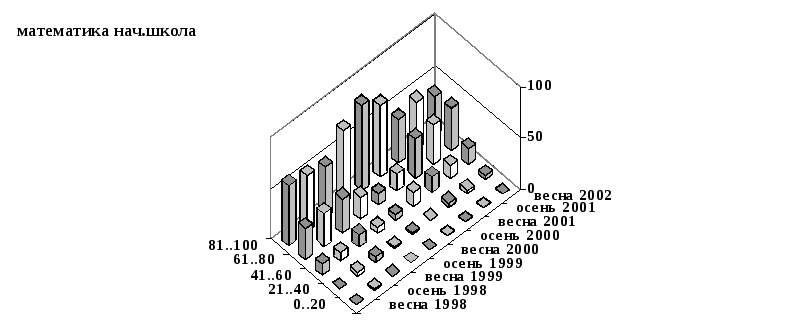

Д иаграмма

рис.1 иллюстрирует результаты обследования

по чтению в начальной школе.

иаграмма

рис.1 иллюстрирует результаты обследования

по чтению в начальной школе.

Рис. 1. Распределение результатов тестирования по чтению

В каждый из периодов в обследовании участвовало от 100 до 1000 учащихся школ Санкт-Петербурга. В виде «столбиков» на диаграмме показана для каждого набора тестов (указанного справа периода обследования) доля обследованных, показавших при тестировании результат (процент правильно выполненных заданий) из указанного слева диапазона.

К ак

видно из этой диаграммы, указанное выше

требование достаточно хорошо

удовлетворяется при использовании

тестов КАС ДОУ «Аттестация» (первые три

периода проведения обследований на

диаграмме), но и они не идеальны –

распределение смещено в сторону высоких

результатов. «Петербургские» тесты

следующих трех периодов обследований

оказались чересчур просты – доля очень

высоких результатов чрезмерно велика.

Задания последних трех периодов

обследования, разработанные в 2000 году,

оказались даже несколько лучше по своим

статистическим параметрам, чем в тестах

КАС ДОУ «Аттестация».

ак

видно из этой диаграммы, указанное выше

требование достаточно хорошо

удовлетворяется при использовании

тестов КАС ДОУ «Аттестация» (первые три

периода проведения обследований на

диаграмме), но и они не идеальны –

распределение смещено в сторону высоких

результатов. «Петербургские» тесты

следующих трех периодов обследований

оказались чересчур просты – доля очень

высоких результатов чрезмерно велика.

Задания последних трех периодов

обследования, разработанные в 2000 году,

оказались даже несколько лучше по своим

статистическим параметрам, чем в тестах

КАС ДОУ «Аттестация».

Рис. 2. Распределение результатов тестирования по математике

Подобный результат является естественным следствием неправильного выбора норм при использовании в Санкт-Петербурге КАС ДОУ «Аттестация». Нормы устанавливались не по статистическим характеристикам результатов тестирования, а задавались случайно выбранными и не слишком компетентными экспертами без учета содержания заданий и условий тестирования. В результате возникло и распространилось представление о чрезмерной сложности «московских» тестов для петербургских школьников, побудившее разработчиков из Санкт-Петербургского государственного Университета педагогического мастерства к упрощению заданий. Анализ результатов применения этих заданий и приобретенный опыт позволили заметно улучшить задания в 2000 году.

Аналогично построена диаграмма рис.2 для результатов тестирования по математике в начальной школе. Как видно из этой диаграммы, указанное выше требование одинаково плохо удовлетворялось и при использовании тестов КАС ДОУ «Аттестация» (первые три периода проведения обследований на диаграмме), и при «петербургских» тестах (следующие периоды проведения обследований на диаграмме). Все эти тесты чересчур просты – доля очень высоких результатов чрезмерно велика. Это свидетельствует о недооценке учебных достижений младших школьников по математике и малой пригодности всех этих тестов для целей обследования – оценки «нормальных», лучших и худших.

Аттестационные обследования проводились с выпускниками ступеней общеобразовательной школы: начальной, основной и средней, поэтому тесты имели характер итоговых. Они включали в себя те темы и задания, которые разработчики заданий считали наиболее существенными для результатов обучения по предметам на данной ступени. Структура тем и распределение учебного материала по четвертям, триместрам, полугодиям, классам при составлении «петербургских» тестов практически не принимались во внимание. Если задание относилось к теме, еще не изученной в школе, оно просто исключалось из теста.

При диагностике учебных достижений по итогам ступени школы можно пользоваться достаточно обобщенной структурой тем предметных тестов. Правда, и в этом случае следовало бы проводить научно-педагогическое обоснование выбора тем заданий, но его отсутствие не является непреодолимым препятствием для проведения тестирования. Например, в Санкт-Петербурге даже на крайне ограниченном количестве тестовых заданий по предметам (1500..2000) удалось провести обследование нескольких сотен школ.

Конечно, качество обследования, а, значит, достоверность его результатов и выводов по ним от этого не повысились. Так, при отборе заданий для оценки уровня учебных достижений выпускников основной школы (за 5-9 классы) материал 5..6 классов почти не используется. Во многом это справедливо и для оценки образования в начальной школе. Несколько лучше обстоит дело с подбором тем заданий для выпускников средней школы (за 10-11 классы).

При организации текущего контроля учебных достижений по предметам с дискретностью до месяца, четверти или триместра первоочередной задачей является создание структурированного по «темам» и «подтемам» банка тестовых заданий по предметам.

Сам подбор заданий для организации тестовой оценки учебных достижений не представляет сегодня почти никакой сложности. Обилие подобных заданий во всевозможных публикациях почти всегда позволяет выбрать из этой массы достаточное количество заданий необходимой формы на выбранную тему.

При аттестационном обследовании школ использовались исключительно задания с множественным выбором ответов из предложенных, атрибуция таких заданий (описание, в том числе – перечисление номеров правильных ответов на вопрос) предусматривала один или несколько правильных ответов. При этом задание считалось выполненным, если порядковые номера всех ответов обследуемого находились среди правильных – среди них не было ни одного номера неправильного ответа. Такой алгоритм допускал указание не всехправильных ответов. Для заданий с небольшим числом правильных ответов:

Вопрос: Подчеркни слова, где букв больше, чем звуков.

Варианты ответа:

1. пеньки 2. ёжик 3. червяк 4. гусак 5. дикарь

6. печка 7. учит 8. яма 9. пальчик

этот алгоритм подходит – 1, 5 и 9-й ответы правильны, их немного, любой из остальных, будучи назван как правильный, сделает задание невыполненным.

Возможности проверки уровня учебных достижений по предметам значительно расширяет использование заданий других видов. Весьма эффективны, в частности, широко распространенные в гуманитарных предметах задания «на соответствие».

Для таких заданий:

Вопрос: Установите соответствие между группами А и Б:

|

|

А |

|

Б |

|

1.) |

Содом и Гоморра. |

1.) |

Предательский поступок. |

|

2.) |

Продать за чечевичную похлебку. |

2.) |

Нежелание взять на себя ответственность за что-либо. |

|

3.) |

Терновый венец. |

3.) |

Приобретать знания, постигать смысл разнообразных явлений. |

|

4.) |

Каинова печать. |

4.) |

Громкий, грубый голос. |

|

5.) |

Умывать руки. |

5.) |

Строгие меры, применяемые по отношению к кому-либо вообще. |

|

6.) |

Иудин поцелуй. |

6.) |

Клеймо преступника. |

|

7.) |

Труба иерихонская. |

7.) |

Символ страдания. |

|

8.) |

Тридцать серебренников. |

8.) |

Крайний беспорядок, шум, суматоха. |

|

|

|

9.) |

Цена предательства. |

|

|

|

10.) |

Поступиться чем-либо значительным ради ничтожной выгоды. |

Варианты ответа: Перечислите соответствия парами, например: 1-3 (т.е. пункту 1 из группы А соответствует пункт 3 из группы Б), 2-1, и т.д.

описанный выше алгоритм не годится – большое число правильных ответов (1-8, 2-10, 3-7, 4-6, 5-2, 6-1, 7-4, 8-9) из 80 возможных сочетаний делает, как показала практика, практически невозможным указание всех правильных ответов. Не случайно подобные задания выделены при проведении Единого Государственного экзамена в отдельную группу повышенной сложности. При текущем контроле, когда такие задания даются учащимся наравне с другими (базовыми), можно ввести допустимый процент от общего числа правильных ответов, например – 50%, если общее число правильных ответов больше 3-4-х.

Как видно из перечня правильных ответов на такие задания, при их описании и обработке результатов тестирования удобнее использовать не числовой, а текстовый формат представления ответов.

Возможность указания допустимого процента правильных ответов целесообразно использовать и для заданий с выбором ответов из предложенных, если число правилных ответов более 5-6-и. Для тех же заданий, где требуется указать все правильные ответы, например:

Вопрос: Укажите предложения, где придаточное стоит в середине сложноподчиненного:

Варианты ответа:

1. Впервые я услышал как шелестит лист падающий с дерева.

2. Нынче в пять часов утра когда я открыл глаза в окно моей комнаты повеяло запахом цветов.

3. Должно быть каждый из нас подумал о лесных ручьях которые бегут под буреломом о мерцающих звездах.

4. Слышно было как мать звенела стаканами разливая чай.

единственно допустимым будет процент указанных обследуемым правильных ответов 100%.

Использование представления правильных ответов в текстовом (а не цифровом, т.е. численном) виде, позволяет без изменения алгоритма автоматизированнойобработки включить в банк задания с открытым кратким текстовым ответом, например – географическое название или однозначно записываемое имя. Подобные задания гораздо сложнее и намного эффективнее при проверке учебных достижений, чем задания с выбором ответа из предложенных вариантов или на установление соответствия. При проведении Единого Государственного экзамена такие задания относятся к группе наиболее сложных.

Важно, что при определении правильности выполнения заданий описанных видов не используется экспертная оценка. Это значительно повышает «технологичность» (простоту) и объективность оценки такими заданиями уровня учебных достижений по предметам.

Наиболее трудоемкой частью этой работы при создании банка заданий является структурирование этого банка в соответствии со структурой проверяемых результатов обучения. В этом случае структура тем по каждому предмету должна быть весьма детальной, чтобы иметь возможность проверить результаты достаточно ограниченного этапа обучения.

При подборе заданий учитель ориентируется по привычке на тематику учебного материала, соответствующую этапу обучения, по итогам которого оценивается учебные достижения. Такой подход, как справедливо отмечается в работе Шишова С.Е. и Кальней В.А. «Школа: мониторинг качества образования» [41], соответствует методике преподавания и практике работы учителя. Именно этот материал учитель рассказывал, объяснял и закреплял.

Однако уже в процессе формирования с помощью учителей первых вариантов тестов – наборов заданий на выбранные темы, выяснилось, что, как это справедливо отмечается многими, оцениваться должно достижение цели обучения, а не действия учителя на уроках. Стала очевидной необходимость структурирования проверочного материала (тем заданий) по элементам содержания результатов обучения, а не содержания учебного материала. При этом формируемая самими учителями структура тем стала гораздо более детальной: появились «подтемы», учитывающие необходимость выделения при контроле учебных достижений различных аспектов рассматриваемых тем учебного материала.

Формирование банка тестовых заданий, таким образом, имеет своим результатом не только создание и развитие самого банка, но и, что не менее важно, существенное повышение качества работы учителя. Учитель начинает формулировать и осознавать, согласно упомянутой ранее формулировке Э.Н. Гусинского, «свои цели», точнее ощущать согласно выражению Кеннета-Комоски «свое дидактическое пространство».

При относительно малой «насыщенности» содержания учебной программы структура тем достаточно проста и формируется легко. В качестве примера можно привести сложившийся описанным путем перечень тем по природоведению для 2-го класса:

сезонные изменения\весна\животные

сезонные изменения\весна\календарь

сезонные изменения\весна\птицы

сезонные изменения\весна\растения

сезонные изменения\весна\явления природы

сезонные изменения\зима\животные

сезонные изменения\зима\календарь

сезонные изменения\зима\птицы

сезонные изменения\зима\растения

сезонные изменения\зима\труд людей

сезонные изменения\зима\явления природы

сезонные изменения\лето\календарь

сезонные изменения\лето\растения

сезонные изменения\лето\явления природы

сезонные изменения\осень\грибы

сезонные изменения\осень\животные

сезонные изменения\осень\календарь

сезонные изменения\осень\птицы

сезонные изменения\осень\растения

сезонные изменения\осень\труд людей

сезонные изменения\осень\явления природы

температура\термометр

температура\изменение

температура\теплее

температура\холоднее.

Здесь в каждой строке указана подтема, которая, в свою очередь, может являться частью другой – более крупной, подтемы или темы. Темы и подтемы в строке перечислены в порядке уменьшения общности и отделяются знаком «бэкслэш» – \. Такое описание позволяет построить сколь угодно «разветвленное» «дерево» тем. Имея для любого контролируемого этапа обучения не менее 4-5 тем, каждая из которых «обеспечена» несколькими равноценными заданиями, можно сформировать для выбранных тем тестовые тетради (группы заданий), позволяющие детально проверить усвоение материала.

Из рассмотренных примеров результатов тестовой оценки учебных достижений в школах Санкт-Петербурга становится очевидным, что результат применения закрытого теста в виде процента правильно выполненных заданий существенно зависит от содержания теста: количества и сложности заданий, времени и условий его использования и т.д. Сопоставлять результаты подобной оценки, полученной в различных условиях: для разных предметов, времени тестирования, трудности тестов и т.п., некорректно. В то же время подобную задачу часто необходимо решать при массовой оценке учебных достижений. Примером могут служить аттестационное обследование школ, проведение Единого Государственного экзамена и т.п. случаи.

Задача оценки качества образования путем мониторинга учебных достижений в регионе предъявляет особые требования к системе оценки. Даже при самой современной технологии и неограниченных ресурсах трудно обеспечить одновременность обследования из-за различия в условиях работы школ и необходимости учета особенностей организации учебного процесса: периодов итоговых работ, школьных каникул, массовых мероприятий и т.п. Смещение сроков проведения обследования (например, с первого на второе полугодие учебного года) означает необходимость существенной корректировки содержания тестов. Такая корректировка, как и неизбежное обновление банка заданий, изменяет сложность тестов и ставит в неравные условия школы, проходящие обследование в разное время или на разных тестах. В связи со значительной протяженностью во времени процесса оценки качества образования в школах региона особенно актуальной является проблема сопоставления результатов, полученных в разное время, на разных тестах, в разных организационных условиях. Основная задача при этом – обеспечить корректное сравнение результатов без привлечения субъективных экспертных оценок, например – оценки учителями сложности тестов и соответствующей корректировки результатов.

Выход из этого положения предоставляет рейтинговая оценка каждого результата в виде доли (процента) худших, чем оцениваемый, результатов из числа полученных при полностью аналогичных условиях: на том же или равном по сложности наборе тестов, в то же время и т.д. Можно предположить, что общий уровень рассматриваемого свойства образования (например, учебных достижений по истории в 5-х классах) не меняется существенно на протяжении 2-3-х лет. С учетом этого при одновременном обследовании достаточно представительной выборки учащихся школ разного уровня рейтинг результата среди полученных в то же время на том же наборе тестов (например – по математике в 5-ом классе) можно считать относящимся ко всей группе аналогичных, но полученных в другие периоды обследования (на протяжении 2-3-х лет) и на других тестах – другой тематики, более сложных или менее сложных.

Главные допущения при использовании рейтинговой оценки качества школьного образования:

стабильность (неизменность) оцениваемых показателей качества образования на протяжении 2-3-х лет;

представительность выборки обследуемых школ, классов, учащихся для целей обследования, обеспечивающая стабильность указанных показателей не только для системы образования в целом, но и для совокупности прошедших обследование школ.

Если количество результатов достаточно велико и они достаточно разнообразны, то можно воспользоваться широко применяемым в статистике приемом отнесения результата к одному из нескольких диапазонов, соотнеся, например, каждый из них с «школьной» отметкой 2, 3, 4 или 5. Необходимо отметить, что определение границ диапазонов, а, следовательно, и значения «тестовой отметки» является в значительной степени волюнтаристским актом. При этом особенно важным представляется соблюдение единства, простоты и «прозрачности» алгоритма оценки.

Как следует из описанного алгоритма получения «тестовых отметок», их использование при оценке учебных достижений непосредственно связано с понятиями «нормы» оценки и «стандарта» учебных достижений.

Существенным достоинством представления результатов тестирования «тестовыми отметками» является привычный вид результата, возможность сравнения результатов, полученных на очень разных по содержанию наборах тестовых заданий, в том числе – по разным предметам, между собой и с полученными другими способами – например, со школьными отметками. Необходимо лишь, чтобы база оценки – совокупность всех результатов, по которым определяются процентные соотношения и рейтинг, использованная для получения этих результатов, была достаточно представительна и адекватна «нормальному» множеству результатов.

Описанные способы рейтингового представления результатов тестирования позволяют непрерывно поддерживать «эталон» нормы учебных достижений по предметам и, одновременно, проверять с помощью экспертной оценки содержания тестов соответствие «эталона» стандартам образования и реальному положению дел.

При контроле учебных достижений в отдельных школах возникла проблема оценки результатов тестирования отдельного ученика по уникальному, не предлагавшемуся никому, кроме него, тесту. Для решения такой задачи был разработан специальный метод (алгоритм) обработки.

Перед началом обработки результатов тестирования определяются статистические характеристики всех используемых заданий, в том числе – процент выполнения (или невыполнения) задания учащимися разных классов.

Кроме используемого обычно процента правильно выполненных заданий в тесте теперь можно получить «взвешенный» процент выполнения теста, где вклад каждого задания зависит от его сложности. Сложность задания определяется как процент «невыполнения» этого задания учащимися такого же класса, что и обследуемый школьник. В результате «взвешенный» процент выполнения теста будет выше «обычного», если среди правильно выполненных школьником заданий превалируют те, на которые не смогли ответить его сверстники, и ниже «обычного», если он правильно ответил только на те вопросы, что и большинство других. Таким образом, «взвешенный» процент выполнения теста позволяет учесть различие в сложности отдельных заданий теста.

Для получения рейтинговой оценки можно использовать следующий алгоритм. Каждое задание теста имеет свою сложность, показателем которой является процент «невыполнения» задания. Для получения рейтинга результата расположим все задания теста в порядке возрастания сложности, то есть увеличения процента не выполнивших задание. Если предположить, что тестируемые школьники, как правило, сначала чаще всего выполняют более «легкие» задания, то рейтинг результата в персентилях можно считать равным проценту «невыполнения» задания из этой последовательности с номером, пропорциональным «взвешенному» проценту выполнения теста.

Результат применения описанного подхода к оценке иллюстрирует диаграмма рис.3.

Р ис.3.Результат применения

«весовых» коэффициентов для закрытых

тестов

ис.3.Результат применения

«весовых» коэффициентов для закрытых

тестов

Два ученика выполняли варианты теста по английскому языку из 12 заданий. На диаграмме для каждого из 12 заданий обоих вариантов (для обоих учеников) показаны: результат выполнения (1 – правильно, 0 – неправильно), значения весовых коэффициентов, равные проценту невыполнения задания всеми когда-либо обследованными по ним учениками, для каждого задания (светлые столбики) и в порядке возрастания (темные столбики), а также изменение процента выполнения теста с изменением числа выполненных заданий от 1 до 12 (крайний правый ряд).Хотя оба теста были сформированы путем выбора заданий из групп, в которых содержались однотипные задания с высокой внешней и низкой внутренней валидностью, сложность вариантов оказалась весьма различной. 1-ый вариант явно сложнее 2-го – среди его весовых коэффициентов почти все больше 50%, а у 2-го – только половина.

Несмотря на это, 1-ый ученик выполнил правильно больший процент заданий теста, чем 2-ой. При этом он не справился с самыми сложными заданиями (3,8,11 на диаграмме), поэтому его результат по «взвешенному» проценту выполнения (45%) оказался ниже, чем по «обычному» (58%). В то же время 2-ой ученик выполнил правильно большинство наиболее сложных заданий своего теста и его «взвешенный» процент выполнения (45%) оказался выше «обычного» (42%). Применение «взвешенного» процента выполнения теста позволило учесть разницу в объективной сложности заданий в каждом из вариантов.

Равенство результатов обоих учеников по «взвешенному» проценту выполнения достигнуто без учета различной сложности вариантов теста. Учесть ее позволяет следующий этап оценки. 45% выполнения теста из 12 заданий соответствует примерно (с округлением до целого) 5-и правильно выполненным заданиям (крайний правый ряд на диаграмме рис.3). Для 1-го ученика пятое по сложности задание (см. диаграмму рис.3) дает 40% не справившихся и, следовательно, «худших», чем 1-ый ученик. Его «рейтинг среди всех» – 40%. Для 2-го ученика с гораздо более простым тестом пятое по сложности задание (см. диаграмму рис.3) дает всего 20% не справившихся. Его «рейтинг среди всех» – 20%. В результате среди двух учеников с одинаковым «взвешенным» процентом выполнения вдвое более высоким рейтингом обладает тот, кто выполнял более сложный тест.

Предложенный алгоритм позволяет оценить выполнение теста с учетом сложности как всего теста, так и отдельных заданий, с получением результата в виде «рейтинга среди всех», независимо от числа выполнявших тест. Если задания из теста применялись в течение нескольких лет в Санкт-Петербурге, то это будет рейтинг результата ученика в Санкт-Петербурге. Необходимо отметить, что большинство заданий правильно выполняло 40…60% всех тестировавшихся, поэтому «рейтинг среди всех» в 50…60% по описанному алгоритму является достаточно высоким – близким к максимальному, результатом. Чтобы получить рейтинг среди всех в 100% необходимо выполнить все задания теста, в котором обязательно должно быть хотя бы одно, не выполненное до сих пор правильно никем.