- •2.Косвенный переход

- •Дескрипторы

- •Основные характеристики тестов

- •Надёжность тестирования –

- •Однородное ранжирование

- •Ранжирование по методу Хаффмана

- •Формы представления чисел

- •Представление чисел с учетом знака

- •4.1. Сложение с плавающей точкой

- •4.2. Умножение мантисс чисел с плавающей точкой

- •Сложение чисел

- •Система команд

- •Интегральный таймер

- •Программируемый адаптер последовательного интерфейса

- •Схемы управления и защиты памяти

- •Разрядность обрабатываемых данных - 8; 16; 32

- •Разрядность обрабатываемых данных - 8; 16; 32

- •80486Dx – 32 разрядный процессор 80486 с встроенным сопроцессором

- •80486Sx -- 32 разрядный процессор 80486 без сопроцессора

- •80486Dx2 – частота cpu увеличена в 2 раза по сравнению с шиной.

- •80486Dx4 -- частота cpu увеличена в 2,5 (3) раза по сравнению с шиной.

- •Для увеличения объёма convention memory осуществляют перемещение dos, резидентных программ и драйверов в расширенную память.

- •Существуют две системы нумерации секторов на диске:

- •Pause [сообщение] -- приостановка выполнения bat-файла и выдача сообщения

- •73. Управление дисками и каталогами в ms-dos.

- •Триггеры с управлением по фронту

- •Приведена схема мультиплексора 4 в 1

- •После заполнения таблицы можно перейти к синтезу комбинационной схемы r- го вычислителя I – го разряда регистра.

- •2.1.2. Комбинаторная мера.

- •2.1.3. Аддитивная мера Хартли.

- •2.2.3. Условная энтропия.

- •2.2.4. Энтропия и информация.

- •3.2. Выбор частоты отсчётов при дискретизации.

- •3.3. Квантование по уровню.

- •Теорема 1

- •Теорема 2

- •4.4. Оптимальное кодирование.

- •Например: Дан восьмибуквенный первичный алфавит, известны безусловные вероятности для символов первичного алфавита.

- •4.6.2. Циклические коды.

- •1. Семантический разрыв между архитектурой эвм и уровнем решаемых задач

- •1.1. Физическая и виртуальная эвм

- •1.2. Семантический разрыв между физической и виртуальной эвм

- •1.3. Уменьшение семантического разрыва

- •1.4. Векторная обработка данных

- •2. Основы горизонтальной и вертикальной обработки информации

- •2.1. Характеристика горизонтальной и вертикальной технологий

- •2.2. Вертикальные операции и устройства

- •2.2.1. Операция вертикального сложения.

- •2.2.2. Операция деления количества единиц.

- •2.2.3. Операция упорядочения единиц.

- •2.2.4. Примеры выполнения вертикальных операций.

- •3. Использование матричного параллелизма в архитектуре эвм

- •3.1. Матричный параллелизм на системном уровне

- •3.1.1. Однородные матричные процессоры.

- •3.1.2. Периферийные матричные процессоры.

- •3.2. Матричный параллелизм на схемном уровне

- •3.2.1. Параллельные сдвигатели.

- •3.2.2. Параллельные сумматоры.

- •3.2.3. Матричные умножители

- •3.2.4. Матричные делители.

- •№114 Матричные системы

- •№117 Многомашинные системы

- •№121 Стандарт скоростной оптической магистрали fddi.

- •152. Принцип управления по хранимой микропрограмме. Операционно-адресная структура микрокоманды.

- •Основная задача свв – организация обменом информации между оп эвм и пу.

- •К основным функциям свв относят следующие:

- •166. Формирование речевых сообщений по правилам и по образцам. Способы сжатия информации в устройствах ввода-вывода речевых сообщений.

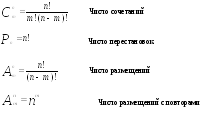

2.1.2. Комбинаторная мера.

В рамках данного подхода количество информации измеряется как количество комбинаций элементов информационных систем

Здесь производится не подсчёт квантов, а определение возможных или действительных комбинаций, т.е. оценка структурного разнообразия.

2.1.3. Аддитивная мера Хартли.

Рассмотрим L - разрядное число в произвольной системе счисления с основанием h.

Глубина числа (h) - количество элементов (символов) алфавита (основание системы счисления). Длина числа (L) - количество позиций (разрядов). Следовательно, всего можно представить различных состояний: Q=h L

где Q - информационная ёмкость.

Величина Q носит экспоненциальный характер. Поэтому на практике была введена аддитивная логарифмическая двоичная мера , которая получила название – мера Хартли: I=log2Q=log2hL=L*log2h

Это выражение можно применять в случае, если каждому разряду L доступно каждое состояние из h.

При l =1,h=2: I=1* log 22 =1[бит] I=log2 Q=log1010=1[дum]

2.2. Статистическая мера информации.

Информация - сообщение об исходе случайных событий, и в рамках статистического подхода количество информации ставится в зависимость от априорных вероятностей этих событий.

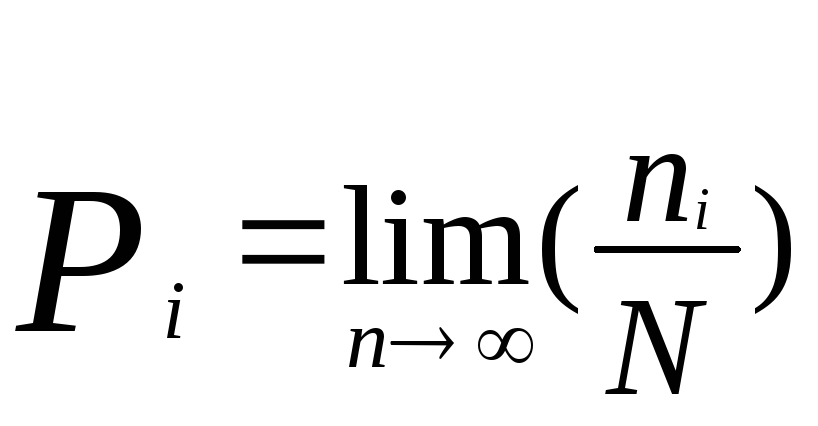

Случайное событие - событие, которое может произойти или не произойти в результате данного опыта. Если при N-кратном повторении какого-либо опыта относительное число появления 1-го события по мере увеличения общего числа реализации опыта N стремится к некоторому пределу то говорят, что результат данного опыта статистически устойчив. Число Рi, позволяющее при этом количественно сравнить события по степени их возможности, называется вероятностью события.

Чем более определённым является событие, тем меньше информации оно несёт. Чем менее определённым является событие, тем больше информации оно несёт.

P=1- вероятность достоверного события;

P =0-

вероятность невозможного

события;

=0-

вероятность невозможного

события;

Понятие энтропии.

Количество информации рассматривается как функция от вероятности появления случайных событий:

I=F(Pi)=F(ni /N)

Известно, что logQ=-log(1/Q), и следовательно с учётом (I=log2Q=log2hL=L*log2h)

Ii=-logPi

Р![]() ассмотрим

полную группу событий. Для неё имеет

место:

ассмотрим

полную группу событий. Для неё имеет

место:

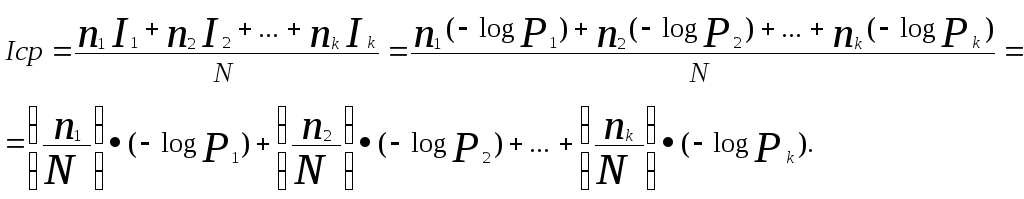

Пусть N - всего

возможных исходов, из них k

-разных; i

- исход (i =![]() )

повторяется

ni

раз и вносит

информацию Ii,.

Тогда среднее количество информации,

доставляемое одним опытом:

)

повторяется

ni

раз и вносит

информацию Ii,.

Тогда среднее количество информации,

доставляемое одним опытом:

Тогда, с учётом предельного перехода, получим:

![]()

Эта величина называется энтропией и обозначается:

![]()

Энтропия это среднее значение неопределённости отдельных исходов. С точки зрения математики энтропия

H=M[-logPi]

где М - математическое ожидание.

№99. Свойства безусловной энтропии.

2.2.2. Свойства энтропии.

1. Энтропия всегда неотрицательна, H>=0. H=0, если события полностью определены, т.е. при P1=1, P2,3…=0.

2. При заданном к Hmax=logk, только при P1=P2=...= Pk =1/k; (сумма Pi=1).

![]()

В этом случае энтропия Н совпадает с мерой Хартли I, что свидетельствует о полном использовании информационной емкости системы (при равновероятных событиях).

3. Значение функции энтропии H(P1...Pk) не меняется при любой перестановке вероятностей Pi. Т.е. энтропия не учитывает смысл событий.

4. Функция энтропии H(P1...Pk) непрерывна.

5. Функция энтропии удовлетворяет следующему равенству: H(P1…Pk)=H(P1+P2,P3..Pk)+(P1+P2)*H(P1/(P1+P2);P2/(P1+P2));

Свойство 5 во многом связано со свойством 2.

6. Функция энтропии возрастает с увеличением числа к.

7. Если две системы А и В независимы, тоН(АВ)=Н(А)+Н(В)

(Пример задача) Условие.

Рассматриваются два различных медицинских исследования для диагностики одного и того же заболевания. Первое исследование даёт правильное заключение о состоянии пациента с вероятностью 0,5;

второе - с вероятностью 0,8. Определить, какое медицинское исследование обладает большей неопределённостью.

Для исследования А:

|

Заключение |

Правильное |

Неправиль ное |

|

Вероятность |

0,5 |

0,5 |

Для исследования В:

|

Заключение |

Правильное |

Неправиль ное |

|

Вероятность |

0,8 |

0,2 |

Решение.

Ha=-PnlogPn-PmlogPm=-2*0,5*log0,5=1[бит]

Hb=-PnlogPn-PmlogPm=-0,8*log0,8-0,2log0,2=0,8[бит]

Выводы:

Чем ближе друг к другу значения вероятностей, тем больше величина энтропии, тем большей неопределённостью обладает данная система.

Величина энтропии никак не учитывает смысл событий.

№100. Условная энтропия. Свойства условной энтропии.