- •Поняття економетричної моделі, її складові частини.

- •Причини, які спонукають появу випадкової складової в регресійних моделях.

- •Етапи побудови економетричної моделі.

- •Параметри моделі парної лінійної регресії, їх сутність та оцінювання.

- •Закони розподілу ймовірностей емпіричних параметрів , їх числові характерстики та статистичні властивості.

- •Обчислення значень вибіркових дисперсій , , для парної регресії.

- •Коефіцієнт детермінації та кореляції для моделі парної регресії. Перевірка суттєвості коефіцієнта детермінації за допомогою t-критерію.

- •Коефіцієнт детермінації та кореляції для моделі парної регресії. Перевірка суттєвості коефіцієнта детермінації за допомогою f-критерію.

- •Перевірка суттєвості оцінок параметрів на основі t-критерію.

- •Точковий та інтервальний прогноз на основі побудованої моделі парної регресії.

- •Передумови застосування методу найменших квадратів.

- •Метод найменших квадратів (мнк). Система нормальних рівнянь.

- •Оператор оцінювання мнк в матричному вигляді.

- •Властивості оцінок параметрів, знайдених за мнк.

- •Дисперсійний аналіз моделі лінійної множинної регресії.

- •Коефіцієнт множинної кореляції та детермінації та перевірка їх статистичної значущості.

- •Дисперсійно-коваріаційна матриця оцінок параметрів.

- •Довірчі інтервали для оцінок параметрів.

- •Перевірка достовірності оцінок параметрів за допомогою t -критерію.

- •Точковий та інтервальний прогноз на основі побудованої моделі лінійної множинної регресії.

- •Перевірка загальної якості моделі та рівності двух коефіціентів детермінації.

- •Поняття фіктивних змінних.

- •Врахування якісних факторів в лінійних економетричних моделях за допомогою фіктивних змінних.

- •Моделі з фіктивними регресорами: моделі, що містять тільки фіктивні незалежні змінні та моделі, що містять як фіктивні, так і кількісні незалежні змінні.

- •Моделі з фіктивними залежними змінними.

- •Оцінювання параметрів моделі з фіктивними змінними.

- •Порівняння двох регресійних моделей. Тест Чоу.

- •Суть та наслідки мультиколінеарності.

- •Тестування наявності мультиколінеарності в моделі. Алгоритм Фаррара-Глобера.

- •Методи усунення мультиколінеарності.

- •Алгоритм покрокової регресії.

- •Поняття про гомо- та гетероскедастичність залишків.

- •Негативні наслідки наявності гетероскедастичності залишків в лінійних моделях.

- •Тест Гольдфельда-Квандта. Послідовність його виконання.

- •Алгоритм теста Глейсера.

- •Перевірка наявності гетероскедастичності залишків на основі теста коефіцієнта рангової кореляції Спірмена.

- •Узагальнений метод найменших квадратів для моделі з гетероскедастичністю залишків.

- •Зважений метод найменших квадратів.

- •Суть та наслідки автокореляції стохастичної складової.

- •Алгоритм Дарбіна-Уотсона для виявлення автокореляції залишків першого порядку.

- •Критерій фон Неймана.

- •Циклічний та нециклічний коефіцієнт автокореляції.

- •Узагальнений метод найменших квадратів для знаходження оцінок параметрів моделі з автокорельованими залишками.

- •Метод перетворення вихідної інформації.

- •Алгоритм методу Кочрена – Оркатта.

- •Оцінювання параметрів моделі з автокорельованими залишками методом Дарбіна.

- •Поняття часового лагу. Моделі з часовим лагом незалежних змінних.

- •Авторегресійні моделі.

- •Оцінювання авторегресійних моделей з часовим лагом незалежних змінних.

- •Часовий ряд в загальному вигляді. Поняття тренду, сезонної, циклічної та випадкової компоненти. Основні етапи аналізу числових рядів.

- •Метод ковзної середньої для згладжування часового ряду.

- •Експоненціальне згладжування.

- •Аналітичні методи згладжування часового ряду.

- •Довжина часового ряду суттєво перевищує ступінь полінома , а випадкові залишки мають властивості «білого шуму», тобто

- •Стаціонарні та нестаціонарні часові ряди. Основні характеристики часових рядів.

- •Тест Дікі-Фулера.

- •Авторегресійні моделі ( ar(p)- процеси).

- •Моделі ковзного середнього (ma(q)- процеси).

- •Авторегресійні моделі ковзного середнього ( arma(p,q)- процеси).

- •Інтегровані авторегресійні моделі ковзного середнього ( arima(p,d,q)- процеси).

- •Адаптивні моделі. Схема їх побудови.

- •Поняття про коінтеграцію часових рядів.

- •Моделі коригування помилки, етапи її побудови.

- •Поняття системи економетричних рівнянь. Приклади моделей на основі системи одночасних рівнянь.

- •Структурна та зведена форми системи рівнянь.

- •Ідентифікація. Необхідна і достатня умова ідентифікації.

- •Непрямий метод найменших квадратів оцінювання параметрів системи одночасних рівнянь.

- •Оцінювання параметрів системи одночасних рівнянь двохкроковим методом найменших квадратів.

- •Трьохкроковий метод найменших квадратів.

- •Прогноз ендогенних змінних

-

Суть та наслідки мультиколінеарності.

Мультиколінеарність — це існування тісної лінійної залежності, або сильної кореляції, між двома чи більше пояснювальними змінними.

Вона негативно впливає на кількісні характеристики економетричної моделі або робить її побудову взагалі неможливою.

Так, мультиколінеарність пояснювальних змінних призводить до зміщення оцінок параметрів моделі, а це означає, що за їх допомогою не можна зробити коректні висновки про результати взаємозв’язку залежної та пояснювальних змінних. А якщо між пояснювальними змінними існує функціональний зв’язок, оцінити їхній вплив на залежну змінну взагалі неможливо.

1. Дисперсія і коваріація оцінок параметрів моделі різко збільшуються.

2. Похибки оцінок параметрів значно збільшуються, відповідно збільшуються їхні інтервали довіри.

3. Оцінки параметрів моделі можуть бути статистично незначущими.

-

Тестування наявності мультиколінеарності в моделі. Алгоритм Фаррара-Глобера.

Найповніше дослідити мультиколінеарність можна застосувавши алгоритм Фаррара—Глобера.

Усі ці критерії при порівнянні з їхніми критичними значеннями дають змогу робити конкретні висновки щодо наявності чи відсутності мультиколінеарності пояснювальних змінних.

Опишемо алгоритм Фаррара—Глобера.

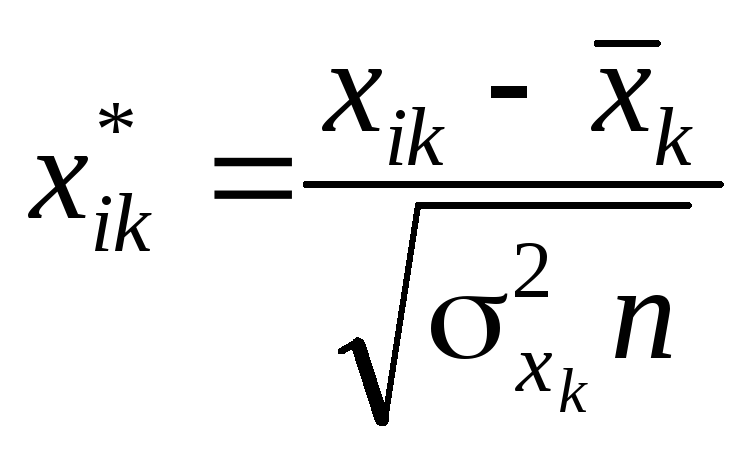

Крок 1. Нормалізація змінних.

Позначимо вектори

пояснювальних змінних економетричної

моделі через

![]() .

Елементи нормалізованих векторів

обчислимо за формулами:

.

Елементи нормалізованих векторів

обчислимо за формулами:

1) ![]() ;

2)

;

2)  ,

,

де

![]() — кількість спостережень;

— кількість спостережень;

![]() — кількість пояснювальних змінних;

— кількість пояснювальних змінних;

![]() — середнє арифметичне k-ї пояснювальної

змінної;

— середнє арифметичне k-ї пояснювальної

змінної;

![]() — дисперсія k-ї пояснювальної змінної.

— дисперсія k-ї пояснювальної змінної.

Крок 2. Знаходження кореляційної матриці згідно з двома методами нормалізації змінних:

1) ![]() ;

2)

;

2) ![]() ,

,

де

![]() —

матриця нормалізованих незалежних

(пояснювальних) змінних,

—

матриця нормалізованих незалежних

(пояснювальних) змінних,

![]() —

матриця, транспонована до матриці

—

матриця, транспонована до матриці

![]() .

.

Крок 3.

Визначення критерію

![]() («хі»-квадрат):

(«хі»-квадрат):

![]() ,

,

де

![]() — визначник кореляційної матриці rxx.

— визначник кореляційної матриці rxx.

Значення

цього критерію порівнюється з табличним

при

![]() ступенях свободи і рівні значущості

ступенях свободи і рівні значущості

![]() .

Якщо

.

Якщо

![]() ,

то в масиві пояснювальних змінних існує

мультиколінеарність.

,

то в масиві пояснювальних змінних існує

мультиколінеарність.

Крок 4. Визначення оберненої матриці:

![]() .

.

Крок 5. Обчислення F-критеріїв:

![]() ,

,

де

![]() — діагональні елементи матриці C.

Фактичні значення критеріїв порівнюються

з табличними при m – 1 і n – m

ступенях свободи і рівні значущості .

Якщо Fk

факт > Fтабл,

то відповідна k-та пояснювальна змінна

мультиколінеарна з іншими.

— діагональні елементи матриці C.

Фактичні значення критеріїв порівнюються

з табличними при m – 1 і n – m

ступенях свободи і рівні значущості .

Якщо Fk

факт > Fтабл,

то відповідна k-та пояснювальна змінна

мультиколінеарна з іншими.

Коефіцієнт детермінації для кожної змінної

![]() .

.

Якщо коефіцієнт детермінації наближається до одиниці, то пояснювальна змінна мультиколінеарна з іншими.

Крок 6. Знаходження частинних коефіцієнтів кореляції:

![]()

де

![]() — елемент матриці C, що міститься в k-му

рядку і j-му стовпці;

— елемент матриці C, що міститься в k-му

рядку і j-му стовпці;

![]() i

i

![]() — діагональні елементи матриці C.

— діагональні елементи матриці C.

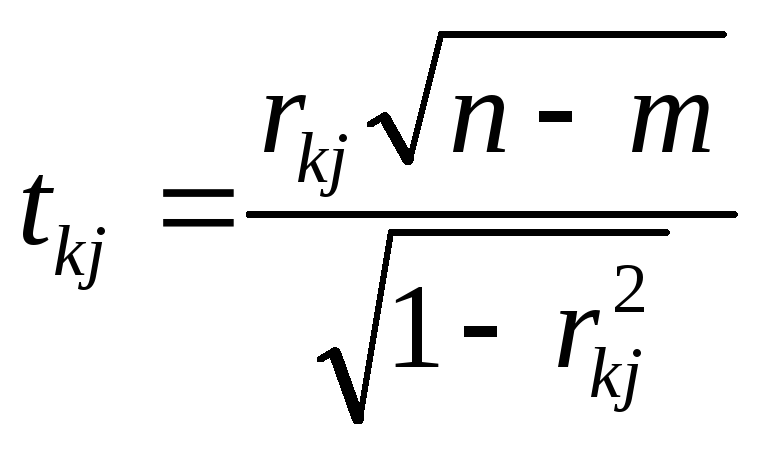

Крок 7. Обчислення t-критеріїв:

.

.

Фактичні

значення критеріїв

![]() порівнюються з табличними при

порівнюються з табличними при

![]() ступенях свободи і рівні значущості

ступенях свободи і рівні значущості

![]() .

Якщо tkj > tтабл,

то між пояснювальними змінними

.

Якщо tkj > tтабл,

то між пояснювальними змінними

![]() і

і

![]() існує мультиколінеарність.

існує мультиколінеарність.

-

Методи усунення мультиколінеарності.

Можна запропонувати кілька простих методів усунення мультиколінеарності:

1) використання додаткової або первинної інформації;

2) об’єднання інформації;

3) відкидання змінної з високою кореляцією;

4) перетворення даних (використання перших різниць);

5) збільшення кількості спостережень.

Алгоритм методу головних компонентів включає дев’ять кроків.

1-й

крок: нормалізувати змінні x1 x2, ... хт

регресійної моделі, обчисливши

![]() де

п кількість спостережень (і= 1, «);

де

п кількість спостережень (і= 1, «);

т - кількість пояснюючих змінних у моделі (/= 1, т); х. - середня арифметична ;-ї незалежної змінної;

σ - середньоквадратичне відхилення ;-ї незалежної змінної.

2-й крок: побудувати нову матрицю Ґ, елементами якої є нормалізовані незалежні змінні.

3-й крок: обчислити кореляційну матрицю (матрицю моментів нормалізованої системи нормальних рівнянь) за формулою

![]()

де X** - транспонована матриця Ґ:

![]()

(недіагональні елементи матриці R характеризують щільність зв’яз-ку однієї незалежної змінної з іншою (rij = rxixj ), тобто є парними ко-ефіцієнтами кореляції).

4-й крок: знайти характеристичні числа матриці r, тобто визначити корені

X1,X2,..., Хm рівняння m-то порядку:

![]() де

E - одинична матриця розмірності mxm; Хj,

j = 1, 2,..., m - харак-теристичні числа матриці

r.

де

E - одинична матриця розмірності mxm; Хj,

j = 1, 2,..., m - харак-теристичні числа матриці

r.

5-й крок: ранжувати власні значення Я , i = 1, 2, ..., m, за абсолютним рівнем внеску кожного головного компонента в загальну дисперсію.

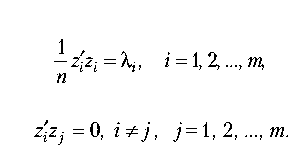

6-й крок: розв’язати систему рівнянь

![]()

і обчислити власні вектори ai , і = 1, 2, ..., m, за умови, що вони відповідають таким співвідношенням:

![]()

7-й крок:

знайти

головні компоненти векторів zi=xai, і= 1,

2, ..., m, які задо-вольняють умови

![]()

8-й крок: визначити параметри моделі Y = ZP :

![]()

9-й

крок: знайти параметри моделі Y = XА:

![]()