- •В. Н. Седалищев Физические основы получения измерительной информации с использованием генераторных и параметрических первичных преобразователей Учебное пособие

- •Введение

- •Глава 1

- •1. Информационно-энергетические основы теории измерений

- •1.1 Понятие информации. Разновидности информации

- •1.2 Количественная оценка информации

- •1.3 Связь понятий энергии и информации Информационный подход к анализу физических процессов

- •1.4 Применение энерго-информационного подхода к анализу физических процессов

- •Аномалии физических и химических свойств воды

- •1.5 Связь теории информации с теорией измерений

- •Количественная оценка измерительной информации

- •Естественные пределы измерений

- •1.6 Причины наличия ограничений количества информации, получаемой при измерениях

- •Разновидности шумов и причины их появления

- •1.7 Способы повышения информативности измерительного процесса

- •1.8 Общая характеристика этапов измерительного преобразования

- •Метрологические характеристики измерительных преобразователей

- •1.2 Классификация физических эффектов и областей их применения в измерительной технике

- •«Фундаментальное единство» природы. Метод электромеханических аналогий

- •Физические основы построения измерительных преобразователей генераторного типа

- •Физические основы создания электромеханических измерительных преобразователей генераторного типа

- •2.3 Пьезоэффект и его применение в измерительной технике

- •2.3.1 Теоретические основы построения пьезоэлектрических измерительных преобразователей генераторного типа

- •2.3.3 Ээсз пьезоэлектрического преобразователя генераторного типа

- •2.3.4 Физические основы работы пьезорезонансных измерительных преобразователей

- •2.3.2 Электрострикция и области применения ее в измерительной технике

- •2.4 Физические основы создания термоэлектрических измерительных преобразователей

- •2.4.1 Пироэффект и применение его в измерительных устройствах

- •2.4.2 Термоэлектрические эффекты в проводниках и полупроводниках

- •2.4.3 Особенности практической реализации термоэлектрических эффектов в измерительных устройствах

- •2.5 Гальваномагнитные эффекты и применение их в измерительных устройствах

- •2.5.1 Эффект Холла и применение его в измерительных устройствах

- •3. Физические эффекты, связанные с модуляцией активного сопротивления ээсз измерительного преобразователя

- •3.1 Принципы построения и разновидности резистивных измерительных преобразователей

- •3. 2 Физические основы создания пьезорезистивных преобразователей контактного сопротивления

- •3.3 Физические основы создания тензорезистивных проводниковых измерительных преобразователей

- •3.4 Физические основы полупроводниковых тензорезистивных преобразователей

- •3.6 Физические основы магниторезистивных измерительных преобразователей

- •3.7 Физические основы работы проводниковых терморезистивных измерительных преобразователей

- •3.8 Физические основы создания полупроводниковых терморезистивных измерительных преобразователей

- •3.9 Физические основы создания фоторезистивных измерительных преобразователей

- •3.10 Физические основы применения явления сверхпроводимости в измерительных устройствах

- •3.10.1 Свойства сверхпроводников

- •3.10.2 Квантово-механическая теория сверхпроводимости

- •Объяснение понятий экситона и поляритона

- •3.10.3 Применение явления сверхпроводимости в измерительной технике

- •3.10.4 Эффект Мейснера и его практическое применение

- •3.10.5 Стационарный и нестационарный эффекты Джозефсона и применение их в измерительной технике

- •4. Физические основы создания электрохимических измерительных преобразователей

- •4.1 Полярографический эффект в растворах и применение его в измерительных устройствах

- •4.2 Физические основы работы кондуктометрических измерительных преобразователей

- •4.3 Применение в измерительной технике электрокинетических явлений в растворах

- •4.4 Принципы работы гальванических измерительных преобразователей

- •5. Физические основы создания первичных преобразователей, основанных на модуляции магнитных параметров измерительной цепи

- •5.1 Принцип работы магнитоиндукционных измерительных преобразователей генераторного типа

- •5.2 Теоретические основы создания индуктивных измерительных преобразователей

- •5.3 Принцип работы вихретоковых измерительных устройств

- •5.4 Физические основы магнитомодуляционных измерительных преобразователей

- •Эффект Виганда

- •5.5 Физические эффекты, связанные с модуляцией магнитных характеристик материалов

- •Пример реализации магнитострикционного эффекта в датчиках линейных перемещений

- •Принцип работы устройства

- •Дополнительные эффекты, возникающие в магнитомодуляционных преобразователях

- •5.6 Физические основы создания магнитоупругих измерительных преобразователей

- •5.7 Зависимость магнитной проницаемости ферромагнетиков от влияющих факторов

- •6. Физические основы создания емкостных измерительных преобразователей

- •6.1 Модуляция геометрических размеров емкостных преобразователей

- •Принципы работы емкостных измерительных преобразователей

- •Емкостной преобразователь с переменной площадью обкладок

- •6.2 Физические основы емкостных измерительных устройств, основанных на модуляции диэлектрических свойств веществ

- •6.2.1 Строение материалов

- •6.2.2 Виды связей и механизмы поляризации диэлектриков

- •6.2.3 Влияние агрегатного состояния вещества на его диэлектрические свойства

- •6.2.4 Примеры практической реализация емкостных измерительных устройств, основанных на управлении диэлектрической проницаемостью веществ

- •7. Физические основы создания биодатчиков генераторного и параметрического типов

- •Глава 1. Информационно-энергетические основы теории измерений

- •Глава 2. Физические основы построения измерительных преобразователей генераторного типа

- •Глава 3. Физические эффекты, связанные с модуляцией активного сопротивления ээсз измерительного преобразователя

- •Глава 4. Физические основы создания электрохимических измерительных преобразователей

- •Глава 5. Физические основы создания первичных преобразователей, основанных на модуляции магнитных параметров измерительной цепи

- •Глава 6. Физические основы создания емкостных измерительных преобразователей

- •Глава 7. Физические основы создания биодатчиков генераторного и параметрического типов

- •Перечень физических эффектов

1.2 Количественная оценка информации

В 1928 году английский инженер Хартли предложил количественную оценку информации, основанную на использовании логарифма числа комбинаций результатов независимых экспериментов:

![]() .

(1.2)

.

(1.2)

В 1933 году Котельников В.А. опубликовал работу о теоретических исследованиях по оценке пропускной способности каналов связи.

В 1948 году в журнале американской телефонной компании «Белл систем» появилась статья 32-летнего инженера-связиста Клода Эльвуда Шеннона «Математическая теория связи». Данная статья с постановкой сугубо технической прикладной задачи (влияние шума на канал связи) привела к созданию теории информации. Главным принципиально новым в этой статье явилась введенная Шенноном мера количества информации, что позволило измерять информацию при ее получении, передаче, хранении, обработке с помощью техническими устройствами.

![]() ,

(1.3)

,

(1.3)

где:

![]() - мощность сигнала;

- мощность сигнала;![]() - мощность шума.

- мощность шума.

Если в канале

передачи информации возможны искажения

сигналов или измерения производятся с

погрешностью, то количество получаемой

информации определяется разностью

энтропий априорной (![]() )

и апостериорной (

)

и апостериорной (![]() ).

).

![]() (1.4)

(1.4)

А.Н. Колмогоров ввел три подхода для количественной оценки информации, выделяя при этом три ее разновидности: комбинаторную, вероятностную и алгоритмическую.

Вероятностная информация характеризует общее число возможных микросостояний системы.

Комбинаторная информация оценивает число возможных комбинаций, определенных сочетаний, композиций состояния системы.

Алгоритмическая информация определяет минимальную длину алгоритма, описывающего неизвестную величину.

Количественная оценка информации является объективной, а качественная оценка (ценность информации) является субъективной оценкой. Для количественной оценки ценности полученной информации предлагаются различные математические соотношения.

Например, мера ценности информации, предложенная Бонгардом и Харкевичем, определяется с использованием формулы:

![]() ,

(1.5)

,

(1.5)

где

![]() - вероятность достижения цели до получения

информации;

- вероятность достижения цели до получения

информации;

![]() - вероятность

достижения цели после получения

информации.

- вероятность

достижения цели после получения

информации.

Корогодиным для этой же цели предлагается другая формула:

![]() .

(1.6)

.

(1.6)

1.3 Связь понятий энергии и информации Информационный подход к анализу физических процессов

Информационная революция поставила на повестку дня вопрос об углубленном изучении сущности единства и противоположности понятий информации и энергии. Связующим звеном между этими понятиями является понятие энтропии. До создания теории информации в понятие «информации» никто не пытался вкладывать строгий научный смысл. Информация, как простая осведомленность о чем-либо казалась вполне исчерпывающим для науки и для повседневной жизни до тех пор, пока не возникла необходимость в количественном измерении сведений, знаний, потребность в машинной обработке огромных массивов информации.

Впервые

вероятно-статистический подход для

описания состояния физического тела

был применён Людвигом Больцманом,

который использовал понятие энтропии,

введенное Рудольфом Клаузиусом (![]() )

за 20 лет до этого (в 1854 году), для описания

термодинамического состояния газа.

)

за 20 лет до этого (в 1854 году), для описания

термодинамического состояния газа.

Клаузиус термин «энтропия» образовал из греческого корня «тропэ», означающего «превращение», к которому добавил приставку «эн», чем хотел подчеркнуть родство введенного им в науку понятия с понятием энергии. Корень «тропэ» Клаузиус употребил потому, что с помощью энтропии удалось проанализировать процессы превращения одних форм энергии в другие. Аналогичную роль сыграло понятие энтропии и в теории информации.

Энтропия – это мера незнания о конкретном состоянии объекта, мера неопределённости, мера беспорядка. Энтропия количественно определяется как средняя логарифмическая функция множества вероятностей возможных состояний системы.

Понятие вероятности в статистической физике связано с понятием энтропии. По Больцману энтропия пропорциональна логарифму числа микроскопических состояний в микросистеме:

![]() (1.7)

(1.7)

где:

![]() число микросостояний;

число микросостояний;

![]() постоянная

Больцмана.

постоянная

Больцмана.

Термодинамическое равновесие характеризуется максимумом энтропии и соответствует наиболее неупорядоченному молекулярному состоянию.

При переходе от термодинамической энтропии к математической необходимо учитывать изменение основания логарифма:

![]() .

(1.8)

.

(1.8)

В математической статистике используют закон больших чисел и центральную предельную теорему для больших выборок. Значение математической энтропии определяется плотностью вероятности наступления определенного события:

![]() (1.9)

(1.9)

где:

![]() -

плотность вероятности события.

-

плотность вероятности события.

Чем больше событий, тем меньше вероятность кого-либо конкретного события, тем выше его информативность.

Математическая статистика, теория вероятностей используется и в метрологии, где числу микросостояний соответствует число различимых градаций, а его логарифм – энтропии:

![]() .

(1.10)

.

(1.10)

Количество

получаемой измерительной информации

соответствует разности между значениями

энтропии априорной (![]() ),

то есть имеющейся неопределенности об

измеряемой физической величине до

эксперимента, и апостериорной (

),

то есть имеющейся неопределенности об

измеряемой физической величине до

эксперимента, и апостериорной (![]() )

энтропии, соответствующей оставшейся

неопределенности после измерения:

)

энтропии, соответствующей оставшейся

неопределенности после измерения:

![]() =

=![]() ,

(1.11)

,

(1.11)

где:

![]() – измеряемая величина;

– измеряемая величина;

![]() - неопределённость

полученных результатов.

- неопределённость

полученных результатов.

Информационный подход, основанный на использовании понятия энтропии, является общим для анализа физических процессов, измерения значений физических величин, получения, передачи и хранения информации. В термодинамике температура, давление являются статистическими величинами. В математической статистике при стремлении объема выборки к бесконечности вероятность заменяется определенностью. Но в физике определенности быть не может, т.к. всегда есть флуктуации, без наличия флуктуаций не возможно получить информацию. В этом есть отличие классического и квантового подхода в физике, статистики и теории вероятности в математике.

Максвелл доказал, что скорости молекул в газе имеют то же самое распределение, что и ошибки наблюдений у Гаусса и это не является случайным совпадением, так как определяются одними и теми же законами. Малые флуктуации возникают в больших системах, а большие флуктуации в малых системах.

Главное достоинство понятие энтропии – быть мерой неопределенности, хаоса, что позволяет перейти от динамической картины мира к статистическому описанию физических процессов и явлений.

Рассмотрим, например, простейшую термодинамическую систему, состоящей из двух соединенных между собой полостей, в одной из которых находятся атомы идеального газа. В результате соударений между собой и со стенками емкостей атомы будут хаотически перемещать в замкнутом пространстве, случайным образом перераспределяясь между двумя емкостями. Проведя анализ возможных комбинаций перераспределения атомов между емкостями можно определить вероятность появления каждой комбинации. При этом для N равновероятных событий вероятность (Р) каждого события равна:

![]() ,

(1.12)

,

(1.12)

где

![]() -

число конкретных реализаций.

-

число конкретных реализаций.

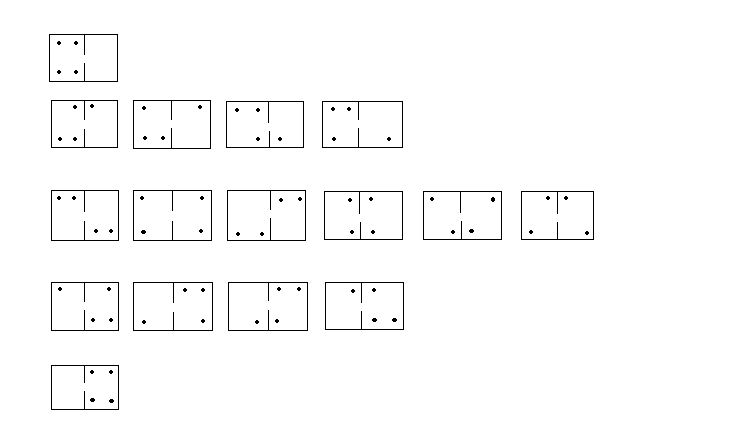

Рассмотрим несколько вариантов состояния такой системы с различным значением числа N = 1; 2; 3…

Рис. 1.1 Возможные варианты термодинамического состояния системы.

![]() ;

;

![]() ;

;![]() ;

;![]() ;

;![]() .

.

Сумма вероятностей

всех возможных комбинаций равна:

![]() .

.

Можно определить среднее значение энтропии для такой системы, которое будет соответствовать ее информативности:

![]()

![]()

![]()

![]()

![]() ≈

≈![]() ≈2,3 бит.

≈2,3 бит.

На основании проведенного анализа такой простейшей термодинамической системы можно сделать вывод, что наиболее вероятным состоянием для идеального газа является равномерное распределение (диффузия) атомов в объеме.

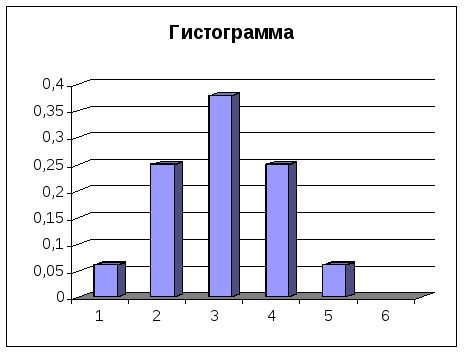

На рисунке приведены гистограмма и ступенчатая характеристика, отражающие дифференциальный и интегральный законы распределения случайных величин, описывающих поведение данной динамической системы.

Рис. 1.2 Статистические характеристики состояния системы.

Очевидно, что с ростом числа частиц будет возрастать информативность такой системы. При переходе границы числа комбинаций состояния системы, равной половине от их общего числа, резко изменяется вероятность пребывания системы в данном состоянии. Это пример вероятностной оценки информативности идеальной термодинамической системы.

Если рассматривать реальную термодинамическую систему, с учетом наличия взаимодействий между атомами, молекулами и т.д., характер протекающих в таких системах физических процессов значительно усложнится. Это обусловит существенно большее разнообразие ее состояний, повысит ее информативность. Информационная оценка агрегатных состояний физических систем потребует введения новых понятий: негэнтропии, равновесной энтропии и т.п.

Для математического описания сложных динамических систем используют понятия комбинаторной, алгоритмической информации. Очевидно, дальнейшее развитие теории информации и других, смежных с ней наук приведет к возможности количественной оценки семантической информации, содержащейся в реальных объектах. Эта информация будет отражать наличие в объекте различных связей, взаимодействий, условий и других его характеристик. Но для того, чтобы можно было говорить об измерениях чего-либо, необходимо иметь для этого соответствующие единицы измерений.

В настоящее время, согласно формуле Шеннона, в качестве меры для измерения информативности сигнала используется уровень сопутствующего ему шума. В измерительной технике – это уровень неопределенности измерительного процесса. Но это чисто энергетическая, обезличенная мера, а для качественной оценки чего-либо необходимо использовать другие характеристики.

Возможно, для оценки сложности систем можно будет использовать фрактальные критерии сложности систем, а в более простых случаях параметры, характеризующие степень нелинейности физических процессов и их математических моделей.

Например, для полученной гистограммы можно определить с помощью коэффициента нелинейности полученной характеристики информативность системы на каждом этапе протекающего динамического процесса, а не только среднее значение информативности. Максимальное значение количества информации в такой системе равно 4 битам (вероятностная информация). Количественная оценка величины комбинаторной информации соответствует 2,3 битам. Исходное состояние в системе характеризовалось нулевым значением информативности и по мере поступления в систему внешней энергии возрастала ее хаотизация, возрастало разнообразие возможных ее состояний, то есть увеличивалась ее информативность.

Если бы это был реальный газ, то физические процессы в системе характеризовались бы гораздо большим разнообразием и, соответственно, информативностью. При этом возрастала бы ее комбинаторная составляющая, которая в пределе бы стремилась к значению вероятностной оценки информативности системы.

Так как при

комнатной температуре:

![]() ,

то энергетическая цена одного бита

информации при нормальных условиях не

может быть меньше значения:

,

то энергетическая цена одного бита

информации при нормальных условиях не

может быть меньше значения:![]() .

С учетом того, что

.

С учетом того, что![]() ,

можно определить минимальную потребляемую

мощность устройств

,

можно определить минимальную потребляемую

мощность устройств

Например, мощность любого технического устройства с информационной производительностью 1Гбит в секунду должна быть не менее:

![]()

В реальных условиях уровень шумов существенно превышает термодинамическую составляющую, поэтому для получения, передачи и преобразования измерительной информации требуются значительно более мощные устройства.

В данных примерах речь идет о микроинформации (связанная информация), а в реальной жизни для макрообъектов имеют дело с макроинформацией (свободная информация).

При получении измерительной информации от объекта используют понятие рецепции информации (прием, получение). При этом выделяют два способа рецепции информации: генераторный и параметрический. Соответственно, и измерительные преобразователи подразделяются на генераторные и параметрические типы.

Попытки практического применения энергетического анализа измерительных устройств предпринимались неоднократно, но не привели к разработке четкой теории, описывающей связь между затраченной энергией и точностью измерений. Положение изменилось после применения информационного подхода к измерительному процессу, основанному на использовании энергетического эквивалента количества информации, исследования взаимосвязи процессов передачи информации, с количеством используемой при этом энергии (Шеннон), связи теории информации с термодинамикой (Бриллюэн) и теории информации с теорией измерений. В основе объединения этих теорий лежит единство свойств математической информации, энтропии с термодинамической энтропией и неопределенностью в теории измерений, т.е. теории погрешностей измерений. Во всех случаях понятие энтропии связано с вероятностным описанием объектов и процессов. Например, если предоставить систему самой себе, то она начнет эволюционировать в сторону возрастания энтропии, происходит хаотизация системы. Поэтому получение информации связано с затратой энергии. Даже при описании «демона» Максвелла нужно учитывать необходимость затраты энергии на считывание информации о скорости движения молекул, их направления движения и т.п.

Решение задачи про «демона», предложенного Максвеллом в 1871 г. было дано Леоном Бриллюэном только через полвека. Суть его рассуждений заключается в том, что для определения скорости частиц потребуется энергия, превышающая энергию термодинамического шума системы.

В приведенном примере речь идет о микроинформации (связанной информаций), а для макрообъектов имеют дело с макроинформацией (свободная информация).