- •Введение

- •Структура курса

- •Литература

- •Сигналы

- •Свойства сигналов

- •Случайные величины и процессы

- •Классификация свойств сигналов

- •Синусно-косинусная форма

- •Вещественная форма

- •Комплексная форма

- •Примеры расчета преобразования Фурье Прямоугольный импульс

- •Свойства преобразования Фурье

- •Представление непрерывных (аналоговых) сигналов в дискретной форме

- •Многомерное дискретное преобразование Фурье

- •Дпф произведения последовательностей

- •Круговая свертка

- •Спектральный анализ

- •Исследование спектра дискретного случайного процесса

- •Связь дпф и спектра дискретного сигнала

- •Растекание спектра

- •Весовые функции

- •Алгоритм быстрого преобразования Фурье

- •Бпф с прореживанием по времени

- •Бпф с прореживанием по частоте

- •Системы обработки сигналов

- •Реализация дискретных систем

- •Взаимосвязь дпф и фильтрации

- •Дпф как дискретная фильтрация

- •Проектирование дискретных фильтров

- •Синтез фильтров по аналоговому прототипу

- •Оптимальные методы

- •Восстановление сигналов (решение обратной задачи)

- •Шум квантования

- •И выбор структуры цифровых фильтров

- •4.6. Свойства цф различной структуры

- •Формы реализации дискретных фильтров

Случайные величины и процессы

Основные положения теории вероятности

Случайные величины. Теория случайных величин изучает вероятностные явления в «статике», рассматривая их как некоторые зафиксированные результаты экспериментов.

Вероятность

Современная теория вероятностей представляет собой аксиоматизированную ветвь математики, обобщившую эмпирический материал, накопленный при изучении случайных явлений.

В основе теории

вероятностей лежит понятие полного

множества «элементарных исходов» или

случайных событий

![]() .

Символы

.

Символы

![]() означают всевозможные исходы некоторого

случайного эксперимента. Каждому событию

означают всевозможные исходы некоторого

случайного эксперимента. Каждому событию

![]() сопоставлено вещественное число

сопоставлено вещественное число

![]() ,

которое называется вероятностью

этого события.

,

которое называется вероятностью

этого события.

Принимаются следующие аксиомы:

-

вероятность неотрицательна и не превышает единицы:

![]() ;

;

-

если

и

и

- несовместимые события, то

- несовместимые события, то

![]() ;

;

-

сумма всех событий, содержащихся в

,

есть достоверное событие:

,

есть достоверное событие:

![]() .

.

Измерение вероятностей

Математическое понятие вероятности случайного события является абстрактной характеритикой, присущей не самим объектам метериального мира, а их теоретико-множественным моделям. Требуется некоторое дополнительное соглашение для того, чтобы можно было извлекать сведения о вероятности из эксперементальных данных.

Общепринято оценивать вероятность события отностительной частотой благоприятных исходов.

Если проведено N независимых испытаний, причем в n из них наблюдалост событие A, то эмпирическая (выборочная) оценка вероятности Р(А),

![]()

Обычно полагают,

что

![]() если число испытаний

если число испытаний

![]() .

.

(Число опытов минимум на порядок больше, чем необходимо правильных значащих цифр, т.е. если до сотых, то не меньше 1000)

Классификация свойств сигналов

Классификация сигналов по статистическим параметрам

Усреднение. Моменты случайной величины

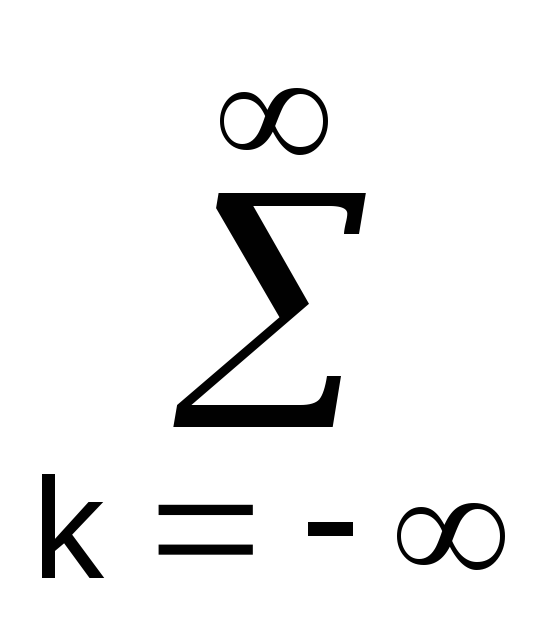

![]()

Например, простейший «первый» момент – «математическое ожидание»

![]()

Среднее значение сигнала при осреднении по ансамблю в момент t1 определяется по формуле

![]() .

(6-53)

.

(6-53)

При осреднении данной k-й реализации во времени среднее значение

![]() .

(6.54)

.

(6.54)

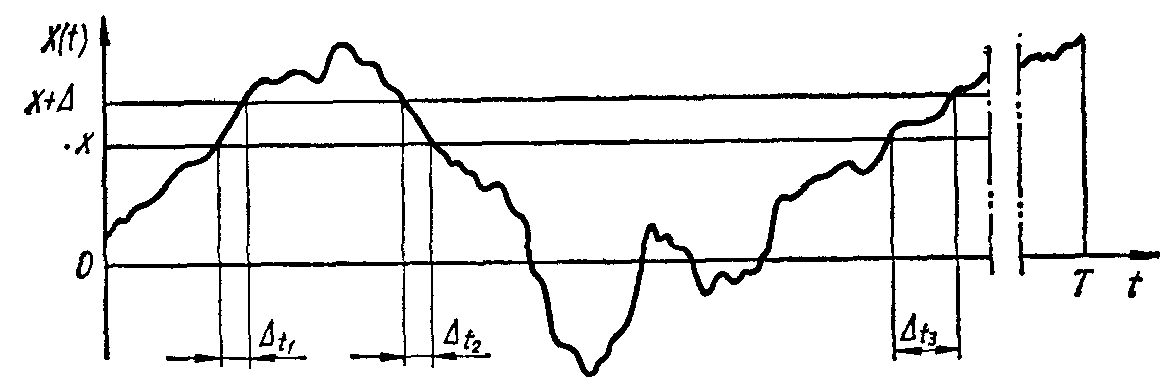

Рис. 6.16. К определению плотности распределения случайного сигнала

Среднее значение сигнала характеризует его постоянную составляющую. Среднее значение стационарного сигнала равно постоянной величине, а стационарного и эргодического сигнала, найденное путем временного осреднения одной реализации — среднему значению по ансамблю реализаций.

Среднее значение квадрата сигнала характеризует суммарную интенсивность данной реализации:

![]() (6.55)

(6.55)

Среднее квадратическое значение сигнала равно корню квадратному из среднего значения квадрата:

Центральные моменты

![]()

Например, второй центральный момент –«дисперсия»

![]()

С. к. о. сигнала (для стационарных и эргодических процессов?)

![]() .

.

Стационарный и

эргодический случайный сигнал удобно

характеризовать двумя составляющими:

постоянной и переменной. Первая равна

среднему значению сигнала

![]() ,

а вторая оценивается дисперсией

,

а вторая оценивается дисперсией

![]() ,

характеризующей рассеяние сигнала по

отношению к среднему значению, и равна

среднему значению квадрата отклонения

сигнала от его среднего значения:

,

характеризующей рассеяние сигнала по

отношению к среднему значению, и равна

среднему значению квадрата отклонения

сигнала от его среднего значения:

![]() .

(6.56)

.

(6.56)

Преобразуя уравнение (6.56), получим

![]() .

.

Следовательно, дисперсия стационарного и эргодического сигнала равна разности между средним значением квадрата и квадратом среднего значения и характеризуется постоянным числом.

С. к. о. сигнала

![]() .

.

Функция распределения, или интегральный закон распределения, Р(X<x1) равна вероятности того, что сигнал X(t) не превосходит заданного значения:

![]() .

(6.58)

.

(6.58)

Вероятность того,

что

![]() ,

очевидно, равна нулю, а вероятность

того, что

,

очевидно, равна нулю, а вероятность

того, что

![]() ,

равна 1. Следовательно, функция

распределения Р(X)

изменяется от 0 до 1.

,

равна 1. Следовательно, функция

распределения Р(X)

изменяется от 0 до 1.

Рис. Функция распределения

Вероятность нахождения сигнала в интервале между значениями x1 и х2

Плотность распределения случайного сигнала, или дифференциальный закон распределения р(х) характеризует вероятность того, что мгновенные значения сигнала в произвольный момент времени будут находиться в заданном интервале значений. Рассматривая реализацию случайного сигнала X(t) (рис. 6.16), вероятность нахождения сигнала в интервале значений х и х + ∆ можно определить, вычисляя отношение

![]()

где

![]() —суммарное время нахождения сигнала

X(t)

в интервале между значениями х и х + ∆

в течение времени Т, Т — продолжительность

реализации X(t);

—суммарное время нахождения сигнала

X(t)

в интервале между значениями х и х + ∆

в течение времени Т, Т — продолжительность

реализации X(t);

![]()

Одномерная плотность распределения сигнала

![]() .

.

ПРВ есть производная от функции распределения.

![]() =>

=>

![]() ,

т.е. p(x) есть

вероятость попадания случайной величины

в полуинтервал (х, x+dx].

,

т.е. p(x) есть

вероятость попадания случайной величины

в полуинтервал (х, x+dx].

Свойства:

p(x)>0

![]()

Одномерная плотность распределения р(х) не содержит координаты времени и не отражает статистической зависимости значений сигнала при изменении времени. Плотность распределения сигнала — действительная неотрицательная функция и для стационарного эргодического сигнала может быть определена по одной реализации. Через плотность распределения удобно выражается среднее значение случайного сигнала

![]()

и среднее значение его квадрата

![]()

Функция распределения, или интегральный закон распределения, для стационарного и эргодического сигнала также может быть определена по одной его достаточно протяженной во времени реализации.

Рис. 6.17. Примеры сигналов и графики плотностей распределения:

а — гармонического, б — суммы гармонического и случайного, в — узкополосного случайного шума, г — широкополосного случайного шума.

Плотность распределения и функция распределения являются весьма важными характеристиками случайного сигнала и измеряются статистическими анализаторами. По известной плотности распределения можно определить другие важные параметры случайного сигнала — функцию распределения, вероятность нахождения сигнала в заданном интервале и др. Кроме этого, характер плотности распределения дает возможность установить структуру сигнала, например наличие в нем гармонической составляющей. Покажем это на примере сравнения реализаций и плотностей распределения четырех сигналов: гармонического (рис. 6.17, и), суммы гармонического и случайного (рис. 6.17, б), узкополосного (рис. 6.17, в) и широкополосного (рис. 6.17, г) случайных шумов. Гармонический сигнал в данном случае рассматривается как случайный, поскольку предполагается, что фаза его является случайной величиной. Плотность распределения гармонического сигнала (рис. 6.17, а, б) со случайной фазой представляется чашеобразной симметричной кривой, а случайных сигналов (рис. 6.17, в) и (рис. 6.17, г) чаще всего подчиняется закону Гаусса (п. 4.2) и имеет куполообразную симметричную форму. Сумма гармонического и случайного сигналов имеет характерные особенности плотностей распределения их обоих — как гармонического, так и случайного сигналов — это иногда дает возможность по виду плотности распределения определить состав данного исследуемого сигнала.

Функциональный анализ

При решении задач обработки сигналов возникают следующие вопросы:

-как оценить сходство сигналов,

-как оценить состав сложного сигнала,

Векторное представление сигналов бесконечномерном пространстве

Математический раздел «Функциональный анализ» использует модель сигнала как вектора в специальном бесконечномерном пространстве. Приведенные далее системы аксиом не являются исчерпывающе полными, но достаточными для понимания следующих разделов. В некоторых случаях вывод показан на основе качественных представлений.

Линейное пространство сигналов

Пусть М={s1(t), s2(t),…}- множество сигналов. Множество сигналов М образует вещественное линейное пространство, если справедливы следующие аксиомы:

-

Любой сигнал

при

любых t

принимает лишь вещественные значения.

при

любых t

принимает лишь вещественные значения. -

Для любых

и

и

существует

их сумма

существует

их сумма

,

причем w

также содержится в

М. Операция суммирования коммутативна:

,

причем w

также содержится в

М. Операция суммирования коммутативна: и ассоциативна:

и ассоциативна: .

. -

Для любого сигнала

и любого вещественного числа α определен

сигнал

и любого вещественного числа α определен

сигнал

.

. -

Множество М содержит особый нулевой элемент

,

такой, что

,

такой, что

для

всех

для

всех

.

.

Если математические модели сигналов принимают комплексные значения, то, допуская в аксиоме 3 умножение на комплексное число, приходим к понятию комплексного линейного пространства.

Элементы линейных пространств часто называют векторами, подчеркивая аналогию свойств этих объектов и обычных трехмерных векторов.

Понятие координатного базиса

Как и в обычном трехмерном пространстве, в линейном пространстве сигналов можно выделить специальной подмножество играющее роль координатных осей.

Говорят,

что совокупность векторов

![]() ,

принадлежащих М является линейно

независимой, если

равенство

,

принадлежащих М является линейно

независимой, если

равенство

![]()

возможно

лишь в случае одновременного обращения

в нуль всех числовых коэффициентов

![]() .

.

Система линейно независимых векторов образует координатный базис в линейном пространстве. Какой либо элемент координатного базиса не может быть выражен в виде линейной комбинации оставшихся элементов. Если дано разложение некоторого сигнала s(t) в виде

![]()

то

числа

![]() являются проекциями

сигнала s(t)

относительно выбранного базиса или

коэффициентами

разложения по базису.

являются проекциями

сигнала s(t)

относительно выбранного базиса или

коэффициентами

разложения по базису.

Какой либо элемент координатного базиса не может быть выражен в виде линейной комбинации оставшихся элементов.

Нормированное линейное пространство. Энергия сигнала

Определение понятия длина вектора позволяет вычислять насколько один сигнал больше другого. Длину вектора называют нормой.

Линейное

пространство сигналов L

является нормированным, если каждому

вектору

![]() однозначно

сопоставлено число

однозначно

сопоставлено число

![]() - норма этого вектора, причем выполняется

следующие аксиомы нормированного

пространства:

- норма этого вектора, причем выполняется

следующие аксиомы нормированного

пространства:

1) Норма

неотрицательна,

![]() .

Норма

.

Норма

![]() тогда и только тогда, если

тогда и только тогда, если

![]()

2) Для

любого числа α справедливо равенство

![]() .

.

3) Если

s(t)

и p(t)

– два вектора из L,

то выполняется неравенство треугольника:

![]() .

.

Принято определять норму вещественных непрерывных сигналов следующим образом

![]()

Если сигнал дискретен то

![]()

Для комплексных сигналов норма

![]()

где * - символ комплексно-сопряженной величины.

Квадрат нормы фактически является энергией сигнала, именно такая энергия выделяется на резисторе с сопротивлением 1Ом, если к нему приложено напряжение s(t).

![]()

Энергетическая норма оказывается нечувствительной к изменениям формы сигнала , даже значительным, но происходящим на коротких отрезках времени.

Рисунок

Метрическое пространство

Линейное

пространство становится метрическим

пространством, если

каждой паре элементов

![]() сопоставлено неотрицательное число

сопоставлено неотрицательное число

![]() ,

называемое метрикой или расстоянием

между этими элементами.

,

называемое метрикой или расстоянием

между этими элементами.

Обычно метрику определяют как норму разности двух сигналов:

![]() .

.

Норму

можно понимать как расстояние между

данным элементом пространства и нулевым

элементом:

![]() .

.

Метрика, независимо от способа ее определения, должна подчиняться аксиомам метрического пространства:

1)

![]() - рефлексивность метрики.

- рефлексивность метрики.

2)

![]()

3) Каков

бы ни был элемент

![]() ,

всегда

,

всегда

![]() .

.

Зная метрику, можно судить, насколько один сигнал подобен по форме другому.

Скалярное произведение сигналов

Угол

между векторами(норма и метрика уже

определена) можно определить через

понятие скалярного произведения

элементов линейного пространства. Если

в обычном трехмерном пространстве

известны два вектора

![]() и

и

![]() ,

то квадрат модуля их суммы равен

,

то квадрат модуля их суммы равен

![]() ,

,

где

![]() - скалярное

произведение сигналов, зависящее от

угла между ними.

- скалярное

произведение сигналов, зависящее от

угла между ними.

Рисунок

Действуя по аналогии, вычислим энергию суммы двух сигналов u и v:

![]() . (a)

. (a)

В отличии от самих сигналов их энергии не аддитивны – энергия суммарного сигнала содержит в себе так называемую взаимную энергию

![]() . (b)

. (b)

Сравнивая между собой формулы (a) и (b), примем, что скалярное произведение вещественных сигналов u и v равно

![]() ,

,

а также косинус между ними:

![]() .

.

В соответствии с формулой угол должен лежать в интервале от 0° до 180°.

Скалярное произведение обладает следующими свойствами:

1)

![]() ;

;

2)

![]() ;

;

3)

![]() ,

где λ – вещественное число;

,

где λ – вещественное число;

4)

![]() .

.

Справедливо фундаментальное неравенство Коши-Буняковского

![]() .

.

Линейное пространство с таким скалярным произведением, называется вещественным гильбертовым пространством.

Если сигналы принимают комплексные значения, то можно определить комплексное гильбертово пространство, введя в нем скалярное произведение по формуле

![]() ,

,

такое

что

![]() .

.

Корреляционный анализ

Корреляция (correlation), и ее частный случай для центрированных сигналов – ковариация, является методом анализа сигналов, его смысл состоит в количественном измерении степени сходства различных сигналов.

Автокорреляционная функция (autocorrelation) показывает степень сходства между сигналом и его сдвинутой копией (скользящей по аргументу) — чем больше значение корреляционной функции, тем это сходство сильнее. Автокорреляция позволяет оценить среднестатистическую зависимость текущих отсчетов сигнала от своих предыдущих и последующих значений (так называемый радиус корреляции значений сигнала), а также выявить в сигнале наличие периодически повторяющихся элементов.

Взаимная корреляция сигналов характеризует определенную корреляцию явлений и физических процессов, отображаемых данными сигналами, и может служить мерой “устойчивости” данной взаимосвязи при раздельной обработке сигналов в различных устройствах.

Приведем один из вариантов использования метода. Допустим, что имеется сигнал s(t), в котором может быть (а может и не быть) некоторая последовательность x(t) конечной длины Т, временное положение которой нас интересует. Для поиска этой последовательности в скользящем по сигналу s(t) временном окне длиной Т вычисляются скалярные произведения сигналов s(t) и x(t). Тем самым мы "прикладываем" искомый сигнал x(t) к сигналу s(t), скользя по его аргументу, и по величине скалярного произведения оцениваем степень сходства сигналов в точках сравнения. В функциональном пространстве сигналов эта степень сходства может выражаться в нормированных единицах коэффициента корреляции, т.е. в косинусе угла между векторами сигналов, и, соответственно, будет принимать значения от 1 (полное совпадение сигналов) до -1 (полная противоположность).

Особое значение методы корреляции имеют при анализе случайных процессов для выявления неслучайных составляющих и неслучайных параметров этих процессов.

Заметим, что в терминах "корреляция" и "ковариация" в настоящее время существует изрядная путаница. В иностранной литературе термин "ковариация" применяется к центрированным функциям, а "корреляция" – к произвольным. В отечественной литературе, и особенно в литературе по сигналам и их обработке, довольно часто применяется прямо противоположная терминология.

Принципиального значения это не имеет, но при знакомстве с литературными источниками стоит обращать внимание на принятое назначение данных терминов. При разработке настоящих лекций было принято решение использовать общепринятую международную терминологию, как согласованную по понятиям с основными положениями теории вероятностей и математической статистики.

Автокорреляционные функции сигналов

Автокорреляционные функции (АКФ) финитных сигналов. АКФ (correlation function, CF) сигнала s(t), локализованного во времени и конечного по энергии, является количественной интегральной характеристикой формы сигнала, и определяется интегралом от произведения двух копий сигнала s(t), сдвинутых относительно друг друга на время :

Bs()

= s(t)

s(t+)

dt = ás(t),

s(t+)ñ

= ||s(t)||

||s(t+)||

cos ().

(8.1.1)

s(t)

s(t+)

dt = ás(t),

s(t+)ñ

= ||s(t)||

||s(t+)||

cos ().

(8.1.1)

АКФ, вычисленная по центрированному значению сигнала s(t), и нормированная на центральное значение, изменяется в интервале от -1 до 1 и представляет собой функцию автокорреляционных коэффициентов:

s() = Bs()/Bs(0) = Bs()/ ||s(t)||2.

Иногда эту функцию называют "истинной" (нормированной) автокорреляционной функцией.

АКФ обладает следующими свойствами:

1. АКФ имеет физическую размерность энергии, а при = 0 значение АКФ имеет максимум, который всегда положителен и непосредственно равен энергии сигнала, а модуль АКФ при любом значении временного сдвига не превосходит энергии сигнала. Последнее прямо вытекает из свойств скалярного произведения (как и неравенство Коши-Буняковского):

ás(t), s(t+)ñ = ||s(t)||||s(t+||cos (),

cos () = 1 при = 0, ás(t), s(t+)ñ = ||s(t)||||s(t)|| = Es,

cos () < 1 при 0, ás(t), s(t+)ñ = ||s(t)||||s(t+||cos () < Es.

![]()

2. КФ является четной функцией своего аргумента τ, в чем нетрудно убедиться заменой переменной t = t- в выражении (8.1.1):

Bs()

=

s(t)

s(t+)

dt =

s(t)

s(t+)

dt =

s(t-)

s(t) dt

= Bs(-).

s(t-)

s(t) dt

= Bs(-).

3. Значение КФ при τ = 0 является максимально возможным значением:

![]()

4. По мере увеличения значения величины сдвига для финитных сигналов временное перекрытие сигнала с его копией уменьшается, а, соответственно, косинус угла взаимодействия и скалярное произведение в целом стремятся к нулю (С ростом абсолютного значения τ КФ сигнала с конечной энергией затухает):

![]()

5. Если сигнал s(t) не содержит особенностей в виде дельта-функций, его КФ не может иметь разрывов (то есть обязана быть непрерывной функцией).

6. Если сигнал — напряжение, то размерность его КФ равна В2 • с.

Примеры АКФ

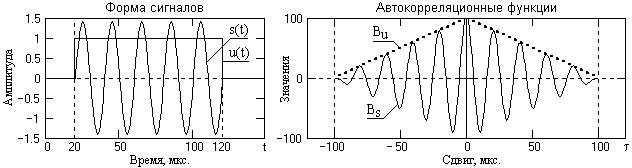

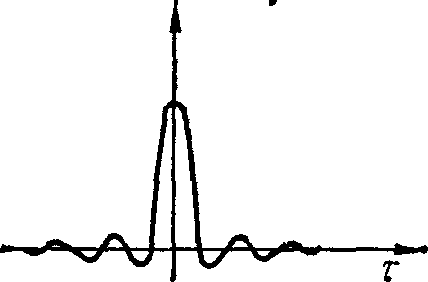

На рис. приведены

два сигнала – прямоугольный импульс и

радиоимпульс одинаковой длительности,

и соответствующие данным сигналам формы

их АКФ. Амплитуда колебаний радиоимпульса

установлена равной

![]() амплитуды прямоугольного импульса, при

этом энергии сигналов также будут

одинаковыми, что подтверждается равными

значениями центральных максимумов АКФ.

При конечной длительности импульсов

длительности АКФ также конечны, и равны

удвоенным значениям длительности

импульсов (при сдвиге копии конечного

импульса на интервал его длительности

как влево, так и вправо, произведение

импульса со своей копией становится

равным нулю). Частота колебаний АКФ

радиоимпульса равна частоте колебаний

заполнения радиоимпульса (боковые

минимумы и максимумы АКФ возникают

каждый раз при последовательных сдвигах

копии радиоимпульса на половину периода

колебаний его заполнения).

амплитуды прямоугольного импульса, при

этом энергии сигналов также будут

одинаковыми, что подтверждается равными

значениями центральных максимумов АКФ.

При конечной длительности импульсов

длительности АКФ также конечны, и равны

удвоенным значениям длительности

импульсов (при сдвиге копии конечного

импульса на интервал его длительности

как влево, так и вправо, произведение

импульса со своей копией становится

равным нулю). Частота колебаний АКФ

радиоимпульса равна частоте колебаний

заполнения радиоимпульса (боковые

минимумы и максимумы АКФ возникают

каждый раз при последовательных сдвигах

копии радиоимпульса на половину периода

колебаний его заполнения).

Рис. График функции прямоугольного импульса и радиоимпульса

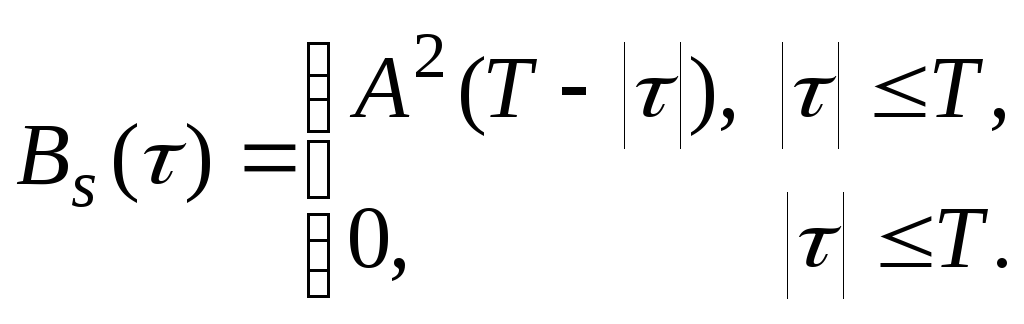

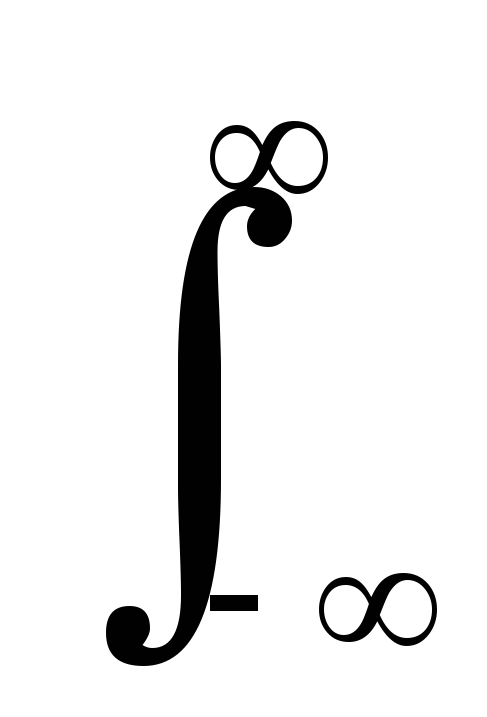

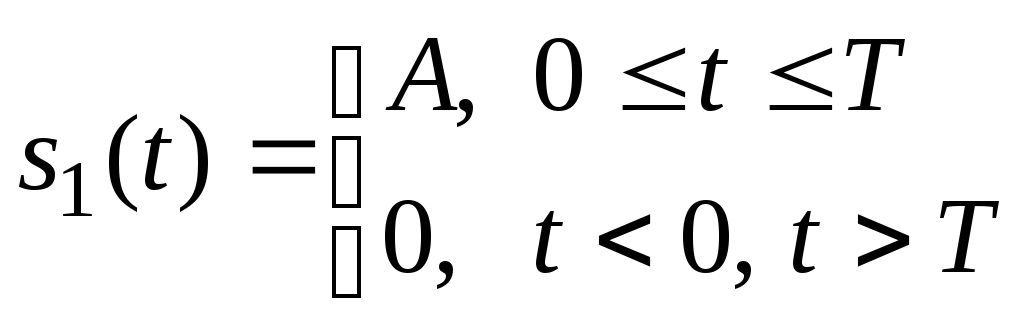

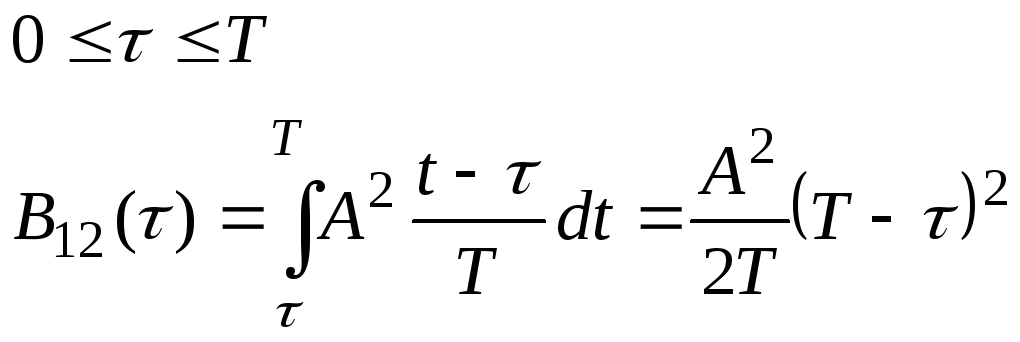

Вычислим АКФ прямоугольного импульса

- при 0<τ< Т

![]()

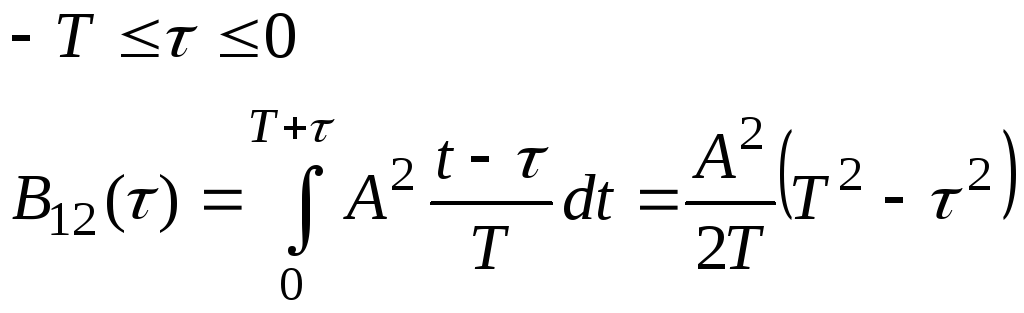

- при -T<τ<0

![]()

- при |τ| > Т

![]()

Объединяя результаты, можно записать

Рис. График корреляционной функции прямоугольного импульса

С учетом четности, графическое представление АКФ обычно производится только для положительных значений . Знак + в выражении (8.1.1) означает, что при увеличении значений от нуля копия сигнала s(t+) сдвигается влево по оси t. На практике сигналы обычно задаются на интервале положительных значений аргументов от 0 до Т, что дает возможность продления интервала нулевыми значениями, если это необходимо для математических операций. В этих границах вычислений более удобным для построения вычислительных алгоритмов является сдвиг копии сигнала вправо по оси аргументов, т.е. применение в выражении (8.1.1) функции копии s(t-):

Bs()

=

s(t)

s(t-) dt.

s(t)

s(t-) dt.

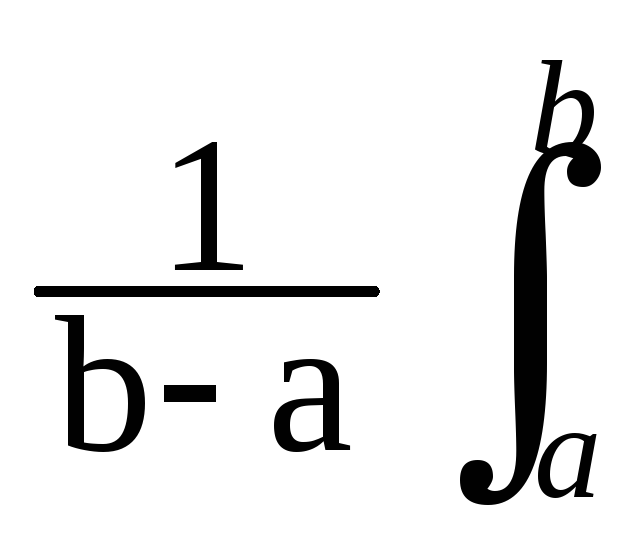

АКФ неограниченных во времени сигналов. Для сигналов, заданных на определенном интервале [a, b], вычисление АКФ производится с нормировкой на длину интервала [a, b]:

Bs()

= s(t)

s(t+)

dt. (8.1.1'')

s(t)

s(t+)

dt. (8.1.1'')

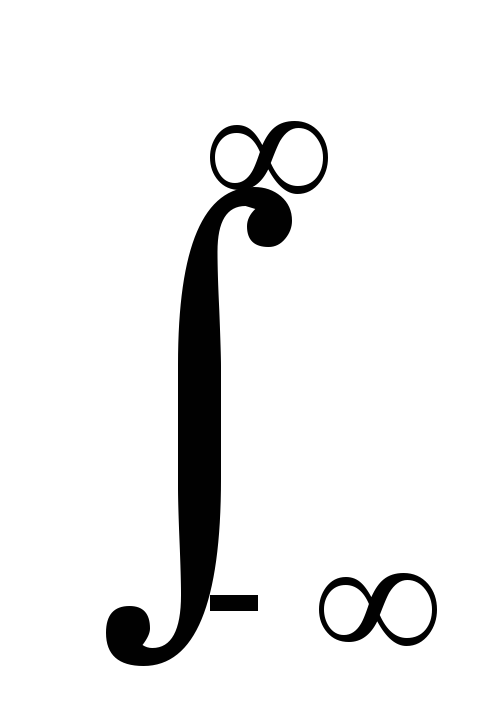

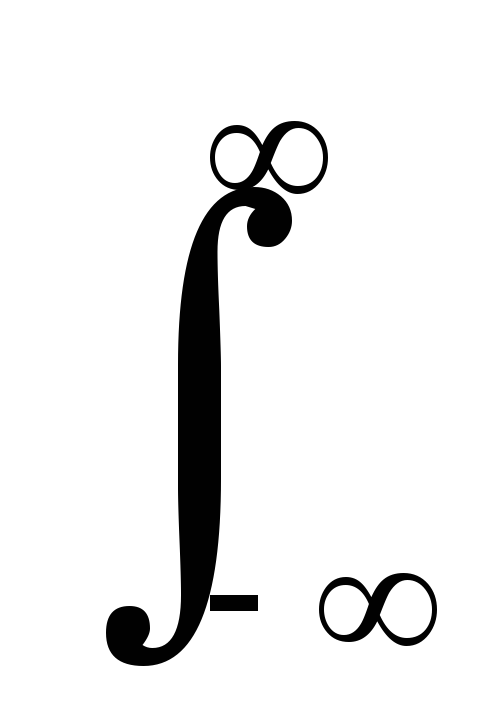

В пределе, для сигналов с бесконечной энергией, АКФ может быть получена как среднее значение скалярного произведения сигнала и его копии при устремлении интервала длительности сигнала Т к бесконечности:

Bs()

.

.

АКФ по данному выражению имеет физическую размерность мощности, и равна средней взаимной мощности сигнала и его копии в функциональной зависимости от сдвига копии.

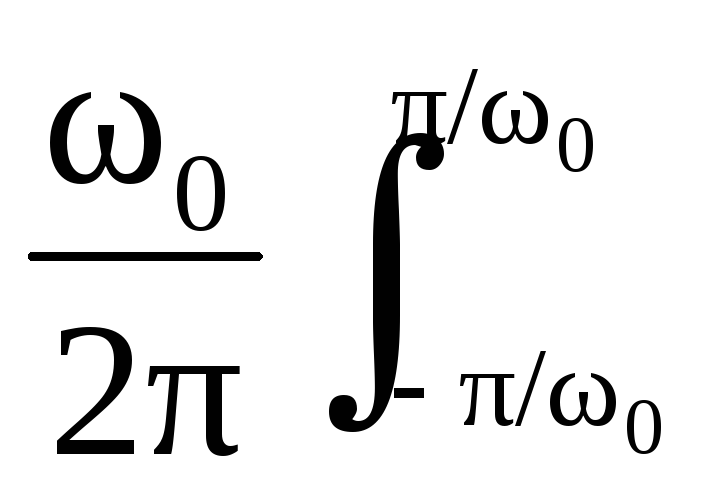

АКФ периодических сигналов. Энергия периодических сигналов бесконечна, поэтому АКФ периодических сигналов вычисляется по одному периоду Т, с усреднением скалярного произведения сигнала и его сдвинутой копии в пределах этого периода:

Bs()

= (1/Т)![]() s(t)

s(t-)

dt. (8.1.2')

s(t)

s(t-)

dt. (8.1.2')

Свойства КФ периодических сигналов

1. При =0 значение нормированной на период АКФ в этом случае равно не энергии, а средней мощности сигналов в пределах периода:

![]()

2. Свойство четности сохраняется:

![]() .

.

3. Значение КФ при τ = 0 по-прежнему является максимально возможным:

![]()

4. АКФ периодического сигнала является периодической функцией с тем же периодом, что и сам сигнал:

![]() .

.

5. Если сигнал не содержит дельта-функций, его КФ будет непрерывной функцией.

6. Отметим, что полученный результат не зависит от начальной фазы гармонического сигнала, что характерно для любых периодических сигналов и является одним из свойств КФ.

7. Размерность КФ периодического сигнала — квадрат размерности сигнала (В2, если сигнал — напряжение).

Вычислим АКФ прямоугольного радиоимпульса

Так, для сигнала s(t) = A cos(0t+0) при T=2/0 имеем:

Bs()

= A cos(0t+0)

A cos(0(t-)+0)

= (A2/2) cos(0).

A cos(0t+0)

A cos(0(t-)+0)

= (A2/2) cos(0).

АКФ случайных функций

АКФ дискретных сигналов. При интервале дискретизации данных t = const вычисление АКФ выполняется по интервалам = t и обычно записывается, как дискретная функция номеров n сдвига отсчетов n:

Bs(n) =

t sksk-n.

(8.1.3)

sksk-n.

(8.1.3)

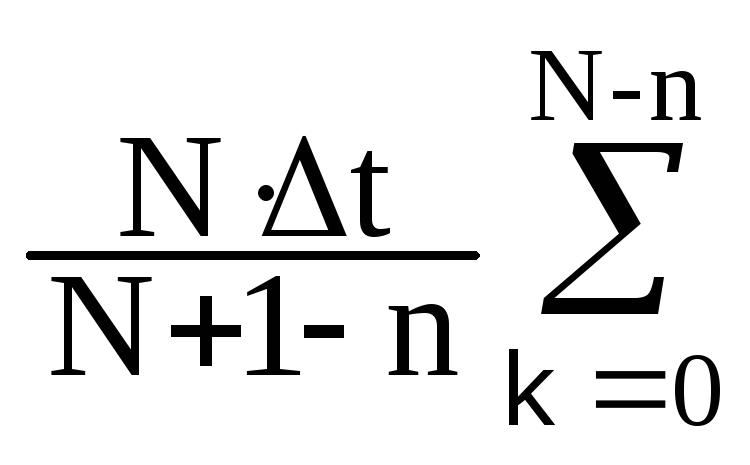

Дискретные сигналы обычно задаются в виде числовых массивов определенной длины с нумерацией отсчетов к = 0,1,…N, а вычисление дискретной АКФ выполняется в одностороннем варианте с учетом длины массивов по формуле:

Bs(n) =

sksk-n.

(8.1.3')

sksk-n.

(8.1.3')

Множитель N/(N+1-n) в данной функции является поправочным коэффициентом на постепенное уменьшение числа перемножаемых и суммируемых значений (от N до N-n) по мере увеличения сдвига n. Без этой поправки для нецентрированных сигналов в значениях АКФ появляется тренд суммирования средних значений.

Практически, дискретная АКФ имеет такие же свойства, как и непрерывная АКФ. Она также является четной, а ее значение при n = 0 равно энергии дискретного сигнала.

Кодовые сигналы являются разновидностью дискретных сигналов. На определенном интервале кодового слова Мt они могут иметь только два амплитудных значения: 0 и 1 или 1 и –1. При выделении кодов на существенном уровне шумов форма АКФ кодового слова имеет особое значение. С этой позиции наилучшими считаются такие коды, значения боковых лепестков АКФ которых минимальны по всей длине интервала кодового слова при максимальном значении центрального пика. К числу таких кодов относится код Баркера, приведенный в таблице 8.1. Как видно из таблицы, амплитуда центрального пика кода численно равна значению М, при этом амплитуда боковых осцилляций при n 0 не превышает 1.

Таблица 8.1.

|

M |

Сигнал Баркера |

АКФ сигнала |

|

2 |

1, -1 |

2, -1 |

|

3 |

1, 1, -1 |

3, 0, -1 |

|

4 |

1, 1, 1, -1 |

4, 1, 0, -1 |

|

|

1, 1, -1, 1 |

4, -1, 0, 1 |

|

5 |

1, 1, 1, -1, 1 |

5, 0, 1, 0, 1 |

|

7 |

1, 1, 1, -1, -1, 1, -1 |

7, 0, -1, 0, -1, 0, -1 |

|

11 |

1,1,1,-1,-1,-1,1,-1,-1,1,-1 |

11,0,-1,0,-1,0,-1,0,-1,0,-1 |

|

13 |

1,1,1,1,1,-1,-1,1,1-1,1,-1,1 |

13,0,1,0,1,0,1,0,1,0,1,0,1 |

Функции автоковариации (ФАК). В практике обработки и статистического анализа дискретных данных и функций вместо корреляционных функций обычно используются ковариационные функции, хотя эти два термина очень часто используются как синонимы. Строго корректно, под функциями автоковариации (ФАК) следует понимать вторые центральные моменты распределения числовых величин в цифровых массивах:

Cs(n) =

(sk-

(sk-![]() )(sk-n-

)(sk-n-![]() ),

(8.1.4)

),

(8.1.4)

где

![]() -

среднее значение функций. Максимум ФАК,

как и АКФ, соответствует n = 0 и равен

дисперсии сигнала sk. Из сравнения

(8.1.4) с выражением (8.1.3) отсюда следует,

что дисперсия сигналов (квадрат

стандартного отклонения от среднего

значения) равна средней энергии сигнала

по интервалу его задания. Соответственно,

связь ФАК с энергетическим спектром

(плотностью распределения мощности

сигнала) через преобразование Фурье

сохраняется аналогичной АКФ.

-

среднее значение функций. Максимум ФАК,

как и АКФ, соответствует n = 0 и равен

дисперсии сигнала sk. Из сравнения

(8.1.4) с выражением (8.1.3) отсюда следует,

что дисперсия сигналов (квадрат

стандартного отклонения от среднего

значения) равна средней энергии сигнала

по интервалу его задания. Соответственно,

связь ФАК с энергетическим спектром

(плотностью распределения мощности

сигнала) через преобразование Фурье

сохраняется аналогичной АКФ.

Классификация сигналов по АКФ

Автокорреляционная функция отражает степень линейной статистической связи значений сигнала в данный момент времени от его значений в другие моменты и для стационарного и эргодического сигнала определяется по формуле

![]() , (6.59)

, (6.59)

т. е. равна среднему значению произведения мгновенных значений сигнала, сдвинутых во времени на интервал τ.

Автокорреляционная функция достигает максимума в точке τ=0 и является действительной четной функцией, т. е.

![]() (6.60)

(6.60)

Значение автокорреляционной функции при временном нулевом сдвиге τ=0 равно среднему значению квадрата сигнала:

![]()

Значение автокорреляционной функции при временном сдвиге τ=∞ равно квадрату среднего значения сигнала (за исключением некоторых особых случаев, например гармонического сигнала):

![]() .

.

Коэффициентом корреляции центрированного сигнала rx(τ) называют отношение

![]() .

.

Автокорреляционная

функция, как и плотность распределения,

также является удобным средством

идентификации исследуемого сигнала,

поскольку, например, дает возможность

установить, является ли данный сигнал

гармоническим или случайным либо их

суммой. Это возможно потому, что

автокорреляционная функция гармонического

сигнала также является гармонической

функцией т, а случайного, например

центрированного, сигнала с

![]() —

затухающей функцией и при больших

сдвигах τ стремится к нулю.

—

затухающей функцией и при больших

сдвигах τ стремится к нулю.

Покажем это на примере сравнения автокорреляционных функций реализаций четырех сигналов, представленных на рис. 6.18. Из рис. 6.18, а видно, что автокорреляционная функция гармонического сигнала является гармонической функцией — косинусоидой

![]()

с частотой

![]() ,

равной частоте гармонического сигнала.

Автокорреляционная функция суммы

гармонического и случайного сигналов

(рис. 6.18, б) представляет собой сумму их

автокорреляционных функций, имеет

крутой пик при τ=0 и является незатухающей,

гармонической функцией. Автокорреляционная

функция узкополосного случайного

сигнала (рис. 6.18, в) представляет собой

медленно затухающую периодическую

функцию.

,

равной частоте гармонического сигнала.

Автокорреляционная функция суммы

гармонического и случайного сигналов

(рис. 6.18, б) представляет собой сумму их

автокорреляционных функций, имеет

крутой пик при τ=0 и является незатухающей,

гармонической функцией. Автокорреляционная

функция узкополосного случайного

сигнала (рис. 6.18, в) представляет собой

медленно затухающую периодическую

функцию.

Рис. 6.18. Автокорреляционные функции некоторых сигналов:(картинку переделать!)

а — гармонического, б — суммы гармонического сигнала и случайного шума, в —узкополосного случайного шума, г — широкополосного случайного шума.

Указанные особенности автокорреляционных функций дают возможность в ряде случаев различить детерминированный, в частности гармонический, процесс от случайного, выявить основные особенности последнего.

Автокорреляционная функция широкополосного случайного сигнала (рис. 6.18, г) с нулевым средним значением представляет собой крутой пик (при τ=0), который быстро затухает. В идеальном случае для предельно широкополосного сигнала в виде белого шума автокорреляционная функция является дельта-функцией при τ=0.

Взаимные корреляционные функции сигналов

Взаимная корреляционная функция (ВКФ) разных сигналов (cross-correlation function, CCF) описывает как степень сходства формы двух сигналов, так и их взаимное расположение друг относительно друга по координате (независимой переменной). Обобщая формулу (8.1.1) автокорреляционной функции на два различных сигнала s(t) и u(t), получаем следующее скалярное произведение сигналов:

Bsu()

= s(t)

u(t+) dt.

s(t)

u(t+) dt.

Очевидно, что КФ является частным случаем ВКФ, когда оба сигнала одинаковы.

Для периодических сигналов понятие ВКФ обычно не применяется, за исключением сигналов с одинаковым периодом, например, сигналов входа и выхода систем при изучении характеристик систем.

Количественный показатель степени сходства сигналов s(t) и u(t) - функция взаимных корреляционных коэффициентов:

su()

= Bsu()/![]() = Bsu() /(||s(t)||

||u(t)||).

= Bsu() /(||s(t)||

||u(t)||).

Интервал изменения значений функций при сдвигах i может изменяться от –1 (полная обратная корреляция) до 1 (полное сходство или стопроцентная корреляция). При сдвигах I, на которых наблюдаются нулевые значения su(i), сигналы независимы друг от друга (некоррелированны).

Свойства ВКФ

1. Для конечных по энергии сигналов ВКФ также конечна, что следует из неравенства Коши-Буняковского и независимости норм сигналов от сдвига по координатам. При этом:

|Bsu()|

||s(t)||||u(t)||,

![]() ,

,

где Е1 и E2 — энергии сигналов s1(t) и s2(t).

2. При замене переменной t = t-, получаем:

Bsu()

= s(t-)

u(t) dt

=

s(t-)

u(t) dt

= u(t) s(t-)

dt = Bus(-).

u(t) s(t-)

dt = Bus(-).

![]() ,

то есть изменение знака τ равносильно

взаимной перестановке сигналов, отсюда

следует, что для ВКФ не выполняется

условие четности, Bsu()

Bsu(-).

,

то есть изменение знака τ равносильно

взаимной перестановке сигналов, отсюда

следует, что для ВКФ не выполняется

условие четности, Bsu()

Bsu(-).

С учетом нечетности, графическое представление ВКФ производится, и для отрицательных, и для положительных значений .

3. Значение ВКФ при τ=0 ничем не выделяется; максимум может быть расположен в любом месте оси τ.

Рис. Сигналы и ВКФ

Это можно наглядно видеть на рис., где заданы два одинаковых сигнала с центрами на точках 0.5 и 1.5. Вычисление с постепенным увеличением значений означает последовательные сдвиги сигнала s2(t) влево по оси времени (для каждого значения s1(t) для подынтегрального умножения берутся значения s2(t+)). При =0 сигналы ортогональны и значение B12()=0. Максимум В12() будет наблюдаться при сдвиге сигнала s2(t) влево на значение =1, при котором происходит полное совмещение сигналов s1(t) и s2(t+).

4. С ростом абсолютного значения τ ВКФ сигналов с конечной энергией затухает:

![]()

5. Если сигналы s1(t) и s2(t) не содержат особенностей в виде дельта-функций, то ВКФ не может иметь разрывов (то есть обязана быть непрерывной функцией).

6. Если сигналы — напряжение, то размерность их ВКФ равна В2 с.

Примеры ВКФ:

Комбинации по парам функций: гармоническая, импульсная, импульсная с гармоническим заполнением, случайная.

На рис. приведены примеры ВКФ для прямоугольного сигнала s(t) и двух одинаковых треугольных сигналов u(t) и v(t). Все сигналы имеют одинаковую длительность Т, при этом сигнал v(t) сдвинут вперед на интервал Т/2.

Сигналы s(t) и u(t) одинаковы по временному расположению и площадь "перекрытия" сигналов максимальна при =0, что и фиксируется функцией Bsu. Вместе с тем функция Bsu резко асимметрична, так как при асимметричной форме сигнала u(t) при симметричной форме s(t) (относительно центра сигналов) площадь "перекрытия" сигналов изменяется по разному в зависимости от направления сдвига (знака при увеличения значения от нуля). При смещении исходного положения сигнала u(t) влево по оси ординат (на опережение сигнала s(t) - сигнал v(t)) форма ВКФ остается без изменения и сдвигается вправо на такое же значение величины сдвига – функция Bsv на рисунке. Если поменять местами выражения функций в (8.2.1), то новая функция Bvs будет зеркально повернутой относительно =0 функцией Bsv.

Рис. Взаимноковариационные функции сигналов

Взаимная корреляционная функция двух сигналов X (t) и Y (f) характеризует общую статистическую зависимость их значений и для эргодических сигналов определяется по следующей формуле:

![]() (6.70)

(6.70)

т. е. равна среднему значению произведения мгновенных значений сигналов X(t) и Y(t), сдвинутых во времени на интервал τ.

Если

![]() ,

то, следовательно, сигналы X(t)

и Y(t)

некоррелированы между собой. При этом

должно быть равно нулю среднее значение

одного из сигналов X(t)

или Y(t).

,

то, следовательно, сигналы X(t)

и Y(t)

некоррелированы между собой. При этом

должно быть равно нулю среднее значение

одного из сигналов X(t)

или Y(t).

Абсолютное значение Rxy (т) ограничивается двумя неравенствами:

![]() (6.71)

(6.71)

![]() . (6-72)

. (6-72)

Взаимная корреляционная функция применяется для определения взаимных временных характеристик и параметров исследуемых сигналов, например для измерения времени задержки. На взаимокорреляционной функции входного и выходного сигналов исследуемого линейного звена в момент, когда τ равно времени задержки, появляется пик. Взаимная автокорреляционная функция применяется также для обнаружения сигнала в шуме и определения его автокорреляционной функции и др.

Ортогональные сигналы и обобщенные ряды Фурье

Основой спектрального анализа являются ортогональные сигналы. Два сигнала называются ортогональными, если их скалярное произведение, а значит, и взаимная энергия равны нулю:

![]() .

.

Например, sin(x) и cos(x) на периоде повторения.

Ортонормированным

базисом называется

бесконечная система ортогональных друг

другу функций

![]() заданная на конечном или бесконечном

отрезке времени

заданная на конечном или бесконечном

отрезке времени

![]() и обладающая единичными нормами.

и обладающая единичными нормами.

Примеры ортонормированных базисов:

- Система гармонических функций

![]() ,

,

![]() ;

;

![]() ,

,

![]()

![]() .

.

- Система функций Уолша

![]()

![]()

![]()

![]()

![]() -безразмерное

время

-безразмерное

время

Представлением сигнала в виде обобщенного ряда Фурье в выбранном ортонормированном базисе называется следующее выражение

![]() .

(х)

.

(х)

где

![]() -

функции данного ортонормированного

базиса(может записываться и как

-

функции данного ортонормированного

базиса(может записываться и как

![]() ,

и как

,

и как

![]() при этом помнится, что базисная функция

задана на отрезке времени),

при этом помнится, что базисная функция

задана на отрезке времени),

![]() -

коэффициенты данного ряда(коэффициенты

разложения в ряд ХХ).

-

коэффициенты данного ряда(коэффициенты

разложения в ряд ХХ).

Например,

разложение сигнала с конечной энергией,

заданного на отрезке времени

![]() в

обобщенный ряд Фурье по функциям Уолша

имеет вид

в

обобщенный ряд Фурье по функциям Уолша

имеет вид

![]() .

.

Коэффициенты

ряда находят следующим образом. Домножим

обе части выражения (х) на базисную

функцию

![]() с произвольным номером k

и проинтегрируем результаты по времени:

с произвольным номером k

и проинтегрируем результаты по времени:

.

.

Т.к.

базис ортонормирован, то в правой части

равенства останется только член суммы

с номером

![]() поэтому

поэтому

.

.

Геометрический смысл формулы таков: коэффициент обобщенного ряда Фурье есть проекция вектора на базисное направление.

Рис.

Возможность представления сигналов посредством обобщенных рядов Фурье является фактом большого принципиального значения. Вместо того чтобы изучать функциональную зависимость в несчетном множестве точек (отсчеты по времени бесконечной функции), можно характеризовать эти сигналы счетной системой коэффициентов ряда(хотя система коэффициентов в общем бесконечна).

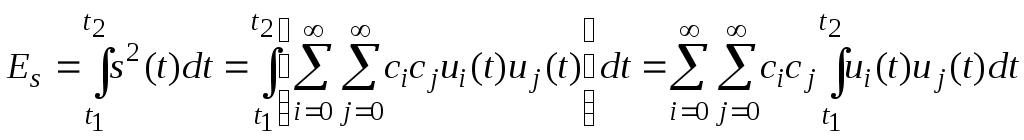

Энергия сигнала, представленная в форме обобщенного ряда Фурье

Рассмотрим некоторый сигнал s(t), разложенный в ряд по ортонормированной базисной системе:

![]() ,

,

и вычислим его энергию, непосредственно подставив этот ряд в выражение для расчета энергии:

Напоминание. Интеграл суммы можно представить как сумму интегралов.

Поскольку

базисная система функций ортонормированна,

в сумме отличными от нуля окажутся

только члены с номерами

![]() .

.

Отсюда получается замечательный результат:

![]() .

.

Т.е. энергия сигнала есть сумма энергий всех компонент, из которых складывается обобщенный ряд Фурье.

Данная формула обобщает теорему Пифагора на случай бесконечномерных пространств.

Оптимальность разложения по ортогональному (ортонормированному) базису

При разложении в обобщенный ряд Фурье обеспечивается минимум ошибки аппроксимации. Величина ошибки монотонно убывает с ростом числа учитываемых членов ряда. Выбирая это число достаточно большим, всегда можно снизить норму ошибки до любой приемлемо малой величины.

Следует учитывать, что близость нормы сигнала к норме конечного отрезка обобщенного ряда Фурье вовсе не означает сходимость суммы ряда к мгновенному значению сигнала в каждой точке. В некоторых точках сумма ряда может давать резкие всплески, которые называют эффектом Гиббса.

Представление сигнала в виде суммы ортогональных функций называется –спектральным разложением (коротко, спектром) или представление сигнала в частотной форме(области).

Разложение в ряд Фурье по гармоническому базису

Существует множество разнообразных систем ортогональных функций, но широкое применение получила система, составленная из гармонических функций(sin и cos).

Это обусловлено тем, что динамические физические системы принято описывать дифференциальными уравнениями, а функции sin и cos инвариантны относительно операций интегрирования и дифференцирования. При дифференцировании и интегрировании гармонических функций может измениться амплитуда и фаза колебания, но частота остается неизменной.

![]()

Т.е. базовые функции остаются неизменными, а изменяются только коэффициенты.

Для других условий может быть более выгодно применять другие системы ортогональных функций.

В ряд Фурье раскладывают периодические сигналы.

Для того чтобы такое разложение существовало, фрагмент сигнала длительностью в один период должен удовлетворять условиям Дирихле:

- не должно быть разрывов второго рода (с уходящими в бесконечность ветвями функции);

а число разрывов первого рода (скачков) должно быть конечным;

- число экстремумов должно быть конечным (в качестве примера функции, которая на конечном интервале имеет бесконечное число экстремумов, можно привести sin(l/X) в окрестности нуля).

В зависимости от конкретной формы базисных функций различают несколько форм записи ряда Фурье.