Информатика - Борисов

.pdf

2.Информация, еевидыисвойства, кодирование информации

Вкибернетике под информацией понимается любая совокупность сигналов, воздействий или сведений, которые некоторой системой воспринимаются от окружающей среды, выдаются в окружающую среду, а также хранятся.

Форму и представление передаваемой информации определяют сообщения. Примерами сообщений являются телефонный разговор; музыкальное произведение; текст, распечатанный на принтере, и т.д. Сообщение от источника к получателю передается посредством ка- кой-нибудь среды, являющейся в таком случае каналом связи.

Так, при передаче речевого сообщения в качестве канала связи можно рассматривать воздух, в котором распространяются звуковые волны. При передаче такого же сообщения по телефону каналом связи служит телефонный кабель, по которому передаются электри- ческие сигналы, а в случае передачи письменного сообщения кана- лом можно считать лист бумаги, на котором напечатан текст

(Рис. 2.1).

Рис. 2.1

При передаче по каналу связи может происходить потеря ин- формации, т.е. уменьшение ее количества.

Различают по формам представления информации:

–непрерывную (аналоговую);

–прерывистую (цифровую, дискретную).

Непрерывная форма характеризует процесс, который не имеет перерывов и теоретически может изменяться в любой момент време- ни и на любую величину (например, речь человека, напряжение электрического тока).

Примером аналогового хранения звуковой информации является виниловая пластинка (звуковая дорожка изменяет свою форму не- прерывно), а дискретного – аудио компакт-диск (звуковая дорожка которого содержит участки с различной отражающей способностью).

Примером аналогового представления графической информации может служить, скажем, живописное полотно, цвет которого изме- няется непрерывно, а дискретного — изображение, напечатанное с помощью струйного принтера и состоящее из отдельных точек раз- ного цвета.

Примером дискретной информации может служить текст книги, со- общение, передаваемое с помощью азбуки Морзе. На ЭВМ можно об-

11

Раздел I. Теоретические основыинформатики

рабатывать только дискретную информацию, поэтому непрерывную (аналоговую) информацию необходимо преобразовывать в дискретную (цифровую). Для преобразования аналогового сигнала в цифровой тре- буется провести дискретизацию непрерывного сигнала во времени, квантование по уровню, а затем кодирование отобранных значений. Дискретизация – замена непрерывного сигнала последовательностью отдельныхвовремениотсчетовэтогосигнала.

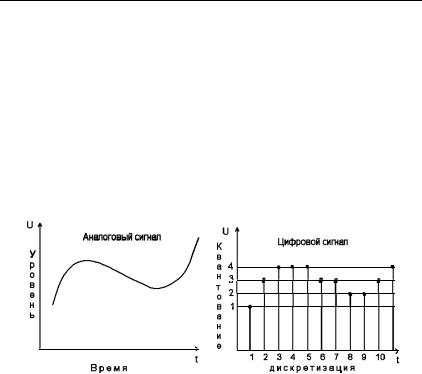

На Рис. .2.2 схематично показан процесс преобразования ана- логового сигнала в цифровой, который в данном случае может принимать лишь пять различных уровней. Естественно, качество такого преобразования невысокое. Из рисунка видно, что изменение цифрового сигнала возможно лишь в некоторые моменты времени (в данном случае этих моментов одиннадцать).

Рис. 2.2

После такого преобразования непрерывный сигнал представляют последовательностью чисел. Показанный на рисунке непрерывный сигнал заменяется числами 1-3-4-4-4-3-3-2-2-3-4. Чем выше частота дискретизации и чем меньше шаг квантования, тем выше качество воспроизведения цифрового сигнала.

Для преобразования аналогового сигнала в цифровой используют специальное электронное устройство – аналого-цифровой преобразо- ватель (АЦП). Примером АЦП являются модем, сканер. Обратное преобразование цифрового сигнала в аналоговый осуществляется с помощью цифро-аналогового преобразователя (ЦАП). ЦАП входит

вустройство видеокарты для преобразования цифровой картинки

ваналоговую информацию.

Информацию следует считать особым видом ресурса, при этом имеется в виду толкование «ресурса» как запаса неких знаний о ма- териальных предметах или энергетических, структурных или каких- либо других характеристик предмета. В отличие от материальных ресурсов, информационные ресурсы являются неистощимыми.

12

2. Информация, еевидыисвойства, кодирование информации

2.2. Вероятностный и объемный способы измерения количества информации

Зачастую разные люди, получившие одно и то же сообщение, по- разному оценивают информацию, содержащуюся в нем. Тот, кто мало осведомлен об описываемых событиях, сочтет, что получил много информации. Тот, кто имел сведений больше, чем получил в сообщении, скажет, что информации не получили вовсе. С каждым получаемым сообщением неопределенность знаний по интересую- щему вопросу уменьшается. Если достигнута полная ясность, то не- определенность исчезает. Таким образом, информацию, которую получает человек, можно считать мерой уменьшения неопределенности знания.

За единицу количества информации принята такая единица, ко- торая уменьшает неопределенность знаний в два раза. Эта единица называется бит.

Возьмем в качестве примера опыт, связанный с бросанием пра- вильной игральной кости, имеющей N=6 граней. Результатом дан- ного опыта может быть выпадение грани с одним из следующих зна-

ков: 1, 2, …, N.

Введем численную величину, измеряющую неопределенность эн- тропию (обозначим ее H). Величины N и H связаны между собой не- которой функциональной зависимостью H = f(N), а сама функция f является возрастающей и неотрицательной.

Рассмотрим процедуру бросания кости более подробно:

1)готовимся бросать кость, исход опыта неизвестен, т.е. имеется некоторая неопределенность, обозначим ее H1;

2)кость брошена, информация об исходе данного опыта получена, обозначим количество этой информациичерезI;

3)обозначим неопределенность данного опыта после его осуще-

ствления через H2.

За количество информации, которое получено в ходе осуществ- ления опыта, примем разность неопределенностей до и после опыта:

I = H1 – H2.

Очевидно, что в случае, когда получен конечный результат, имевшаяся неопределенность снята (H2 = 0) и, таким образом, количество полученной информации совпадает с первоначальной энтропией. Иначе говоря, неопределенность, заключенная в опыте, совпадает с информацией об исходе этого опыта.

Следующим важным моментом является определение вида функ- ции f. Если варьировать число граней N и число бросаний кости

13

Раздел I. Теоретические основыинформатики

(обозначим эту величину через M), то общее число исходов будет равно N в степени M

Так, в случае двух бросаний кости с шестью гранями имеем X = 62 = 36. Фактически каждый исход X есть некоторая пара (X1, X2), где X1 и X2 – соответственно исходы первого и второго бросания (X – общее число таких пар).

Выражение H = log2N – формула Хартли для определения энтро-

пии (вероятностной меры количества информации).

Важным при введении какой-либо величины является вопрос о том, что принимать за единицу ее измерения. Очевидно, H будет равно единице при N=2. Иначе говоря, в качестве единицы прини- мается количество информации, связанное с проведением опыта, состоящего в получении одного из двух равновероятных исходов (примером такого опыта может служить бросание монеты, при кото- ром возможны два исхода: «орел» и «решка»). Такая единица количе- ства информации называется «бит».

Все N исходов рассмотренного выше опыта являются равноверо- ятными и поэтому можно считать, что на долю каждого исхода при- ходится одна N-я часть общей неопределенности опыта: (log2N)/N.

При этом вероятность i-го исхода Pi равняется, очевидно, 1/N.

Формула для определения энтропии в случае, когда вероятности различных исходов опыта не равновероятны (т.е. Pi могут быть раз-

личными), определяется выражением

иназывается формулой Шеннона.

Вкачестве примера определим количество информации, связан- ное с появлением каждого символа в сообщениях, записанных на рус- ском языке. Будем считать, что русский алфавит состоит из 33 букв и знака «пробел» для разделения слов. По формуле Хартли H = log2 34 ≈

≈ 5 бит.

Однако в словах русского языка (равно как и в словах других язы- ков) различные буквы встречаются неодинаково часто. Ниже приве- дена таблица вероятностей частоты употребления различных знаков русского алфавита, полученная на основе анализа очень больших по объему текстов.

14

2. Информация, еевидыисвойства, кодирование информации

Таблица 2.1. Частотность букв русского языка

Воспользуемся для подсчета H формулой Шеннона: H ~ 4,72 бит. Полученное значение H, как и можно было предположить, меньше вычисленного ранее. Величина H, вычисляемая по формуле Хартли, является максимальным количеством информации, которое могло бы приходиться на один знак.

Рассмотрим алфавит, состоящий из двух знаков: 0 и 1. Если считать, что со знаками 0 и 1 в двоичном алфавите связаны одина- ковые вероятности их появления (P(0)=P(1)=0,5), то количество информации на один знак при двоичном кодировании

H=log22=1(бит).

Таким образом, количество информации (в битах), заключенное

вдвоичном слове, равно числу двоичных знаков в нем.

Вдвоичной системе счисления знаки 0 и 1 будем называть би- тами (от английского выражения Binary digiTs – двоичные цифры). Отметим, что создатели компьютеров отдают предпочтение именно двоичной системе счисления потому, что в техническом устройстве наиболее просто реализовать два противоположных физических со- стояния. В компьютере бит является наименьшей возможной еди- ницей информации.

Объем информации, записанной двоичными знаками в памяти компьютера или на внешнем носителе, подсчитывается просто по количеству требуемых для такой записи двоичных символов. Для удобства использования введены и более крупные, чем бит, единицы измерения информации:

1 байт = 8 бит; 1 Килобайт (Кбайт) = 210 байт = 1024 байт;

1 Мегабайт (Мбайт) = 210 Кбайт = 1024 Кбайт; 1 Гигабайт (Гбайт) = 210 Мегабайт = 1024 Мегабайт.

15

Раздел I. Теоретические основыинформатики

В последнее время в связи с увеличением объемов обрабатываемой информациивходят вупотребление такие производные единицы, как:

1 Терабайт (Тбайт) = 1024 Гбайт = 240 байт; 1 Петабайт (Пбайт) = 1024 Тбайт = 250 байт.

Между вероятностным и объемным количеством информации соотношение неоднозначное. Далеко не всякий текст, записанный двоичными символами, допускает измерение объема информации в вероятностном (кибернетическом) смысле, но заведомо допускает его в объемном. Далее, если некоторое сообщение допускают изме- римость количества информации в обоих смыслах, то это количество не обязательно совпадает, при этом кибернетическое количество ин-

формации не может быть больше объемного. В прикладной информа-

тике практически всегда количество информации понимается в объ- емном смысле.

2.3. Системы счисления

Система счисления (СС) – принятый способ записи чисел и со- поставления этим записям реальных значений. Все системы счисле- ния можно разделить на два класса: позиционные и непозиционные. Для записи чисел в различных системах счисления используется не- которое количество отличных друг от друга знаков (цифр). Количе- ство таких знаков в позиционной системе счисления называется ос- нованием системы счисления. В десятичной системе счисления таких знаков десять: 0, 1, 2, 3, 4, 5, 6, 7, 8, 9. Рассмотрим несколько приме- ров различных систем счисления.

Непозиционные системы счисления. Римская система счисле-

ния: I(1) V(5) X(10) L(50) C(100) D(500) M(1000). В скобках приве-

дено соответствие римской цифры десятичному числу. Она является непозиционной и используется, в основном, для ведения нумерации.

Позиционные системы счисления.

Двоичная: 0, 1.

Восьмеричная: 0, 1, 2, 3, 4, 5, 6, 7, 8.

Шестнадцатеричная: 0, 1, 2, 3, 4, 5, 6, 7, 8, 9, A, B, C, D, E, F.

А (цифра, изображающая десять), В (цифра одиннадцать), С (цифра двенадцать),

D(цифра тринадцать),

E(цифра четырнадцать),

F(цифра пятнадцать).

Представим число 254 в непозиционной (римской) и позиционной (десятичной) системах счисления: CCLIV=C+C+L+V-I (римская). Внепозиционной системе счисления значение знака не зависит от

16

2. Информация, еевидыисвойства, кодирование информации

того места, которое он занимает в числе. В позиционной системе счисления значение знака зависит от позиции, которую он занимает. В числе 254 двойка обозначает количество сотен, а в числе 452 – коли-

чествоединиц: 254(10)=2*102 + 5*101 + 4*100 (десятичная).

В вычислительной технике широко применяют двоичную, восьме- ричную и шестнадцатеричную системы счисления. Понятно, что чем больше основание системы счисления, тем компактнее запись числа.

Так, число 254(10)=11111110(2)=376(8)=FE(16).

Известны правила перевода чисел из одной системы счисления в другую. Как правило, они реализованы в инженерной версии каль- кулятора – программы, поставляемой стандартно с операционной системой, которой следует воспользоваться при возникновении не- обходимости перевода чисел.

2.4. Кодирование информации

Абстрактный алфавит. Дискретная информация записывается с помощью некоторого конечного набора знаков, называемых буква- ми. Вообще буквой будем называть элемент некоторого конечного множества отличных друг от друга знаков. Множество знаков с оп- ределенным в нем порядком назовем алфавитом.

Примеры алфавитов.

1. Алфавит прописных русских букв:

А Б В Г Д Е Ё Ж З И Й К Л М Н О П Р С Т У Ф Х Ц Ч Ш Щ Ъ Ы Ь Э Ю Я

2. Алфавит арабских цифр:

0 1 2 3 4 5 6 7 8 9 3. Алфавит двоичных цифр:

0 1

Кодирование и декодирование. Составляя информационную модель объекта или явления, мы должны договориться о том, как понимать те или иные обозначения, то есть о виде представления информа- ции. Для общения друг с другом мы используем код – русский язык. При разговоре этот код передается звуками, при письме – буквами русского алфавита. Вы встречаетесь с кодированием информации при переходе дороги в виде сигналов светофора.

Кодирование – процесс преобразования информации для переда- чи по каналу связи. Подобное преобразование может осуществляться в момент поступления сообщения в канал связи (кодирование) и в момент приема сообщения получателем (декодирование). Устройства, обеспечивающие кодирование и декодирование, называют соответ- ственно кодировщиком и декодировщиком.

17

Раздел I. Теоретические основыинформатики

Код – однозначное соответствие группы букв одного алфавита группе букв другого алфавита. Известным примером кода может служить азбука Морзе, где английский алфавит закодирован в виде длинных и коротких сигналов.

Компьютер может обрабатывать информацию, представленную в числовой форме. Вся другая информация (звуки, изображения, текст, показания приборов и т.д.) для обработки на компьютере должна быть преобразована в числовую форму. При вводе текста в компьютер каж- дая буква алфавита кодируется числом, а при выводе на экран по этим числам строятся соответствующие изображения букв. Соответствие между набором букв алфавита и числами называется кодировкой сим- волов. Каждая буква, цифра, знак препинания, кодируются в ЭВМ восьмиразрядным двоичным числом. С помощью восьмиразрядного числаможнозакодировать 256 произвольных символов.

Таблица 2.2. Коды ASCII

18

2. Информация, еевидыисвойства, кодирование информации

Все данные и команды в ЭВМ циркулируют в виде двоичных чи- сел. Информацию можно кодировать числами в различных системах счисления. Особая значимость двоичной системы счисления в ин- форматике определяется тем, что с технической точки зрения разра- ботчикам компьютерной техники такое представление информации казалось самым простым. Требовалось различать только два устой- чивых состояния устройства: включено и выключено. Достаточно сложно создать устройство, которое могло бы обеспечить десять ус- тойчивых состояний, да еще и быстрый переход из одного в другое. Поэтому вся сложная начинка микропроцессора сводится к под- держке двух легкоразличимых состояний: высокий сигнал – 1, низ- кий сигнал – 0.

2.5. Международные системы байтового кодирования

Наиболее распространены две системы кодирования – ASCII и Unicode. ASCII (American Standart Information Interchange) была созда-

на в 1963 г. В своей первоначальной версии это система семибитного кодирования. В следующей версии фирма IBM перешла на 8-битную кодировку символов. В ней первые 128 кодов отданы под буквы анг- лийского алфавита, цифрыинекоторые специальные символы.

Остальные коды отданы под буквы некоторых европейских язы- ков, греческие буквы, математические символы и символы псевдо- графики. Всего расширенный код ASCII позволяет кодировать 256 различных символов. Из сказанного выше следует, что 8-битная кодировка недостаточна для кодирования всех символов, которые хотелось бы иметь в расширенном алфавите.

В системе Unix используется 16-битная кодировка символов – Unicode. Unicode – 16-битное расширение 8-битной кодировки ASCII. Она допускает 65 536 кодовых комбинаций и практически включает всеалфавиты мира.

19

Раздел I. Теоретические основыинформатики

Задание 2.1. Способы измерения количества информации

Выполните следующие пункты задания.

1. Подсчитайте количество информации, приходящейся на один символ, вследующемтекстехудожественногосодержания:

«Повинуясь этому желтому знаку, я тоже свернул в переулок и пошел по ее следам. Мы шли по кривому, скучному переулку без- молвно, я по одной стороне, а она по другой. И не было, вообрази- те, в переулке ни души. Я мучился, потому что мне показалось, что с нею необходимо говорить, и тревожился, что я не вымолв- лю ни одного слова, а она уйдет, и я никогда ее более не увижу».

2.Подсчитайте количествоинформации вбитах, которое потребу- ется для представления текста из задания 1 в компьютере, если для представления одного символа в компьютере используется 2 байта памяти.

3.Сколькобитсодержитсяв32 байтахинформации?

4.Сколькобитсодержитсяв15 килобайтахинформации?

5.Сколькобитсодержитсяв27 мегабайтахинформации?

6.Сколькобайтсодержитсяв8192 битахинформации?

7.Сколькокилобайтсодержитсяв24576 битах информации?

8.Числа, представленные в десятичной системе счисления, пе- реведитевдвоичнуюсистемусчисления: а. 11; б. 78; в. 234; г. 688,68.

9.Числа, представленные в двоичнойсистеме счисления, переве- дите в десятичную систему счисления: а. 10101000; б. 11001100;

в. 11111111; г. 00110011.

10.Числа, представленные в десятичной системе счисления, переведите в восьмеричную систему счисления: а. 11; б. 78; в. 234;

г. 688.

11.Числа, представленные в восьмеричной системе счисления, переведите в десятичную систему счисления: а. 27; б. 101; в. 1042;

г. 50,012.

12.Числа, представленные в десятичной системе счисления, пе- реведите в шестнадцатеричную систему счисления: а. 35; б. 690;

в. 1234; г. 688.

13.Числа, представленные в шестнадцатеричной системе счис- ления, переведите в десятичную систему счисления: а. 1011; б. 6F;

в. ABC; г. 12A,05F.

20