- •Список сообщений

- •Треки и клипы

- •Sweet Spot

- •Частотная характеристика

- •Ушная раковина (Pinna)

- •Неподвижные источники звука

- •Каково же будет решение?

- •Хорус как таковой

- •Хорус в Cool Edit Pro 2

- •Хорус в SONAR 2.1

- •Простые методы сжатия

- •Методы сжатия, основанные на психоакустике

- •Некоторые факты о восприятии звука

- •Транзиентные сигналы

- •1. Оцифровка звука и его хранение на цифровом носителе

- •2. Преобразование звука из цифрового вида в аналоговый

- •3. Способы хранения цифрового звука

- •4. Преимущества и недостатки цифрового звука

- •5. К вопросу об обработке звука

- •6. Аппаратура

- •7. Программное обеспечение

- •8. Перспективы и проблематика

- •Глоссарий терминов

- •Уровень и динамический диапазон звукового сигнала

- •Устройства динамической обработки

- •Структура устройств динамической обработки

- •Временные характеристики

- •Уровень и динамический диапазон звукового сигнала

- •Устройства динамической обработки

- •Структура устройств динамической обработки

- •Временные характеристики

- •Дилэй и эхо - близнецы-братья

- •Дилэй и эхо в Cool Edit Pro 2

- •Дилэй в SONAR 2

- •Дилэй в Cubase SX

- •FFT фильтр

- •IIR фильтры

- •FIR фильтры

- •Введение

- •Wave файл с компрессией ADPCM

- •MPEGplus/Musepack (MP+/MPC/MPP)

- •TwinVQ (VQF)

- •Liquid Audio

- •OGG Vorbis

- •Качество Звучания

- •Заключение

- •Глоссарий:

- •Полезные ссылки:

- •Создаем аудиотрек

- •Выбираем порт ввода звуковых данных

- •Выбираем порт вывода

- •Чтобы не работать впустую

- •Регулируем уровень сигнала

- •Спет куплет

- •Словарик

- •Классический спектр

- •Текущий спектр

- •Мгновенный спектр

- •Отображение мгновенного спектра

- •Сколько весит спектр?

- •Список сообщений

- •Треки и клипы

- •Audio-CD

- •Что влияет на качество воспроизведения Audio-CD?

- •Является ли CD-R, переписанный с обычного CD, точной копией исходного диска?

- •Чем, в таком случае, отличается привод CD-R[W] за $2.000 от привода за $200?

- •Можно ли получить абсолютную копию звука Audio-CD в обычный wav-файл ("сграбить" - англ. "grab")?

- •Какой грабер лучше использовать?

- •Формат сжатия MP3 - общие вопросы

- •Откуда у тебя такая любовь к кодеру Producer 2.1?

- •Если ты даже не смотрел {MP3enc, Lame, Bladeenc, OGG Vorbis, *.* AAC, впишите_сюда_своё}, то почему ты уверен, что Producer 2.1 лучше всех?

- •Всё же, какой кодер самый крутой?

- •Ты совсем не упомянул кодер <n>!

- •Можно ли отличить MP3-256 от оригинала на слух?

- •??? Я всегда считал, что MP3-256 неотличим на слух от оригинала?

- •Может быть, еще увеличить поток поможет? Как насчет MP3-320?

- •А можно ли отличить MP3-256 от оригинала, сравнивая их таким же интенсивным образом, но в слепом тесте?

- •Значит, отличить всё же можно. Почему тогда ты говоришь в своей статье - 'MP3-256 не изменяет параметры звука хоть сколь заметным человеку образом'?

- •Так в каком же случае можно считать MP3-256 оригиналом?

- •Ну и чем кодировать в MP3-256?

- •Немного философии

- •Тебя не смущает, что все твои записи закодированы в MP3-256, и в один прекрасный момент ты обнаружишь их некачественность?

- •Я понял - тебя просто не волнует качество звука. Может, ты просто не слышишь разницы?

- •Если MP3-256 оставляет, как ты говоришь, практически оригинал, можно ли использовать его в студии?

- •Что такое MP3 ?

- •Детали

- •Настоящее и будущее MP3

- •Описание процесса кодирования

- •Подготовка к кодированию. Фреймовая структура

- •Начало кодирования

- •Работа психоакустической модели.

- •Завершение кодирования

- •Замечание

- •Способы кодирования стерео сигнала

- •Простые заблуждения и ошибки, делаемые пользователями MP3

- •Немного о программах

- •Немного о некоторых битрейтах

- •VBR & XingTech

- •Способы хранения MP3

- •Характер потерь при кодировании

- •Тестирование качественности кодеров

- •Психоакустическая модель и разные битрейты

- •Какие, собственно, кодеры у нас в распоряжении

- •Всякое-разное

- •Что такое front-end ?

- •Что такое ACM pro codec ( MP3-кодек ) ?

- •Файлы какого формата можно перевести в формат MP3?

- •Каков статус MP3 кодеров?

- •Каковы системные требования ?

- •Выводы

- •Чем компьютер может помочь в работе над музыкой?

- •Насколько качественно компьютер исполняет и обрабатывает музыку?

- •Можно ли делать всю музыку только на компьютере?

- •Что выбрать - трекер или синтезатор с секвенсором?

- •Где можно найти информацию по работе над музыкой?

- •Кратко об истории и характеристиках стандартов MPEG

- •Что такое CBR и VBR?

- •Каковы отличия режимов CBR, VBR и ABR? (применительно к кодеру Lame)

- •Какие методы кодирования стерео информации используются в алгоритмах MPEG (и других)?

- •Какие параметры предпочтительны при кодировании MP3?

- •Какие алгоритмы компрессии существуют (альтернативы MP3 и др.)?

- •кодирование с потерями качества / lossy coding

- •кодирование без потерь качества / lossless coding

- •Можно ли осуществить преобразование из одного потокового формата аудио данных в другой?

- •Можно ли осуществить преобразование WAV в MIDI, WAV в трекерный модуль?

- •Можно ли выделить из аудио потока звучание конкретного инструмента или голоса?

- •Какие существуют способы преобразования MIDI в WAV?

- •Какой метод сравнения двух аудио сигналов можно признать наиболее точным?

- •Что такое стеганография?

- •Clip Restoration - алгоритм, функционирующий на грани мистики

- •Noise Reduction - шумоподавитель идет по следу

- •Альфа. Программы

- •Бета. Постановка задачи

- •Гамма. Подготовка к восстановлению

- •Дельта. Два способа

- •Дзета. Стерео и дорожки. Щелчки и винил

- •Эта. Фильтрация

- •Тэта. Вычитание или подавление?

- •Иота. Многополосная фильтрация

- •Каппа. Sono luminus

- •Лямбда. Полуфинал

- •Ми. Финал

- •Омега. Суперфинал

- •Графический эквалайзер

- •Параметрический эквалайзер

- •Практикум

- •Кроссовер

- •Совет 1 - Surround stereo, типа.

- •Совет 2 - Кайфные Ведущие.

- •Совет 3 - Эффективное Панорамирование.

- •Совет 4 - Попадаем в Качание вселенского маятника.

- •Предисловие к "ничему"

- •Пики и Впадины

- •Мелодия

- •Groove? Что за Groove?

- •Мля. Только не C, Dm, F, G

- •Последнее, но немаловажное

- •Выразительные средства музыкального языка

- •Динамическое развитие

- •Темповое развитие

- •Мелодическое развитие

- •Ритмическое развитие

- •Тембровое развитие

- •Имитация акустической среды

- •Звуковые эффекты

- •Вибрато

- •Амплитудное вибрато и тремоло

- •Частотное вибрато

- •Тембровое вибрато

- •Немного анатомии (устройство уха - коротко и ясно)

- •О чувствительности (по мощности и частотной)

- •О фазовой чувствительности

- •Об объемном восприятии

- •О нотах и октавах. Гармоники

- •1. Способы преобразования звука

- •2. Звуковые эффекты

- •Использование задержки

- •Преобразование амплитуд

- •Частотные преобразования

- •Использование эффекта реверберации в профессиональных приложениях

- •Сущность эффекта реверберации

- •История искусственной реверберации

- •Цифровые ревербераторы

- •Типы реверберации

- •Параметры реверберации

- •Управление реверберацией по MIDI

- •Способы практического использования

- •Компрессоры и компрессия

- •Оживление искусственных барабанов

- •Советы по эквализации музыкальных инструментов

- •Практика записи

будет воплощен. А во-вторых, процентов, этак, 90 возможностей звуковой карты вам будут просто недоступны. За что, спрашивается тогда, столько "у.е." платили?

Треки и клипы

У каждой из рассмотренных форм компьютерного представления музыки есть свои достоинства. Все вместе они позволяют эффективно решить любую проблему понотного редактирования. Но в любом музыкальном редакторе профессионального уровня музыкальная информация может быть представлена не только отдельными нотами или сообщениями, но и в виде блоков сообщений. Такими блоками могут считаться треки и клипы.

Трек - это группа сообщений, направляемая в определенный канал и порт вывода - MIDI или аудио. А клип - это группа сообщений, с которой можно производить операции редактирования, как с единым целым.

На рисунке вы видите окно Track программы Cakewak Pro Audio. Его левая часть - это секция треков. Для каждого их них нужно задать несколько атрибутов: номер и имя трека; его состояние (заглушен или звучит, солирует, подготовлен к записи); порты ввода и вывода; закрепленные MIDI-инструмент и MIDI-канал; громкость; панораму, интервал транспонирования, смещение событий относительно тактовой сетки.

Рис. 6. Окно Track программы Cakewak Pro Audio

Прямоугольники (вообще-то цветные) в правой части окна - клипы.

В одном предельном случае клип - это одно сообщение, в другом - вся композиция или как мы говорим, весь сонг. Но практическое применение находят только клипы, объединяющие в себе часть композиции. Примеры клипов:

•Один или несколько тактов нескольких треков

•Один трек

•Несколько треков

•Логически завершенный фрагмент композиции, скажем, куплет или припев

Технология клипов в сотни раз ускоряет работу компьютерного музыканта. В каких ситуациях? Например, записали вы 4 такта барабанной партии, выдели их в отдельный клип и путем копирования размножили клип так, что образовалась партия, насчитывающая десятки, а то и сотни тактов.

Или: записали один куплет и один припев песни, выделили это в клип и размножили в необходимом количестве экземпляров.

Еще один пример. Записали солирующую партию в исполнении фортепиано. Захотелось найти какой-то оригинальный тембр. Вот он - синтезированный звук плачущей флейты! Но у этого звука большое время атаки, он медленно нарастает. Создается впечатление запаздывания. Хорошо бы сделать так, чтобы ноты этой партии брались с небольшим опережением. Если вы не работаете с клипами, то станете передвигать каждую ноту, на что уйдет уйма времени. Да еще придется делать это не один раз. А вот после объединения партии в клип, все ноты вы сможете переместить одним легким движением руки с мышью.

И MIDI-, и аудиотреки в окне Track можно разбить на клипы. Клип можно скопировать, вырезать, мышью перенести в любое место партитуры. Можно применить к выделенному клипу любую обработку, MIDI или аудиоэффекты (о них я обязательно расскажу в будущем). Несколько клипов можно объединить в один.

Особенно интересна технология связанного копирования клипов, когда любое изменение в одном из связанных клипов автоматически распространяется на все остальные. Очень это удобно при редактировании однотипных фрагментов, скажем, куплетов.

Мы с вами, уважаемый читатель, хоть и компьютерные, но все же музыканты. Образные выражения в нашем общении допустимы. Поэтому скажу, что клипы и треки - это средство обзора композиции в целом, с высоты птичьего полета. Это не только наглядное графическое отображение структуры партитуры, но и возможность быстрого и легкого переноса партий и их фрагментов во времени и пространстве музыкального произведения.

Клипы и треки - это, по сути дела, инструменты дирижера. Причем, виртуальные оркестранты этому дирижеру подчиняются безоговорочно, замысел его понимают абсолютно и воплощают в музыке идеально.

Что такое трехмерный звук и почему по этому поводу возникает так много споров? Как

соотносится понятие "трехмерное, пространственное звучание" со способностью человека воспринимать звук двумя ушами? Эти вопросы часто задают себе как пользователи так и профессионалы. Дело в том, что повсеместное использование понятий 3D (3D графика, 3D звук) вносят сумятицу и неразбериху в головы простых пользователей. Зачастую эти понятия используются, мягко говоря, не совсем уместно, что вносит дополнительный раздор в их употребление и правильное понимание. 3D графика - тема не этой статьи. Здесь же мы остановимся на трехмерном звуке.

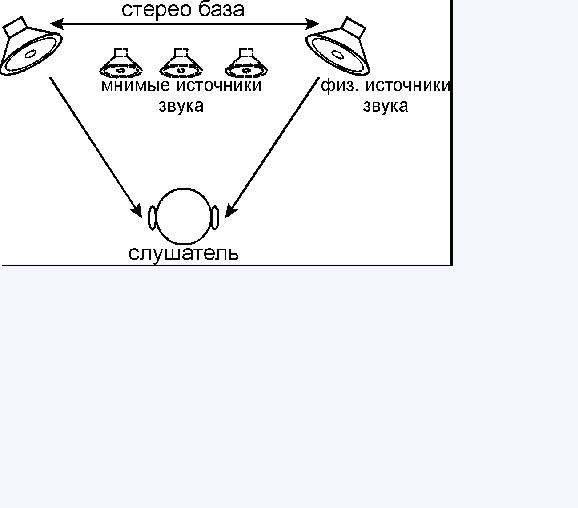

Реализация пространственного звучания (3D звука) в том или ином виде, применительно к компьютерной технике, используется для придания естественности звуку в компьютерных играх или фильмах, для создания полного ощущения погружения в процесс игры или просмотра фильма. Такая постановка задачи делает недостаточным использование обычного стереофонического звучания. Это связано с тем, что стерео сигнал, приходящий к слушателю от двух физических источников звука, не обеспечивает объемного звучания, а определяет расположение мнимых (слышимых) источников лишь в той плоскости, в которой расположены реальные (физические) источники звука. Кстати, как ни парадоксально, "stereophonic" на самом деле обозначает "трехмерный звук" (от греч. "stereos" - пространственный, трехмерный, цельный). Таким образом, обычного стерео сигнала не достаточно для создания полного реализма звучания, когда источники звука могут находиться в трехмерном пространстве. Также заблуждением является мысль, что объемное звучание обеспечивается квадрофонической системой (два источника перед слушателем и два сзади). Дело в том, что также, как и в стереофонической системе, здесь все четыре источника находятся в одной плоскости, что не позволяет создать полное ощущение трехмерного звучания.

В целом можно обозначить три основных способа реализации пространственного звучания:

расширение стерео базы (Stereo Expansion) - специальная обработка уже имеющегося стерео сигнала и, таким образом, расширение кажущегося звукового поля (имитация расширения расстояния между источниками);

позиционирование звучания (Positional 3D Audio) - оперирование с множеством отдельных звуковых потоков и расположение каждого из них в пространстве вокруг слушателя;

виртуальный (мнимый) окружающий звук (Virtual Surround Sound) - использование определенного числа звуковых потоков с целью воспроизведения истинного звучания с помощью ограниченного числа физических источников звука.

Что это все означает на практике? На практике это означает, что метод расширения стерео базы относительно прост в реализации и очень часто находит применение в стерео фонической бытовой технике. Однако, в той же степени, на сколько проста его реализация, сам метод не дает ощущения "трехмерного звучания" в том понимании, в котором мы его себе представляем, по причине обеспечения звучания лишь в одной плоскости. Не достаточно также и применения так называемого панорамирования. Панорамирование (panning) - это управление уровнем сигнала в каналах, в не зависимости от частоты сигнала. Панорамирование позволяет создавать иллюзию перемещения мнимого источника сигнала где-то между физическими источниками (разумеется, в одной с ними плоскости).

Для создания более или менее реалистичного объемного звучания необходимо что-то принципиально другое. Попытаемся в этом разобраться.

Как ни странно, но вся проблема в устройстве слухового аппарата человека. Оказывается, что он на столько не совершенен, что даже в реальной жизни мы можем столкнуться с трудностями, связанными с неточностью восприятия звуковых сигналов и определения их пространственного месторасположения. Все дело в том, что все мы живем на планете Земля и все время существования человека его основная пища и враги находились в плоскости, параллельной земле.

Поэтому, два уха, расположенные по обеим сторонам головы, позволяют нам определять расположение источников звука только лишь в горизонтальной плоскости (бинауральный эффект). При этом мы очень плохо различаем звук идущий спереди и сзади. Способность оценки человеческим ухом (слуховым аппаратом) расположения источников звука в вертикальной плоскости также крайне ограничена. Кроме того, тело слушателя, в частности, голова, уши и туловище, является, как известно, препятствием на пути распространения звуковых колебаний. Взаимодействуя с телом звук отражается, затухает и искажается, что приводит к восприятию слушателем не исходного, а измененного звучания. Все это создает трудности имитации пространственного звучания.

Что же происходит внутри нас? Приемником сигнала в человеке является барабанная перепонка, скрытая ушной раковиной. При восприятии звука, мозг как бы декодирует получаемый от барабанной перепонки сигнал, интерпретируя его определенным образом для правильного определения пространственного местоположения источника/ков звука. И именно это рассуждение взято в основу всех существующих на сегодня технологий создания пространственного звучания.

Оказывается, если произвести специальную обработку звукового потока с учетом максимального числа особенностей восприятия звука слуховым аппаратом, то, возможно, удастся имитировать пространственное звучание даже с использованием всего двух источников (колонок или наушников). Необходимо подчеркнуть, что любой алгоритм создания 3D звука реализовывается с помощью алгоритмов фильтрации (оперирующих с амплитудой и частотой звукового сигнала) той или иной сложности, которые определенным образом "обманывают" слуховой аппарат, "заставляя его считать", что то, что он слышит, расположено в трехмерном пространстве вокруг слушателя.

Одним из таких алгоритмов (способов) является HRTF - Head Related Transfer Function. Посредством этого алгоритма звук можно преобразовать специальным образом, что обеспечит прекрасное 3D звучание, рассчитанное на прослушивание в наушниках (пояснение этому можно найти чуть ниже). Следует отметить, что HRTF (в том или ином виде) является основой создания множества существующих на сегодня методов создания объемного звучания. Однако мы не даром заговорили о HRTF как об одном из алгоритмов, так как этот алгоритм в чистом виде (впрочем, как и все остальные) не является единственным и совершенным. Все дело в том, что HRTF неодинаков для различного слушателя и, тем более, для различных положений головы (если речь идет о воспроизведении не через наушники). Безусловно, есть способы найти сбалансированный HRTF для всех слушателей, но такой подход не обеспечивает высокочеткое восприятие звука для каждого, и уж тем более не решает проблему с поворотами головы. Наверное, именно поэтому стандарт на HRTF не существует до сих пор.

Конечно, если в качестве источников звука будут выступать наушники, закрепленные на голове слушателя, то их расположение относительно головы слушателя не будет изменяться, какие бы повороты головы не производились. В этом случае, как мы сказали, с использованием HRTF может быть достигнуто высококачественное пространственное звучание. В случае же, если источниками являются, например, две колонки, то, кроме всего прочего, для создания естественного пространственного звучания необходимо, в частности, точно отслеживать повороты слушателем головы для соответствующей корректировки сигналов от каждого физического источника. Кроме того, при воспроизведении звука через наушники, сигнал от каждого канала попадает только в соответствующее ухо, а при воспроизведении через колонки сигналы могут смешиваться, в результате чего появляются перекрестные искажения. Этот недостаток частично устраняется с помощью специального устройства - бифонического процессора.

Итак, как мы сказали выше, при использовании в качестве источников звука колонок, возникает проблема необходимости расположения слушателя строго в определенной области пространства между источниками звука. Эта область называется Sweet Spot. При отсутствии возможности контролировать положение слушателя в пространстве относительно источников звука при прочих равных условиях, Sweet Spot накладывает строгие ограничения на расположение слушателя. Это значит, что как только слушатель покидает область Sweet Spot, звучание, создаваемое источниками, перестает восприниматься слушателем как пространственное. Поэтому, при создании технологий объемного звучания перед разработчиками возникает проблема расширения области Sweet Spot.

Одним из эффективных методов решения этой проблемы является введение дополнительного третьего источника звука, когда слушатель становится независимым от области Sweet Spot. Трехканальные системы объемного звучания часто используются в бытовой аудио и видео аппаратуре. Существуют также многоканальные (трех-, четырех- и более) расширения этого метода.

Однако наряду с проблемами реализации трехмерного звучания с помощью HRTF, у любой системы звуковоспроизведения есть проблемы другого плана. Так, например, наушники слабо справляются с воспроизведением фронтальных сигналов. При использовании наушников также возникает проблема локализации звукового сигнала внутри головы слушателя, а также эффект бесконечного расширения стерео базы. Конечно, существуют способы борьбы с этими эффектами, однако всех проблем это не решает. Двухканальные системы плохо обеспечивают восприятие слушателем звучания сзади. В реализации многоканальных систем слабым местом является необходимость достаточно точного расположения источников сигнала, потому что как раз это зачастую сделать затруднительно. Кроме того, здесь также существует проблема звучания в одной плоскости.

Таким образом, создание настоящего качественного пространственного звучания затруднено как необходимостью учитывать все особенности слухового аппарата человека, так и необходимостью динамического отслеживания положения слушателя относительно источников звука, а также учета особенностей звукопередачи последних. По этому, сложно сказать, какая схема создания 3D звука более совершенна. Гораздо легче сказать, что все существующие схемы далеки от совершенства, и все технологии 3D звука, построенные на использовании HRTF или других алгоритмов, имеют массу недостатков, так как просто невозможно создать универсальную схему, учитывающую все вышеперечисленные особенности слуха, источников звука и их расположения относительно слушателя.

Вкачестве справки отметим, что для создания библиотек HRTF используется искусственный манекен KEMAR (Knowles Electronics Manikin for Auditory Research) или специальное "цифровое ухо".

Вслучае использования манекена суть измерений состоит в следующем. В уши манекена встраиваются микрофоны. Звук воспроизводится источниками, расположенными вокруг манекена, а запись производится с микрофонов. В результате, запись от каждого микрофона представляет собой звук, "прослушанный" соответствующим ухом манекена с учетом всех изменений, которые звук претерпел на пути к уху. Расчет HRTF производится с учетом исходного звука и звука, "услышанного" манекеном.

Следует сказать также, что мы рассмотрели лишь одну сторону реализации полноценного пространственного звучания. Дело в том, что на ряду со сложностями, связанными с "правильной" передачей объемности звучания, при создании игр возникают также проблемы корректной имитации различных физических свойств звука (эффектов отражения от различных поверхностей, поглощения и искажения звука). Грамотная реализация этих свойств также коренным образом влияет на ощущение слушателем пространственности звучания. Однако, эта проблема в основном касается аккуратности механизмов, закладываемых разработчиками в игры. Что же касается рассмотренной нами выше проблемы <донесения> трехмерного звука до пользователя (а вернее, до его нервной системы), то она остается не решенной, так как идеальные модели реализации трехмерного звучания еще не найдены.

Звуковое сопровождение компьютера всегда находилось несколько на втором плане. Большинство пользователей более охотно потратят деньги на новейший акселератор 3D графики, нежели на новую звуковую карту. Однако за последний год производители звуковых чипов и разработчики технологий 3D звука приложили немало усилий, чтобы убедить пользователей и разработчиков приложений в том, что хороший 3D звук является неотъемлемой частью современного мультимедиа компьютера. Пользователей убедить в пользе 3D звука несколько легче, чем разработчиков приложений. Достаточно расписать пользователю то, как источники звука будут располагаться в

пространстве вокруг него, т.е. звук будет окружать слушателя со всех сторон и динамично изменяться, как многие сразу потянутся за кошельком. С разработчиками игр и приложений сложнее. Их надо убедить потратить время и средства на реализацию качественного звука. А если звуковых интерфейсов несколько, то перед разработчиком игры встает проблема выбора. Сегодня есть два основных звуковых интерфейса, это DirectSound3D от Microsoft и A3D от Aureal. При этом, если разработчик приложения предпочтет A3D, то на всем аппаратном обеспечении DS3D будет воспроизводиться 3D позиционируемый звук, причем такой же, как если бы изначально использовался API DS3D. Само понятие "трехмерный звук" подразумевает, что источники звука располагаются в трехмерном пространстве вокруг слушателя. Это основа. Далее, чтобы придать звуковой модели реализм и усилить ощущения при восприятии звука слушателем, используются различные технологии, обеспечивающие воспроизведение реверберации, отраженных звуков, окклюзии (звук прошедший через препятствие), обструкции (звук не прошел через препятствие), дистанционное моделирование (вводится параметр удаленности источника звука от слушателя) и масса других интересных эффектов. Цель всего этого — создать у пользователя ощущение реальности звука и усилить впечатления от видеоряда в игре или приложении. Не секрет, что слух это второстепенное чувство человека, именно поэтому, каждый индивидуальный пользователь воспринимает звук по-своему. Никогда не будет однозначного мнения о звучании той или иной звуковой карты или эффективности той или иной технологии 3D звука. Сколько будет слушателей, столько будет мнений. В данной статье мы попытались собрать и обобщить информацию о принципах создания 3D звука, а также рассказать о текущем состоянии звуковой компьютерной индустрии и о перспективах развития. Мы уделим отдельное внимание необходимым составляющим хорошего восприятия и воспроизведения 3D звука, а также расскажем о некоторых перспективных разработках. Некоторые данные в статье рассчитаны на подготовленного пользователя, однако, никто не мешает пропустить нудные формулы тем, кому это не интересно или давно надоело в институте.

Итак, наверняка почти все слышали, что для позиционирования источников звука в виртуальном 3D пространстве используются HRTF функции. Ну что же, попробуем разобраться в том, что такое HRTF и действительно ли их использование так эффективно.

Сколько раз происходило следующее: команда разработчиков, отвечающая за звук, только что закончила встраивание 3D звукового движка на базе HRTF в новейшую игру; все комфортно расселись, готовясь услышать "звук окружающий вас со всех сторон" и "свист пуль над вашей головой"; запускается демо версия игры и… и ничего подобного вы просто не слышите!

HRTF (Head Related Transfer Function) это процесс, посредством которого наши два уха определяют слышимое местоположение источника звука; наши голова и туловище являются в некоторой степени препятствием, задерживающим и фильтрующим звук, поэтому ухо, скрытое от источника звука головой воспринимает измененные звуковые сигналы, которые при "декодировании" мозгом интерпретируются соответствующим образом для определения местоположения источника звука. Звук, улавливаемый нашим ухом, создает давление на барабанную перепонку. Для определения создаваемого звукового давления необходимо определить характеристику импульса сигнала от источника звука, попадающего на барабанную перепонку, т.е. силу, с которой звуковая волна от источника звука воздействует на барабанную перепонку. Эту зависимость называют Head Related Impulse Response (HRIR), а ее интегральное преобразование по Фурье называется HRTF.

Если вас интересует научное объяснение, то нет проблем, оно будет ниже. Если вас пугают формулы или вы их уже видеть не можете, просто пролистайте пару экранов вниз.

С точки зрения науки, правильнее характеризовать акустические источники скоростью распространения вещества в звуковой волне V(t), нежели давлением P(t), распространяемой звуковой волны. Теоретически, давление, создаваемой идеальным точечным источником звука бесконечно, но ускорение распространяемой звуковой волны есть величина конечная. Если вы достаточно удалены от источника звука и если вы находитесь в состоянии "free field" (т.е. в окружающей среде нет ничего кроме, источника звука и среды распространения звуковой волны), тогда давление "free field" (ff) на расстоянии "r" от источника звука определяется по формуле:

Pff(t) = Zo V(t - r/c) / r

где Zo это постоянная, называемая волновым сопротивлением среды (characteristic impedance of the medium), а "c" это скорость распространения звука в среде. Итак, давление ff пропорционально скорости в начальный период времени (происход "сдвиг" по времени, обусловленный конечной скоростью распространения сигнала, т.е. возмущение в этой точке описывается скоростью источника в момент времени, отстоящий на r/c - время которое затрачено на то, чтобы сигнал дошел до наблюдателя. В принципе не зная V(t) нельзя утверждать характера изменения скорости при сдвиге, т.е. произойдет замедление или ускорение) и уменьшается обратно пропорционально расстоянию от источника звука до точки наблюдения.

С точки зрения частоты, давление звуковой волны можно выразить так:

Pff(f) = Zo V(f) exp(- i 2 pi r/c) / r

где "f" это частота в герцах (Hz), i = sqrt(-1), а V(f) получается в результате применения преобразования Фурье к скорости распространения вещества в звуковой волне V(t). Таким образом, задержки при распространении звуковой волны можно охарактеризовать параметром, называемым "phase factor", т.е. фазовым коэффициентом exp(- i 2 pi r / c). Или, говоря словами, это означает, что функция преобразования в "free field" Pff(f) просто является результатом произведения масштабирующего коэффициента Zo, фазового коэффициента exp(- i 2 pi r /c) и обратно пропорциональна расстоянию 1/r. Заметим, что более рациональным будет использовать традиционную циклическую частоту, равную 2*pi*f, нежели просто частоту.

Если поместить в среду распространения звуковых волн человека, тогда звуковое поле вокруг человека искажается за счет дифракции (рассеивания или иначе говоря наблюдается различие скоростей распространения волн разной длины), отражения и дисперсии (рассредоточения) при контакте человека со звуковыми волнами. Теперь все тот же источник звука будет создавать несколько другое давление звука P(t) на барабанную перепонку в ухе человека. С точки зрения частоты это давление обозначим как P(f). Теперь, P(f), как и Pff(f) также содержит фазовый коэффициент, чтобы учесть задержки при распространении звуковой волны, при этом давление вновь ослабевает обратно пропорционально расстоянию. Для исключения этих концептуально незначимых эффектов HRTF функция H определяется как соотношение P(f) и Pff(f). Итак, строго говоря, H это функция, определяющая коэффициент умножения для значение давления звука, присутствующее в центре головы слушателя, если нет никаких объектов на пути распространения волны, по отношению к величине давления на барабанную перепонку в ухе слушателя.

Обратным преобразованием Фурье функции H(f) является функция H(t), представляющая собой HRIR (Head-Related Impulse Response). Таким образом, строго говоря, HRIR это коэффициент (он же есть отношение давлений, т.е. безразмерен; это просто удобный способ загнать в одну букву в формуле очень сложный параметр), который определяет воздействие на барабанную перепонку, когда звуковой импульс испускается источником звука, за исключением того, что мы сдвинули временную ось так, что t=0 соответствует времени, когда звуковая волна в "free field" достигнет центра головы слушателя. Также мы масштабировали результаты таким образом, что они не зависят от того, как далеко источник звука расположен от человека, относительно которого производятся все измерения.

Если вы готовы пренебречь этим временным сдвигом и масштабированием расстояния до источника звука, вы можете просто сказать, что HRIR это давление, воздействующее на барабанную перепонку, когда источник звука является импульсным.

Напомним, что интегральным преобразованием Фурье функции HRIR является HRTF функция. Если известно значение HRTF для каждого уха, мы можем точно синтезировать бинауральные сигналы от монофонического источника звука (monaural sound source). Соответственно, для разного положения головы относительно источника звука задействуются разные HRTF фильтры. Библиотека HRTF фильтров создается в результате лабораторных измерений, производимых с использованием манекена, носящего название KEMAR (Knowles Electronics Manikin for Auditory Research, т.е. манекен

Knowles Electronics для слуховых исследований) или с помощью специального "цифрового уха" (digital ear), разработанного в лаборатории Sensaura, располагаемого на голове манекена. Понятно,

что измеряется именно HRIR, а значение HRTF получается путем преобразования Фурье. На голове манекена располагаются микрофоны, закрепленные в его ушах. Звуки воспроизводятся через акустические колонки, расположенные вокруг манекена и происходит запись того, что слышит каждое

"ухо".

HRTF представляет собой необычайно сложную функцию с четырьмя переменными: три пространственных координаты и частота. При использовании сферических координат для определения расстояния до источников звука больших, чем один метр, считается, что источники звука находятся в дальнем поле (far field) и значение HRTF уменьшается обратно пропорционально расстоянию. Большинство измерений HRTF производится именно в дальнем поле, что существенным образом упрощает HRTF до функции азимута (azimuth), высоты (elevation) и частоты (frequency), т.е. происходит упрощение, за счет избавления от четвертой переменной. Затем при записи используются полученные значения измерений и в результате, при проигрывании звук (например, оркестра) воспроизводится с таким же пространственным расположением, как и при естественном прослушивании. Техника HRTF используется уже несколько десятков лет для обеспечения высокого качества стерео записей. Лучшие результаты получаются при прослушивании записей одним слушателем в наушниках.

Наушники, конечно, упрощают решение проблемы доставки одного звука к одному уху и другого звука к другому уху. Тем не менее, использование наушников имеет и недостатки. Например:

•Многие люди просто не любят использовать наушники. Даже легкие беспроводные наушники могут быть обременительны. Наушники, обеспечивающие наилучшую акустику, могут быть чрезвычайно неудобными при длительном прослушивании.

•Наушники могут иметь провалы и пики в своих частотных характеристиках, которые соответствуют характеристикам ушной раковины. Если такого соответствия нет, то восприятие звука, источник которого находится в вертикальной плоскости, может быть ухудшено. Иначе говоря, мы будем слышать преимущественно только звук, источники которого находится в горизонтальной плоскости.

•При прослушивании в наушниках, создается ощущение, что источник звука находится очень близко. И действительно, физический источник звука находится очень близко к уху, поэтому необходимая компенсация для избавления от акустических сигналов влияющих на определение местоположения физических источников звука зависит от расположения самих наушников.

Использование акустических колонок позволяет обойти большинство из этих проблем, но при этом не совсем понятно, как можно использовать колонки для воспроизведения бинаурального звука (т.е. звука, предназначенного для прослушивания в наушниках, когда часть сигнала предназначена для одного уха, а другая часть для другого уха). Как только мы подключим вместо наушников колонки, наше правое ухо начнет слышать не только звук, предназначенный для него, но и часть звука, предназначенную для левого уха. Одним из решений такой проблемы является использование техники cross-talk-cancelled stereo или transaural stereo, чаще называемой просто алгоритм crosstalk cancellation (для краткости CC).

Идея CC просто выражается в терминах частот. На схемы выше сигналы S1 и S2 воспроизводятся колонками. Сигнал Y1 достигающий левого уха представляет собой смесь из S1 и "crosstalk" (части) сигнала S2. Чтобы быть более точными, Y1=H11 S1 + H12 S2, где H11 является HRTF между левой колонкой и левым ухом, а H12 это HRTF между правой колонкой и левым ухом. Аналогично Y2=H21 S1 + H22 S2. Если мы решим использовать наушники, то мы явно будем знать искомые сигналы Y1 и Y2 воспринимаемые ушами. Проблема в том, что необходимо правильно определить сигналы S1 и S2, чтобы получить искомый результат. Математически для этого просто надо обратить уравнение:

На практике, обратное преобразование матрицы не является тривиальной задачей.

•При очень низкой частоте звука, все функции HRTF одинаковы и поэтому матрица является вырожденной, т.е. матрицей с нулевым детерминантом (это единственная помеха для тривиального обращения любой квадратной матрицы). На западе такие матрицы называют сингулярными. (К счастью, в среде отражающей звук, т.е. где присутствует реверберация, низкочастотная информация не являются важной для определения местоположения источника звука).

•Точное решение стремиться к результату с очень длинными импульсными характеристиками. Эта проблема становится все более и более сложной, если в дальнейшем искомый источник звука располагается вне линии между двумя колонками, т.е. так называемый фантомный источник звука.

•Результат будет зависеть от того, где находится слушатель по отношению к колонкам. Правильное восприятие звучания достигается только в районе так называемого "sweet spot", предполагаемого месторасположения слушателя при обращении уравнения. Поэтому, то, как мы слышим звук, зависит не только от того, как была сделана запись, но и от того, из какого места между колонками мы слушаем звук.

При грамотном использовании алгоритмов CC получаются весьма хорошие результаты, обеспечивающие воспроизведение звука, источники которого расположены в вертикальной и горизонтальной плоскости. Фантомный источник звука может располагаться далеко вне пределов линейного сегмента между двумя колонками.

Давно известно, что для создания убедительного 3D звучания достаточно двух звуковых каналов. Главное это воссоздать давление звука на барабанные перепонки в левом и правом ушах таким же, как если бы слушатель находился в реальной звуковой среде.

Из-за того, что расчет HRTF функций сложная задача, во многих системах пространственного звука (spatial audio systems) разработчики полагаются на использование данных, полученных экспериментальным путем, например, данные получаются с помощью KEMAR, о чем мы писали