otd

.pdf

Метод наибольшего правдоподобия дает решение, не требующее знания точных значений стоимости ошибок и вероятностей состояния, а только качественно отражающее их соотношение.

Тогда правило решения принимается следующим

x D , если |

f x0 |

/ D1 |

|

|

1 |

|

|||

f x0 |

/ D2 |

|

|||||||

1 |

|

|

|||||||

|

|

|

|||||||

x D , если |

f x / D1 |

|

|

1 , |

(3.22) |

||||

f x / D2 |

|

||||||||

2 |

|

|

|

||||||

|

|

|

|

||||||

то есть, граничное значение находится в точке пересечения кривых плотностей вероятностей из условия

f x |

/ D |

f x |

/ D |

|

0 |

1 |

0 |

2 |

|

C P |

|

12 |

2 |

C |

P |

21 |

1 |

.

1

(3.23)

Условие (3.23) можно использовать, когда заранее известно, что

С12 С21, |

Р1 Р2. |

Вусловиях работы подвижного состава бывает очень сложно дать количественную оценку последствий пропуска дефекта. В то же время ложная тревога поддается более точной оценке потерь, связанных в нашем случае с обнаружением ошибки в принятии решения. Более того, можно определить допустимый уровень частоты появления ложной тревоги, не влияющий существенно на работу транспорта в целом.

Вданном случае полезно использовать метод Неймана-Пирсона, в

соответствии с которым минимизируется вероятность пропуска цели

(дефекта).

Если задан максимально допустимый уровень вероятности ложной тревоги L, то условием наименьшей вероятности пропуска дефекта будет:

1 |

|

1 |

.dx L. |

|

|

|

|||

P |

|

f x / D |

(3.24) |

xo

Условие (3.24) однозначно определяет величину xо для заданного уровня вероятности ложной тревоги L.

В ряде случаев можно исходить из заданного значения вероятности пропуска дефекта F и минимизировать вероятность ложной тревоги:

х |

|

|

P2 о |

f x / D2 .dx F . |

(3.25) |

4.ДИАГНОСТИЧЕСКАЯ ИНФОРМАЦИЯ

4.1.Оценка количества диагностической информации

Средства технического диагностирования (СТД) предназначены для получения информации о техническом состоянии объекта и основной характеристикой СТД является объем или количество получаемой информации.

Диагностическими параметрами называются элементы множества параметров объекта, содержащие информацию о неисправностях, над которыми установлены наблюдение и контроль. Существует различие между множествами параметров объекта и диагностическими параметрами. В отличие от параметров, образующих множество выходных величин, состав которого обычно не определен и не постоянен, на множество диагностических параметров накладываются дополнительные ограничения: эти параметры должны быть достаточно информативными и, кроме того, доступными для

измерения или наблюдения.

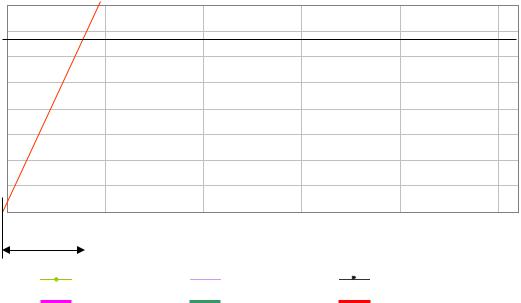

Начнем с нашего примера. При следовании поезда он проходит с установленной скоростью N постов контроля перегрева букс К.

температура,гр С

80 70 60 50 40 30 20 10

0

0

т

|

|

|

|

|

|

|

|

|

50 |

100 |

3т |

150 |

200 |

250 |

|

|

|

|

время,мин |

|

|

||

ось_цил |

|

корп_верх_цил |

корп_низ_цил |

|

|||

корп_верх_кон |

|

корп_низ_кон |

ось_кон |

|

|||

Рисунок 6 – Графики избыточных температур элементов буксового узла при стендовых испытаниях конического и цилиндрических подшипников в стандартном корпусе буксы (выход на стационарный режим теплового состояния)

Температура подшипника растет по экспоненциальному закону при условии неизменного тепловыделения, то есть для определенного технического состояния подшипника. Через время 3т практически наступает установившийся режим. В аварийном режиме эта зависимость неопределима, и зависит от характера разрушения, дефекта.

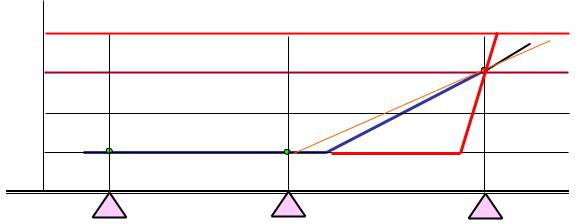

С |

|

40 |

|

30 |

N |

|

|

20 |

|

N-2 |

N-1 |

10 |

|

L

K |

KN-1 |

K |

N-2 |

|

N |

На посту контроля КN от датчика перегрева корпуса буксы поступило сообщение о перегреве одной из букс в проходящем поезде на

N = 30 C. Такой уровень перегрева допустим для участковой станции, но является пороговым перед ПТО сортировочной станции (по методу НейманаПирсона)

Вто же время поступило второе сообщение о сравнении измеренной температуры

стемпературой этой же буксы N-1= N-2 =10 C при прохождении предыдущих

постов контроля КN-1 и КN-2, в результате зарегистрирован прирост температуры перегрева на = +20 C.

Рассмотрим, какое из этих сообщений несет больше диагностической информации. Как мы уже убедились ранее, вероятность правильного решения на основании

данных о перегреве корпуса буксы на = 30 C равна 0,72.

Второе сообщение определяет не только о вероятность наличия дефекта в буксовом подшипнике, но и однозначно свидетельствует о его интенсивном развитии

и невозможности дальнейшего следования поезда. По второму сообщению можем принимать вероятность наличия опасного дефекта

близкую 1, например, равную 0,99.

Очевидно, что второе сообщение несет больше информации, так как практически полностью устраняет неопределенность состояния объекта. На основании данных соображений дается определение:

величина информации – разность неопределенностей (энтропий) системы до и после получения информации.

Некоторые определения, относящиеся к информации:

Информация - совокупность сведений об объекте, рассматриваемая с позиций передачи этих сведений в пространстве и во времени.

Сообщение - это информация, выраженная в определенной форме и предназначенная для передачи от источника к пользователю (тексты, фото, речь, музыка, телевизионное изображение и др.).

Сигнал - это физический процесс, распространяющийся в пространстве и времени, параметры которого способны отображать (содержать) сообщение.

Понятие энтропии статистической системы

В общем случае энтропия характеризует состояния и возможные изменения состояний материальных систем, в термодинамике – тепловое состояние вещества.

Теория информации возникла с развитием технических средств связи и изучает методы передачи сообщений как связь статистических систем. Передача какого-либо сообщения, состоящего из последовательности элементов, это случайный процесс, так как получатель может ожидать любую из возможных последовательностей элементов (букв, цифр, знаков, символов).

В диагностике изучается связь между системой состояний и

системой признаков.

Мы будем рассматривать системы, в которых одно из состояний обязательно реализуется, а два или более состояний одновременно

невозможны. Рассмотрим систему А, имеющую n возможных состояний с |

|

вероятностями Р(А1), Р(А2),…, Р(Аn), при этом очевидно, что |

|

n |

|

P Ai . 1 |

(4.1) |

i 1

Энтропия (степень неопределенности) системы А в теории информации определяется выражением:

n |

1 |

|

n |

|

H A P Ai log |

|

P Ai log P.Ai (4.2) |

||

|

|

|||

P Ai |

||||

i 1 |

i 1 |

|||

Энтропия системы А зависит от числа возможных состояний n (бросание

монеты или кубика) и от соотношения вероятностей Р(Аi) того или другого состояния.

Энтропию нагляднее представить с помощью двоичных логарифмов, при этом в качестве единицы энтропии принимается степень неопределенности системы, имеющей два равновероятных состояния (бросание монеты)

Р(А1) = Р(А2) = 0,5. Тогда по формуле (4.2)

H A P A1 log2 |

P A1 P A2 log2 |

P A2 |

|||||||||

|

1 |

log |

|

1 |

|

1 |

log |

|

1 |

1бит. |

(4.3) |

|

2 |

|

|

2 |

|

||||||

2 |

|

2 |

2 |

|

2 |

|

|

||||

|

|

|

|

|

|

||||||

Бит – единица энтропии, которая соответствует степени неопределенности системы, имеющей два возможных равновероятных состояния. Название бит происходит от английских слов binary digit (двоичная единица)

Основные свойства энтропии.

1) Если система А имеет одно из возможных состояний Аk с вероятностью Р(Аk) = 1, то энтропия такой системы Н(А) = 0.

2) Энтропия системы, имеющей n равновероятных состояний равна логарифму числа состояний: 1

Р(Аi) = n

Н(А)=n

1 n

. log2n=log2n

(4.4)

3) Если система А имеет n возможных состояний, то энтропия будет максимальной, когда все состояния равновероятны. Из этого свойства следует, что для произвольной системы всегда соблюдается условие

H A log 2 n |

(4.5) |

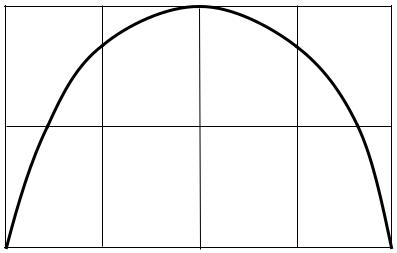

В задачах технической диагностики часто встречаются системы с двумя возможными состояниями, которые называют бинарной системой. Если для бинарной системы вероятность первого состояния равна Р, то второго

1 – Р. Для наглядности на рис. 4.2 представлена зависимость энтропии

бинарной системы от вероятности одного из состояний Р2=1- Р1, а энтропия

Н Р log |

2 |

P (1 Р ) log |

2 |

(1 Р ) |

|

1 |

1 |

1 |

. 1 |

||

Р1. При этом

(4.6)

H

0,5

0 |

0,5 |

Р1 |

Рис. 4.2. Зависимость энтропии бинарной системы от вероятности первого состояния.