- •Экзаменационный билет №1

- •1. Статистические свойства квадратурных компонент случайного узкополосного гауссова сигнала, его огибающей и фазы.

- •Экзаменационный билет №2

- •1. Модели и классификация каналов телекоммуникаций. Каналы связи с помехами. Понятие переходной вероятности канала. Вероятностные характеристики дискретного симметричного канала без памяти.

- •Экзаменационный билет №3

- •1. Оптимальный прием сигналов на фоне помех. Критерий идеального наблюдателя. Структурная схема идеального приемника Котельникова.

- •Экзаменационный билет №4

- •1. Вероятностные характеристики случайных сигналов. Физический смысл дисперсии и акф эргодического сигнала.

- •Экзаменационный билет №6

- •1. Плотность распределения вероятности мгновенных значений случайного сигнала: возможные графики одномерной прв, двумерная, многомерная.

- •2. Согласованный фильтр. Импульсная характеристика согласованного фильтра и ее связь с временной формой согласованного с ней сигнала. Описание и форма сигнала на выходе согласованного фильтра.

- •Экзаменационный билет №7

- •Математическая модель узкополосного случайного сигнала в виде комплексного колебания.

- •Экзаменационный билет №8

- •1. Корреляционная функция случайного процесса. Определение и основные свойства, формулы расчета для дискретных сигналов, для эргодических непрерывных сигналов.

- •Экзаменационный билет №9

- •1. Определение количества информации по Шеннону. Энтропия источника случайных сообщений. Свойства энтропии. Энтропия двоичного источника.

- •2. Корреляционная функция стационарного эргодического случайного сигнала. Формула расчета и физический смысл интервала корреляции.

- •Экзаменационный билет №10

- •Понятие спектральной плотности мощности случайного сигнала.

- •Теорема Винера-Хинчина.

- •Принцип помехоустойчивого кодирования канала.

- •Экзаменационный билет №11

- •1. Количественное измерение информации. Энтропия дискретного источника и ее свойства. Энтропия двоичного источника.

- •2. Дисперсия случайного сигнала. Определение, формулы расчета для дискретных и непрерывных сигналов, физический смысл дисперсии, единицы измерения.

- •Алгоритм работы и структурная схема когерентного корреляционного приемника бинарных сигналов:

- •Экзаменационный билет №13

- •1. Понятие случайного сигнала «белый шум». Спектральная плотность мощности и корреляционная функция «белого» и небелого шума. Понятие квазибелого шума.

- •2. Структура сверточного кодера, как цифрового фильтра. Диаграмма состояний сверточного кодера, как конечного автомата. Импульсная характеристика сверточного кодера и порядок ее расчета.

- •Экзаменационный билет №14

- •Плотность распределения вероятности мгновенных значений узкополосного случайного сигнала.

- •Экзаменационный билет №15

- •Экзаменационный билет №16

- •Автокорреляционная функция (акф) – второй смешанный центральный момент двумерной плотности распределения вероятностей; центральный смешанный момент второго порядка.

- •Экзаменационный билет №18

- •1. Синтез оптимального приемника на согласованных фильтрах. Алгоритм работы и структура оптимального приемника на согласованных фильтрах для бинарных сигналов.

- •2. Эффективное кодирование источника. Словарное кодирование. Алгоритм Лемпеля-Зива. Порядок составления словаря и порядок формирования кодовых символов для передачи по каналу.

- •Экзаменационный билет №20

- •1. Формирователь модулирующих символов (фмс) для сигналов кам16. Сигнальное созвездие кам-16. Понятие о коде Грея.

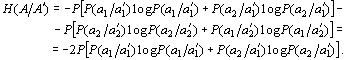

- •Условная энтропия между входом и выходом в канале и взаимная информация входа и выхода

- •Экзаменационный билет №21Классификация случайных сигналов по виду закона распределения. Нормальный закон: формула одномерной прВинтеграл вероятности

- •Экзаменационный билет №22

- •2. Модели непрерывных каналов с аддитивным шумом: с постоянными параметрами, с неопределенной фазой, с общими и частотно-селективными замираниями.

- •Экзаменационный билет №23

- •1. Блочный код Хэмминга (7,4). Структура проверочной матрицы для систематического кода. Принцип кодирования с использованием проверочной матрицы.

- •Экзаменационный билет №24

- •1. Блочный код Хэмминга (7,4). Проверочная матрица систематического кода и получение синдрома кодового слова. Принцип синдромного декодирования систематического блокового кода.

- •2. Модели дискретных каналов. Математическое описание несимметричного канала без памяти и канала с памятью. Принцип относительной фазовой модуляции. Исключение обратной работы демодулятора.

- •Экзаменационный билет №25

- •1. Импульсная характеристика линейной системы. Свертка сигнала и импульсной характеристики. Формулы свертки для непрерывных и дискретных сигналов. Порядок выполнения дискретной циклической свертки.

- •Экзаменационный билет №26

- •1. Особенности преобразования сигналов в параметрических цепях и системах. Параметрическое преобразование частоты. Принцип работы супергетеродинного приемного устройства. Понятие зеркальной частоты.

- •2. Статистические свойства квадратурных компонент случайного узкополосного сигнала. Статистические свойства огибающей и фазы узкополосного случайного сигнала.

- •Экзаменационный билет №27

- •1. Усреднение по ансамблю реализаций, усреднение по времени: формулы расчета для дискретных и непрерывных случайных сигналов. Эргодические случайные сигналы.

- •1. Критерий минимального среднего риска.

- •2. Критерий максимального правдоподобия (критерий мп).

- •3. Критерий идеального наблюдателя.

- •4. Критерий Неймана-Пирсона.

- •Экзаменационный билет №28

- •Возможные доп. Вопросы:

- •22 Билет) а нахуя нам каноническая матрица

Экзаменационный билет №11

1. Количественное измерение информации. Энтропия дискретного источника и ее свойства. Энтропия двоичного источника.

Ряд задач теории информации относится к определению объема запоминающих устройств, предназначенных для хранения информации. Для решения таких задач нужно научиться измерять количественно объем информации, пропускную способность линии связи и их чувствительность к помехам. Т.О., теория информации представляет собой математическую теорию, посвященную измерению количества информации, преобразованию информации, передаче информации по линиям связи, изучению методов построения различных кодов, и пр.

Энтропия дискретного источника и ее свойства.

На практике встречаются системы, состояния которых непрерывно переходят одно в другое. Для таких систем распределение вероятностей характеризуется плотностью. Такие системы будем называть непрерывными системами.

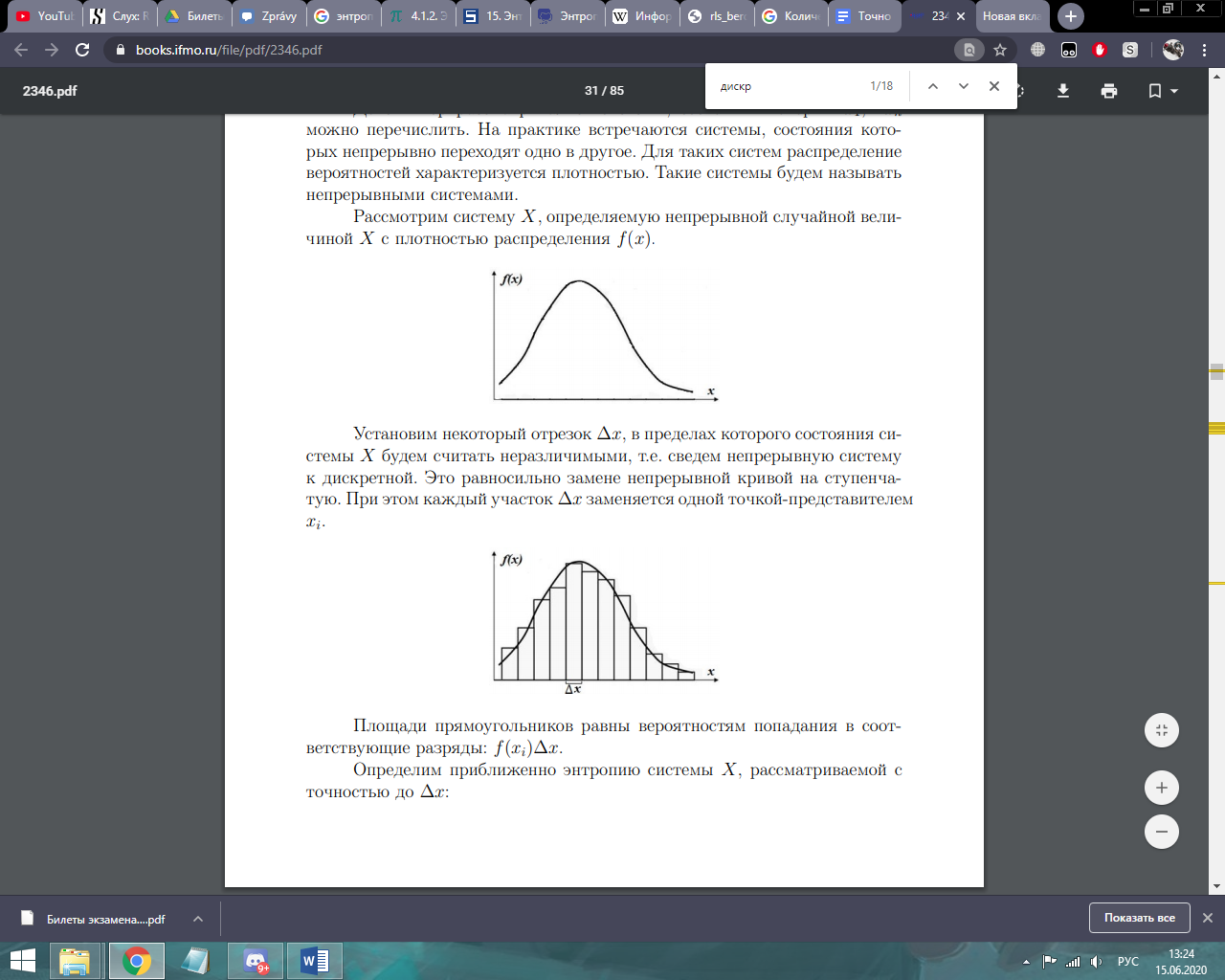

Рассмотрим систему X, определяемую непрерывной случайной величиной X с плотностью распределения f(x).

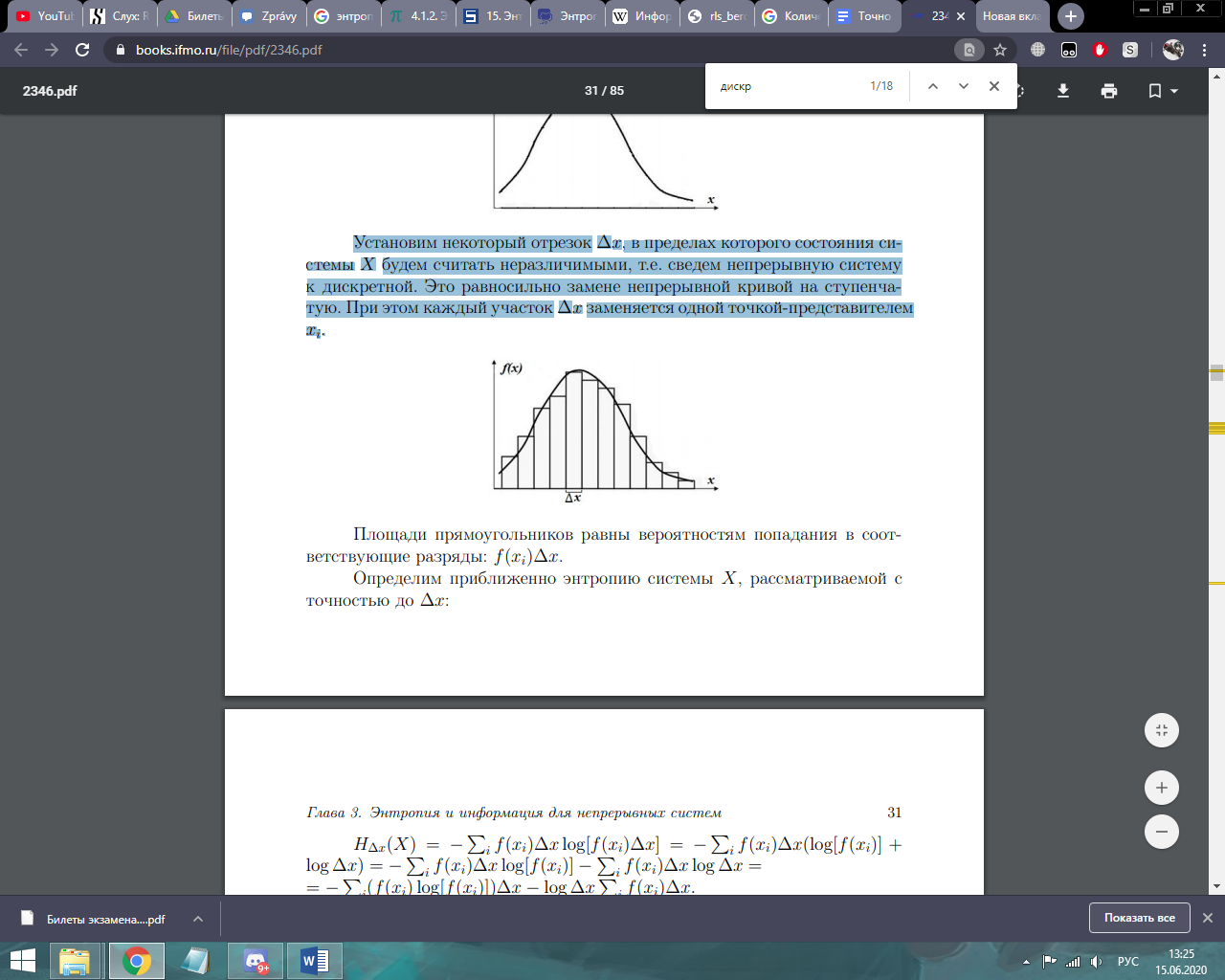

Установим некоторый отрезок ∆x, в пределах которого состояния системы X будем считать неразличимыми, т.е. сведем непрерывную систему к дискретной. Это равносильно замене непрерывной кривой на ступенчатую. При этом каждый участок ∆x заменяется одной точкой-представителем xi .

Определим приближенно энтропию системы X рассматриваемой с точностью до дельта x

Свойства:

1) Энтропия

— неотрицательное вещественное число.

Н(A) ≥ 0 Прямое следствие того, что 0≤ pi≤

1,i=1,...,N и свойств функции

![]() .

.

2) Энтропия равна 0, если с вероятностью, равной единице, всегда выбирается один и тот же символ.

3) Энтропия максимальна, если все символы источника сообщений появляются независимо и равновероятно.

![]() ;

H - энтропия, p(a) вероятность символа.

;

H - энтропия, p(a) вероятность символа.

4) Энтропия аддитивна (энтропия нескольких независимых источников равна сумме энтропий этих источников)

Энтропия двоичного источника.

Случай независимых равновероятных символов

Вероятности: P(a1)=P(a2)=P=0.5 , условные вероятности равны нулю. Энтропия такого источника максимальна:

Hmax=-0.5 * log(0.5)- 0.5 * log(0.5) = log(2) = 1 бит/символ

Таким образом, 1 бит - это максимальное среднее (ANAL) - количество информации, которое может переносить один символ источника двоичных сообщений.

Случай независимых неравновероятных символов

Вероятности: P(a1)=P ; P(a2)=1-P условные вероятности равны нулю. Энтропия такого источника равна: H(P)=-P * log(P) - (1-P) * log(1-P)

Эта зависимость показана ниже на рисунке. Максимум энтропии достигается при P=0.5. Поскольку H(p)< Hmax при P!=0.5, то производительность такого источника меньше максимальной.

Рис. Энтропия двоичного источника сообщений с неравновероятными символами

Случай коррелированных равновероятных символов

Вероятности: P(a1)=P(a2)=P=0.5 , условные вероятности равны отличны от нуля:

![]()

Условная

энтропия с учетом соотношения

![]()

равна:

Где

где![]() - условная вероятность появления символа

- условная вероятность появления символа

![]() после символа

после символа

![]()

Например,

если

![]() , то

, то

![]()

При некоррелированных равновероятных символах двоичного источника энтропия равна 1 бит/симв. Следовательно, наличие статистических связей между символами приводит к уменьшению энтропии и увеличению избыточности источника.