- •Экзаменационный билет №1

- •1. Статистические свойства квадратурных компонент случайного узкополосного гауссова сигнала, его огибающей и фазы.

- •Экзаменационный билет №2

- •1. Модели и классификация каналов телекоммуникаций. Каналы связи с помехами. Понятие переходной вероятности канала. Вероятностные характеристики дискретного симметричного канала без памяти.

- •Экзаменационный билет №3

- •1. Оптимальный прием сигналов на фоне помех. Критерий идеального наблюдателя. Структурная схема идеального приемника Котельникова.

- •Экзаменационный билет №4

- •1. Вероятностные характеристики случайных сигналов. Физический смысл дисперсии и акф эргодического сигнала.

- •Экзаменационный билет №6

- •1. Плотность распределения вероятности мгновенных значений случайного сигнала: возможные графики одномерной прв, двумерная, многомерная.

- •2. Согласованный фильтр. Импульсная характеристика согласованного фильтра и ее связь с временной формой согласованного с ней сигнала. Описание и форма сигнала на выходе согласованного фильтра.

- •Экзаменационный билет №7

- •Математическая модель узкополосного случайного сигнала в виде комплексного колебания.

- •Экзаменационный билет №8

- •1. Корреляционная функция случайного процесса. Определение и основные свойства, формулы расчета для дискретных сигналов, для эргодических непрерывных сигналов.

- •Экзаменационный билет №9

- •1. Определение количества информации по Шеннону. Энтропия источника случайных сообщений. Свойства энтропии. Энтропия двоичного источника.

- •2. Корреляционная функция стационарного эргодического случайного сигнала. Формула расчета и физический смысл интервала корреляции.

- •Экзаменационный билет №10

- •Понятие спектральной плотности мощности случайного сигнала.

- •Теорема Винера-Хинчина.

- •Принцип помехоустойчивого кодирования канала.

- •Экзаменационный билет №11

- •1. Количественное измерение информации. Энтропия дискретного источника и ее свойства. Энтропия двоичного источника.

- •2. Дисперсия случайного сигнала. Определение, формулы расчета для дискретных и непрерывных сигналов, физический смысл дисперсии, единицы измерения.

- •Алгоритм работы и структурная схема когерентного корреляционного приемника бинарных сигналов:

- •Экзаменационный билет №13

- •1. Понятие случайного сигнала «белый шум». Спектральная плотность мощности и корреляционная функция «белого» и небелого шума. Понятие квазибелого шума.

- •2. Структура сверточного кодера, как цифрового фильтра. Диаграмма состояний сверточного кодера, как конечного автомата. Импульсная характеристика сверточного кодера и порядок ее расчета.

- •Экзаменационный билет №14

- •Плотность распределения вероятности мгновенных значений узкополосного случайного сигнала.

- •Экзаменационный билет №15

- •Экзаменационный билет №16

- •Автокорреляционная функция (акф) – второй смешанный центральный момент двумерной плотности распределения вероятностей; центральный смешанный момент второго порядка.

- •Экзаменационный билет №18

- •1. Синтез оптимального приемника на согласованных фильтрах. Алгоритм работы и структура оптимального приемника на согласованных фильтрах для бинарных сигналов.

- •2. Эффективное кодирование источника. Словарное кодирование. Алгоритм Лемпеля-Зива. Порядок составления словаря и порядок формирования кодовых символов для передачи по каналу.

- •Экзаменационный билет №20

- •1. Формирователь модулирующих символов (фмс) для сигналов кам16. Сигнальное созвездие кам-16. Понятие о коде Грея.

- •Условная энтропия между входом и выходом в канале и взаимная информация входа и выхода

- •Экзаменационный билет №21Классификация случайных сигналов по виду закона распределения. Нормальный закон: формула одномерной прВинтеграл вероятности

- •Экзаменационный билет №22

- •2. Модели непрерывных каналов с аддитивным шумом: с постоянными параметрами, с неопределенной фазой, с общими и частотно-селективными замираниями.

- •Экзаменационный билет №23

- •1. Блочный код Хэмминга (7,4). Структура проверочной матрицы для систематического кода. Принцип кодирования с использованием проверочной матрицы.

- •Экзаменационный билет №24

- •1. Блочный код Хэмминга (7,4). Проверочная матрица систематического кода и получение синдрома кодового слова. Принцип синдромного декодирования систематического блокового кода.

- •2. Модели дискретных каналов. Математическое описание несимметричного канала без памяти и канала с памятью. Принцип относительной фазовой модуляции. Исключение обратной работы демодулятора.

- •Экзаменационный билет №25

- •1. Импульсная характеристика линейной системы. Свертка сигнала и импульсной характеристики. Формулы свертки для непрерывных и дискретных сигналов. Порядок выполнения дискретной циклической свертки.

- •Экзаменационный билет №26

- •1. Особенности преобразования сигналов в параметрических цепях и системах. Параметрическое преобразование частоты. Принцип работы супергетеродинного приемного устройства. Понятие зеркальной частоты.

- •2. Статистические свойства квадратурных компонент случайного узкополосного сигнала. Статистические свойства огибающей и фазы узкополосного случайного сигнала.

- •Экзаменационный билет №27

- •1. Усреднение по ансамблю реализаций, усреднение по времени: формулы расчета для дискретных и непрерывных случайных сигналов. Эргодические случайные сигналы.

- •1. Критерий минимального среднего риска.

- •2. Критерий максимального правдоподобия (критерий мп).

- •3. Критерий идеального наблюдателя.

- •4. Критерий Неймана-Пирсона.

- •Экзаменационный билет №28

- •Возможные доп. Вопросы:

- •22 Билет) а нахуя нам каноническая матрица

Экзаменационный билет №3

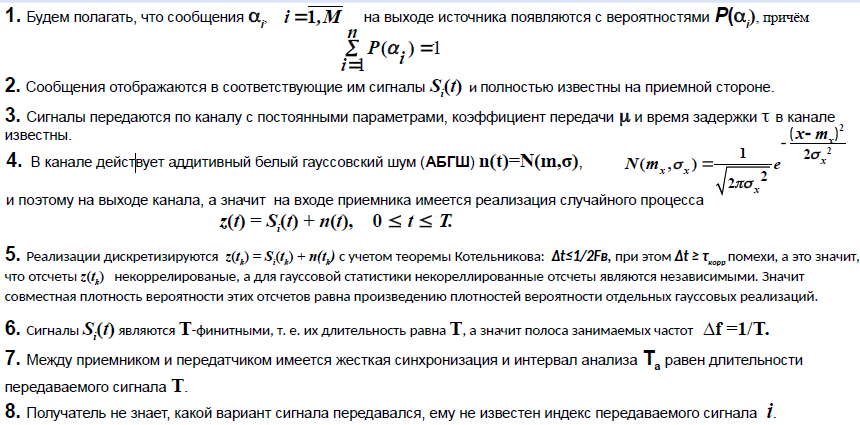

1. Оптимальный прием сигналов на фоне помех. Критерий идеального наблюдателя. Структурная схема идеального приемника Котельникова.

Оптимальный приём на фоне помех.

Оптимальный приемник (оптимальное правило решения) обеспечивает наилучшее качество решения, то есть обеспечивает минимум искажений переданного сообщения в соответствии с мерой качества, заданной потребителем.

Оптимальное значение меры качества, которое достигается приемником в процессе оптимизации, называется критерием оптимальности приема.

Критерий идеального наблюдателя.

Если

весовые коэффициенты (кол-во

ненулевых значений)

П12 = П21=1 (Где П функции потерь), то критерий

минимального среднего риска минимизирует

среднюю вероятность ошибки:

![]() и

называется критерием

идеального наблюдателя.

и

называется критерием

идеального наблюдателя.

Критерий идеального наблюдателя широко применяется в системах связи, когда искажения любого сигнала одинаково нежелательны и совпадает с критерием Максимального Правдоподобия, если вероятности сигналов Р(S1) = P(S2) = 0,5.

Структурная схема идеального приемника Котельникова.

Где, “минус” - вычитающее устройство; “S1(t)” , “S2(t)” генераторов опорных сигналов, “Кв” - квадратор, “Интеграл” - интегратор, “В”- выравнивающие устройства

P.S. сигма – среднее квадратичное отклонение

2. Дать определение энтропии и привести ее свойства. Рассчитать энтропию дискретного источника, если р1=0.4, р2= 3=0.1, р4=0,08, р5=0,07.

Среднее количество информации определяется как математическое ожидание количества информации в сообщении:

где Ма — количество возможных сообщений источника. Н(А) – энтропией источника и характеризует среднее количество информации приходящейся на одно сообщение.

Свойства:

1. Энтропия — неотрицательное вещественное число. Н(A) ≥ 0 Прямое следствие того, что 0 <= 𝑝𝑖 <= 1,𝑖=1,...,𝑁 и свойств функции y=log2𝑥.

2. Энтропия равна 0, если с вероятностью, равной единице, всегда выбирается один и тот же символ.

3. Энтропия максимальна, если все символы источника сообщений появляются независимо и равновероятно. 𝐻𝑚𝑎𝑥(А)= 𝑙𝑜𝑔 𝑁 при 𝑝(𝑎1)=𝑝(𝑎2)=...=𝑝(𝑎𝑛); H - энтропия, p(a) вероятностЕь символа.

4. Энтропия аддитивна (энтропия нескольких независимых источников равна сумме энтропий этих источников)

р1=0.4, р2=0.35, р3=0.1, р4=0,08, р5=0,07

Определим энтропию источника по формуле:

H(A)=0.528771+0.530101+0.332193+0.291508+0.268555= 1.951128 [бит]

Экзаменационный билет №4

1. Вероятностные характеристики случайных сигналов. Физический смысл дисперсии и акф эргодического сигнала.

Вероятностные характеристики случайных сигналов.

Для практических целей наиболее важными являются следующие вероятностные характеристики стационарных эргодических сигналов, имеющих длительность реализации Т:

- среднее значение (математическое ожидание). Оно характеризует постоянную составляющую сигнала

; (1)

- средняя мощность. Она характеризует средний уровень сигнала

; (2)

- дисперсия, характеризующая среднюю мощность переменной составляющей сигнала:

; (3)

- среднеквадратическое отклонение (СКО)

![]()

; (4)

- функция распределения, которая определяется как интегральная вероятность того, что значение xi(tj) в j-й момент времени будут ниже некоторых значений X:

Физический смысл: дисперсии заключается в том, что она является средней мощностью флуктуаций (любое случайное отклонение какой-либо величины) случайного сигнала, воздействующего на сопротивление в 1 ОМ.

![]()

Коэффициент корреляции приобретает ясный физический смысл, если статистические переменные центрировать (вычесть математическое ожидание) и нормировать на величину среднеквадратического отклонения. Поскольку среднеквадратические отклонения нормированных величин равны единице, то коэффициент корреляции становится равен тангенсу наклона линии среднеквадратической регрессии.

2. Постановка задачи синтеза оптимального приемника дискретных сообщений. Пояснить как из критерия Байеса (минимум среднего риска) получается критерий оптимальности максимума правдоподобия.

Критерий оптимальности максимум правдоподобия получается из критерия минимального среднего риска при условии, что потери при совершении ошибки обратно пропорциональны вероятности их совершения. При этом порог оптимального обнаружителя выставляется таким образом, чтобы минимизировать сумму вероятностей ошибок.

Экзаменационный билет №5

1. Функция распределения вероятности мгновенных значений случайного сигнала: определение, график для одномерной ФРВ, двумерная, многомерная.

Функция распределения F(x) показывает вероятность нахождения случайной величины в пределах F(x)=P(X≤x). Безразмерна.

•Одномерная – F(х,ti) = P(X(ti)≤х)

•Двумерная – F2 (х1,х2; t1,t2) = P(X(t1)≤х1; X(t2)≤х2;)

•Многомерная – FN(х1,х2,…,хN; t1,t2,…,tN) = P(X(t1)≤х1; X(t2)≤х2;…; X(tN)≤хN)

Одномерная фрв

++

++

2. Пропускная способность канала, формула расчета пропускной способности гауссовского канала (формула Шеннона) . Физический смысл всех составляющих формулы.

ШУМАКОВ:Если мы используем передачу аналогового или цифрового сигнала, то у него есть спектр, у которого есть макс верхняя частота fв. Тогда если нам нужно передать сигнал по каналу связи, то канал должен передать все частоты без искажений, в этом случае информацию можно будет извлечь с минимальными потерями; Отсюда вытекает

1)Полоса пропускания канала должна пропускать в себе параметр ЧХ канала, которая должна превышать область частот, АЧХ канала не должна искажать Спектральные компоненты канала. ППК определяется, по уровню 0.707 от максимальной частоты (fв)

2) Все сигналы передаваемые через канал модулированные -> имеется несущее колебание синусоида, частота.

Если в канале есть сигнал (S), то он обладает энергией, помимо его самого (сигнала) существует помеха обычно “гауссова помеха”, в таком случае диапазон делим на 6 частей, находим мощность помехи, а это есть дисперсия, если помеха имеет небольшой уровень сред квадр. откл, то можно забить на нее хуй.

На пропускную способность канала влияет черное отношение сигнал/помеха

откуда следует формула Шеннона [бит/секунда] С=Fканала*log2(1+ (Pсигнала/Pпомеха))

чем выше отношение с/п тем больше Полоса Пропускания ->

чем выше(шире) ПП, тем больше пропускная способность канала

ЭТО

УЖЕ НАША ДРОЧЬ: Подытожим максимальное

количество информации, которое можно

в принципе передать по данному дискретному

каналу за один входной символ называют

информационной емкостью или пропускной

способностью канала:

![]()

Пропускная способность C – фундаментальный параметр канала, определяющий его потенциальные возможности в части надежной передачи информации.++