- •Экзаменационный билет №1

- •1. Статистические свойства квадратурных компонент случайного узкополосного гауссова сигнала, его огибающей и фазы.

- •Экзаменационный билет №2

- •1. Модели и классификация каналов телекоммуникаций. Каналы связи с помехами. Понятие переходной вероятности канала. Вероятностные характеристики дискретного симметричного канала без памяти.

- •Экзаменационный билет №3

- •1. Оптимальный прием сигналов на фоне помех. Критерий идеального наблюдателя. Структурная схема идеального приемника Котельникова.

- •Экзаменационный билет №4

- •1. Вероятностные характеристики случайных сигналов. Физический смысл дисперсии и акф эргодического сигнала.

- •Экзаменационный билет №6

- •1. Плотность распределения вероятности мгновенных значений случайного сигнала: возможные графики одномерной прв, двумерная, многомерная.

- •2. Согласованный фильтр. Импульсная характеристика согласованного фильтра и ее связь с временной формой согласованного с ней сигнала. Описание и форма сигнала на выходе согласованного фильтра.

- •Экзаменационный билет №7

- •Математическая модель узкополосного случайного сигнала в виде комплексного колебания.

- •Экзаменационный билет №8

- •1. Корреляционная функция случайного процесса. Определение и основные свойства, формулы расчета для дискретных сигналов, для эргодических непрерывных сигналов.

- •Экзаменационный билет №9

- •1. Определение количества информации по Шеннону. Энтропия источника случайных сообщений. Свойства энтропии. Энтропия двоичного источника.

- •2. Корреляционная функция стационарного эргодического случайного сигнала. Формула расчета и физический смысл интервала корреляции.

- •Экзаменационный билет №10

- •Понятие спектральной плотности мощности случайного сигнала.

- •Теорема Винера-Хинчина.

- •Принцип помехоустойчивого кодирования канала.

- •Экзаменационный билет №11

- •1. Количественное измерение информации. Энтропия дискретного источника и ее свойства. Энтропия двоичного источника.

- •2. Дисперсия случайного сигнала. Определение, формулы расчета для дискретных и непрерывных сигналов, физический смысл дисперсии, единицы измерения.

- •Алгоритм работы и структурная схема когерентного корреляционного приемника бинарных сигналов:

- •Экзаменационный билет №13

- •1. Понятие случайного сигнала «белый шум». Спектральная плотность мощности и корреляционная функция «белого» и небелого шума. Понятие квазибелого шума.

- •2. Структура сверточного кодера, как цифрового фильтра. Диаграмма состояний сверточного кодера, как конечного автомата. Импульсная характеристика сверточного кодера и порядок ее расчета.

- •Экзаменационный билет №14

- •Плотность распределения вероятности мгновенных значений узкополосного случайного сигнала.

- •Экзаменационный билет №15

- •Экзаменационный билет №16

- •Автокорреляционная функция (акф) – второй смешанный центральный момент двумерной плотности распределения вероятностей; центральный смешанный момент второго порядка.

- •Экзаменационный билет №18

- •1. Синтез оптимального приемника на согласованных фильтрах. Алгоритм работы и структура оптимального приемника на согласованных фильтрах для бинарных сигналов.

- •2. Эффективное кодирование источника. Словарное кодирование. Алгоритм Лемпеля-Зива. Порядок составления словаря и порядок формирования кодовых символов для передачи по каналу.

- •Экзаменационный билет №20

- •1. Формирователь модулирующих символов (фмс) для сигналов кам16. Сигнальное созвездие кам-16. Понятие о коде Грея.

- •Условная энтропия между входом и выходом в канале и взаимная информация входа и выхода

- •Экзаменационный билет №21Классификация случайных сигналов по виду закона распределения. Нормальный закон: формула одномерной прВинтеграл вероятности

- •Экзаменационный билет №22

- •2. Модели непрерывных каналов с аддитивным шумом: с постоянными параметрами, с неопределенной фазой, с общими и частотно-селективными замираниями.

- •Экзаменационный билет №23

- •1. Блочный код Хэмминга (7,4). Структура проверочной матрицы для систематического кода. Принцип кодирования с использованием проверочной матрицы.

- •Экзаменационный билет №24

- •1. Блочный код Хэмминга (7,4). Проверочная матрица систематического кода и получение синдрома кодового слова. Принцип синдромного декодирования систематического блокового кода.

- •2. Модели дискретных каналов. Математическое описание несимметричного канала без памяти и канала с памятью. Принцип относительной фазовой модуляции. Исключение обратной работы демодулятора.

- •Экзаменационный билет №25

- •1. Импульсная характеристика линейной системы. Свертка сигнала и импульсной характеристики. Формулы свертки для непрерывных и дискретных сигналов. Порядок выполнения дискретной циклической свертки.

- •Экзаменационный билет №26

- •1. Особенности преобразования сигналов в параметрических цепях и системах. Параметрическое преобразование частоты. Принцип работы супергетеродинного приемного устройства. Понятие зеркальной частоты.

- •2. Статистические свойства квадратурных компонент случайного узкополосного сигнала. Статистические свойства огибающей и фазы узкополосного случайного сигнала.

- •Экзаменационный билет №27

- •1. Усреднение по ансамблю реализаций, усреднение по времени: формулы расчета для дискретных и непрерывных случайных сигналов. Эргодические случайные сигналы.

- •1. Критерий минимального среднего риска.

- •2. Критерий максимального правдоподобия (критерий мп).

- •3. Критерий идеального наблюдателя.

- •4. Критерий Неймана-Пирсона.

- •Экзаменационный билет №28

- •Возможные доп. Вопросы:

- •22 Билет) а нахуя нам каноническая матрица

Экзаменационный билет №8

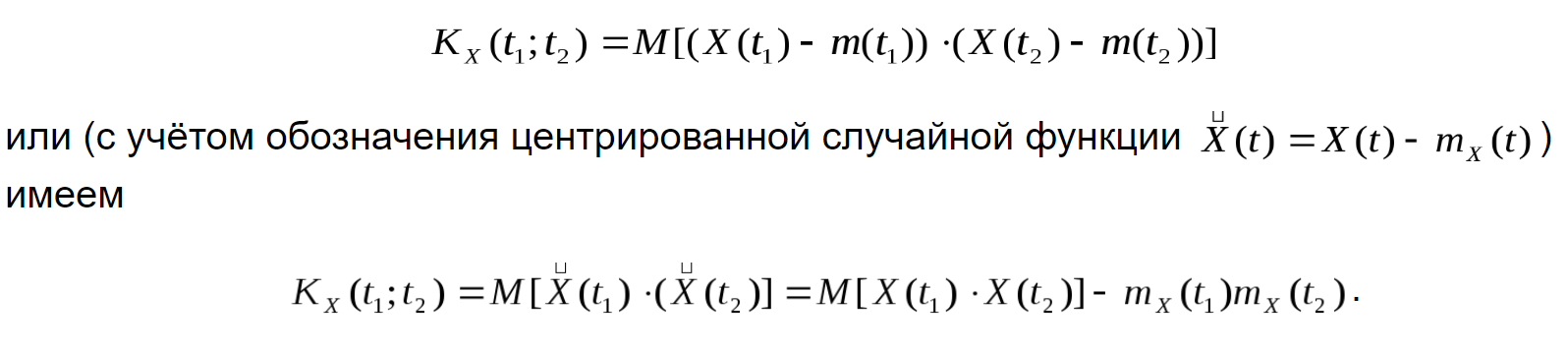

1. Корреляционная функция случайного процесса. Определение и основные свойства, формулы расчета для дискретных сигналов, для эргодических непрерывных сигналов.

Корреляционной (ковариационной, автоковариационной, автокорреляционной) функцией случайного процесса X(t) называется ф-я, которая при каждой паре значений {t1, t2} равна корреляционному моменту соответствующих сечений X(t1) и X(t2):неслучайная функция двух аргументов K(t1; t2), которая

Свойства:

1.

Корреляционная функция при одинаковых

значениях аргументов равна дисперсии

с.п.![]()

2.

Корреляционная функция не меняется

относительно замены аргументов, т.е.

является симметрической функцией

относительно своих аргументов:![]()

3.

Если к случайному процессу прибавить

неслучайную функцию, то корреляционная

функция не меняется, т.е. если![]() ,

то

,

то

![]() .

Другими словами является периодической

функцией относительно любой неслучайной

функции.

.

Другими словами является периодической

функцией относительно любой неслучайной

функции.

4.

Модуль корреляционной функции не

превосходит произведения с.к.о., т.е.![]()

5.

При умножении с.п.X(t) на неслучайный

множитель![]() её

корреляционная функция умножится на

произведение f(t1)*f(t2), т.е., если

её

корреляционная функция умножится на

произведение f(t1)*f(t2), т.е., если![]() ,

то

,

то

![]()

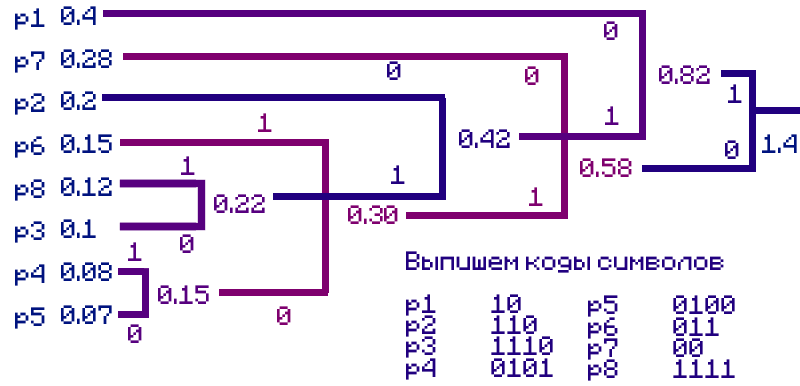

2. Построить дерево эффективного кодирования источника кодом Хаффмена, если вероятности передаваемых символов р1=0.4; р2=0.2; р3=0.1; р4=0,08; р5=0,07; р6=0.15; р7=0.28; р8=0.12. Определить энтропию источника и среднее число бит кода на одно сообщение.

Шаг 1 Упорядочим вероятности передаваемых символов в порядке невозрастания (тупо убывания вот он ах...)

p1 =0.4 ; р7=0.28 ; р2=0.2; р6=0.15; р8=0.12 ; р3=0.1; р4=0,08; р5=0,07.

Шаг 2 Берем два элемента с наименьшими вероятностями и объединяем их (складываем вероятности) наименьшему элементу сопоставляем “0”, наибольшему “1”

p1 =0.4 ; р7=0.28 ; р2=0.2; р6=0.15; р8=0.12 ; р3=0.1; р54=0,15;

Шаг 3 Рассматриваем новую последовательность и повторяем Шаг 2 до тех пор пока не останется один “корень”

p1 =0.4 ; р7=0.28 ; р2=0.2; р6=0.15; р38=0.22 ; р54=0,15;

Определим среднее число бит(цену кодирования: средняя длину кодового слова L)

=2*(0.4+0.28)+3*(0.2+0.15)+4*(0.1+0.08+0.07+0.12)= 3.89 [бит]

Определим энтропию источника по формуле:

H(A)=0.528771+0.51422+0.464386+0.410545+0.367067+0.332193+0.291508+0.268555=3.177245[бит]

Экзаменационный билет №9

1. Определение количества информации по Шеннону. Энтропия источника случайных сообщений. Свойства энтропии. Энтропия двоичного источника.

Определение количества информации по Шеннону

Американский инженер-связист Клод Шеннон предложил ввести меру количества информации с помощью статистической формулы энтропии:

![]()

,где вероятность Wi появления состояния i, I количество информации

Энтропия источника случайных сообщений.

Энтропия

случайного источника

(англ. Shannon

entropy)

— функция от вероятностей исходов

![]() (оператор

объединения)

характеризующая количество информации,

приходящейся на одно сообщение источника.

(оператор

объединения)

характеризующая количество информации,

приходящейся на одно сообщение источника.

Свойства энтропии.

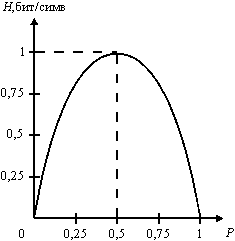

Энтропия двоичного источника. Сделал так-же, как в 11

Случай независимых равновероятных символов

Вероятности: P(a1)=P(a2)=P=0.5 , условные вероятности равны нулю. Энтропия такого источника максимальна:

Hmax=-0.5 * log(0.5)- 0.5 * log(0.5) = log(2) = 1 бит/символ

Таким образом, 1 бит - это максимальное среднее количество информации, которое может переносить один символ источника двоичных сообщений.

Случай независимых неравновероятных символов

Вероятности: P(a1)=P ; P(a2)=1-P условные вероятности равны нулю. Энтропия такого источника равна: H(P)=-P * log(P) - (1-P) * log(1-P)

Эта зависимость показана ниже на рисунке. Максимум энтропии достигается при P=0.5. Поскольку H(p)< Hmax при P!=0.5, то производительность такого источника меньше максимальной.

Рис. Энтропия двоичного источника сообщений с неравновероятными символами

Случай коррелированных равновероятных символов

При некоррелированных равновероятных символах двоичного источника энтропия равна 1 бит/симв. Следовательно, наличие статистических связей между символами приводит к уменьшению энтропии и увеличению избыточности источника.