- •1. Структурная схема микропроцессора (на примере i8086). Назначение регистров.

- •3. Организация основной памяти.

- •3. Структура и характеристики оперативной памяти

- •4. Модель osi

- •5. Стек протоколов tcp/ip

- •6. Классификация компьютерных сетей

- •7. Данные и модели данных

- •8. Модель данных «сущность-связь»

- •Ограничения целостности

- •9. Реляционная модель данных

- •10. Основные направления исследования в области ии

- •11. Метод резолюции в лппп.

- •12. Продукционная модель

- •13. Основные парадигмы языков программирования.

- •14. Основные понятия ооп: инкапсуляция, наследование, полиморфизм

- •1. Инкапсуляция

- •2. Полиморфизм

- •3. Наследование

- •15. Понятие алгоритма.

- •16. Понятие о временной и емкостной сложности алгоритма

- •17. Машина Тьюринга: детерминированная и недетерминированная

- •18. Понятие формального языка и формальной грамматики

- •19. Основные понятия теории графов.

- •20. Понятие количества информации и энтропии. Теорема Шеннона.

- •21. Деревья в теории графов.

- •22. Модели линейного программирования (постановка задачи, математическая модель, решение графическим методом).

- •23. Двойственность в задачах линейного программирования.

- •25. Элементы теории игр.

- •2. Подпрограммы. Процедуры и функции

- •3. Массивы

- •4. Записи

- •5. Работа с Динамическими данными

- •6. Динамические структуры данных. Линейные списки.

- •7. Динамические структуры данных: двоичные деревья

- •8. Работа с файлами

- •9.Операции целочисленной арифметики

- •10. Системы счисления. Перевод чисел из одной системы счисления в другую

- •11. Язык sql. Назначение и основные команды.

- •Манипулирование данными

- •Простые запросы

- •12. Алгоритмы внутренней сортировки.

- •13. Алгоритмы внешней сортировки

- •14. Нахождение кратчайших путей в графе

- •15. Поиск в ширину

- •16. Поиск остова и минимального остова.

- •17. Линейная модель работы информационно-поисковой системы.

- •18. Хеширование

- •Основные достоинства в-дерева

- •20. Логические вопросно-ответные системы:выполнение запросов различных типов.

- •21. Поиск в семантической сети.

- •22. Принципы динамического программирования. Иллюстрация на примере.

- •23. Адресация в Интернете

- •Доменные имена

- •Общий вид формата url-адреса

- •Как работает dns-сервер

- •24. Основные сервисы в сети Интернет.

- •Word Wide Web (www) - "Всемирная паутина"

- •Поиск информации в сети

- •VoIp сервис

- •Мессенджеры

- •25. Использование html. Структура Web(html) страницы.

20. Понятие количества информации и энтропии. Теорема Шеннона.

Будем считать, что некоторая абстрактная информация передается посредством конкретного сообщения. Тогда всякий процесс получения информации представляет собой получение конкретных сообщений. Под сообщением будем понимать совокупность знаков, понятных адресату. Формальное определение знака дается в семиотике - науке о всевозможных знаковых системах, мы под знаком будем понимать некоторый символ. Информация от источника адресата предается с использованием некого канала связи:

Канал - это нечто, используемое для передачи информации, точнее сообщений. В канале всегда существуют помехи, имеющие случайную природу. Помехи могут искажать информацию. Источник обладает конкретным конечным множеством сообщений (X), каждому из которых сопоставлена вероятность отсылки (p(xi)). Это множество с распределением вероятностей называется ансамблем источника. Аналогично определяется ансамбль адресата (множество Y и для каждого уi существует вероятность получения p(yi)). Допустим, что источник отправил в канал сообщение xi. Помехи имеют свою вероятностную природу, поэтому мы можем получить на приемнике (адресате) несколько разных сообщений с разной вероятностью. Если помех в канале нет, то мы получим сообщение yi. Естественно, что и на приемнике и на источнике выполняются условия нормировки:

![]()

![]()

Т.е. считаем, что какое-то сообщение будет обязательно отправлено, и какое-то обязательно будет принято.

Д ля

ля

![]() определена

вероятность того, что послано хi

при условии, что получено yj

- p(xi,yj).

определена

вероятность того, что послано хi

при условии, что получено yj

- p(xi,yj).

В идеальном канале

![]()

![]()

![]()

![]()

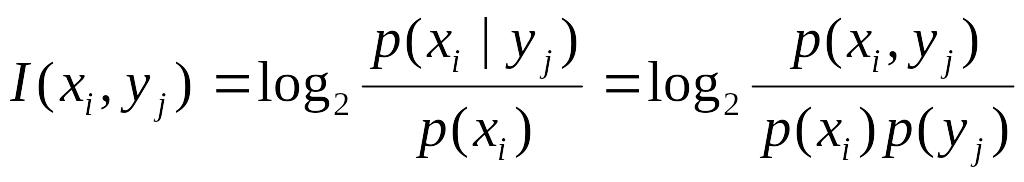

Опред. Количеством взаимной или совместной информации сообщений хi и yj называется следующая величина:

Средней взаимной информацией ансамблей называется величина:

![]()

Пример 1. Двоичный симметричный канал.

![]()

![]()

![]()

![]()

![]()

![]()

Для идеального канала I(X,Y)=1, а при E=1/2 мы вообще не получаем никакой информации.

Энтропия и ее связь с информацией.

Собственной информацией сообщения называется величина:

![]()

В случае, если канал без помех I(xi) показывает какую информацию мы получим, если послано xi, т.е. собственную информацию сообщения xi.

![]()

- энтропия, суть средняя информация сообщения в ансамбле, ее также называют мерой неопределенности (беспорядочности) источника.

Теорема (1-я теорема об энтропии).

Н(X)>=0

Доказательство.

![]() очевидно

очевидно

![]()

![]()

Замечание. В реальности P(xi)>0 поскольку, если p(xi)=0, то сообщение никогда не будет послано, а значит его не существует.

Теорема (2-я теорема об энтропии).

Пусть в источнике k сообщений, причем

![]() тогда

тогда

![]()

Доказательство опускается.

Кодирование ансамбля источника

Двоичный код.

Самым распространенным способом кодирования информации. Двоичный код представляет собой последовательность нулей и единиц. Каждый символ «0» или «1» называется битом. ЭВМ обрабатывает информацию именно в двоичном коде.

Теорема Шеннона.

Задача кодирования ансамбля источника состоит в том, чтобы максимально эффективно (с наименьшей средней длиной кода) представить сообщения источника в двоичном виде. Возникает вопрос, насколько эффективно в принципе можно решить эту задачу. ответ дает теорема Шеннона.

Приведем формулировку теоремы Шеннона (основной теоремы кодирования) для двоичного кодирования информации.

Пусть имеется ансамбль источника с энтропией H(X), тогда существует двоичный код, с помощью которого сообщение можно закодировать в среднем в k битах, где

![]()

(Доказательство опускается).

Замечание. Теорема Шеннона окончательно проясняет связь между понятием бита, как единицы информации и как разряда в двоичном коде.