- •Элементы теории погрешностей.

- •1.1.Определение абсолютной и относительной погрешности численного результата.

- •1.2.Основные составляющие абсолютной погрешности.

- •1.3.Формулы для оценки абсолютной и относительной погрешности для значения функции и переменных.

- •Решение уравнений с одной неизвестной.

- •2.1.Отделение корней уравнения и отделение корней алгебраического уравнения.

- •2.2.Понятие кратного корня.

- •2.3.Методы уточнения корней простой итерации.

- •2.4.Метод Ньютона.

- •2.5.Метод хорд.

- •2.6.Достаточное условие сходимости метода простой итерации.

- •Вывод условия сходимости:

- •2.7.Оценка погрешности n-приближения.

- •Решение систем линейных уравнений.

- •3.1.2.Классификация слау

- •3.1.3.Обусловленность слау

- •3.1.Метод Гаусса.

- •3.2.Метод прогонки.

- •3.3.Метой простой итерации. Приведение системы к итерационной форме

- •Выполнение итерации

- •Проверка условия окончания решения

- •3.4.Достаточное условие сходимости простой итерации.

- •3.5.Оценка погрешности n-приближения.

- •4.1.Метод простых итераций.

- •1) Функции 1(X,y) и 2(X,y) определены и непрерывно дифференцируемы в r;

- •3) В r выполнены неравенства

- •4.2.Метод Ньютона.

- •Интерполяция функций.

- •5.1.Постановка задачи.

- •5.2.Формула Лагранжа.

- •5.3.Формула Ньютона.

- •5.4.Оценка погрешности интерполяции.

- •5.5.Интерполяция сплайнами.

- •Определение кубического сплайна.

- •Формулировка системы уравнений для коэффициентов кубического сплайна.

- •Аппроксимация функций.

- •6.1.Постановка задачи.

- •6.2.Метод наименьших квадратов.

- •6.3.Матричная формула для коэффициентов многочлена аппроксимации.

- •Численное интегрирование.

- •8.1.Формулы прямоугольников, трапеций, парабол (Симпсона). Оценки погрешностей. Методы прямоугольников

- •Метод трапеций

- •Метод парабол

- •8.2.Метод Рунге двойного счета для оценки погрешности.

- •Методы решения задачи Коши для обыкновенного дифференциального уравнения.

- •9.1.Интегральное представление задачи Коши.

- •10.1.Обусловленность задачи поиска минимума.

- •10.3.Метод золотого сечения.

- •10.4.Метод координатного спуска.

- •10.5.Метод наискорейшего спуска.

9.1.Интегральное представление задачи Коши.

9.2.Метод Эйлера (метод касательных, ломанных и т. д.) Оценка погрешности.

9.3.Метод Эйлера-Коши (метод предиктор-корректор). Оценка погрешности.

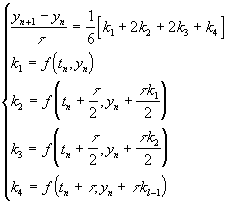

9.4.Метод Рунге-Кутты 4-ого порядка точности.

На практике широко

распространен Метод Рунге - Кутта

четвертого порядка :

Данная схема имеет четвертый порядок аппроксимации.

9.5.Сведение задачи Коши для уравнений n-порядка к системе ОДУ 1-ого порядка (задача Коши для системы).

9.6.Понятие краевой задачи для ОДУ 2-ого порядка.

9.7.Метод стрельбы (пристрелки).

9.8.Пример жесткой задачи Коши.

Методы оптимизации функций.

Под оптимизацией понимают процесс выбора наилучшего варианта из всех возможных.

В процессе решения задачи оптимизации обычно необходимо найти оптимальные значения некоторых параметров, определяющих данную задачу. При решении задач эти параметры обычно называют переменными или факторами оптимизации. Их число (x1, x2, … , xn) определяет размерность задачи оптимизации.

Выбор оптимального решения или сравнение двух альтернативных решений проводится с помощью некоторой зависимой величины. Эта величина называется целевой функцией. В процессе решения задачи оптимизации должны быть найдены такие значения переменных оптимизации, при которых целевая функция имеет минимум (или максимум).

Целевую функцию в общем виде можно записать следующим образом

u = f(x1, x2, …, xn)

Различают одно- и многофакторную оптимизацию. В случае однофакторной оптимизации целевая функция является функцией одной переменной, и ее график - некоторая кривая на плоскости. При n=2, например, целевая функция является функцией двух переменных, и ее графиком является поверхность.

Целевая функция не всегда может быть представлена в виде формулы. Иногда она может принимать некоторые дискретные значения, задаваться в виде таблицы и т.п.

Задачи оптимизации. Можно выделить два типа задач оптимизации - безусловные и условные.

10.1.Обусловленность задачи поиска минимума.

Будем искать минимум функции f(x), которая определена на отрезке [a,b] и унимодальна (т.е. на данном отрезке имеет только один минимум).

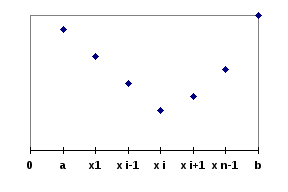

Процесс решения задачи методом поиска состоит в последовательном сужении интервала изменения фактора оптимизации, называемого интервалом неопределенности. В начале процесса оптимизации его длина равна b-a, а к концу она должна стать меньше заданного допустимого значения , т.е. оптимальное значение параметра оптимизации должно находиться в интервале неопределенности - отрезке [xn, xn+1], причем xn+1 - xn < .

Наиболее простым способом сужения интервала неопределенности является деление его на некоторое число равных частей с последующим вычислением значений целевой функции в точках разбиения. Пусть n - число элементарных отрезков, h = (b-a)/n - шаг разбиения. Вычисляют значения целевой функции yk = fk(x) в узлах xk = a + k h (k=0,1, … , n). Сравнивая полученные значения f(xk), среди них находят минимальное. В данном методе, который можно назвать методом перебора, основная трудность состоит в выборе n и оценке погрешности.

В описанном методе можно с помощью разумного выбора шага разбиения добиться эффективного поиска.

10.2.Метод дихотомии.