- •1. Передача информации между двумя оконечными устройствами. Тип соединения оконечных устройств

- •2. Основные определения: информация, сообщение, система связи, сигнал, алфавит.

- •5. Форматирование информации. Форматирование текстовых данных. Существующие стандарты.

- •6. Передача сообщений по каналу, искажения, краевые искажения, дробление

- •9. Дискретизация по методу «выборка-хранение».

- •10. Сигнал, как реализация процесса. Классификация процессов.

- •11. Детерминированные процессы. Гармонические и переходные непериодические процессы.

- •12. Полигармонические и непериодические процессы их спектральные характеристики.

- •13. Определение случайного процесса. Непрерывные и дискретные случайные процессы.

- •14. Измерение случайных процессов.

- •15. Числовые характеристики случайных процессов, их инженерно-физический смысл.

- •16.Законы распределения и основные характеристики случайных процессов

- •17. Автокорреляционная функция случайного процесса. Примеры автокорр. Функций.

- •18. Взаимная корреляционная функция случайных процессов. Примеры применения корреляционных характеристик.

- •19. Усреднение по ансамблю и по времени. Эргодическое свойство случайных процессов.

- •20. Стационарные и нестационарные случайные процессы. Стационарность в широком и узком смыслах. (2 стр)

- •21. Количество информации. Формула Хартли.

- •22. Формула Шеннона.

- •23. Энтропия источника сообщений. Свойства энтропии источника дискретных сообщений

- •24. Избыточность при передаче сообщений. Роль избыточности при передаче информации

- •25. Математические модели сигналов. Спектральное представление сигналов.

- •26. Ряд Фурье по произвольной ортогональной системе функций.

- •27. Ряд Фурье по основной тригонометрической системе функций.

- •28. Разложение периодических функций в ряд Фурье. Спектр амплитуд и спектр фаз.

- •29. Ряд Фурье в комплексной форме. Спектр фаз и спектр амплитуд.

- •30. Спектр мощности сигнала. Практическая ширина спектра. Равенство Парсеваля. (3 стр!!!)

- •31. Спектральные характеристики непериодического сигнала. Прямое и обратное преобразования Фурье.

- •32. Оценивание спектральной плотности с помощью дпф

- •33. Дискретное преобразование Фурье (дпф). Гармонический анализ.

- •34. Примеры ортогональных базисов. Функции Уолша.

- •35. Модуляция. Зачем она нужна

- •36. Спектр ам сигнала. Ширина полосы.

- •38. Амплитудная модуляция.

- •41. Угловая модуляция

- •42. Частотная модуляция.

- •43. Спектр колебаний с угловой модуляцией

- •44. Сравнение методов амплитудной и угловой модуляций

- •45. Шумы. Тепловой шум. Представление тепловых шумов. Мощность шума. Распределение тепловых шумов.

- •49. Спектральные характеристики случайных процессов.

- •50. Коды, применяемые в информационных системах. Преобразование кодов.

- •51.Исправляющие или корректирующие коды.

- •52. Кодирование источников без памяти: Код Хаффмана.

- •53. Кодирование источников без памяти: Код Шеннона-Фано

- •Оглавление

21. Количество информации. Формула Хартли.

Пусть имеется множество N=2k элементов. Пусть во множестве N помечен некоторый элемент. Каким кол-вом инф-ции (в битах) надо обладать для идентификации помеченного эл-та?

K=log2 N, где N – кол-во элементов.

В формуле Хартли предполагается, что все элементы множества равновероятны.

Закон аддитивности:

Пусть имеется мн-во M1, содержащее N1 эл-тов и Хi принадлежит N1. M2 содержит N2 эл-тов и Хj принадлежит N2. Составим пары (Хi , Хj)

M=N1*N2

log2(N1*N2)= log2 N1 + log2 N2

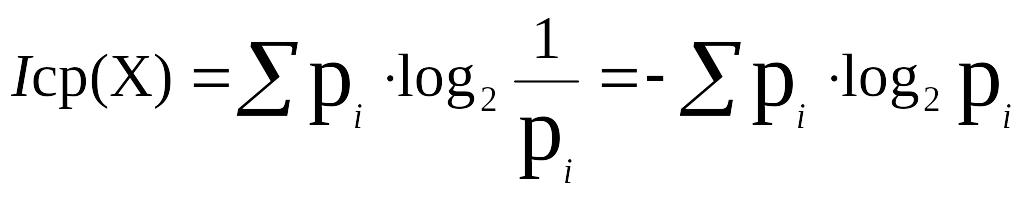

22. Формула Шеннона.

Пусть имеется случайная величина Х: Х1, Х2, Х3, … , Хn с вероятностями р1, р2, р3, … , рn

I(Xi) – кол-во информации при одном опыте

I(Xi) = log2 1/Pi

В каждом комплексе мы получаем различное кол-во информации.

Формула Шеннона:

23. Энтропия источника сообщений. Свойства энтропии источника дискретных сообщений

Энтропия - это

математическое ожидание по частным

количествам информации сообщений,

генерируемых источником. Безусловная

энтропия источника![]() вычисляется по формуле:

вычисляется по формуле:

![]() [бит/сообщ.]

[бит/сообщ.]

Свойства энтропии:

Это величина вещественная, действительная, неотрицательная: 0<=

<=1.

<=1.Энтропия достоверного события = 0.

![]() , [бит/сообщ.]

, [бит/сообщ.]

![]()

Энтропия – это интегральная оценка

Не

следует путать среднее значение

информации ![]() с информацией, полученной в данном

конкретном опыте.

с информацией, полученной в данном

конкретном опыте.

![]() -энтропия

достоверного события.

-энтропия

достоверного события.

![]() ;

;

![]() ;

;

![]() ;

;

;

;

Где ![]() .

.

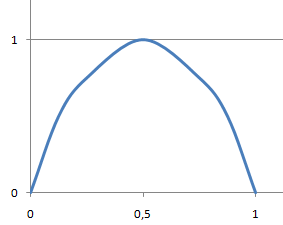

Энтропия альтернотивного сообщения максимальна при равной вероятности.

![]()

![]()

![]()

![]()

![]()

![]()

Энтропия максимальна, когда вероятности событий одинаковы.

![]() ;

;

![]()

![]() -

при

условии равновероятности.

-

при

условии равновероятности.

Реальные источники как правило имеют произвольный закон распределения и энтропия, вызванная неравенством распределения будет меньше max, а энтропия, вызванная неравенством распределения называется безусловной. Т.о. безусловная энтропия вызывается только неравенством распределения:

-

независимые

события

-

независимые

события

Условная энтропия – термин применимый к зависимым событиям.

![]() ;

;

.

.

24. Избыточность при передаче сообщений. Роль избыточности при передаче информации

Наличие в сообщении большего числа букв или в кодовой комбинации большего числа элементов, чем это минимально необходимо для передачи содержащегося в них количества информации, называют избыточностью. Расчет избыточности проводится по формуле:

![]()

Роль избыточности при передаче информации: избыточность позволяет обнаруживать и исправлять ошибки, и эта способность зависит от количества избыточных разрядов.

25. Математические модели сигналов. Спектральное представление сигналов.

Физ. природа сигнала зависит от канала связи. Для того, чтобы сигнал стал объектом научного исследования без относительно физ. природе, необх. указать путь создания его мат. модели. Различные мат. модели должны отражать различные с-ва сигналов. Сигнал можно изучать как аналитическое описание ф-ции, аргументом кот. явл. время. Можно изучать энерг. с-ва сигнала. Можно построить частотную модель сигнала (спектр). Ряд Фурье произвольной периодической ф-ции любого аргумента:

В математике ф-ция любого аргумента, а в ТПС – ф-ции, аргументом кот. явл. ВРЕМЯ – наз. ПРОЦЕСС.

Спектральные характеристики случайных процессов.

Гармонич.

анализ детерминир. процесса явл. мощным

средством исслед. и описания их.

Естественно этот аппарат перенести на

случ. процессы. Но случ. процесс имеет

2 особенности: 1)процесс не является

абсолютно интегрируемым:

.

2) Преобраз. Фурье случ. процесса есть

тоже процесс случайный. Для обобщ.

хар-тик случ. процесса необх. неслуч.

величина. Спектральные хар-тики случ.

процессов МОГУТ быть вычислены. Сущ. 2

пути их нахождения: I)

Путь усреднения. Исходя из с-ва эргодичности

случ. процесса.

.

2) Преобраз. Фурье случ. процесса есть

тоже процесс случайный. Для обобщ.

хар-тик случ. процесса необх. неслуч.

величина. Спектральные хар-тики случ.

процессов МОГУТ быть вычислены. Сущ. 2

пути их нахождения: I)

Путь усреднения. Исходя из с-ва эргодичности

случ. процесса.

I

I)

Путь, связ. с Фурье-преобраз. корреляционной

ф-ции. Имеем кор. ф-цию

![]() ,

кот. зависит только от τ,

то корреляц. ф-ция, связ. с энергетическим

спектром Фурье-преобразования.

,

кот. зависит только от τ,

то корреляц. ф-ция, связ. с энергетическим

спектром Фурье-преобразования.

Ф-лы Винера-Хинчера:

![]()

![]()