- •§1. Понятие эс, назначение, классификация

- •§2. Качество сложной системы

- •§3. Жизненный цикл сложной системы

- •§4. Структуры конструкции эс и их математические модели

- •§5. Параметры конструкции эс и отклонение параметров.

- •§6. Конструкция эс и ее характерные черты

- •§7. Воздействия на конструкцию эс

- •§8. Конструирование эс

- •§9. Модели и моделирование как основы оптимизации

- •§10. Математическая формулировка задачи оптимального проектирования

- •§11. Целевая функция

- •§12. Методы решения задач оптимального проектирования. Классификация

- •§13. Методы оптимизации, основанные на классической математике

- •Экстремум функции одной переменной

- •Экстремум функции многих переменных

- •Метод замены переменных

- •Метод неопределенных множителей Лагранжа.

- •§14. Нелинейное программирование

- •Метод релаксации.

- •Метод градиента.

- •Метод наискорейшего спуска (метод Коши).

- •Метод Ньютона.

- •Метод общего поиска

- •Метод дихотомии

- •Метод почти половинного деления.

- •Метод золотого сечения.

- •Метод чисел Фибоначчи

- •3. Метод случайных направлений

- •4. Комбинированный метод

- •§15. Надежность. Основные понятия

- •§16. Показатели надежности невосстанавливаемых элементов и систем

- •Вероятность безотказной работы

- •Частота отказов

- •Интенсивность отказов

- •§17. Основные законы надежности

- •§18. Классификация аппаратуры по требованиям к надежности

- •§19 Факторы, влияющие на надежность эс

- •§20. Обеспечение надежности резервированием эс

- •§21. Общие принципы обеспечения надежности эс

- •При проектировании.

- •При производстве:

- •При эксплуатации:

- •§22. Расчеты надежности эс

- •Оценочный

- •Ориентировочный

- •Уточненный

- •§23. Методы прогнозирования состояния и качества эс

- •Этап проектирования

- •Этап производства

- •Этап эксплуатации

- •§24. Показатели качества прогнозирования

Метод релаксации.

Применяется в задачах, где трудно или невозможно отыскать оптимум в аналитической форме (ЦФ имеет сложную структуру).

Исходная задача разбивается на ряд подзадач.

![]()

В области определения

выбирается точка

![]() и составляется

функция вида:

и составляется

функция вида:

![]()

Все переменные делаем постоянными, а x1 освобождаем:

Находим производную:

=0

=> x1=х1(1)

=const.

=0

=> x1=х1(1)

=const.

Это значение подставляется в функцию , освобождая переменную х2:

Дальше таким же образом берется производная и находится:

![]() и т.д.

и т.д.

Находим:

![]()

Т. е. за

![]() шагов вычисляем

шагов вычисляем

![]() ,

производим сравнение

,

производим сравнение

![]() и

.

Далее снова освобождаем переменную х1

и составляем

новую ЦФ:

и

.

Далее снова освобождаем переменную х1

и составляем

новую ЦФ:

![]() ;

; ![]()

……….

![]()

и так к раз. Сравнивая

![]() ,…,

выбирают max

или min

значение ЦФ. Т.о. общее число вычислений

kn.

,…,

выбирают max

или min

значение ЦФ. Т.о. общее число вычислений

kn.

После сравнения выбирается максимальное или минимальное значение функции, которое и дает оптимальное значение вектора Хопт.

![]() – оптимальное значение.

– оптимальное значение.

Достоинства:

Простота и наглядность.

Недостатки:

Долгий путь решения задачи.

Необходимо иметь аналитические выражения производных ЦФ по всем параметрам.

Метод градиента.

Исключает недостатки предыдущего метода и использует основное свойство градиента: вектор градиента всегда направлен в сторону наибольшего изменения функции.

Требование: Функция должна быть дифференцируема, унимодальная (иметь 1 экстремум) на определенном промежутке.

![]() или:

или:

![]() ,

,

здесь К – постоянная, определяющая величину шага.

Метод наискорейшего спуска (метод Коши).

Величина шага выбирается из условия максимизации или минимизации целевой функции при движении в направлении градиента.

Используется информация о поведении первых производных.

Отсюда малая сходимость метода.

Метод Ньютона.

Производится квадратическая аппроксимация целевой функции, что позволяет использовать информацию о поведении вторых производных. Это позволяет менять шаг в зависимости от расстояния до оптимума: увеличивать шаг, где градиент изменяется медленно и наоборот.

Достоинства:

Лучшая сходимость относительно методов, работающих с первой производной;

Не нужно иметь аналитических выражений производных ЦФ, а необходимо знать только их численные значения.

Недостаток: Нужно 2 раза дифференцировать.

Поисковые методы

Безградиентные методы.

Используются для поиска экстремума унимодальных функций.

Не надо искать производные, нужно лишь знать значения целевой функции в определенных точках.

Все методы многошаговые (итерационные, т.е. необходимо провести однотипные вычисления определенное число раз, чтобы найти экстремум с заданной точностью).

Они имеют разную сходимость.

К ним относятся:

Методы общего поиска,

Метод дихотомии.

Метод золотого сечения.

Метод чисел Фибоначчи.

Метод общего поиска

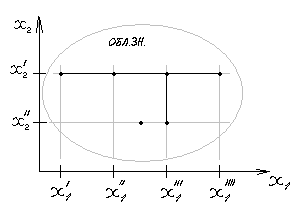

а) Метод покоординатного поиска (метод Гаусса-Зейделя).

Все переменные, кроме одной, фиксируются, а одна, нефиксированная – изменяется, пока ЦФ не достигнет наилучшего значения (max или min). Затем эта переменная фиксируется, освобождается следующая, с которой проделывается то же самое (см. рис. ниже).

Недостатки:

малая сходимость, большое число шагов;

слабо используется информация, полученная на предыдущем шаге;

малая точность метода при одинаковом шаге.

х2-фиксированная, х1-свободная (затем –наоборот).

Достоинства:

Целевая функция может зависеть от нескольких переменных.

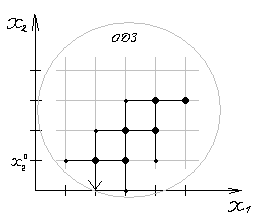

б) Покоординатный поиск с циклическим изменением координат.

Все переменные, кроме одной фиксируются, а одна изменяется следующим образом: делается один шаг в одну сторону и два шага в обратную. Во всех трех точках вычисляются значения целевой функции, из них выбирается наилучшее (точка, которая наиболее близка к оптимуму).

Достоинства:

Сходимость немного лучше.

Недостатки:

Те же.

в) Метод комбинированный.

Вначале используется покоординатный поиск, а вблизи экстремума используется метод б) с переменным шагом.

Достоинства:

Сходимость и точность стали лучше.