- •Содержавние

- •Глава 1 Границы применимости формализма классической теории информации 5

- •Глава 2 Информация — объект постнеклассическои науки 20

- •Глава 3 Эволюция систем — это эволюция ценности информации 36

- •Глава 4 Эволюция логической информации: развитие социокультурных систем 59

- •Глава 5 Научные основы междисциплинарных исследований 77

- •Введение

- •Глава 1 Границы применимости формализма классической теории информации

- •1.1. Истоком информации является случайный выбор

- •20 1.2. Характеристики информации: качество, количество, ценность и эффективность

- •1.2.1. Качество информации.

- •1.2.2. Количество информации.

- •1.2.3. Ценность информации и ее эффективность.

- •Imax — оптимальное количество информации, Emax — максимальное значение эффективности

- •1.3. О микро- и макроинформации

- •1.4. Методологический анализ экстраполяции негэнтропииного принципа

- •Глава 2 Информация — объект постнеклассическои науки

- •2.1. Почему попытки однозначного определения понятия "информация" всегда неудачны?

- •2.2. Информация — это необратимый процесс в многомерном, нелинейном мире

- •2.3. Сколько у информации свойств?

- •Глава 3 Эволюция систем — это эволюция ценности информации

- •3.1. Создание информации как событие в аспекте становления эволюционирующих систем

- •3.2. Иерархия уровней информации на шкале универсальной эволюции

- •3.2.1 Синергетическая информация (s-информация).

- •3.2.2 Генетическая информация.

- •3.2.3 Поведенческая информация.

- •3.2.4 Логическая информация.

- •Развитие логической информации.

- •3.3. Термодинамика информационных систем

- •3.4. Динамика информации: модели эволюции ценности и эффективности

- •Глава 4 Эволюция логической информации: развитие социокультурных систем

- •4.1. Методологические возможности информационно-синергетического подхода к исследованию социокультурных систем

- •Функции отдельных элементов задержанных цивилизаций

- •4.2. Эволюция социокультурных систем

- •4.3. Методология сопоставления взглядов на пути развития культуры

- •Глава 5 Научные основы междисциплинарных исследований

- •5.1. Логическая информация и проблема "двух культур"

- •5.2. Исследование социальных следствий синергетики

- •Заключение

1.1. Истоком информации является случайный выбор

Термин "информация" настолько дискуссионен, что до сих пор, несмотря на множество книг и статей, посвященных информации, несмотря на расширение сфер ее применения, не существует точного общепризнанного определения этого феномена. В следующей главе мы обсудим причины, по которым это происходит. В общепризнанном (обыденном) смысле информация означает сумму сведений, которые получает человек об окружающем мире, об интересующих его явлениях, о других людях, наконец о самом себе. Жизнь личности, жизнь общества основаны на сообщении и получении информации.

В середине XX века возникла новая наука — кибернетика, изучавшая процессы управления и связи в искусственных устройствах и живых организмах [33]. Благодаря кибернетике, одним из основных понятий которой является информация, стало ясным огромное значение информационных процессов при функционировании всего живого: растений, простейших организмов, животных. Казалось, что между живой и неживой природой имеется существенное "кибернетическое" различие. Неживые системы самопроизвольно переходят к состоянию максимальной неупорядоченности, отвечающему максимальной энтропии (второе начало термодинамики). Живые системы, обладающие заданной функциональной организацией, напротив, переходят к состояниям биологической упорядоченности. Эту особенность живых систем справедливо объяснили на основе сочетания открытости и сильной неравновесности, создающих предпосылки для протекания информационных процессов [198]. Оказалось, что любое биологическое упорядочение направляется информацией. Именно поэтому при развитии живого энтропия утрачивает характер жесткой альтернативы: в то время как одни системы вырождаются, другие достигают высокого уровня организации, их энтропия самопроизвольно понижается. Живые системы являются самоорганизующимися.

В семидесятых годах было четко показано, что самоорганизация не является прерогативой живых систем. Природа изобилует примерами неживых открытых систем, способных в неравновесных условиях использовать энтропию как источник организации, переходить "от хаоса к порядку", т. е. в этом отношении вести себя подобно живым системам (см., например, [140]). В связи с этим оказался возможен объединяющий, а вовсе не взаимоисключающий подход к явлениям физики, химии, геологии, с одной стороны, и биологии — с другой. В рамках этого подхода, оказавшегося в настоящий момент в центре новейшей естественно-научной (постнеклассической) картины мира, встает вопрос о роли информации в процессах самоорганизации (вообще всех, а не только живых) систем. Трудно предположить, что явления самоорганизации в живой природе направляются потоками информации, а в неживой при очевидной их изоморфности — каким-то иным способом.

Становится ' очевидным, что на фоне развития теории самоорганизации (синергетики) понимание информации как "суммы сведений о..." весьма ограничено. Одно из наиболее содержательных определений, позволяющих понять роль информации в самоорганизующихся системах, а также подойти к оценке количества информации и единице ее измерения дано Генри Кастлером: информация есть случайный запоминаемый выбор варианта из многих возможных и равноправных [60].

Строго говоря, эта часто цитируемая формулировка относится не к определению содержания понятия "информация", а к способу ее создания — к особенностям генерации информации.

Согласно определению Кастлера выбор варианта должен быть:

1) случайным;

2) совершаемым из многих возможных и равноправных (но не обязательно равновероятных) вариантов;

3) запоминаемым.

Рассмотрим последовательно условия 1)-3).

1) Итак, выбор должен быть случайным, если речь идет о возникновении новой информации. Если выбор подсказан на основе предшествующей информации, то речь может идти о ее восприятии, т. е. о рецепции. Поясним это различие на простом "житейском" примере. Пусть путешественнику необходимо прибыть в пункт А (рис. 1.1, в), к которому ведет ветка раздваивающейся дороги. На развилке отсутствует указатель. Путешественник, оказываясь перед дилеммой выбора, полагается на счастливый случай. При этом генерируется информация, которую путешественник запомнит вне зависимости от удачи своего выбора, обеспечивающего попадание в пункт А. Возвращаясь, путешественник может заложить в "дорожную память" полученные им сведения о нахождении пункта А по отношению к развилке. Если эти сведения окажутся зафиксированными с помощью указателя, следующим путешественникам уже не придется совершать выбор, им будет достаточно рецептировать информацию, генерация которой "добыта" предшественником. Для этих "новых поколений" путешественников информация об эффективном способе попадания в пункт А дана в виде указателя, они и воспримут (рецептируют) эту информацию как программу своих дальнейших действий (рис. 1.1,6).

Рис. 1.1. Генерация (о) и рецепт— (<) информации при "путешествии" к пункту А через развилку дороги

Заметим, что предоставление путешественнику свободы выбора при генерации информации противоречит логике ньютоновского детерминизма. Как справедливо отмечено в [86, с. 50], в экспериментах Ньютона никогда не фигурировали задачи с развилкой, т. е. такие, когда движение могло реализовываться в нескольких вариантах. Это отвечает притче о буридановом осле, подверженном фанатизму классического детерминизма. В качестве механического аналога знаменитого животного предложено следующее простое устройство. В однородном поле тяжести с напряженностью \д\ = 9,8м/с установлен желоб, по которому скатывается шарик (рис 1.2). Если трение практически отсутствует, движение однозначно определяется начальными условиями (скоростью и координатой), т. е. для любого заданного момента времени (после опускания шарика) может быть вычислено положение шарика в желобе. Если пристроить в желобе развилку, то, попав на ее острие, шарик имеет возможность .скатиться вправо и влево с одинаковой вероятностью, что и происходит на самом деле вопреки принципу классического детерминизма. Ясно, что случайный "выбор" правого или левого желоба связан с генерацией информации. Классический детерминизм, отказывая шарику в праве "выбора", разрешает ему в результате упругого соударения отталкиваться от острия, подпрыгивать и прыгать множество раз.

Поскольку выбор экспериментальной базы классической науки исключает "задачи с развилками", становится ясным, что генерация информации даже в столь простых и наглядных вариантах выносится "за скобки" как этой науки, так и классического детерминизма. В дальнейшем этот тезис будет развит вплоть до утверждения о том, что без введения дополнительных аксиом в виде концептуальных положений теории самоорганизации невозможно раскрыть смысл феномена информации.

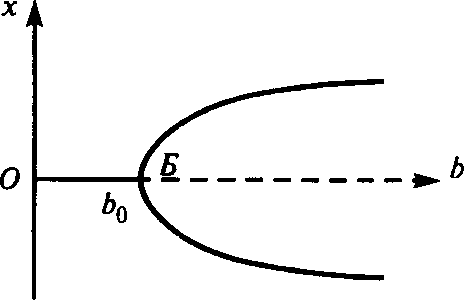

Аналогичный рассмотренному случайный выбор должна совершать самоорганизующаяся физико-химическая система, когда оказывается достигнутым порог ее устойчивости. При некотором значении варьируемого параметра состояния системы (для термоконвекции Бенара это разность температур, для лазера — скорость накачки и т. д.) нарушается устойчивость термодинамической ветви, система оказывается в критической ситуации. Это отвечает точке бифуркации, после перехода через которую система может оказаться в одном из двух стационарных состояний. На рис. 1.3 приведена типичная бифуркационная кривая. По оси абсцисс — параметр состояния, по оси ординат — стационарные значения некоторой переменной х.

Рис. 1.3. Симметричная бифуркационная диаграмма; ОБ — термодинамическая ветвь,

становящаяся неустойчивой правее точки Б. При b > bо существуют два стационарных состояния

Существование этих состояний предоставляет системе выбор: она может отдать предпочтение одной из возможностей. Каким образом система совершает выбор? В нем присутствует элемент случайности: нелинейное макроскопическое уравнение, описывающее временную эволюцию системы, предсказывая многовариантность траекторий эволюции, не в состоянии предсказать, по какой из возможных (разрешенных законами природы) траекторий пойдет дальнейшее развитие. Не помогает и обращение к микроскопическому описанию. Перед нами случайные явления, аналогичные исходу бросания игральной кости. В процессе случайного выбора, который совершает система, генерируется информация.

Случайность

выбора создает платформу для статистической

оценки количества информации и

выбора единицы ее измерения. Введем

эту единицу. Если случайный выбор

совершается один раз между вариантами,

имеющими разные вероятности Р ,

Р

,

Р ,

…Р

,

…Р то

общее количество информации равно

то

общее количество информации равно

I=

-

,

=1;

,

=1;

знак минус отвечает условию I > О, ибо

0

0

так как 1.

Формула (1.1) была получена Клодом Шенноном [191], вычислившим количество информации, которое передают сигналы, отвечающие буквам алфавита, по каналу связи с учетом различной вероятности появлений букв в словах (здесь М — число букв алфавита) в расчете на одну букву. Если сообщение содержит N букв, то количество информации есть

I= - N .

Единица

информации "бит" вводится следующим

образом. Пусть все вероятности

одинаковы; тогда из условия

=

1 следует M

== 1 или мы можем заменить в (1.1) Р

= 1/М.

Тогда

=

1 следует M

== 1 или мы можем заменить в (1.1) Р

= 1/М.

Тогда

I=-

=

M.

=

M.

Минимальное количество информации отвечает случаю, когда М = 2. Это выбор "орел—решка" при подбрасывании монеты или выбор системой ветви бифуркационной кривой или выбор путешественником дороги на развилке и т. д. При этом I = 2=1, что соответствует единице количества информации — биту. Очевидно, что бит — двоичная единица (binary digits). Двоичная система широко применяется в кибернетической технике, компьютерах, так как оперирование всего лишь двумя возможностями, скажем, включением и выключением какого-нибудь элемента, очень упрощает расчеты.

2) В приведенных примерах речь шла о выборе вариантов, принадлежащих одному множеству. Это и соответствует термину в определении Кастлера "равноправный". Нарушение этого требования при обсуждении информации обычно вызывает смех. Знаменитой в этом отношении стала фраза: "Моя мама — русская, а папа — юрист".

Известный представитель французской школы структурализма Мишель Фуко признается, что его бестселлер "Слова и вещи" написан под влиянием смеха, вызванного одним из произведений Хорхе Луиса Борхеса, в котором цитируется придуманная "Китайская энциклопедия". В ней дается следующая "классификация": "животные подразделяются на а) принадлежащих Императору, б) бальзамированных, в) прирученных, г) молочных поросят, д) сирен, е) сказочных, ж) бродячих собак, з) включенных в настоящую классификацию, и) буйствующих как в безумии, к) неисчислимых, л) нарисованных очень тонкой кисточкой из верблюжей шерсти, м) и прочих, н) только что разбивших кувшин, о) издалека кажущихся мухами".

"Предел нашего мышления, — пишет Фуко, — то есть совершенная невозможность мыслить таким образом, — вот что сразу же открывается нашему взору, восхищенному этой таксономией; вот какое экзотическое очарование иного способа мыслить предстает перед нами под покровов аполога" [177].

Мы уже отметили, что равноправность не означает равновероятность, но, тем не менее, вероятности выбора вариантов не очень далеки друг от друга.

3) Рассмотрим требование запоминаемости (рецепции) выбора. Если речь идет о человеке, сделавшем тот или иной выбор, то при фактической сложности процесса запоминания кажется более или менее ясным: человек обладает памятью, данной ему природой, он способен запоминать. А если речь идет о "бифуркационном" выборе? Что значит в этом случае "запомнить" ? На физическом языке это значит привести систему в определенное устойчивое состояние. При этом возникает упорядоченность (структура), олицетворяющая нарушение прежней пространственной симметрии и установление новой асимметричной и в то же время более упорядоченной формы координации частиц, из которых состоит система. В термодинамически устойчивой изолированной системе закон максимума энтропии создает ограничения в виде требования пространственной инвариантности распределения вещества. Никакая информация не может быть запомнена равновесной системой, ибо она имеет лишь одно единственное состояние. Запоминать может только система, находящаяся в далеко неравновесных условиях, способная формировать диссипативные структуры, описанные в серии статей и монографий одного из создателей синергетики (учения о самоорганизации на основе термодинамики неравновесных структур) [40], а также в сотнях статей ученых-синергетиков.

Наличие порогов и четкая локализация в пространстве и времени являются очень эффективным путем осуществления регуляторных функций, которые обеспечивают запоминание. Создающиеся в результате выбора структуры — это результат информационного процесса. Запоминать могут и биологические молекулы, способные находиться в нескольких состояниях.

Таким образом, кастлеровское требование к информации "запомнить" эксплицируется в полном объеме только в рамках синергетики. Интуитивно ясное из обыденного опыта требование "запомнить" превращается во вполне научный термин, указывающий на определенные структурно-динамические изменения внутри системы, способной к самоорганизации.

Требование запоминания выбора реализуется в виде общего свойства любой информации, названного "фиксируемостью", т. е. с "записью" информации, не имеющей материальной природы, на материальном носителе [76, с. 28, 29]. Ниже (параграф 2.2) мы подробно остановимся на ключевом характере этого свойства.

Это вовсе не означает, что информация присутствует всюду, что она как некий статический компонент (подобно гипотетическому эфиру) заполняет весь материальный мир. Представление об информации как о субстанции — это такая же фикция, как гипотеза теплорода. Представление об информации должно быть связано с понятием процесса. В самом деле, выбор — это процесс; рецепция или прием, запоминаемой информации — это процесс изменения состояния системы; передача информации по каналам связи, ее кодирование, декодирование, трансформация тоже, несомненно, являются процессами.

Только в специальных искусственных или естественных устройствах-ячейках может храниться законсервированная память о протекших информационных процессах; тогда мы говорим о "накопленной" информации. Ясно, что "накопить" процесс невозможно, но ведь с успехом можно накопить последствия процесса. Так, мы не можем накопить совершенную механическую работу, которая тоже является процессом, но результат работы может быть накоплен, например в виде увеличения внутренней энергии адиабатно сжимаемого газа.

Во всех реальных запоминающих устройствах время запоминания ограничено, ибо ограниченное время сохраняется то состояние, в которое перешел рецептор под влиянием переданной ему информации. Важно, чтобы интервал времени сохранения памяти был не меньше, чем длительность того процесса, в котором данная информация может понадобиться.

Таким образом, благодаря синергетике появляется возможность возвести идею о значимости информационных процессов в окружающем нас мире в ранг способа видения этого мира. Вместе с тем необходимо отметить, что процесс генерации информации не имеет аналогов в традиционной науке. Это — событие, синтезирующее "случай" и "необходимость", поскольку случайный выбор в момент генерации возможен только из числа состояний, разрешенных природой.

Информация бывает условная и безусловная. Условная информация это прежде всего код, соответствие между условными символами и реальными предметами. Условность информации при выборе любого кода людьми (например, телеграфного кода, азбуки Морзе) очевидна. Условной является и информация, содержащаяся в алфавите и словарном запасе языка. Заметим, что в последнее время наше представление о языке необычайно расширилось, что легко объясняется: большой интерес к проблемам языка связан с важностью изучения процессов мышления. В связи с этим развиваются такие области, как математическая лингвистика, разделяющаяся на статистическую и структурную. Перед математиками постоянно стоит задача построения искусственных языков для взаимодействия человека с вычислительной машиной. Для специалистов-кибернетиков изучение языка — это одна из основных задач, поскольку структура управления — это структура языка системы.

"Оставаясь на позициях кибернетики, мы рассматриваем язык как некоторый организм, полагая, что, возникнув под влиянием определенных (может быть, еще далеко не понятых нами, тем более в деталях) причин, он продолжает самостоятельно развиваться, проходя свой, специфический путь эволюции и оказывая подчас решающее влияние на иерархически вышестоящие системы, скажем, на мышление человека" [122, с. 7].

Процесс становления языка (начавшийся 25 тыс. лет тому назад) относится к самым ранним стадиям антропогенеза [173]. Его развитие сопровождалось морфологическим изменением гортани неоантропов [179]. Современная наука считает, что возникновение речи, т. е. замена звуковых сигналов словами, положило начало человеческой истории.

Связано ли появление языка с генерацией условной информации? Для положительного ответа на этот вопрос необходимо выяснить роль случайности при выборе того или иного способа общения с помощью языка. О том, что случайность здесь играет существенную роль, свидетельствует факт множественности языков (специалисты насчитывают около 3000 различных разговорных языков, на которых говорят народы Земли). Но даже если бы к настоящему моменту все языки слились в некий единый международный язык, мы не могли бы исключить влияния случая на его формирование, ибо это слияние могло бы быть результатом эволюции языковых систем, а не насаждением единого языка извне.

Считается, что логическая кодовая условная информация есть результат общественной деятельности, ибо кодовая информация может быть полезной только в том случае, если ею владеют несколько человек [186, с. 7]. С помощью языка в свое время возник новый вид информации — так называемая логическая информация, развитие которой рассматривается в гл. 4 и 5. Однако кодовой является и условная генетическая информация, генерация которой произошла задолго до появления существ, способных к общественной деятельности. Вместе с тем удается свести генетику к формальному описанию явлений в терминах языка, причем языка весьма жесткого и закрытого [186, с. б], так как в его словаре не происходит изменений, ибо любые изменения словаря приводят к летальному исходу для носителя информации. Это язык с застывшим словарем. Замечательно, что, в отличие от обычных языков, язык генетического кода является единым, его структура действительна как для человека, так и для растений. Расшифровка кода потребовала совместных усилий биологов, химиков, физиков и математиков: "Самым трудным в "проблеме кода* было понять, что код существует. На это потребовалось целое столетие” [58].

Безусловной является информация:

— о реально происходящих событиях, т. е. смысловая, не возникающая случайно, а рецептирующаяся из окружающей действительности;

— генерирующаяся в процессах самоорганизации.

В работе [186] отмечается, что каждое сообщение содержит как условную, так и безусловную информацию, и разделить их иногда непросто. Так, например, математический формализм, унифицированный на нижних уровнях иерархической лестницы, кажется безусловной информацией. Однако следует помнить, что унификация математического аппарата произошла не сразу. Генерировалась условная информация рядом ученых-математиков. Унификация произошла в результате эволюции, приведшей к отбору наиболее приемлемого варианта.

В принципе математика — аксиоматизированная область знаний, что делает ее единой наукой, имеющей свою особенную логическую структуру. Идеал языка такой науки — это система правил оперирования со знаками. Чтобы задать "исчисление", необходимо составить алфавит первичных элементов-знаков, задать начальные слова исчисления, построить правила получения новых слов из начальных слов.

Таким образом, математическая мысль и система кодов неразделимы. Символы имеют для математика принципиальное значение: они — предмет изучения математики. Так, методологические установки Гильберта по Клини [65] состоят в том, что символы сами по себе являются окончательными предметами и не должны использоваться для обозначения чего-либо, отличного от них самих, математик смотрит на них, а не через них, и не на то, что за ними; таким образом, они являются предметами без интерпретации или значения.

Математическое знание содержится в кратких высказываниях — математических структурах. Возникает вопрос: а содержат ли (и если да, то какую) информацию доказательства теорем? Очевидно, да, содержат безусловную информацию, поскольку процесс доказательства не является строго формализованным. Эта информация является дочерней по отношению к базовой и рецептируется благодаря определенным генерируемым математическим идеям, что иллюстрируется, например, следующим высказыванием великого математика Карла Гаусса по поводу одного из его открытий: "Наконец, два дня назад я добился успеха, но не благодаря моим величайшим усилиям, а благодаря Богу. Как при вспышке молнии проблема внезапно оказалась решенной. Не могу сказать сам, какова природа путеводной нити, которая соединила то, что я уже знал, с тем, что принесло мне успех" [3, с. 19]. Очевидно, речь идет о случайном выборе на уровне бессознательного, т. е. о генерации информации.

Мы затронули вопрос о "дочерней" информации, вопрос, связанный с ее качеством. В следующем параграфе мы рассмотрим "качество" наряду с такими характеристиками информации, как ее "количество" и "ценность".