- •1. Определение ии. Определение слабоформализуемых задач и их примеры. Определение сложных систем.[1/1]

- •2. История развития исследований в области ии.[1/1]

- •3. Основные свойства естественного интеллекта (еи).[1/1]

- •4. Основные направления исследований в области ии. Две точки зрения на развитие сии. [1/1]

- •5. Нечеткая логика. Краткие исторические сведения. Аспекты неполноты информации [1/1]

- •6. Определения четких и нечетких множеств. Определение нечеткого множества. Функция принадлежности. Примеры нечетких дискретных и непрерывных множеств. [1/2]

- •7. Основные свойства нечетких множеств. Нечеткое число и нечеткий интервал.[1/3]

- •*7. Основные свойства нечетких множеств. Нечеткое число и нечеткий интервал.[2/3]

- •*7. Основные свойства нечетких множеств. Нечеткое число и нечеткий интервал.[3/3]

- •8. Понятия фаззификации, дефаззификации, лингвистической переменной. Пример. [1/1]

- •9. Операции с нечеткими множествами (эквивалентность, включение, нечеткая операция «и», «или», «не»). [1/2]

- •10.Обобщение операций пересечения и объединения в классе т-норм и s-конорм[1/2].

- •11. Нечеткие отношения. Композиционные правила (max-min) и (max-prod). Примеры. [1/1]

- •12. Нечеткие алгоритмы. Обобщенная схема процедуры нечеткого логического вывода. [1/2]

- •13. Нечеткие алгоритмы. Метод максимума-минимума (метод Мамдани) как метод нечеткого логического вывода (изложение необходимо сопроводить примером). [1/2]

- •14. Нечеткие алгоритмы. Метод максимума-произведения (метод Ларсена) как метод нечеткого логического вывода (изложение необходимо сопроводить примером)[1/1].

- •15.Методы дефаззификации[1/1].

- •16.Процедура (схема) нечеткого логического вывода. Пример нечеткого логического вывода для выполнения нескольких правил. Достоинства и недостатки систем, основанных на нечеткой логике[1/2].

- •17.Искусственные нейронные сети. Особенности биологического нейрона. Модель искусственного нейрона [1/2].

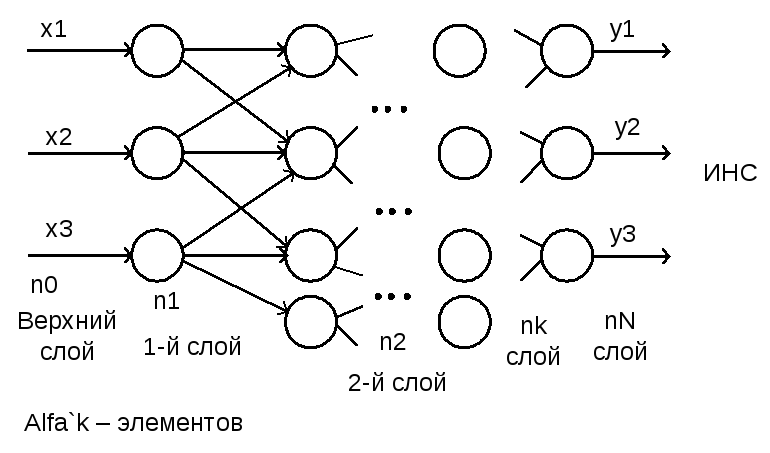

- •18.Определение искусственной нейронной сети (инс). Однослойный и многослойный персептроны [1/1].

- •19. Классификация инс. Задачи, решаемые с помощью нейронных сетей [1/2].

- •20.Основные этапы нейросетевого анализа. Классификация известных нейросетевых структур по типу связей и типу обучения и их применение [1/1].

- •21. Алгоритм обучения с учителем для многослойного персептрона [1/1]

- •22. Алгоритмы обучения нейронных сетей. Алгоритм обратного распространения ошибки [1/1]

- •23. Проблемы обучения нс[1/1].

- •24. Сети Кохонена. Постановка задачи кластеризации. Алгоритм кластеризации[1/1].

- •25. Преобразование алгоритма кластеризации с целью реализации в нейросетевом базисе. Структура сети Кохонена [1/1]

- •26. Алгоритм обучения без учителя для сетей Кохонена. Обобщенная процедура [1/1]

- •27. Алгоритм обучения без учителя для сетей Кохонена. Метод выпуклой комбинации. Графическая интерпретация [1/1]

- •28. Самоорганизующиеся карты (сок) Кохонена. Особенности обучения сок. Построение карт [1/1]

- •29. Проблемы обучения инс [1/1]

- •30. Генетические алгоритмы. Определение. Назначение. Сущность естественного отбора в природе [1/1]

- •31. Основные понятия генетических алгоритмов [1/1]

- •32. Блок-схема классического генетического алгоритма. Особенности инициализации. Пример. [1/1]

- •33. Блок-схема классического генетического алгоритма. Селекция хромосом. Метод рулетки. Пример.[1/2]

- •33. Блок-схема классического генетического алгоритма. Селекция хромосом. Метод рулетки. Пример.[2/2]

- •34. Блок-схема классического генетического алгоритма. Применение генетических операторов. Пример.[1/1]

- •35. Блок-схема классического генетического алгоритма. Проверка условия остановки га.[1/1]

- •36. Достоинства генетических алгоритмов.[1/1]

- •37. Гибридные сии и их виды.[1/2]

- •38. Структура мягкой экспертной системы.[1/1]

- •39.Методология разработки интеллектуальных систем. Виды прототипов экспертных систем.[1/1]

- •40.Обобщенная структура основных этапов разработки экспертных систем.[1/2]

- •1. Идентификация.

- •2. Концептуализация.

- •3. Формализация

- •4. Программирование.

- •5. Тестирование на полноту и целостность

20.Основные этапы нейросетевого анализа. Классификация известных нейросетевых структур по типу связей и типу обучения и их применение [1/1].

|

Тип обучения

Тип связей |

Обучение «с учителем» |

Обучение «без учителя» |

|

Без обратной связи |

Многослоный персептрон (задачи классификации и аппроксимации) |

Сети Кохонена конкурентные сети (задача кластеризации и сжатия данных) |

|

С обратной связью |

Рекуррентные аппроксиматоры (задача прогнозирования) |

Сети Хопфильда (задачи кластеризации, оптимизации, ассоциативная память) |

Основные этапы нейросетевого анализа:

Этап 1: Подготовка исходных данных. Формирование обучающей выборки. (Данные должны быть не противоречивыми).

Этап 2: Необходим выбор типа архитектуры НС.

– Выбор типа нейрона со своей функцией активации.

– Выбор количества входов и выходов, что связано с постановкой задачи.

– Выбор количества слоев и нейронов в каждом слое.

Этап 3: Подготовка данных.

– Кодирование входов/выходов.

– Нормировка данных (если необходимо).

– Обеспечение независимости между входами нейросети – предобработка данных

Этап 4: Процесс обучения сети.

Этап 5: Выбор нейросети, который наилучшим образом подходит по результатам обучения для решения задачи.

Этап 6: Оценка значимости ошибки, которую дает нейронную сеть для решения поставленной задачи.

В случае если нас не устраивает результат, то возвращаемся к этапу 2.

21. Алгоритм обучения с учителем для многослойного персептрона [1/1]

М ногослойный

персептрон – искусственная нейронная

сеть, в которой имеется несколько слоев

нейронов с настраиваемыми весами связи.

ногослойный

персептрон – искусственная нейронная

сеть, в которой имеется несколько слоев

нейронов с настраиваемыми весами связи.

Нейроны входных слоев принимают синоптические сигналы от нейронов предыдущих слоев.

![]() -

значение выходного сигнала j

к-го слоя.

-

значение выходного сигнала j

к-го слоя.

1-й слой

![]() ,

2-й слой

,

2-й слой![]() ,

…, к-й слой

,

…, к-й слой![]() ,

выходной слой

,

выходной слой![]() .

.

Обучение искусственной нейронной сети включает 2 этапа: 1) прямое распространение входного обучающего образа. 2) вычисление ошибки и ее образа распространения. 3) регулирование весов.

Этот метод основан на вычислении вектора градиента поверхности ошибок, который указывает на направление кратчайшего спуска по поверхности из данной точки. Последовательность шагов приводит после ряда итераций к минимуму поверхности ошибок. Алгоритм основан на ∆-правиле, которое гласит: «Корректировка весов на текущем шаге обучения осуществляется в направлении антиградиента функции ошибок». Минимизируемая функция ошибок:

![]() ,

где

,

где

![]() -

реальное выходное состояние нейронаj

выходного слоя нейросети при подаче на

ее входы k-го

образа;

-

реальное выходное состояние нейронаj

выходного слоя нейросети при подаче на

ее входы k-го

образа;

![]() -

требуемое, целевое выходное состояние

этого нейрона.

-

требуемое, целевое выходное состояние

этого нейрона.![]() ;

;![]()

![]() ;

;

![]()

22. Алгоритмы обучения нейронных сетей. Алгоритм обратного распространения ошибки [1/1]

Под обучением понимается целенаправленное изменение весовых коэффициентов синоптических связей нейронов сети из условий достижения требуемых характеристик сети, т.е. желаемая реакция на входные воздействия. В основе лежит базовый принцип обучения – минимизация эмпирической ошибки между желаемым выходом сети и фактической реакции сети. Теорема Розенблатта: Для любого данного набора входной векторов и любой требуемой их классификации алгоритм обучения через конечное число шагов приведет к вычислению требуемого набора весов, если таковой существует.

Существует 2 алгоритма обучения: 1) с учителем; 2) без учителя.

Обучение с учителем: обучение, которое производится под контролем внешнего «учителя», который оценивает поведение системы и управляет ее последующими модификациями. Используется в сетях, предназначен-ных для решения задач классификации, аппроксимации, прогнозирования. Обучение без учителя: Сеть путем самоорганизации делает необходимые изменения. Применяется в задачах кластеризации и сегментации для поддержки принятия решений.

Процедура обратного распространения ошибки.

Обучение искусственной нейронной сети включает 2 этапа: 1) прямое распространение входного обучающего образа. 2) вычисление ошибки и ее образа распространения. 3) регулирование весов.

Этот метод основан на вычислении вектора градиента поверхности ошибок, который указывает на направление кратчайшего спуска по поверхности из данной точки. Последовательность шагов приводит после ряда итераций к минимуму поверхности ошибок. Алгоритм основан на ∆-правиле, которое гласит: «Корректировка весов на текущем шаге обучения осуществляется в направлении антиградиента функции ошибок». Минимизируемая функция ошибок:

![]() ,

где

,

где

![]() -

реальное выходное состояние нейронаj

выходного слоя нейросети при подаче на

ее входы k-го

образа;

-

реальное выходное состояние нейронаj

выходного слоя нейросети при подаче на

ее входы k-го

образа;

![]() -

требуемое, целевое выходное состояние

этого нейрона.

-

требуемое, целевое выходное состояние

этого нейрона.![]() ;

;![]()

![]() ;

;

![]()