- •Лекція №1

- •1.1 Опрацювання результатів прямих вимірювань

- •1.1.1 Принципові основи оцінювання похибок вимірювань

- •1.1.2 Оцінка результату і похибки прямих вимірювань

- •1.1.3 Оцінка похибки прямих одноразових вимірювань

- •1.1.4 Оцінка результату і похибки прямих багаторазових вимірювань

- •1.1.5 Опрацювання результатів прямих одноразових вимірювань

- •1.1.6 Опрацювання результатів багаторазових прямих вимірювань

- •1.1.7 Опрацювання результатів прямих нерівноточних вимірювань

- •1.2 Опрацювання результатів опосередкованих вимірювань

- •1.2.1 Оцінка результату і похибки опосередкованих вимірювань

- •1.2.2 Опрацювання результатів опосередкованих вимірювань з лінійною залежністю

- •1.2.3 Опосередковані вимірювання при нелінійній залежності

- •1.2.4 Систематична похибка опосередкованих вимірювань при нелінійній залежності

- •1.2.5 Результат і похибка опосередкованих вимірювань

- •1.3 Оцінка результатів і похибок сумісних та сукупних вимірювань

- •Питання для самоперевірки

- •Лекція №2

- •2 Статистична перевірка гіпотез

- •2.1 Поняття статистичної гіпотези. Припустима і критична області. Статистичний критерій

- •Питання для самоперевірки

- •2.2 Гіпотези про параметри розподілу. Виникнення помилок першого та другого роду. Визначення обсягу випробувань

- •Питання для самоперевірки

- •2.3 Параметричні критерії розбіжностей для двох сукупностей. Критерії Фішера і Кохрена

- •Питання для самоперевірки

- •2.4 Критерії згоди

- •Питання для самоперевірки

- •2.5 Непараметричні критерії

- •Питання для самоперевірки

- •2.6 Перевірка гіпотез відносно частки ознаки порівняння двох вибірок

- •Питання для самоперевірки

- •Завдання планування експерименту

- •Лукція №3

- •3. Регресійний аналіз

- •3.1 Кореляційна залежність

- •3.2 Два основних завдання вимірювання зв’язків

- •3.3 Емпірична лінія регресії

- •3.4 Метод найменших квадратів

- •3.5 Множинний регресійний аналіз

- •3.6 Нелінійна регресія

- •Лекція №4

- •4. Активний експеримент

- •4.1 Ортогональні плани першого порядку

- •4.2 Повний факторний експеримент

- •4.3 Дисперсія відтворюваності

- •4.4 Оцінка адекватності апроксимуючої залежності досліджуваного

- •4.5 Оцінка значущості коефіцієнтів апроксимуючої залежності, взятій у вигляді алгебраїчного полінома, в сенсі відмінності значень цих коефіцієнтів від нуля

- •4.6 Обробка результатів експерименту

- •4.7 Дрібний факторний експеримент

- •4.8 Складання планів другого порядку

- •4.9 Ортогональні центрально-композиційні плани

- •Лекція №5

- •5. Планування експерименту при відшуканні екстремальної області

- •5.1 Класичні методи визначення екстремуму

- •5.2 Факторні методи визначення екстремуму

- •Лекція №6

- •6. Дисперсійний аналіз при експериментальному дослідженні

- •6.1 Однофакторний дисперсійний аналіз

- •Лекція №7

- •7. Приклади та завдання

- •Список літератури

3.4 Метод найменших квадратів

Нехай маємо N пар спостережень (x,y) , причому xt – фіксовані значення вхідної величини. Цьому набору відповідає деяке поле кореляції.

Необхідно

підібрати лінію регресії виду

![]()

яка

б найкращим чином описувала поведінку

об'єкта. Як вже відмічалося, через

наявність, наприклад, похибки вимірювання

значення вихідної величини ![]() також будуть

випадковими.

також будуть

випадковими.

Для

оцінки коефіцієнтів регресії

![]() і

і

![]() використовується

метод найменших квадратів (МНК), який

дозволяє мінімізувати суму квадратів

різниці відхилення експериментальних

даних

використовується

метод найменших квадратів (МНК), який

дозволяє мінімізувати суму квадратів

різниці відхилення експериментальних

даних

![]() і розрахункових значень, отриманих за

рівнянням регресії

і розрахункових значень, отриманих за

рівнянням регресії

![]()

МНК полягає в мінімізації функції

![]()

Для лінійної парної залежності маємо

![]()

При

знаходженні оцінок коефіцієнтів, які

задовольняють даним умовам, необхідно

взяти час ткові похідні

![]() і прирівняти до нуля. Отримаємо систему

рівнянь, яка називається системою

нормальних рівнянь. Число цих рівнянь

відповідає числу невідомих:

і прирівняти до нуля. Отримаємо систему

рівнянь, яка називається системою

нормальних рівнянь. Число цих рівнянь

відповідає числу невідомих:

Може бути нескінченна множина гіпотез про конкретний вид моделі (значення коефіцієнтів). Завдання полягає у виборі моделі, що найкращим чином описує поведінку об'єкта. Для цього скористуємося методом максимальної правдоподібнос ті:

Якщо маємо N вибраних точок, де проводились експерименти, то функція правдоподібнос ті дорівнюватиме добутку ймовірностей

Для отримання оцінок максимальної правдоподібності

![]()

Ця умова співпадає з умовою МНК.

Таким чином, МНК є частковим випадком методу максимальної правдоподібності при нормальному законі розподілу.

3.5 Множинний регресійний аналіз

На практиці випадкова вихідна величина Y час то залежить не від однієї, а кількох змінних. У такому разі можна говорити про поверхню регресії.

М(Y/X1 = X1, X2 = X2, … Xn=Xn)=φ(X1, X2, … Xn).

Будемо

розглядати лінійні моделі, для яких

функція регресії лінійна за параметрами

![]()

Для проведення регресійного аналізу необхідно виконання наступних умов:

- точніс ть, з якою задаються вхідні змінні (фактори_______) хj , що не є випадковими величинами, повинна бути високою;

- похибки вимірювань вихідної величини є випадковими з математичним очікуванням, рівним нулю;

- результати спостережень являють собою однорідні незалежні нормально розподілені величини;

- кожний фактор не є лінійною комбінацією інших факторів.

Таким чином регресія, що розглядається, має вигляд безумовного математичного очікування. Завдання множинного регресійного аналізу полягає в побудові такої прямої в n-мірному просторі, квадрат відхилення результатів спостереження від якого був би мінімальним.

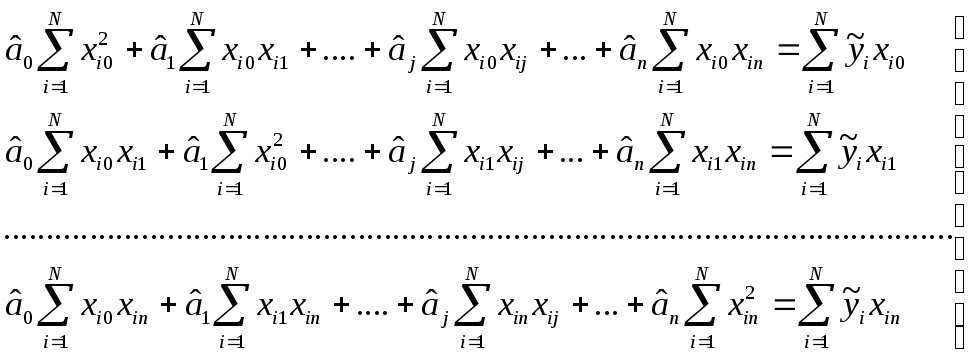

Виходячи із властивостей, які має система нормальних рівнянь, на основі якої визначається оцінка коефіцієнтів рівняння регресії, для n факторного експерименту можна записати:

(3.1)

(3.1)

Рішення даної системи рівнянь і дає значення оцінок коефіцієнтів âj методу найменших квадратів.

Аналіз рівнянь і методика с тає більш наглядними, а розрахункові процедури суттєво спрощуються, якщо використовуємо матричну форму запису. Сукупність вхідних величин представляємо у вигляді вектора, що

Рис.3.4 - Геометричне представлення методу найменших квадратів

подається на об’єкт, який досліджується, і вимірюються вихідні величини, які відповідають даній точці фактичного простору, утвореного вхідними величинами:

![]()

Результатами

даних спостережень при відомих Х

необхідно знайти вектор ![]() який є оцінкою методу найменших квадратів.

Геометрично це може

бути інтерпретовано

наступним чином. В ідеальному випадку

вектор вихідних величин представляється

у вигляді Y=XA. Через наявніс ть похибок

вектор спостережень результатів

експерименту буде

який є оцінкою методу найменших квадратів.

Геометрично це може

бути інтерпретовано

наступним чином. В ідеальному випадку

вектор вихідних величин представляється

у вигляді Y=XA. Через наявніс ть похибок

вектор спостережень результатів

експерименту буде ![]() За методом найменших

квадратів мінімізується значення

За методом найменших

квадратів мінімізується значення

![]()

Область

![]() в якій розташовані вектори вхідних

величин, являє собою гіперплощину (на

рис. 3.4 показаний двомірний випадок). У

цій же площині

в якій розташовані вектори вхідних

величин, являє собою гіперплощину (на

рис. 3.4 показаний двомірний випадок). У

цій же площині ![]() відображається вектор регреії

відображається вектор регреії ![]() Мінімальній відс тані між векторами

спостережень

Мінімальній відс тані між векторами

спостережень ![]() і гіперплощиною

і гіперплощиною ![]() відповідатиме довжина перпендикуляра,

опущеного із кінця цього вектора на

гіперплощину, тобто

відповідатиме довжина перпендикуляра,

опущеного із кінця цього вектора на

гіперплощину, тобто

![]() є

проекцією

є

проекцією

![]() на

область

на

область ![]() і квадрат довжини вектора

і квадрат довжини вектора ![]() буде мінімальним. Умова ортогональнос

ті різницевого вектора

буде мінімальним. Умова ортогональнос

ті різницевого вектора

![]() до

гіперплощини F може бути записана у

вигляді

до

гіперплощини F може бути записана у

вигляді

![]() де

Хt

– транспонована матриця вхідних величин

( по відношенню до матриці Х в ній стовпці

й рядки помінялися місцями). Одержуємо

нормальне рівняння у матричній формі:

де

Хt

– транспонована матриця вхідних величин

( по відношенню до матриці Х в ній стовпці

й рядки помінялися місцями). Одержуємо

нормальне рівняння у матричній формі:

![]() (3.2)

(3.2)

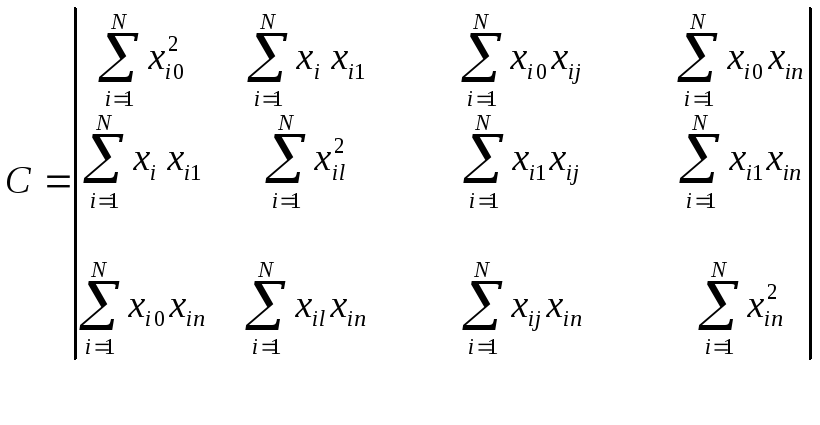

Матриця ХtХ=С називається інформаційною матрицею. Тоді нормальне рівняння можна переписати у вигляді

![]() (3.3)

(3.3)

і воно завжди має рішення.

Дійсно, для матриці Х, яка є матрицею плану (кожен рядок показує умови проведення і-го досліду), транспонована матриця буде:

Інформаційна матриця в цьому випадку

буде квадратною розмірністю (n+1)×(n+1).

Для

визначення вектора ![]() оцінок

МНК необхідно вираз (3.3) домножити зліва

на отриману матрицю С-1.

Оскільки матриця С квадратна, то її

можна обернути. Обернена матриця С-1

називається коваріаційною (дисперсійною).

оцінок

МНК необхідно вираз (3.3) домножити зліва

на отриману матрицю С-1.

Оскільки матриця С квадратна, то її

можна обернути. Обернена матриця С-1

називається коваріаційною (дисперсійною).

Перепишемо вираз (3.3) таким чином:

![]()

Добуток оберненої матриці на пряму дає одиничну матрицю. У результаті одержимо вираз для вектора оцінок коефіцієнтів:

![]() (3.4)

(3.4)

Кожний коефіцієнт множинної регресії визначається з виразу:

![]() (3.5)

(3.5)

де Сij – елементи матриці С-1 .

Знаходження варіаційної матриці С-1 при значній кількості факторів n -складне і трудоємне завдання. Якщо при перевірці моделі встановлено, що точність апроксимації мала, то все треба починати спочатку, оскільки будь-яка добавка (значення) елементів у рівнянні прогресії відповідно до (3.5) приведе до зміни значень усіх коефіцієнтів аj. Таким чином, після уточнення рівняння регресії необхідно знову транспонувати матрицю, а потім відповідно до (3.5) визначати аj, тобто всі коефіцієнти рівняння регресії взаємопов’язані.

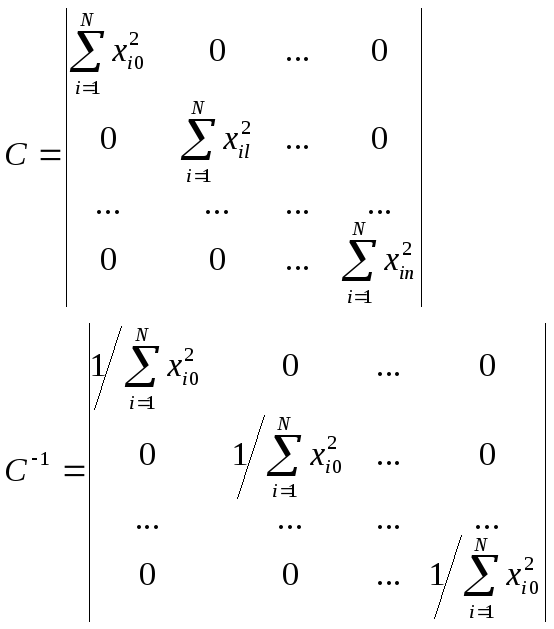

Відомо, що прос то обертається діагональна матриця – матриця, в якій всі елементи, крім тих, що стоять на головній діагоналі, дорівнюють нулю. Для обернення матриці С в діагональну треба виконати умову

![]()

![]()

яка називається умовою ортогональності і може використовуватися в томувипадку, коли в n-мірному факторному просторі кожному з факторів поставити у відповідність одну із взаємноперпендикулярних осей. Тоді матриця С і відповідна їй коваріаційна матриця С-1 матимуть вигляд

Прийнявши умову, що

а

також, що матриця С-1

діагональна, вираз

![]() можна

подати

можна

подати

наступним чином:

У

результаті ос танній вираз, а значить,

вираз

![]() розпадається

на (n+1) незалежних рівнянь, які дозволяють

незалежно знаходити оцінки коефіцієнтів

рівняння множинної регресії:

розпадається

на (n+1) незалежних рівнянь, які дозволяють

незалежно знаходити оцінки коефіцієнтів

рівняння множинної регресії:

(3.6)

(3.6)

Розглянемо,

які властивості мають оцінки найменших

квадратів коефіцієнтів рівняння

множинної регресії, одержаних із

матричного рівняння ![]() .

Оскільки вважається, що похибки вимірювань

вихідної величини є зміщеними, то

математичне очікування матриці ( точніше

вектор – стовпчики) похибок дорівнює

нулю Е[ε]=0. Визначимо, чому дорівнює

математичне очікування оцінки вектора

коефіцієнтів

.

Оскільки вважається, що похибки вимірювань

вихідної величини є зміщеними, то

математичне очікування матриці ( точніше

вектор – стовпчики) похибок дорівнює

нулю Е[ε]=0. Визначимо, чому дорівнює

математичне очікування оцінки вектора

коефіцієнтів ![]() ,

тобто

,

тобто

![]()

Взявши

до уваги, що

![]() і

Е[ε]=0, одержимо

і

Е[ε]=0, одержимо

![]()

тобто

вектор

![]() є незміщеною оцінкою вектора А. Для

визначення дисперсії одержаних оцінок

коефіцієнтів скористуємося виразом

(3.4), тоді

є незміщеною оцінкою вектора А. Для

визначення дисперсії одержаних оцінок

коефіцієнтів скористуємося виразом

(3.4), тоді

![]()

Оскільки

матриця C-1X

t

детермінована, а ![]() - випадкова матриця,

то можна записати

- випадкова матриця,

то можна записати

![]() (3.7)

(3.7)

Дисперсія спостережень (результатів вимірювань) визначається так:

![]()

Якщо

похибки

вимірювання

вихідної

величини

некорельовані

і

мають

однакову

дисперсію,

тобто

![]() ,

,

![]() ,

де

ln

–

одинична

матриця.

,

де

ln

–

одинична

матриця.

Підставимо у вираз (3.7):

![]() (3.8)

(3.8)

і

одержимо, що коли як оцінку вектора А

вибираємо саме вектор-стовпчик А(оцінку

найменших квадратів), то дана оцінка

має найменшу дисперсію. Якщо похибки

![]() незалежні і однаково

розподілені, то

незалежні і однаково

розподілені, то

![]() до

того ж є і ефективною.

до

того ж є і ефективною.

Для

випадку, коли похибки

![]() корельовані,

корельовані,

![]() ,

де W – відома, позитивно визначена

матриця, тоді оцінка найменших квадратів

для вектора А

,

де W – відома, позитивно визначена

матриця, тоді оцінка найменших квадратів

для вектора А

![]()

і називається узагальненою оцінкою найменших квадратів, а для випадку, коли матриця W діагональна, то зваженою оцінкою.

Якщо матриця W діагональна з елементами W-1, то зважена оцінка найменших квадратів для вектора А і дисперсія цієї оцінки визначаться так: