- •Основи автоматики

- •Луцьк - 2007 Вступ

- •Цифрові електронно-обчислювальні машини

- •Інформація

- •Електронні ключі

- •Діодні ключи

- •Оптоелектроні прилади. Фотодіоди, фото транзистори, світло діоди, оптрони. Оптоелектроні ключі і схеми гальванічної розв’язки кіл.

- •Фотодіоди

- •Лавинні фотодіоди

- •Фототранзистори

- •Елементи алгебри і логіки.

- •Системи (серії) логічних елементів. Базові елементи інтегральних схем виду ттл і кмон

- •Вивчення тригерів. Їх схемотехнічна реалізація

- •Тригером називається пристрій, що може знаходитися у двох станах стійкої рівноваги й здатний стрибком переходити з одного стану в інший під впливом зовнішнього сигналу керування.

- •Генератори і формувачі імпульсів на логічних елементах (мультивібратори і схеми усунення деренчання контактних датчиків інформації).

- •Регістри (послідовні, паралельні, універсальні). Їх використання в якості запам’ятовуючих пристроїв та перетворювачів інформації.

- •Лічильники (двійкові, з довільним коефіцієнтом рахунку, реверсні, з попередвстановленням). Подання вихідної інформації в позиціонному, двійковиму і двійково-десятковому коді

- •Його часові діаграми та схематичне позначення

- •Перетворювачі кодів шифратори і дешифратори. Мультиплексори, демультиплексори.

- •Суматори. Однорозрядний двійковий суматор. Багаторозрядні війкові суматори паралельного типу.

- •Споживана мікросхемою пам’яті потужність зазвичай вказується, виходячи із розрахунку на 1 біт.

- •Режим зберігання - забезпечується надходженням 0 по адресній шині рядка, при цьому транзистор vt5 закривається й ізолює тригер від розрядної шини.

- •Зовнішні запам’ятовуючі пристрої

- •В радіальних інтерфейсах використовуються індивідуальні для кожного пп лінії, по яких відбувається передача тільки між цим пп і центральним пристроєм (цп).

- •Зовнішні пристрої введення (клавіатура, фото стрічка). Візуалізація інформації (дисплей, друкувальний пристрій).

- •Характеристики мікропроцесорів.

- •Структура мікропроцесора

- •Системи автоматичного контролю, регулювання, керування.

- •Цифро-аналогові та аналого-цифрові перетворювачі.

- •Цифро-аналогові перетворювачі

- •Аналогово-цифрові перетворювачі

- •Перетворювачі інформації в електричний сигнал в приладах автоматики. Фото-, тензо- і терморезистори. Ємнісні і індуктивні перетворювачі.

- •Виконуючі та індикаторні пристрої в автоматичних системах

- •Автоматика в школі. Шкільний кабінет обчислювальної техніки. Вимоги до навчальної обчислювальної техніки та її програмного забезпечення.

- •Обладнання робочого місця учня.

- •Обладнання мережного забезпечення

- •Електронні ключі………………………………………………………………………………….

- •Вивчення тригерів.Їх схемотехнічна реалізація………………………………………………………………….

- •Регістри (послідовні, паралельні, універсальні).Їх використання в якості запам’ятовуючих пристроїв та перетворювачів інформації…………………………………….

- •Виконуючі та індикаторні пристрої в автоматичних системах………………………………………………………..

- •Література………………………………………………………..…..

- •Додаток 1. Функціональна класифікація імс

- •Додаток 2. Елементи цифрової електроніки та їх зарубіжні аналоги

Інформація

Термін "інформація" походить від латинського що означає раз’яснення, виклад.

За своїми видами інформація поділяється на - вхідну, внутрішню і вихідну. Вхідна інформація, переходячи у внутрішню піддається переробці, перерозподілу і перетворенню і лише потім стає вихідною, котра, у свою чергу, для іншого об'єкта стає вхідною і т.д.

Становить інтерес порівняння роботи з інформацією людини й ЕОМ. Слід зазначити, що практично всю інформацію людин, як правило сприймає за допомогою аналізаторів (органів почуттів) аудіовізуальному способом (практично 90%, візуально і 9% - аудиально). Процес переробки, перерозподіл і преобразования інформації (внутрішня інформація) відбувається в головному мозку (права півкуля - образно-логічне, ліве - розрахункову вихідну інформацію людина відтворює за допомогою органів мови і опорно-рухової системи.

Інформація із середини ХХ сторіччя розглядається як загальнонаукове поняття, що включає в себе обмін відомостями між людьми, людиною та автоматом, автоматом та автоматом; обмін сигналами у тваринному та рослинному світі, генетичну інформацію.

Робота автоматичних комплексів машин та агрегатів неможлива без інформаційного обміну між окремими пристроями та їх частинами. Тому, для того, щоб розібратися в роботі автоматичних систем управління, слід конкретизувати, що саме ми розуміємо під поняттям “інформація”, коли використовуємо його у технічних системах.

Складність поняття “інформація” пов’язана з тим, що воно має ряд аспектів. У семантичному аспекті – це поняття первинне й відповідає термінам “відомості”, “знання”. Перешкодою для використання семантичного трактування поняття “інформація” у технічних системах є складність конкретизації кількісної міри інформації у прагматичному аспекті, оскільки вона вводиться на основі визна-чення цінності цієї інформації для її отримувача, користувача.

На відміну від інших, у математичному аспекті кількісна міра інформації легко вводиться на основі ймовірнісного трактування інформаційного обміну. Цей спосіб вимірювання кількості інформації вперше запропонував К. Шеннон у 1948 р.

Згiдно з К. Шенноном, iнформацiя – це мiра тiєї неозначеностi, яка зникає пiсля отримання вiдомостей про систему.

У теорiї iнформацiї вводиться важлива величина – кiлькiсть iнформацiї. Розглянемо простий приклад. Кожний раз, коли пiдкидається шестигранний кубик, ми отримуємо вiдомостi про цифри на його гранях. У такий спосiб зменшується неозначенiсть або наше незнання про систему. Для кубика число рiвноймовiрних подiй N = 6. Чим бiльше число N, тим бiльша неозначенiсть системи до отримання вiдомостей про неї. При отриманнi вiдомостей про систему кiлькiсть iнформацiї сумується. Для забезпечення умови адитивностi необхiдно допустити, що кiлькiсть iнформацiї I є логарифмiчною функцiєю вiд числа подiй або мiкростанiв N. Для рiвноiмовiрних подiй:

I = lg2 N . (4)

При визначеннi кiлькостi iнформацiї обраний логарифм за основою 2; при цьому представлення кiлькостi iнформацiї вiдбувається у двiйковому (або бiнарному) кодi. Джерело iнформацiї здiйснює вибiр мiж двома можливостями “так” чи “нi” або “1” чи “0”. У двiйковому кодi будь-яке число мiкростанiв N можна уявити як

N = 2 n i I = lg 2 2n , (5)

де n – кiлькiсть двiйкових комiрок. Одиниця кiлькостi iнформацiї у бiнарному представленнi обирається таким чином. Якщо система має всього два мiкростани (N = 2) i для отримання повної iнформацiї достатньо однiєї вiдомостi (n = 1), тодi кiлькiсть iнформацiї становить один бiт. Кiлькiсть iнформацiї оцiнюють у бiтах. Для передачi одного двiйкового символу необхiдна iнформацiя у один бiт. Якщо N = 8 (тобто N = 23 ), тодi кiлькiсть iнформацiї I = 3 бiт. Якщо N = 2n , тодi iнформацiйний змiст системи становить n бiт.

Двiйкова система широко використовується у ЕОМ для запису iнформацiї в пам’ять машини. Мiнiмальною одиницею iнформацiї, що адресується та обробляється в машинi, є байт – 8 двiйкових розрядiв, порядковi номери яких розташовуються вiд нуля до семи (злiва направо). Одна комiрка пам’ятi має 1 бiт, тобто можна обрати 0 або 1. Значить, n = 1, a N = 2. Якщо є двi комiрки (N = 22), тодi можемо отримати велику кiлькiсть комбiнацiй у двiйковiй системi: 00, 01, 11, 10. Таким чином, отримаємо N = 22 = 4 мiкростани i I = 2 бiт. Байт має 8 бiт iнформацiї, а це значить, що число мiкростанiв N = 256.

Кожний з мiкростанiв системи можна отримати в результатi одного з можливих повiдомлень. Ймовiрнiсть появи будь-якого з таких повiдомлень, якщо всi вони рiвноймовiрнi, запишеться як

P = 1/N (6)

Тоді кiлькiсть iнформацiї буде дорiвнювати:

I = lg2 1/p = – lg2 p. (7)

Якщо подiї не рiвноймовiрнi, тодi, за К. Шенноном, визначаємо середню кiлькiсть iнформацiї H(X) джерела iнформацiї з N мiкростанами:

N

H ( X ) = – p ( Xi ) lg2 p ( Xi ). (8)

i=1

Ця кiлькiсть називається ентропiєю, позаяк вона формально еквiвалентна термодинамiчнiй ентропiї. Максимальне значення H(X) буде тоді, коли p(Xi) = 1/N:

H ( X )max = lg2 N. (9)

Величину lg2N називають кiлькiстю розв’язкiв. Вона показує середню кількість бiнарних розв’язкiв, якi необхiднi для вибору однiєї з N ситуацiй.

Рис. 8. Шенонівський канал передачі інформації: Х – джерело інформації; Y – приймач інформації; 1 – кодуючий пристрій; 2 – канал передачі інформації; 3 –декодуючий пристрій; 4 – джерело спотворення інформації.

Загальна теорiя зв’язку розвинута Шеноном. У шенонівському iнформацiйному каналi (рис. 4.1) є джерело (Х) та приймач (Y) iнформацiї. Інформацiя надходить у iнформацiйний канал 2 через кодуючий пристрiй 1 (шифратор). Приймач приймає iнформацiю пiсля декодування 3 (дешифрацiї). Наявнiсть джерела шумiв 4 (завад) спотворює iнформацiю в каналi передачi iнформацiї. Якщо позначити енропiю джерела iнформацiї як H(X), а приймача як H(Y), зв’язок приймача з джерелом iнформацiї характеризується кiлькiстю трансформацiї (Т):

H ( X ) + H ( Y ) – H ( X , Y ) , (10)

де H(X,Y) – ентропiя зв’язку.

Далі розраховуємо максимальне значення Т, так звану потужнiсть каналу, тобто максимальну вeличину можливої iнформацiї, що протiкає через канал:

С = (T/)max , (11)

де – середнiй час передачi на один iнформацiйний символ.

У випадку аналогових каналiв потужнiсть каналу розраховується на основі смуги пропускання В потужності сигналу S i потужностi шуму m на приймачi:

_______

C = 2B lg2 S + m/m (12)

Максимальний потiк iнформацiї називають пропускною здатнiстю каналу.

Для вчителя фізики цікаво знати деякi типовi значення потужностi каналiв при передачi технiчної iнформацiї:

– телевiзiйний канал – С = 7 107 бiт.с-1 ;

– телефонний канал – С = 5 104 бiт.с-1 ;

– телеграфний канал – С = 5 101 бiт.с-1 .

Потужнiсть технiчних каналiв бiльш або менш наближується до iнформацiйної потужностi наших органiв чуття:

– око – С = 3 106 бiт.с-1 ;

– вухо – С = 4 104 бiт.с-1 .

Порівняно з цими значеннями величина потужностi засвоєння iнформацiї людиною порівняно нижча:

– читання про себе – С = 4,5 101 бiт.с-1 ;

– читання вголос – С = 3 101 бiт.с-1 ;

– друкування – С = 1,6 101 бiт.с-1 ;

-

пiдрахунки – С = 3 бiт.с-1 .

***

Оскільки сучасні ЕОМ побудовані за аналогією з законами роботи мозку людини, то подібним чином відбувається переробка інформації й в ЕОМ. Вхідна інформація надходить при допомозі пристроїв вводу. Безпосередньо в ЕОМ відбувається всі процеси, пов’язані з переробкою, перерозподілом і перетворенням інформації. Вихідна інформація відтворюється при допомозі пристроїв виводу.

Можна відмітити, що обмін інформації в ЕОМ між оперативною (ОЗП) і постійною (ПЗП) пам’яттю відбувається знову ж таки за аналогією з обміном інформації між лівою і правою півкулями головного мозку людини.

До основних властивостей інформації відносяться: своєчасність, достовірність, цінність, повнота, доступність, визначеність, глибина, переконливість.

В обчислювальній техніці взагалі і мікропроцесорної в частковості і зокрема для передачі інформації використовуються терміни “біт”, “слово”, “байт”.

Біт (від англійського binary digit - двійковий розряд) цей розряд двійкового числа: 0 або 1.

Слово – закінчена послідовність символів (нулів і одиниць) визначеної довжини або сигналів, що відповідають цим символам.

Машинне слово – спеціальна послідовність нулів і одиниць, яка може бути прочитана або інтерпретована ЕОМ даного типу.

Байт (від анг. byte) – восьми бітне число, розглядається як одиниця для обміну цифровою інформацією між пристроями мікропроцесорної систем.

***

Електричне коло, як пристрій для перетворення сигналів.

Перехідні процеси в RC i LC колах.

Використання в RC колах в якості скорочуючого, розділяючого й розширяючого ланцюжка.

Ключі на транзисторах та у інтегральному виконанні

В електронних колах широко використовується пасивні кола - чотириполюсникі, складається із простих комбінацій елементів електричної схеми. Частіше за всіх зустрічаються ділянки з резисторів і конденсаторів(RC – кола).

Так RC–кола, рис.9а в залежності від співвідношення параметрів використовується для розділення постійної і змінної складової вхідного сигналу, а також для диференціювання вхідного сигналу, тобто для одержання вихідної напруги, пропорційної похідній вхідної напруги по часу.

Рис. 9. RC-кола

RC кола на рис. 9б використовуються для фільтрування змінної складової напруги, а також для інтегрування вхідного сигналу по часу.

Характеристики RC кола для поставленого режиму в випадку синусоїдального сигналу Uвх розглянемо за допомогою символічного метода.

Запишемо вираз для струму І, протікающого через RC кола рис. 1а , і напруги на її виході Uвих:

(12)

Uвих=

IR =Uвх

(12)

Uвих=

IR =Uвх (13)

(13)

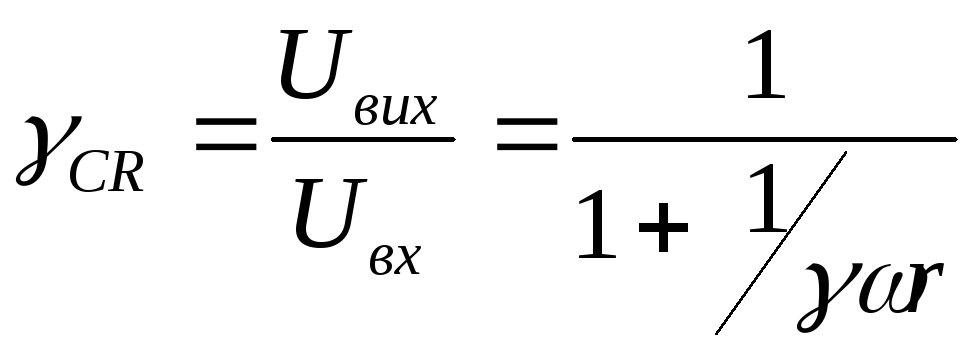

Із (13) знайдемо коефіцієнт передачі по напрузі кола:

,(14)

,(14)

де τ = RC—постійна часу RC-кола .

Фізична

стала часу характеризує відносну

швидкість зміни напруги на конденсаторі

при його заряді чи розряді. За час t

= τ напруга

на конденсаторі при розряді зміниться

на

![]() від початкового, а при заряді на

від початкового, а при заряді на![]() від свого максимального значення.

від свого максимального значення.

Комплексний

характер коефіцієнта передачі γCR

показує, що синусоїдальний сигнал,

проходячи через RC-коло,

зменшеться по амплітуді в

![]() раз і зсовується за фазою на кут φCR:

раз і зсовується за фазою на кут φCR:

(15)

(15)

φCR=arctg 1/ωτ (16)

Ці формули є аналітичними виразами для амплітудно-частотної й фазочастотної характеристики RC-кола.

Аналогічно

можна показати, що вираз для коефіцієнта

передачі RC-кола

рис.9б в комплексної формі буде

(17)

(17)

![]() (18)

(18)

![]() (19)

(19)

Запишимо модуль і аргумент виразу (6)

Коли

для схеми на рис.9а вибір її елементів

задовольняє допоміжні умови, які

забезпечують рівність

![]() (20)

(20)

де а- коеф., пропорційності, то враховуючи, що

Uвих

= IR (10)

![]() (21)

(21)

Отримаємо

![]() (22)

(22)

При цьому використовується імпульсний сигнал оскільки похідна від гармонічних функцій являється токож гармонічною функцією. Коли довжина прямокутного імпульсу задовольняє умови

![]() (23)

(23)

то UR=Uвх-Uвих=Uвх-IR=Uвх (24)

таким

чином,

![]() (25)

(25)

де

![]()

В розглянутому випадку диференціюється стала за величиною на відрізку часу τі функція Uвх. Похідна від сталої рівна 0 тобто умова ідеального диференціювання слідуюча: а=0.

Інтегрування сигналів можна виконати при допомозі схеми рис. 9б, коли вибір її елементів задовольняє умови, які задовольняють рівність

![]() (26)

(26)

За причиною поданою вище, зручно розглядати інтегральні прямокутні імпульси, тобто сталу на інтервалі τ0 напруги. Тоді стала на виході

![]() (27)

(27)

Враховуючи (11) отримаємо:

![]() (28)

(28)

![]() (29)

(29)

Коли довжина прямокутного імпульсу задовольняє умови τn<<τ

Uвх

= UR

+ UC

![]() UR

UR

![]() I R (30)

I R (30)

або

I

![]() (31)

(31)

тоді

Uвих

![]()

![]() dt

(32)

dt

(32)

де

![]() =b

(33)

=b

(33)

інтегрування імпульсів використовують в імпульсних пристроях для одержання лінійно – змінної напруги, а диференціювання – для скорочення запускаючих імпульсів.