- •Министерство образования и науки, молодёжи и спорта украины

- •Тема 1. Предмет теории информации и количественная мера информации

- •1.2 Этапы обращения информации

- •1.3 Система передачи информации

- •1.4 Задачи и постулаты прикладной теории информации

- •1.5. Количественная оценка информации дискретного источника. Энтропия.

- •1.6 Фундаментальные свойства энтропии

- •Тема 2. Основные виды энтропии дискретных источников. Условная и взаимная энтропии.

- •2.1 Условная энтропия.

- •2.2 Основные свойства условной энтропии.

- •2.3 Взаимная энтропия. Свойства энтропии объединения.

- •Тема 3. Эффективное кодирование источника дискретных сообщений в канале без помех.

- •3.1 Избыточность информации, причины ее появления.

- •3.2 Способы сокращения избыточности.

- •3.3 Теорема Шеннона для канала без помех.

- •4.1 Общие понятия и элементы теории кодирования

- •4.2 Цели кодирования

- •4.3 Оптимальные неравномерные коды

- •4.4 Коды Шеннона-Фэно

- •4.5 Коды Хаффмена

- •4.6 Особенности эффективных кодов.

- •Тема 4. Кодирование источника дискретных сообщений в канале с помехами. Общие принципы помехоустойчивого кодирования.

- •5.1 Кодирование информации для канала с помехами. Теорема Шеннона для канала с помехами.

- •5.2 Общие принципы использования избыточности

- •5.3 Связь корректирующей способности кода с кодовым расстоянием

- •6.1 Корректирующие свойства кодов с избыточностью.

- •6.2 Классификация корректирующих кодов

- •Тема 5. Регулярные методы построения двоичных помехоустойчивых кодов

- •7.1 Линейные коды. Общие медоды построения.

- •7.2 Определение числа добавочных разрядов r.

- •7.3 Построение образующей(порождающей) матрицы |om|.

- •7.4 Порядок кодирования

- •7.5 Порядок декодирования

- •7.6 Систематические коды. Код Хэмминга.

- •7.7 Обнаружение и исправление ошибок в коде Хэмминга

- •8.1 Двоичные циклические коды

- •8.2 Некоторые свойства циклических кодов

- •8.3 Матричное описание циклических кодов

- •8.4 Выбор образующего полинома

- •8.5 Декодирование циклических кодов

- •Тема 6. Построение кодов заданой помехоустойчивости. Применение недвоичных помехоустойчивых кодов.

- •9.1 Матричное описание циклических кодов.

- •9.2 Коды Боуза — Чоудхури — Хоквингема (бчх)

- •9.3 Систематический вид циклического кода.

- •9.4 Коды Рида–Соломона и их применение.

- •9.5 Циклический избыточный код crc

- •Тема 7. Информационные характеристики источников непрерывных сообщений. Источники с максимальной энтропией. Максимальная пропускающая способность канала связи с помехами.

- •10.1 Информационные характеристики источников непрерывных сообщений

- •10.2 Энтропия равномерного закона распределения

- •10.3 Энтропия гауссового закона распределения.

- •11.1 Пропускная способность канала связи с помехами для непрерывных сообщений

- •Тема 8. Методы кодирования информации со сжатием.

- •12.1 Подстановочные или словарно-ориентированные алгоритмы сжатия информации. Методы Лемпела-Зива.

- •13.1 Описание алгоритма сжатия lzw

- •Декодирование по lzw

- •Достоинства и недостатки lzw

- •13.2 Применение lz-алгоритмов упаковки данных

- •14.1 Кодирование длин повторений

- •14.2 Дифференциальное кодирование

- •Тема 9. Методы кодирования со сжатием и с потерями информации..

- •15.1 Методы сжатия с потерей информации

- •15.2 Точность. Помехи и искажения. Приближенное восстановление

- •15.5 Кодирование преобразований. Стандарт сжатия jpeg

- •Или же, в матричной форме,

- •Тема 10. Методы кодирования физических сигналов в компьютерных сетях.

- •16.1 Кодирование на физическом уровне.

- •16.2 Самонихронизирующиеся коды - коды rz и Манчестер-II

- •16.3 Несамосинхронизирующиеся коды. - код nrz

- •16.4 Высокоскоростные коды - код mlt-3 и pam 5

- •Еще более высокоскоростной код - код pam 5

- •16.5 Требуемая полоса частот для передачи данных и ширина спектра сигнала

- •Ширина спектра сигнала

1.6 Фундаментальные свойства энтропии

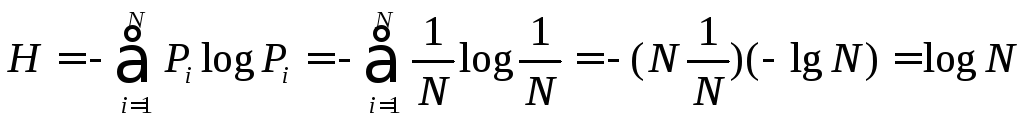

При равновероятности знаков алфавита Pi = 1/N из формулы Шеннона получают:

Из этого следует, что при равновероятности символов алфавита энтропия определяется исключительно числом символов алфавита и по существу является характеристикой только числа символов алфавита.

Если же знаки алфавита неравновероятны, то алфавит можно рассматривать как дискретную случайную величину, заданную статистическим распределением частот появления знаков Xi(или вероятностей Pi =ni / n) табл. 1:

Таблица 1.

|

Символы Xi |

X1 |

X2 |

… |

Xm |

|

Вероятности Pi |

P1 |

P2 |

… |

Pm |

Такие распределения получают обычно на основе статистического анализа конкретных типов сообщений (например, русских или английских текстов и т.п.).

Поэтому, если знаки алфавита неравновероятны и хотя формально в выражение для энтропии входят вероятности появления его знаков, энтропия отражает статистические свойства некоторой совокупности сообщений.

Еще раз вернемся к понятию энтропии источника сообщений.

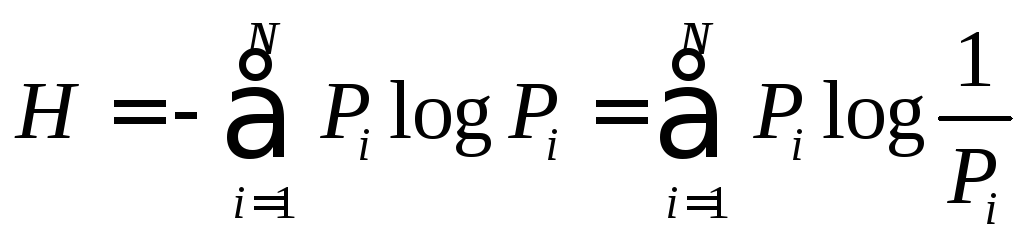

В выражении для энтропии

величина log 1/Pi представляет частную энтропию, характеризующую информативность знака хi, а энтропия Н - есть среднее значение частных энтропий. Таким образом еще раз подчеркнем, что энтропия H источника выражает СРЕДНЮЮ энтропию на один символ алфавита.

Функция (Pi • log Pi) отражает вклад знака Xi в энтропию Н. При вероятности появления знака Pi=1 эта функция равна нулю, затем возрастает до своего максимума, а при дальнейшем уменьшении Pi стремится к нулю

Основные свойства энтропии

Энтропия Н - величина вещественная, неотрицательная и ограниченная, т.е. Н > 0 (это свойство следует из того, что такими же качествами обладают все ее слагаемые Pi log (1/Pi).

Энтропия равна нулю, если сообщение известно заранее (в этом случае каждый элемент сообщения замещается некоторым знаком с вероятностью, равной единице, а вероятности остальных знаков равны нулю).

Энтропия максимальна, если все знаки алфавита равновероятны, т.е. Нmах = log N.

Таким образом, степень неопределенности источника информации зависит не только от числа состояний, но и от вероятностей этих состояний. При неравновероятных состояниях свобода выбора источника ограничивается, что должно приводить к уменьшению неопределенности. Если источник информации имеет, например, два возможных состояния с вероятностями 0,99 и 0,01, то неопределенность выбора у него значительно меньше, чем у источника, имеющего два равновероятных состояния. Действительно, в первом случае результат практически предрешен (реализация состояния, вероятность которого равна 0,99), а во втором случае неопределенность максимальна, поскольку никакого обоснованного предположения о результате выбора сделать нельзя. Ясно также, что весьма малое изменение вероятностей состояний вызывает соответственно незначительное изменение неопределенности выбора.

Особый интерес представляют бинарные источники, использующие алфавит из двух знаков: (0,1), При N = 2 сумма вероятностей знаков алфавита: P1+Р0 = 1. Можно положить P1 = Р, тогда Р0 = 1-Р.

Энтропию можно определить по формуле:

![]()

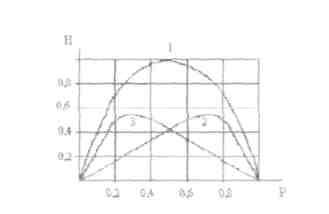

Энтропия бинарных сообщений достигает максимального значения, равного 1 биту, когда знаки алфавита сообщении равновероятны, т.е. при Р 0,5, и ее график симметричен относительно этого значения, (рис.3).

Рис. 1.3. График зависимости энтропии Н двоичных сообщений и ее составляющих : - (1 - Р) log (1 - Р) и - Р log P от Р.

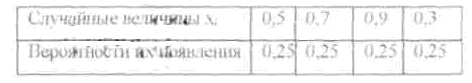

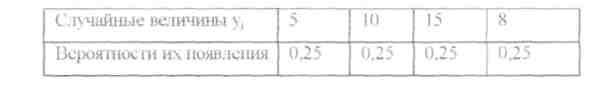

Пример Заданы ансамбли X и Y двух дискретных величи

Таблица A

Таблица B.

Сравнить их энтропии.

Решение: Энтропия не зависит от конкретных значений случайной величины. Так как вероятности их появления в обоих случаях одинаковы, то

Н(Х) = H(Y) = ∑Pi*log(Pi)= - 4(0,251og0,25) = -4(l/41ogl/4) -= log 4=2 бит/c