- •Министерство образования и науки, молодёжи и спорта украины

- •Тема 1. Предмет теории информации и количественная мера информации

- •1.2 Этапы обращения информации

- •1.3 Система передачи информации

- •1.4 Задачи и постулаты прикладной теории информации

- •1.5. Количественная оценка информации дискретного источника. Энтропия.

- •1.6 Фундаментальные свойства энтропии

- •Тема 2. Основные виды энтропии дискретных источников. Условная и взаимная энтропии.

- •2.1 Условная энтропия.

- •2.2 Основные свойства условной энтропии.

- •2.3 Взаимная энтропия. Свойства энтропии объединения.

- •Тема 3. Эффективное кодирование источника дискретных сообщений в канале без помех.

- •3.1 Избыточность информации, причины ее появления.

- •3.2 Способы сокращения избыточности.

- •3.3 Теорема Шеннона для канала без помех.

- •4.1 Общие понятия и элементы теории кодирования

- •4.2 Цели кодирования

- •4.3 Оптимальные неравномерные коды

- •4.4 Коды Шеннона-Фэно

- •4.5 Коды Хаффмена

- •4.6 Особенности эффективных кодов.

- •Тема 4. Кодирование источника дискретных сообщений в канале с помехами. Общие принципы помехоустойчивого кодирования.

- •5.1 Кодирование информации для канала с помехами. Теорема Шеннона для канала с помехами.

- •5.2 Общие принципы использования избыточности

- •5.3 Связь корректирующей способности кода с кодовым расстоянием

- •6.1 Корректирующие свойства кодов с избыточностью.

- •6.2 Классификация корректирующих кодов

- •Тема 5. Регулярные методы построения двоичных помехоустойчивых кодов

- •7.1 Линейные коды. Общие медоды построения.

- •7.2 Определение числа добавочных разрядов r.

- •7.3 Построение образующей(порождающей) матрицы |om|.

- •7.4 Порядок кодирования

- •7.5 Порядок декодирования

- •7.6 Систематические коды. Код Хэмминга.

- •7.7 Обнаружение и исправление ошибок в коде Хэмминга

- •8.1 Двоичные циклические коды

- •8.2 Некоторые свойства циклических кодов

- •8.3 Матричное описание циклических кодов

- •8.4 Выбор образующего полинома

- •8.5 Декодирование циклических кодов

- •Тема 6. Построение кодов заданой помехоустойчивости. Применение недвоичных помехоустойчивых кодов.

- •9.1 Матричное описание циклических кодов.

- •9.2 Коды Боуза — Чоудхури — Хоквингема (бчх)

- •9.3 Систематический вид циклического кода.

- •9.4 Коды Рида–Соломона и их применение.

- •9.5 Циклический избыточный код crc

- •Тема 7. Информационные характеристики источников непрерывных сообщений. Источники с максимальной энтропией. Максимальная пропускающая способность канала связи с помехами.

- •10.1 Информационные характеристики источников непрерывных сообщений

- •10.2 Энтропия равномерного закона распределения

- •10.3 Энтропия гауссового закона распределения.

- •11.1 Пропускная способность канала связи с помехами для непрерывных сообщений

- •Тема 8. Методы кодирования информации со сжатием.

- •12.1 Подстановочные или словарно-ориентированные алгоритмы сжатия информации. Методы Лемпела-Зива.

- •13.1 Описание алгоритма сжатия lzw

- •Декодирование по lzw

- •Достоинства и недостатки lzw

- •13.2 Применение lz-алгоритмов упаковки данных

- •14.1 Кодирование длин повторений

- •14.2 Дифференциальное кодирование

- •Тема 9. Методы кодирования со сжатием и с потерями информации..

- •15.1 Методы сжатия с потерей информации

- •15.2 Точность. Помехи и искажения. Приближенное восстановление

- •15.5 Кодирование преобразований. Стандарт сжатия jpeg

- •Или же, в матричной форме,

- •Тема 10. Методы кодирования физических сигналов в компьютерных сетях.

- •16.1 Кодирование на физическом уровне.

- •16.2 Самонихронизирующиеся коды - коды rz и Манчестер-II

- •16.3 Несамосинхронизирующиеся коды. - код nrz

- •16.4 Высокоскоростные коды - код mlt-3 и pam 5

- •Еще более высокоскоростной код - код pam 5

- •16.5 Требуемая полоса частот для передачи данных и ширина спектра сигнала

- •Ширина спектра сигнала

10.2 Энтропия равномерного закона распределения

Энтропия равномерного закона распределения. Для равномерного распределения W(x)=1/(b-a). По формуле для дифференциальной энтропии получаем

![]()

С увеличением интервала (b-a) значение h(X) также увеличивается.

10.3 Энтропия гауссового закона распределения.

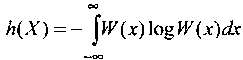

Энтропия гауссового закона распределения. Найдем плотность вероятности стационарного случайного процесса X(t), с ограниченной средней мощностью, которая обеспечивает максимум h(X). другими словами, необходимо найти махсимум функции в следующей постановке: задан целевой функционал:

и

ограничения

и

ограничения

Найти такую W(x), которая доставляет максимум энтропии h(X).

Решение этой задачи известно, и приводит к тому, что искомая плотность вероятности, удовлетворяющая условиям максимизации является гауссовой функцией

а максимальная энтропия

Следовательно, среди всех источников случайного сигнала с ограниченной и одинаковой средней мощностью (дисперсией) наибольшей энтропией владеет источник с гауссовским распределением сигнала.

На практике мы всегда имеем дело с сигналами (сообщениями и помехами) конечной длины и конечной энергии. При этом если продолжительность сигнала Ts, а его ширина спектра ∆f, то без потери информации такое непрерывное сообшение может быть представлено N=Ts*2∆f независимыми отсчетами . Таким образом для гаусового распределения энтропия отрезка непрерывного сообщения длительностью Ts будет равна

![]()

Лекция 11

11.1 Пропускная способность канала связи с помехами для непрерывных сообщений

Рассмотрим канал связи с аддитивним гауссовим шумом n(t), на вход которого поступает информация в виде непрерывного сигнала S(t). Выход такого канала является случайным процессом y(t), каждая реализация которого может быть представлена в виде

y(t) = S(t) + n(t).

Скорость передачи непрерывных сигналов (сообщений) определим, как разницу соответствующих производительностей выхода канала и шума в канале:

R=V*[h(y)-h(n)]

где V=1/Ts - скорость передачи сообщения в канале, которая определяется временем передачи сигнала длительностью Ts , а h(y) и h(n) -дифференциальная энтропия выхода канала и шума в канале соответственно.

Пусть эффективная полоса пропускания канала, что выбрана в соответствии с максимальной шириной спектра сигнала Fmax , равняется ∆f и время передачи сигнала равно Ts . В этом случае производительность шума

Rn(n)=V*h(n), и

![]()

где Рш -мощность шума в полосе ∆f

Пропускная способность канала связи по определению равняется

![]() (*)

(*)

где максимум отыскивается по всем законами распределения W(y) - плотности вероятности процесса

y(t) = S(t) + n(t)

на выходе канала связи (на входе приемника).

Найдем пропускную способность канала связи при условии, что средняя мощность сигнала ограничена, а помехой в канале является белый нормальный шум.

Как и раньше, будем считать, что все потери информации происходят только за счет шума. В этом случае максимизация пропускной способности расписанной выше, сводится к такому формированию сигнала S(t), чтобы процесс на выходе канала связи y(t)= S{t) + n(t) имел нормальное распределение, поскольку такой сигнал имеет максимальную энтропию. Это чрезвычайно важный вопрос рассмотрим более подробно.

Из статистики хорошо известно, что процесс y(t) = S(t) + n(t) имеет нормальное распределение при условии, что шум n(t) распределен нормально, по крайней мере в двух случаях. Во первых, если S(t) - детерминированная функция. Однако в этом случае вероятность реализации p[S(t)]=1, и следовательно, реализация S(t) не несет получателю никакой информации,

Второй случай, когда S(t) гаусовский процесс. Здесь действует правило композиции гауссових законов : при сложении двух гауссовских процессов результирующий процесс является также гауссовским, причем математические ожидания и дисперсии суммируются.

Поскольку сигнал S(t) и шум n(t) независимые, то средняя мощность суммарного колебания y(t) определяется суммой их мощностей : Py = Ps + Рш.

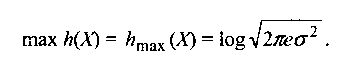

Поскольку шум имеет гауссовское распределение, то для того, чтобы суммарный сигнал имел максимальную энтропию, необходимо, чтобы информационный или полезный сигнал также имел гауссовое распределение. В этом случае производительность Ry суммарного колебания

y(t) = S(t) + n(t).

которое представляет случайный процесс на входе приемника, максимальна и равняется

![]() (**)

(**)

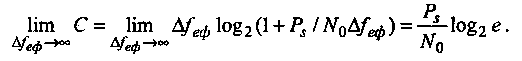

Таким образом, на основании выражений (*) и (**) пропускная способность гауссового канала связи определяется соотношением:

![]() бит/c

(***)

бит/c

(***)

Выражение (***) представляет широко известную в теории связи формулу Шеннона для пропускной способности непрерывного канала с гауссовою помехой. Эта формула связывает ширину спектра сигнала и отношения сигнал/шум на выходе канала связи (или на входе приемника) с пропускной способностью непрерывного канала. Из нее следует, что одну и ту же пропускную способность можно получить при разнообразных соотношениях пар ∆f и Ps/Pш, то есть существует возможность своеобразного размена между полосой пропускания и отношением сигнал/ шум для достижения заданной пропускной способности канала.

Из формулы Шеннона вытекает также, что увеличить пропускную способность можно за счет расширения полосы пропускания канала, который выбирается в соответствии с шириной спектра сигнала. Отсюда появляется задача синтеза шумоподобных импульсных сигналов с максимальной шириной спектра для переноса максимальгого количества информации. Эти выводы являются своеобразным мостиком между теорией информации и теорией кодирования сигналов.

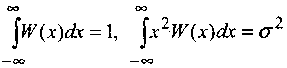

Рассмотрим предельные характеристики пропускной способности при изменении ∆f . Учитывая, что Pш=N0*∆f , где N0 - спектральная плотность мощности белого шума, выражение для пропускной способности приобретает вид:

C=∆f log2(1+Ps/N0∆f )

откуда видно, что С монотонно зависит от ∆f .

Для нахождения максимума этой функции достаточно найти предел

Соотношение представляет предельное (максимально возможно) значение пропускной способности канала при заданном отношении Ps / N0 на входе приемника.

![]() Обозначим

Обозначим

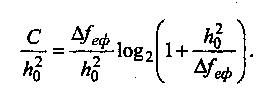

Проведем нормирование пропускной способности канала к величине h02

График зависимости нормируемой пропускной способности от отношения ∆f / h02 имеет вид:

Из анализа графика вытекает, что пропускная способность канала быстро растет при расширении полосы пропускания канала только на начальном участке кривой, где мощность сигнала больше мощности шума.

Отметим, что, как показывают исследования, скорость передачи во многих существующих системах связи еще слишком далека от теоретически возможных значений пропускной способности.