- •Часть 1. Основы криптографии

- •Глава 1.

- •1.2. Примеры моделей шифров

- •Ту же подстановку относительно своих контактов

- •1.3. Свойства шифров

- •1.4. Вероятностная модель шифра

- •1.5. Совершенные шифры

- •1.6. Способы представления реализаций шифров

- •1.7. Основные понятия теории автоматов

- •Глава 2.

- •2.1. Блочный шифр des

- •Матрица начальной перестановки p

- •Матрица обратной перестановки p–1

- •Связь элементов матриц

- •Функция расширения e

- •Функции преобразования s1, s2, ..., s8

- •Функция h завершающей обработки ключа.

- •2.2. Основные режимы работы алгоритма des

- •2.3. Области применения алгоритма des

- •2.4. Алгоритм шифрования данных idea

- •Подключи шифрования и расшифрования алгоритма idea

- •2.5. Отечественный стандарт шифрования данных

- •Режим простой замены. Для реализации алгоритма шифрования данных в режиме простой замены используется только часть блоков общей криптосистемы (рис.3.11). Обозначения на схеме:

- •32, 31, ... 2, 1 Номер разряда n1

- •32, 31, ... 2, 1 Номер разряда n2

- •32, 31, ..., 2, 1 Номер разряда n1

- •32, 31, ..., 2, 1 Номер разряда n2

- •32, 31, ..., 2, 1 Номер разряда n1

- •32, 31, ..., 2, 1 Номер разряда n2

- •32, 31, ..., 2, 1 Номер разряда n1

- •64, 63, ..., 34, 33 Номер разряда n2

- •32, 31, ..., 2, 1 Номер разряда n1

- •32, 31, ..., 2, 1 Номер разряда n2

- •Глава 3.

- •Узел выработки Канал

- •3.1. Шифры гаммирования

- •3.2. Поточный шифр гаммирования rc4

- •Глава 4.

- •Классическая модель криптографической системы (модель Шеннона)

- •4.1. Модель системы связи с открытым ключом

- •Модель системы с открытым ключом

- •4.2. Принципы построения криптосистем с открытым ключом

- •4.3. Схема цифровой подписи с использованием однонаправленной функции

- •4.4. Открытое распределение ключей Диффи-Хеллмана

- •Глава 5.

- •Классическая модель криптографической системы.

- •Глава 6.

- •6.1. Дешифрование шифра перестановки

- •6.2. Дешифрование шифра гаммирования при некачественной гамме

- •6.3. О дешифровании фототелеграфных изображений

- •6.4. Дешифрование шифра гаммирования при перекрытиях

- •Глава 7.

- •7.1. Задача определения периода гаммы в шифре гаммирования по заданному шифртексту

- •7.2. Возможности переноса изложенных результатов на шифры поточной замены (пз)

- •Где принадлежит множеству к подстановок на I (p-1(j) – вероятность j-той буквы, для ее расчета исходя из набора (p1,p2,…,p|I|) необходимо найти --1(j) – образ буквы j при подстановке --1).

- •Глава 8.

- •Глава 9.

- •9.1. Вероятностные источники сообщений.

- •9.2. О числе осмысленных текстов получаемых в стационарном источнике независимых символов алфавита

- •9.3. Критерии на осмысленные сообщения Важнейшей задачей криптографии является задача распознавания открытых текстов. Имеется некоторая последовательность знаков, записанная в алфавите I:

- •9.4. Частотные характеристики осмысленных сообщений Ниже используется следующий алфавит русского текста

- •Глава 10.

- •1) Для любой al(al)

- •Глава 11.

- •Глава 12.

- •Глава 13.

- •13.1. Расстояния единственности для открытого текста и ключа

- •13.2. Расстояние единственности шифра гаммирования с неравновероятной гаммой

- •Глава 14.

- •Глава 15.

9.4. Частотные характеристики осмысленных сообщений Ниже используется следующий алфавит русского текста

![]()

Считается, что точка в тексте записана бкувами «тчк», запятая - буквами «зпт». Приведем сначала вариационный ряд вероятностей букв содержательных текстов

Далее приводятся таблицы частот биграмм в содержательных текстах, которые получены маркировкой 200000 пересекающихся биграмм с учетом упомянутых особенностей текстов.

Глава 10.

Основные понятия и теоремы математической теории информации

Возникновение современной математической теории информации связано с работами К. Шеннона. В основу этой теории положено количественное определение информации через вероятностные характеристики процесса образования данного вида информации. Наиболее важные практические приложения теории информации заложены в определении пропускной способности канала связи с шумом. Понимая под шифрованием передачу открытого сообщения по некоторому каналу связи с шумом, можно использовать ряд общих результатов теории информации (относящихся к вычислению пропускной способности канала связи) в оценке возможности восстановления этого сообщения по шифрованному тексту.

Ограничимся случаем дискретной информации, где сообщение, подлежащее передаче через канал связи, состоит из последовательности дискретных символов, каждый из которых выбран из некоторого конечного множества (алфавита) букв сообщения.

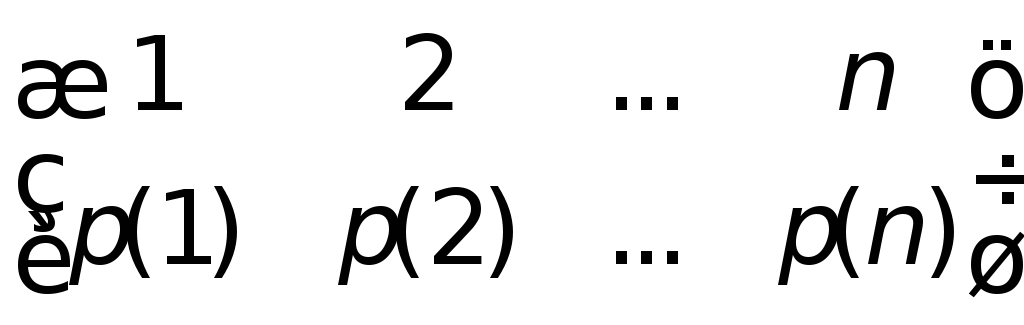

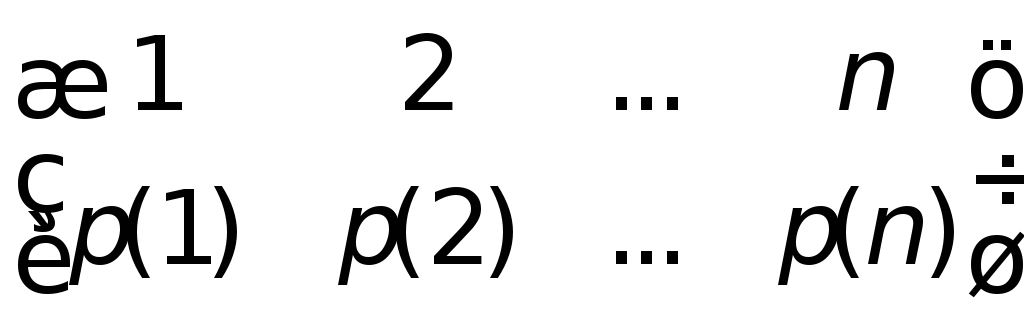

Энтропия конечной вероятностной схемы. Пусть задана конечная вероятностная схема

А= ,

,

1,

2, ..., a,

..., n

– исходы (буквы, сообщения) вероятностной

схемы из множества (алфавита)![]() А=

{1, 2, ..., a,

..., n},

p(1),

p(2)

,

..., p(a),

..., p(n)

– вероятности этих сообщений,

А=

{1, 2, ..., a,

..., n},

p(1),

p(2)

,

..., p(a),

..., p(n)

– вероятности этих сообщений,

![]() .

.

Основоположником теории численной оценки меры неопределенности вероятностных схем является американский инженер и математик Клод Шеннон. Ниже приводятся его основные идеи в решении данной задачи.

Если имеется такая мера (обозначим ее через Н=Н(А)=Н(p(1),p(2),...,p(a),...,p(n)), то разумно аксиоматически потребовать, чтобы она обладала следующими свойствами:

Н должна быть непрерывной относительно р(а), аА;

Н должна быть симметрична относительно своих аргументов (т. е. Н(p(1),p(2),..., p(n))= Н(p(i1),p(i2),..., p(in)) для любой перестановки индексов);

если выбор распадается на два последовательных выбора, то первоначальная Н должна быть взвешенной суммой индивидуальных значений Н, т. е. при р(1)+р(2)>0 справедливо тождество:

Н(p(1),p(2),...,p(n))=Н(p(1)+p(2),p(3),...,p(n))+

+((p(1)+p(2))

H(![]() ).

).

Смысл третьего свойства иллюстрируется на следующем рисунке:

1/3 2/3

1/6 1/2 1/3

1/2 1/2

Слева имеются три возможности р(1)=1/3, p(2)=1/6, p(3)=1/2. Справа проводится выбор сначала между двумя возможностями, причем каждая имеет вероятность 1/2, и в случае осуществления первой возможности производится еще один выбор между двумя возможностями с вероятностями 2/3 и 1/3. Окончательные результаты имеют те же самые вероятности: р(1)=1/22/3=1/3, p(2)=1/21/3=1/6, p(3)=1/2, как и прежде. В этом конкретном случае по свойству 3 требуют, чтобы

Н(1/3,1/6,1/2)=Н(1/2,1/2)

+

![]() Н(2/3,1/3).

Н(2/3,1/3).

Весовой множитель 1/2=(р(1)+р(2)) введен из-за того, что второй выбор осуществляется в половине случаев. Оказывается, что приведенные три условия с точностью до постоянного коэффициента «с» определяют функцию Н(p(1),p(2),..., p(n)):

Н(p(1),p(2),...,

p(n))=

-с![]() ,

,

где с=const>0. Выбор константы равносилен выбору основания d логарифма, а ее значение и значение основания можно трактовать как определение масштаба единицы количества неопределенности. Таким образом, окончательное выражение для Н имеет вид

Н(p(1),p(2),...,

p(n))=

-![]() ,

,

при оговоренном основании логарифма.

ОПРЕДЕЛЕНИЕ. Количеством информации (неопределенности) в сообщении aA называется число h(a), определяемое соотношением

h(a)= – log p(a).

ОПРЕДЕЛЕНИЕ. Среднее значение количества информации

H(A)=![]() (1)

(1)

называется энтропией конечной вероятностной схемы.

Термин количество информации Н применяют исходя из предположения, что произошла реализация (некоторый исход) в вероятностной схеме, в результате чего мы получаем информацию об исходе реализации вероятностной схемы, мера неопределенности Н употребляется в связи с измерением неопределенности возможных не реализованных исходов вероятностной схемы. Не придавая житейского смысла этой величине, а имея в виду математическую формализацию Н, говорят об энтропии вероятностной схемы.

Отметим,

что при использовании десятичных

логарифмов, что обеспечивает удобство

расчетов с помощью таблиц, в качестве

единицы количества информации

(неопределенности) принимают энтропию

равновероятной схемы с 10 исходами

(р(а)=1/10, а![]() ),

так как

),

так как

Н=![]() =1.

=1.

Чаще за единицу неопределенности принимают неопределенность, содержащуюся в альтернативном ответе «да-нет», соответствующему вероятностной схеме (р(1)=1/2, p(2)=1/2). В этом случае основание логарифма должно быть равно двум:

Н=

– (![]() log2

log2![]() +

+

![]() log2

log2![]() )=1.

)=1.

Эту единицу называют «битом», она в 3,32=log210 раза меньше десятичной единицы измерения информации.

Из

определения энтропии конечной

вероятностной схемы следует, что она

всегда неотрицательна: Н(p(1),p(2),...,

p(n))0.

Важное свойство энтропии конечной

вероятностной схемы (p(1),p(2),...,

p(n))

заключается в том, что она максимальна

и равна logn

при р(а)=1/n,

а![]() .

Минимального

значения

энтропия

достигает на вероятностной схеме, где

имеется сообщение с вероятностью, равной

единице.

.

Минимального

значения

энтропия

достигает на вероятностной схеме, где

имеется сообщение с вероятностью, равной

единице.

Неравенство 0H(A)logn позволяет качественно толковать понятие энтропия как меру неопределенности в эксперименте с возникновением того или иного случайного сообщения.

Использование численной меры неопределенности Н(p(1),p(2),..., p(n)) вероятностной схемы оказалось очень удобным для весьма многих целей. Отметим, однако, что эта мера не претендует на полный учет всех факторов, определяющих «неопределенность опыта» в любом практическом смысле, так как приведенная мера неопределенности зависит лишь от значений вероятностей p(1),p(2),..., p(n) различных исходов, но вовсе не зависит от того, каковы сами эти исходы – являются ли они в некотором смысле «близкими» один к другому или очень «далекими», насколько различны или одинаковы последствия этих исходов. Ранее мы отмечали, что основание, по которому берется логарифм в определении энтропии, влияет на единицу измерения количества информации.

Всюду ниже, если не оговорено противное, будут использоваться двоичные логарифмы.

Объединенная энтропия двух конечных схем. Условная энтропия. Рассмотрим наряду со схемой

А= ,

,

схему

B= ,

,

Схемы А и В могут быть зависимы между собой в том смысле, что для вероятности p(a,b) одновременного выполнения событий а, b выполняется неравенство: p(a,b)p(a)q(b). Рассмотрим объединенную схему С=АВ вида

C= ;p(a)=

;p(a)=![]() ,q(b)=

,q(b)=![]() .

.

ОПРЕДЕЛЕНИЕ. В соответствии с (1), энтропия

H(АB)=![]()

называется энтропией объединенной схемы AB.

Обозначая через p(b/a)=p(ab)/p(a), bB условные вероятности сообщений схемы B при условии сообщения a, можно рассмотреть ряд «условных» вероятностных схем

B/a= .

.

Для каждой из этих схем согласно (1) можно определить энтропию

H(B/a)=![]() .

.

ОПРЕДЕЛЕНИЕ. Среднее значение

H(B/A)=![]() =

–

=

–![]()

![]() (2)

(2)

называется условной энтропией схемы В при условии схемы А.

Взаимная информация между вероятностными схемами. Исходя из установленного выше понятия энтропии как меры неопределенности случайного сообщения, введем меру количества информации о сообщении «a», содержащемся в сообщении «b», как разность между количеством неопределенности (априорной) в сообщении «a» и количеством неопределенности в сообщении «a» при известном сообщении «b».

ОПРЕДЕЛЕНИЕ. Количеством информации о сообщении «a», содержащемся в сообщении «b», называется величина

i(ab)=h(a)-h(a/b)=log2p(a/b)/p(a).

ОПРЕДЕЛЕНИЕ. Среднее значение

I(AB)=![]() =

=![]() .

.

называется взаимной информацией между A и B.

Введем в рассмотрение вероятностную схему B с вероятностями исходов

q(b)=![]() .

.

Тогда величину I(AB) можно выразить через энтропийные характеристики следующим образом:

I(AB)=H(A)-H(A/B)=H(B)-H(B/A).

Свойства энтропии.

1. H(B/A)= H(AB) – H(A). (3)

Действительно,

H(B/A)=

![]() =

=![]() +

+

+![]() =H(AB)

– H(A).

=H(AB)

– H(A).

2. H(B/A)H(B), (4)

Нетрудно

показать, что выполняется неравенство

lnx-x+10.

Действительно, для функции f(x)=lnx-x

первая производная![]() обращается в 0 в точкеx=1,

причем f(1)=0,

а

обращается в 0 в точкеx=1,

причем f(1)=0,

а

![]() для всехx>0.

Следовательно, f(x)

имеет единственную точку максимума при

x=1.

Для двоичного логарифма имеем:

для всехx>0.

Следовательно, f(x)

имеет единственную точку максимума при

x=1.

Для двоичного логарифма имеем:

log2x=lnx/ln2=(x-1)log2e.

Тогда

H(B/A)

– H(B)=![]() +

+![]() =

=![]() +

+![]() =

=

=![]()

3.

Пусть

на алфавите A

вероятностной

схемы A

задано отображение (.)

в множество C.

Это отображение определяет вероятностную

схему C

с алфавитом С,

для которой p(с)=![]() .

Тогда выполняется неравенствоH(C)H(A),

и знак равенства имеет место в том

случае, когда отображение (.)

обратимо.

.

Тогда выполняется неравенствоH(C)H(A),

и знак равенства имеет место в том

случае, когда отображение (.)

обратимо.

Легко видеть, что условное распределение p(c/a)=1, если (a)=c и p(c/a)=0 в противном случае. Следовательно, H(C/A)=0. Далее, нетрудно проверить, что

H(C)–H(C/A)=H(A)–H(A/C)

и, следовательно,

H(C)+H(A/C)=H(A)+H(C/A).

Тогда,

H(C) H(C)+H(A/C)=H(A)+H(C/A)= H(A)

и равенство имеет место в том случае, когда отображение (.) обратимо и H(A/C)=0, H(C)=H(A).

4. H(AB)H(A)+H(B), причем равенство достигается в том и только в том случае, когда A и B независимы. Это свойство непосредственно следует из свойств 2 и 3.

5. Энтропии трех вероятностных схем A, B и W.

Энтропия вероятностных схем A и B при W:

H(A,B/W)=

–

![]() p(a,b,w)log2p(a,b/w)

p(a,b,w)log2p(a,b/w)

Энтропия A, B, и W:

H(A,B,W)=

-![]() p(a,b,w)log2p(a,b,w)

p(a,b,w)log2p(a,b,w)

Ниже представлен список информационных тождеств и отношений,

H(A, B, W) = H(A/B, W) + H(B, W)= H(A, B/W) + H(W)

H (A/B, W) +H(B/W) =H(B/A, W) +H(A/W)

6.

Если мы имеем A(L)=![]() –m

независимых объединений схемы А, то

–m

независимых объединений схемы А, то

H(![]() )=

)=![]()

=![]() LH(A)

LH(A)

и в этом случае

![]() .

.

Смысл введенного понятия энтропии становится ясен из следующих двух теорем Шеннона, относящихся к созданию сообщений с помощью независимых испытаний из конечной вероятностной схемы А.

Теоремы

Шеннона.

Обозначим

через AL

последовательность

![]() ,

полученную с помощью независимых

испытаний из конечной вероятностной

схемы

,

полученную с помощью независимых

испытаний из конечной вероятностной

схемы

А= ,

,

P(AL)=

![]() –

вероятность последовательностиAL.

Оказывается, что при больших L

все последовательности (за исключением

сколь угодно малой их доли) имеют

приблизительно одинаковую вероятность,

величина которой зависит от энтропии

H(A).

Качественное объяснение этого факта

достаточно простое. Так как символы в

последовательности AL

независимы, то энтропия на символ текста

равна H(A)=

–

–

вероятность последовательностиAL.

Оказывается, что при больших L

все последовательности (за исключением

сколь угодно малой их доли) имеют

приблизительно одинаковую вероятность,

величина которой зависит от энтропии

H(A).

Качественное объяснение этого факта

достаточно простое. Так как символы в

последовательности AL

независимы, то энтропия на символ текста

равна H(A)=

–![]() .

Предположим, что рассматривается длинное

сообщение, то естьL

велико. Тогда последовательность AL

будет, так сказать, «с большой вероятностью

содержать р(а)L

раз» символ а

.

Предположим, что рассматривается длинное

сообщение, то естьL

велико. Тогда последовательность AL

будет, так сказать, «с большой вероятностью

содержать р(а)L

раз» символ а![]() .

Вероятность конкретной последовательности

AL

есть

.

Вероятность конкретной последовательности

AL

есть

![]() ,

,

где a – частота буквы «a» в последовательности AL. Заменяя a на р(а)L, получаем «приближенное равенство»

Р(AL)![]() ,

,

а

log2

Р(AL)

L![]() =-LH(A),

откуда

=-LH(A),

откуда

Н(A) .

.

Это приближенное равенство остается верным и для любого стационарного источника (стационарной последовательности). Распространение указанного утверждения на цепь Маркова осуществил Хинчин А.Я., а на произвольный стационарный источник – Макмиллан. Пусть, как и прежде, А={1,2,…a,…n} – конечное множество исходов, соответствующее вероятностной схеме

А=

Первая

теорема Шеннона.

Для

любых

![]() существуетL0

такое, что при любом

существуетL0

такое, что при любом

![]() множество АL

всех последовательностей длины L

алфавита А разбиваются на группы (AL)

и (AL)

такие, что

множество АL

всех последовательностей длины L

алфавита А разбиваются на группы (AL)

и (AL)

такие, что