- •Содержание.

- •Введение.

- •Глава 1. Нейронечеткие методы вычислений

- •1.1. Основные положения метода нечеткого управления.

- •1.2. Нейронные сети в системах контроля и управления.

- •Глава 2. Алгоритм реализации нечёткого контроллера на основе сетей обратного распространения.

- •2.1. Нейронные сети с обратным распространением ошибки.

- •2.2. Алгоритм обучения с обратным распространением ошибки.

- •2.3. Алгоритм работы нечёткого контроллера.

- •2.4. Обучающий алгоритм для нечёткого контроллера.

- •Глава 3. Методы управления в компьютерно-интегрированном производстве.

- •3.1. Компьютерно-интегрированное производство.

- •3.2. Типовой технологический маршрут изготовления кмоп ис

- •Глава 4. Реализация программного обеспечения и результаты имитационного моделирования алгоритма нечёткого контроллера.

- •4.1. Реализация алгоритма нечёткого контроллера высокотемпературных операций.

- •Результаты имитационного моделирования.

- •4.3. Вывод.

- •Глава 5. Сегментация рынка контроллеров на основе нейронных сетей.

- •5.1. Общие положения.

- •5.2. Методика расчёта сегментации рынка.

- •5.3. Поиск сегментов рынка нечётких контроллеров.

- •5.4. Вывод.

- •Глава 6. Электробезопасность в помещениях вычислительных центров.

- •6.1. .Анализ вредных воздействий на организм человека при работе на эвм.

- •6.2. Электроопасность при работе с эвм.

- •6.3. Факторы влияющие на степень поражения электрическим током.

- •6.4. Медицинская помощь при поражении электрическим током.

- •6.5. Организационные и Технические мероприятия по безопасности эксплуатации.

- •6.6. Вывод.

- •Заключение.

- •Литература.

- •Глава 1-6.

- •Глава 7.

- •Глава 6.

- •Приложение.

2.4. Обучающий алгоритм для нечёткого контроллера.

При обучении данной сети выделяются две фазы. В первой фазе происходит локальная инициализация членов функции и представленных правил. Во многих задачах эту фазу может выполнить эксперт, имеющий знания по правилам работы поставленной задачи. Он также может задать начальные приблизительные значения функций принадлежности [5]. Во второй фазе применяется супервизорная обучающая схема для оптимального выравнивания членов функций для желаемых выходов.

Организующая фаза.

Задача для организующей обучающей фазы

1 может быть сформулирована так: подаются

обучающие данные xi(t),

i=1, ... , n. Требуемый

выходной уровень yi(t),

i=1, ... , m. Нечеткие

области

![]() и

и![]() .

Нам необходимы локальные члены функций

и нечеткие логические правила. В этой

фазе сеть работает двухсторонним

способом, узлы и связи в режимеup

- down. Таким образом,

обучающие входные и выходные данные

подаются в сеть с двух сторон.

.

Нам необходимы локальные члены функций

и нечеткие логические правила. В этой

фазе сеть работает двухсторонним

способом, узлы и связи в режимеup

- down. Таким образом,

обучающие входные и выходные данные

подаются в сеть с двух сторон.

Сначала центры и ширины функций принадлежности определяются самоорганизующимися обучающимися правилами аналогично статистической организации. Это служит для эффективного распределения ресурсов сети благодаря размещению доменов членов функций только вокруг тех регионов пространства входов и выходов, где присутствуют данные. Здесь алгоритм Кохонена адаптирован для нахождения центра mi функции принадлежности:

для

![]()

где a(t)

- монотонно убывающая

скалярная скорость обучения и

![]() Эти адаптивные формулы выполняются

независимо для каждой входной и выходной

лингвистической переменной. Определение

какой изmi

является mclosed

может быть выполнено

через определенное время по схеме

“Победитель получает все”.

Эти адаптивные формулы выполняются

независимо для каждой входной и выходной

лингвистической переменной. Определение

какой изmi

является mclosed

может быть выполнено

через определенное время по схеме

“Победитель получает все”.

Найдем центры функций, их ширины могут быть определены с помощью эвристического метода N -ближайших связей минимизацией следующей функции, которая относится к ширине si как:

где r - параметр перекрытия. Наша вторая обучающая фаза теперь сможет оптимально приспосабливать центры и ширины функций принадлежности. Ширина на этой стадии может быть, определена по эвристическому методу “первой ближайшей связи” так:

Используя различные законы соревновательного обучения происходит оптимизация связей между слоями. После такого обучения производится оценка весов различных узлов. Если вес очень мал, то связь с этим весом удаляется. Если у узла удалены все связи, то он также удаляется.

Обучающая фаза.

После того, как найдены все нечеткие

логические правила сеть стабилизируется

и переходит во вторую обучающую фазу

для оптимальной подгонки параметров

членов функций. Цель второй фазы может

быть, описана так: подается входная

обучающая последовательность: xi(t),

i=1, ... , n. желаемый

выходной уровень yi(t),

i=1,...,m, нечеткие области

![]() и

и![]() ,

и нечеткие логические правила, необходимо

оптимально подобрать параметры функций

принадлежности. Нечеткие логические

правила были определены на первой фазе

или в некоторых задачах были даны

экспертами, обладающими необходимыми

знаниями. Пример последнего - эксперту

нужно дать правила типа, если температура

слишком высокая, то быстро ее снизить.

,

и нечеткие логические правила, необходимо

оптимально подобрать параметры функций

принадлежности. Нечеткие логические

правила были определены на первой фазе

или в некоторых задачах были даны

экспертами, обладающими необходимыми

знаниями. Пример последнего - эксперту

нужно дать правила типа, если температура

слишком высокая, то быстро ее снизить.

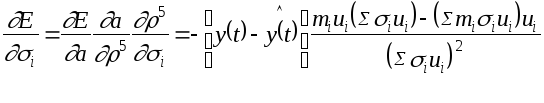

Во второй фазе задача минимизировать функцию ошибок

![]() - желаемый выход

- желаемый выход

- текущий выход.

- текущий выход.

Для

каждой обучающей последовательности

данных, начинающейся на входных узлах,

проход вперед используется для вычисления

уровня активности всех узлов в сети.

Затем начинающийся на выходных узлах

проход назад используется для вычисления

для всех невидимых узлов (внутренних

узлов).

для всех невидимых узлов (внутренних

узлов).

Результирующим w - желаемый параметр узла. Главное используемое обучающее правило это:

где h - скорость обучения и

(5)

(5)

Произведем

вычисление

слой за слоем, начиная с выходных узлов

(используем колоколобразную функцию

принадлежности и желаемые параметры

этих вычисленийmi

и si)

слой за слоем, начиная с выходных узлов

(используем колоколобразную функцию

принадлежности и желаемые параметры

этих вычисленийmi

и si)

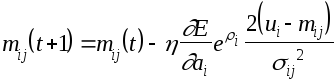

Слой 5: Используя (4) и (5) адаптивные правила, центр mi ищется так:

Параметр центра обновляется как:

точно так же применим правила (4) и (5) для ширины si:

и параметр обновляется так:

Ошибка распространения в следующий уровень это:

Слой 4: Для этого уровня у нас нет желаемых параметров mi и si . Мы можем вычислить и передать только сигнал ошибки (di4):

и из (2)

Сигнал ошибки:

Слой 3: Как и в слое четыре надо вычислить только сигнал ошибки. Согласно (3) этот сигнал может быть, вычислен так:

Таким образом, сигнал ошибки

di3=di4

. Если у нас много

выходов, то сигнал ошибки будет

![]() ,

где суммирование производится по

последовательности узлов правил.

,

где суммирование производится по

последовательности узлов правил.

Слой 2: Используя (5) и (1) адаптивные правила mij вычисляется как:

где из предыдущего получили

и из (2)

Где

суммирование выполняется по узлам

правил, влияющих на ai

и

Где

суммирование выполняется по узлам

правил, влияющих на ai

и

Итак, адаптивное правило mij:

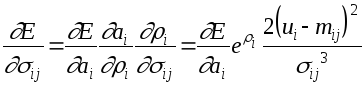

Точно также, используя (5) и (1) для sij получим:

Адаптивное правило sij:

Скорость работы данного алгоритма намного выше, чем работа алгоритма обычной сети обратного распространения благодаря оптимизированной схеме сети и уменьшенному количеству вычислений.