- •Особенности задач принятия решений

- •1.1. Формирование задач принятия решений.

- •1.2. Основные понятия системного анализа

- •1.3. Постановка задач принятия оптимальных решений

- •1.4. Принятие решений в условиях определенности

- •1.5. Принятие решений с учетом неопределенностей

- •Принятие решений в антагонистических и конфликтных ситуациях

- •Основная теорема теории игр. Всякая конечная антагонистическая игра 2-х лиц имеет цену и у каждого игрока имеется, по меньшей мере, одна оптимальная стратегия.

- •Аналитический метод решения игры (продолжение лекции 2)

- •Геометрический способ решения игры

- •Метод последовательных приближений

- •Решение игры методом сведения к задаче линейного программирования (лп)

- •Принятие статистических решений

- •Классические критерии пр.

- •Производные критерии

- •Рассмотрим пример применения рассмотренных статистических критериев пр для следующей практической задачи.

- •Связь между критериями и их графическая интерпретация

- •Критерии с прямоугольными конусами п редпочтения

- •Критерий с прямыми предпочтениями

- •Критерии с иными фп

- •Рациональный выбор решений: аксиомы, задачи, парадоксы

- •Многокритериальные решения: модели, оценка альтернатив, выбор решений

- •Интерактивные методы решения мкз

- •Метод уступок

- •Пример выбора варианта квартиры

- •Метод смещенного идеала

- •Метод electre

- •Метод promethee

- •Принципы группового выбора решений

- •Анализ риска

- •1. Измерение риска

- •Риск катастроф как независимый критерий

- •Коллективные решения

- •Особенности пр в малых коллективах

- •Общая схема экспертизы. Для решений задач пр привлекаются эксперты. Общая схема экспертизы включает следующие элементы (рис.):

- •Методы обработки экспертной информации. Существуют три основные группы методов обработки экспертной информации: статистические методы; алгебраические методы; методы шкалирования.

- •Пр в организациях

- •4.1. Постановка задачи

- •4.2. Детерминистский случай.

- •4.3. Многостадийные задачи принятия решений в условиях неопределенности

- •4.4. Марковские модели принятия решений

- •19.1. Примеры биматричных игр

- •19.1.1. Борьба за рынки

- •19.1.2. Дилемма узников

- •19.1.3. Семейный спор

- •19.1.4. Студент - преподаватель

- •19.2. Смешанные стратегии

- •19.3. 2 X 2-6иматричные игры. Ситуация равновесия

- •19.4. Поиск равновесных ситуаций

- •19.4.1. Борьба за рынки

- •29.4.2. Дилемма узников

- •19.4.3. Семейный спор

- •19.4.4. Студент - преподаватель

- •19.5. Некоторые итоги

- •19.6. Задания и ответы

4.4. Марковские модели принятия решений

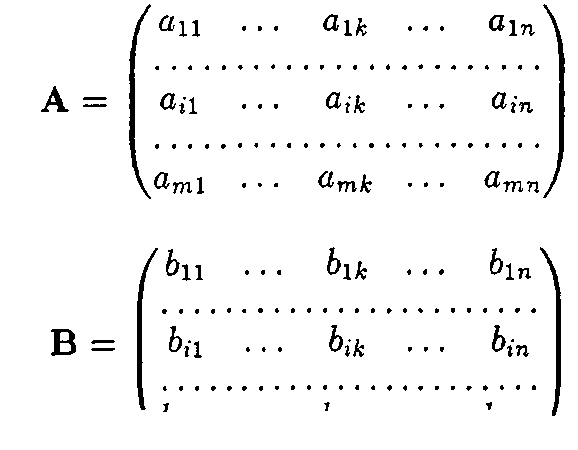

В данном разделе рассматриваются многостадийные задачи принятия решений с конечным числом состояний Sj(/ = I, ..., m) оптимизируемой счстемы S. Предполагается, что в дискретные моменты времени tx, t2, ... система переходит в новое состояние в соответствии с некоторой матрицей переходных вероятностей:

р11 р12 … р1m

P= р21 р22 … р2m

… … … …

Рm1 pm2 … pmm

Элемент pi} матрицы означает вероятность перехода системы из состояния S/ в состояние Sj. Таким образом, строки матрицы соответствуют "старым", а столбцы — "новым" состояниям. Очевидно, сумма элементов любой строки матрицы равна 1.

Такой процесс поведения системы называется марковским, если вероятность перехода системы в любое возможное состояние в каждый момент времени определяется только ее состоянием в предыдущий момент времени и не зависит от более ранней предыстории.

Многие практические ситуации могут быть описаны с помощью аппарата марковских моделей. Рассмотрим конкретный пример.

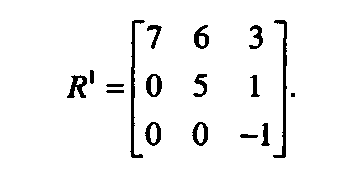

Пример 4.3. Некоторая фирма занимается промышленной разработкой программного обеспечения для компьютерных систем. В начале каждого года она решает задачу замены оборудования, включающего технические и программные средства, используемые в производственном процессе и обеспечивающие необходимую технологическую среду разработки. В зависимости от результатов экспертной оценки оборудования состояние фирмы (это система S) оценивается как "хорошее" (1), "удовлетворительное" (2) и "плохое" (3). Следовательно, система может находиться в одном из трех указанных состояний. Матрица переходных вероятностей может иметь вид:

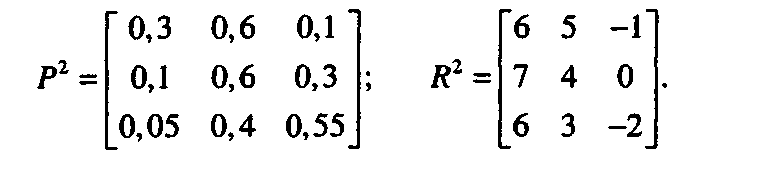

Здесь, например, число 0, 3 означает, что если система находилась в "хорошем" состоянии, то в следующий момент изменения состояния (следующий момент анализа состояния фирмы) она окажется в "плохом" состоянии с данной вероятностью. В действительности изменение (ухудшение) состояния связано с процессом износа и устаревания оборудования и технологических сред. Если матрица переходных вероятностей не меняется, то достаточно просто проанализировать весь жизненный цикл системы S.

Предположим, что в зависимости от состояний, в которых последовательно оказывается система, может быть вычислен доход, приносимый фирмой. Логично предположить, что доход за период //+,—/, зависит от уровня оснащенности фирмы современным оборудованием и технологическим окружением, включая профессиональный уровень персонала, также требующий непрерывного повышения. В свою очередь, уровень оснащенности в значительной степени коррелирует с тем состоянием, в котором находилась фирма в начале рассматриваемого периода и в его конце. Если, например, в момент времени tt система находилась в "хорошем" состоянии и в момент /,+, это состояние сохранилось, то, по-видимому, доход будет максимальным (конечно, при выполнении прочих условий, связанных с наличием заказов, ситуации на рынке и т. д.).

Для моделирования этой ситуации можно матрице переходных вероятностей P поставить в соответствие матрицу доходов R:

Здесь в матрице доходов мы учли затраты на реорганизацию и модификацию. Например, элемент г,, матрицы /доказывается меньше соответствующего элемента матрицы R].

На каждом этапе мы можем принять решение не проводить модернизацию фирмы и иметь матрицы Р[ и R1 или принять решение о необходимых изменениях и получить матрицы Р2, Л2. Возникает проблема выбора или принятия решений с целью максимизации приносимого фирмой ожидаемого (речь идет о вероятностях!) дохода. Это многоэтапная задача принятия решений, т. к. выбор осуществляется каждый раз в заданные дискретные моменты времени.

С привлечением уже рассмотренного примера обсудим основные моменты выбора оптимального решения. Предположим, что планирование

стратегии поведения фирмы осуществляется на конечный период времени. Покажем, что решение может быть основано на уже известном методе динамического программирования (метод Беллмана) в соответствии с общей концепцией анализа и оптимизации многошаговых задач (см. разд. 4.3).

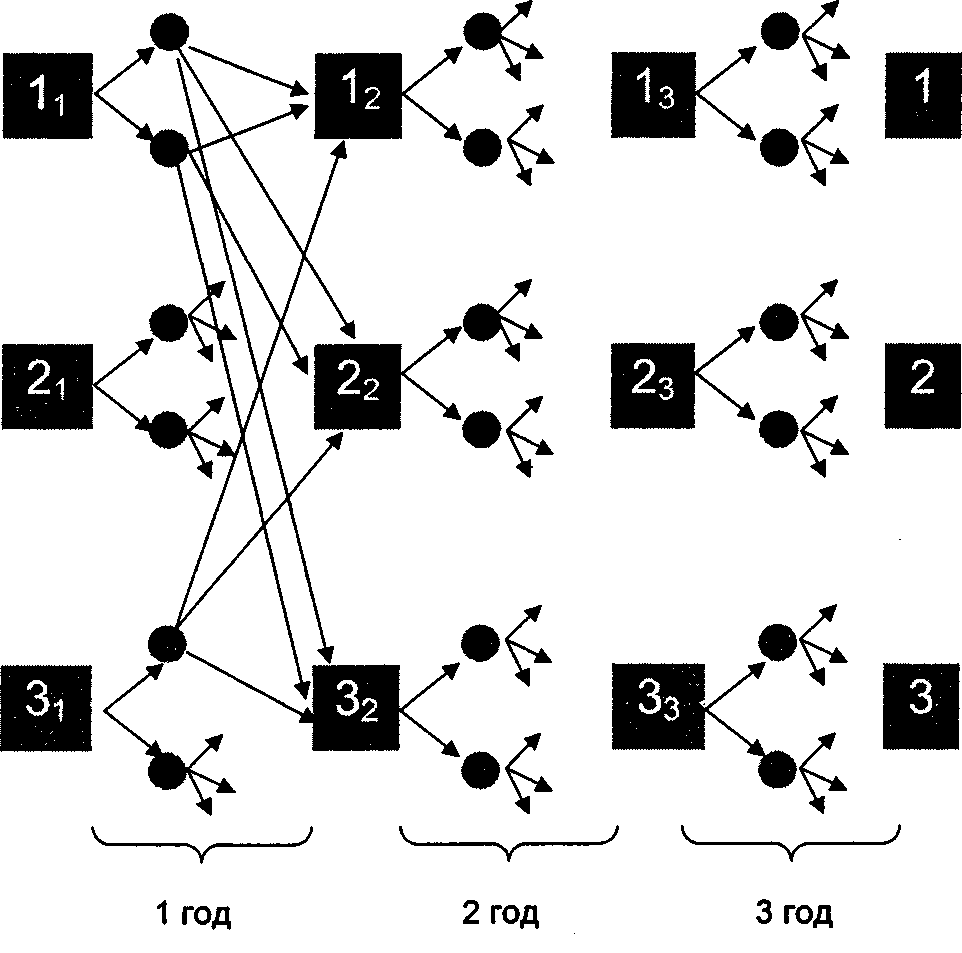

Пусть период ti+]—tt соответствует одному году, а планирование проводится на трехлетний период. Для наглядности соответствующее дерево решений можно представить графически (рис. 4.11).

Рис. 4.11. Дерево решений

Как обычно, квадратики означают решающие вершины. Каждый квадратик соответствует определенному состоянию системы в определенный момент времени. Знак /, внутри квадрата означает, что в момент време-

ни у, j= 1, 2, 3 (номер этапа) система находится в состоянии /, /= 1, 2, 3 (соответственно, "хорошее", "удовлетворительное" или "плохое" состояние). Две стрелки, исходящие из каждой "решающей" вершины, соответствуют двум альтернативам на каждом этапе: х^ — проводить модернизацию (это верхняя стрелка, будем называть ее стрелкой или направлением 1) или х2 — не проводить (это нижняя стрелка, будем называть ее стрелкой или направлением 2). Кружочки означают "случайные" вершины, переход из которых осуществляется в соответствии с выбранной матрицей переходных вероятностей.

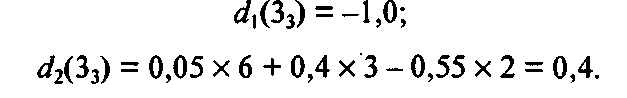

Следуя общему алгоритму динамического программирования, решаем задачу с конца. Двигаемся справа налево по решающим вершинам. Начнем с вершины 13. Тогда при принятии решения jc, (без модернизации) ожидаемый доход равен

![]()

При выборе х2 (модернизация) имеем:

![]()

Число 5,3 больше, чем 4,7, поэтому если мы окажемся в вершине 13, то пойдем по направлению 1, а сама вершина помечается числом 5,3. Стрелка 1 также выделяется.

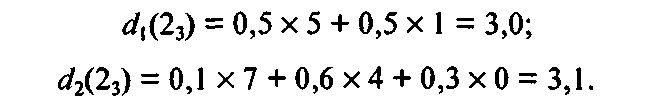

Далее переходим к вершине 23. Получаем значения двух доходов в зависимости от принимаемых решений:

Вершина 23 помечается числом 3,1 и выделяется направление 2. Для вершины 33 получим:

Вершина 33 помечается большим числом 0,4 и выделяется стрелка 2.

Полученные числа 5,3, 3,1, 0,4 характеризуют один акт изменения состояния и получаемый при этом локальный доход. Далее эти вычисления уже не повторяются, а значения этих локальных доходов потребуются в дальнейших расчетах.

Переходим теперь к началу второго года. Начнем с вершины 12. При выборе направления (решения) 1 имеем:

![]()

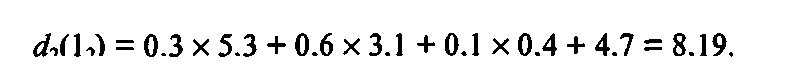

Здесь число 5,3 отражает локальный доход этапа (рассчитанный ранее), а остальные слагаемые характеризуют наилучший ожидаемый доход, получаемый на оставшихся этапах. Для второго варианта решения для этой же вершины имеем:

Число 8,19 больше, чем 8,03, поэтому вершину 12 помечаем числом 8,19 и выделяем стрелку 2.

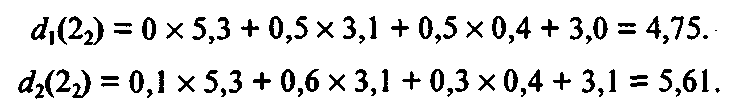

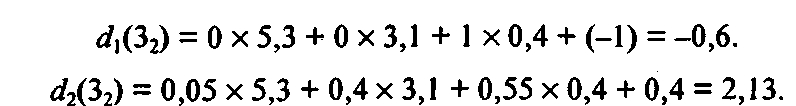

Для вершин 22 и 32 проводим аналогичные расчеты:

Выбираем число 5, 61 и выделяем стрелку 2. Далее имеем:

Для первого этапа аналогично получаем:

Теперь обратная процедура динамического программирования закончена и, двигаясь от начала дерева решений к концу, можно "прочитать" оптимальное решение. А именно: числа 10,74, 7,92, 4,23 означают оптимальный ожидаемый доход, если, соответственно, система находилась первоначально в состояниях 1, 2 и 3. Эти ожидаемые доходы достигаются, если мы всегда будем вести себя "оптимально", т. е. в соответствии с помеченными на дереве решений стрелками. В частности, в каком бы состоянии мы ни находились в начале первого года, целесообразно решение, связанное с модернизацией оборудования. То же относится к началу второго года (все выделенные стрелки направлены "вниз"). И только если в начале третьего года мы окажемся в состоянии 1, нам нецелесообразно проводить модернизацию оборудования фирмы.

Поставленная задача решена.

Отметим, что в теории марковских процессов принятия решений рассматриваются также модели с бесконечным числом этапов. Эти и другие вопросы рассматриваются в учебной литературе [36].

БИМАТРИЧНЫЕ ИГРЫ

Предыдущие рассмотрения касались игр двух лиц, в которых интересы игроков были прямо противоположны (антагонистические, или матричные, игры), а также позиционных игр, сводимых к матричным. Однако ситуации, в которых интересы игроков хотя и не совпадают, но уже необязательно являются противоположными, встречаются значительно чаще.

Рассмотрим, например, конфликтную ситуацию, в которой каждый из двух участников имеет следующие возможности для выбора своей линии поведения:

игрок А — может выбрать любую из стратегий Ai,..., Am, игрок В — любую из стратегий Z?i,..., Вп.

При этом всякий раз их совместный выбор оценивается вполне определенно:

если игрок А выбрал г-ю стратегию А;, а игрок В — к-ю стратегию Bk, то в итоге выигрыш игрока А будет равен некоторому числу а,^, а выигрыш игрока В — некоторому, вообще говоря, другому числу Ь^.

Иными словами, всякий раз каждый из игроков получает свой приз.

Последовательно перебирая все стратегии игрока А и все стратегии игрока В, мы можем заполнить их выигрышами две таблицы:

|

|

|

Вп |

|

|

|

|

#ln |

|

|

|

|

&in |

|

|

|

|

®тп |

|

|

|

|

tj-n |

|

|

|

|

■ bln |

|

Ai |

Ъа ■ |

Ык • • |

Oin |

|

Ат |

Ът\ • • |

®тк ■ ■ |

®тп |

|

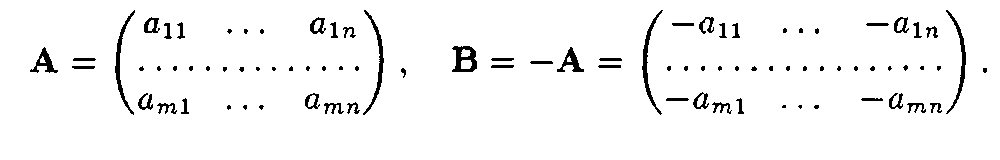

Первая из таблиц описывает выигрыш игрока А, а вторая — выигрыш игрока В. Обычно эти таблицы записывают в виде матриц:

\0т1 ' • ' ®тк • • ' ^тп/

Здесь А — платежная матрица игрока Л, а В — платежная матрица игрока В.

При выборе игроком А г'-й стратегии, а игроком В — fc-й стратегии их выигрыши находятся в матрицах выплат на пересечении г-х строк и /г-х столбцов:

в матрице А это элемент а,-*, а в матрице В — элемент bik.

Таким образом, в случае, когда интересы игроков различны (но необязательно противоположны), получаются две платежные матрицы: одна — матрица выплат игроку Л, другая — матрица выплат игроку В. Поэтому совершенно естественно звучит название, которое обычно присваивается подобной игре, — биматричная.

Замечание. Рассмотренные ранее матричные игры, разумеется, можно отнести и к биматричным, где матрица выплат игроку В противоположна матрице выплат игроку А:

bik = —o,ik

или

Тем не менее в общем случае биматричная игра — это игра с ненулевой суммой.

Нам кажется вполне естественным время от времени сопоставлять наши рассмотрения с рассуждениями, приведенными ранее для матричных игр (особенно при попытках разрешения сходных проблем). Подобные сопоставления часто оказываются одновременно и удобными и полезными. Конечно, класс биматричных игр значительно шире класса матричных (разнообразие новых моделируемых конфликтных ситуаций весьма заметно), а значит, неизбежно увеличиваются и трудности, встающие на пути их успешного разрешения. Впрочем, мы надеемся, что часть этих трудностей мы сумеем преодолеть уже в настоящем издании.