- •Введение

- •Вступление

- •Благодарности

- •Предисловие

- •Содержание

- •Основы поисковой оптимизации

- •Что такое SEO?

- •SEO терминология

- •Конкретные вопросы от начинающих

- •Тематика будущего сайта - как с ней определиться

- •Поддомены, папки и микросайты – что выбрать

- •Домены с www и без www – история появления, использование 301 редиректа для их склеивания

- •Как перенести сайт: 10 этапов переезда сайта

- •Раскручиваем сайт с нуля – рекомендация по наращиванию ссылочной массы

- •Как отличить хорошего донора от плохого

- •План раскрутки: С чего начать продвижение сайта?

- •Продвижение от А до Я

- •Поцелуй паука - моя схема бесплатного продвижения сайтов

- •Поисковая оптимизация, раскрутка и продвижение нового сайта глазами начинающих оптимизаторов

- •Внутренняя оптимизация сайта, что это?

- •Как раскрутить сайт

- •Адрес сайта на стекле автомобиля

- •Как раскрутить сайт с нуля

- •Высокочастотные, низкочастотные и среднечастотные запросы

- •Продвижение по низкочастотным запросам

- •Семантическое ядро: Ключевые слова

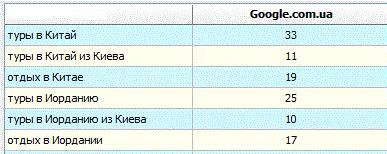

- •Подбор ключевых слов для продвижения сайта

- •Как подбирать ключевые слова для продвижения сайта

- •Под какое количество ключевых слов можно оптимизировать страницу?

- •Классификация вхождений ключевых слов

- •Контент вашего ресурса

- •Ультиматум сайту: контент или конец

- •Как бесплатно наполнять свой сайт контентом

- •Контент – текстовое содержание сайта

- •Дубликаты контента – мифы и решение проблемы

- •Определение дублированного контента

- •Уникальный контент – поприветствуем его величество

- •Как уникализировать контент для интернет магазинов и увеличить продажи

- •На какой поисковый траф можно рассчитывать, зная позицию в выдаче

- •Получение дополнительного трафика

- •Железный метод увеличения поискового трафика

- •Поисковая оптимизация страниц

- •Как создать идеально оптимизированную страницу?

- •Часть 1

- •Часть 2

- •Оптимизации страниц под множество запросов

- •Типы поисковых запросов. Изучаем цели аудитории

- •Влияет ли Sitemap на индексацию?

- •Ошибки поисковой оптимизации

- •Основные ошибки поисковой оптимизации

- •Технические ошибки оптимизации сайтов

- •Сайт для людей, а не для поисковиков

- •Как не надо продвигать сайт

- •Продвижения по словам с ошибками

- •Цифры, числа... Берем врага количеством

- •5 причин ставить внешние ссылки у себя на сайте

- •5 способов увеличить продажи при продвижении сайта

- •Продвижение сайта – 5 самых грубых SEO ошибок

- •7 секретов успешного сайта

- •7 признаков покупных ссылок

- •7 способов превратить Ваш сайт в Линкомагнит

- •Восемь хитростей, используемых SEO-консультантами

- •9 экспертных SEO советов для маленького бизнеса

- •10 способов продвижения в обход Google

- •10 основных правил для локального продвижения

- •10 вопросов для SEO подрядчика или как найти специалиста по продвижению сайтов

- •10 самых популярных SEO мифов

- •10 практических советов по обмену ссылками

- •10 актуальных способов получить бесплатные ссылки на сайт

- •10 способов доказать ценность вашей SEO работы

- •10 проверенных методов ускорить индексацию сайта

- •11 советов по составлению успешных URL адресов

- •13 факторов оценки конкуренции по запросу

- •Индексация сайта - еще 16 способов, как ее ускорить

- •Внутренняя оптимизация сайта - 17 советов

- •17 факторов которые учитывают поисковики при расчете веса ссылки

- •Как ускорить индексацию сайта - 18 эффективных способов

- •22 лучших SEO плагина для Google Chrome

- •32 самых важных SEO подсказок

- •44 каталога статей

- •Продвижение сайтов пресс-релизами и 53 каталога, куда их можно добавить

- •69 методов наращивания ссылочной массы прошедшего года

- •100 новых способов получения внешних ссылок

- •101 совет по покупке текстовых ссылок

- •149 англоязычных каталогов статей

- •Как я увеличил посещаемость этого блога с 350 до 1000 человек

- •Как из одной статьи сделать тысячи

- •Как увеличить посещаемость с 0 до 3600 посетителей в сутки за 1 год

- •Как получить 10000 ссылок за 3 недели

- •Продвижение ссылками

- •Искусство покупки ссылок

- •Биржи ссылок

- •Сервисы покупки постовых и контекстных ссылок

- •Обратные ссылки, обратные ссылки, обратные ссылки...

- •Сервисы определения ссылочного бюджета

- •Покупаем ссылки с минимальным риском и максимальной пользой

- •Инструкция по покупке ссылок в подписях на форумах

- •Google дает больший вес естественным ссылкам, располагающимся в тексте

- •Стоит ли обмениваться взаимными ссылками?

- •Распределение анкоров ссылочной массы

- •Составляем анкоры и описания для продвижения сайта

- •Советы по грамотному составлению анкоров

- •Ссылки с футера все еще работают!!

- •Вспоминаем главное свойство ссылок

- •Методы получения обратных ссылок на Интернет-магазин

- •Ценность ссылок и разнообразие доменов

- •Как добыть ссылки в трудных нишах

- •Разбавляем ссылки при продвижении сайта

- •Покупка ссылок: классификация параметров для отсева

- •Cапа. Советы новичкам

- •Вред от исходящих ссылок

- •Продвижение в буржнете

- •Как вывести сайт в топ под англоязычный сегмент

- •Продвижение англоязычного сайта - часть 1

- •Продвижение англоязычного сайта – часть 2

- •Свежая база англоязычных каталогов пресс-релизов с PR 3-8

- •Свежая база белых англоязычных каталогов с PR 4-8

- •Блоги, форумы, движки. Использование, оптимизация, раскрутка

- •Использование блога для продвижения сайта

- •Как сделать блог-многотысячник

- •Как легко и быстро найти рекламодателя для блога

- •Особенности развития и продвижения форумов

- •Как увеличить PR сайта - ищем dofollow блоги

- •Куда добавить блог - мой список полезных ресурсов

- •Использование блогуна для раскрутки сайтов

- •Почему я покупаю верхние постовые?

- •Пресс релиз или постовой, что лучше для SEO

- •Как выбрать блоги для покупки постовых

- •Платные посты в западных блогах

- •Блог на поддомене или или в папке - как лучше?

- •Лучшие плагины Wordpress - 103 плагина

- •SEO в phpBB3

- •SMF: Удаляем мусорные слова

- •Пузомерки, ТИЦ, PageRank и т.д. Поднимаем рейтинг сайта

- •тИЦ - что эффективно для его увеличения?

- •Как увеличить PR

- •Высокий PR за счет внутренних ссылок

- •Как увеличить PR - ищем сайты с высоким PR

- •Растолкованный PageRank

- •Фальшивый PageRank

- •Актуален ли Alexa Rank

- •Trust Runk и все о нем

- •Траст и авторитетность сайта в поисковых системах

- •О доменных пузомерках. Домен Ранк. Домен Траст. Домен Джус

- •Продвинутое SEO

- •Когда ожидать результатов продвижения?

- •Линзы Squidoo - как их правильно создавать для продвижения сайта

- •Как определить целевую страницу для продвижения

- •Долгосрочная эффективная стратегия продвижения сайта

- •Черное SEO: Советы для вебмастеров

- •Дорвей или сателит

- •Продвижение социальными закладками

- •Зарубежные SEO ресурсы, которые я читаю

- •Улучшаем ранжирование сайта, не изменяя его контент

- •Мелочи в SEO имеют большое значение

- •Как правильно составить информацию для регистрации сайта в каталогах

- •SEO и XHTML 2.0, HTML 5

- •Из чего состоит работа SEO специалиста?

- •Как стать профи в поисковой оптимизации?

- •Продвижение сайта: существующие схемы работы с заказчиком

- •Seo аудит сайта

- •Полезные советы клиентам по SEO

- •Правильная работа с партнерскими программами

- •Что делать, когда резко снижаются позиции сайта

- •Как повысить позиции в поисковиках

- •Среднее время индексации

- •Роль окружающего текста в seo

- •Секрет продвижения статьями

- •Продвижение сайта статьями

- •Теги STRONG, EM, B и I в SEO

- •Использование и оптимизация тега title

- •Роль опечаток в SEO

- •Внутренние факторы ранжирования

- •Назначение и замена релевантных (целевых) страниц

- •Чему я научился при продвижении сайтов

- •Методы прикормки поисковых роботов

- •Обзор автоматических систем продвижения сайтов

- •Разное. Расширенная оптимизация

- •Как попасть в DMOZ — советы редактора

- •Как индексирует Google

- •SEO плагины под FireFox

- •Список поисковых ботов для User-agent в robots.txt

- •Поисковые запросы Google

- •Операторы запросов Яндекс

- •Послесловие

SEO: Поисковая Оптимизация от А до Я => Продвижение ссылками

Вы также получите ссылку с главной страницы сайта, так как там показываются последние записи в Твиттере. Учитывая частотность добавления записей в их Твиттер аккаунт, можно предположить, что ссылка на главной будет находиться несколько дней.

Примечательно, что PR по тулбару у этого домена 0, мне показалось это странным. Это все потому, что они недавно сменили домен, а на старом www.dcsf.gov.uk стоит 302 редирект. Если бы я хотел сохранить хоть часть прежнего веса, я бы использовал 301 редирект.

Источник: How to Get Links in Tough Industries

Перевод: SEOM.info

Разбавляем ссылки при продвижении сайта

Автор: Виктор Карпенко (SeoProfy)

Те, кто продвигают клиентские сайты или свои по высоко конкурентным запросам в особенности под Яндекс, в большинстве случаев используют покупные ссылки через sape.

На практике я сталкивался с тем что у многих это единственный источник ссылок. Сегодняшней пост о том, как я разбавляю ссылки и что про это думаю.

Если правильная оптимизация сайта сделана, дальше нужны ссылки, и вот как я их разбиваю при продвижении проекта.

Процентное распределение

-постовые 25%

-контекстные ссылки 15%

-Sape 50%

http://www.seobuilding.ru/seo-forum/index.php стр. 296 из 536 30.11.2010 http://www.seobuilding.ru/

SEO: Поисковая Оптимизация от А до Я => Продвижение ссылками

- статьи навсегда 10%

1.Постовые

При начале продвижения сайта нужно прикупать постовые, проверенно, работает вообще отлично. Чем постовые хороши так это тем, что сразу попадает в индекс и дает вес. Но тут есть большое НО:

Постовые должны размещаться сразу в новом посте, а не после того как пост проиндексируется.

Если сразу не разместить, то возможно он учтется через пару недель и то не факт.

Как вам такой пример:

И это за 3 дня продвижения. Постовые дают ощутимый траст, а про то где их можно прикупать читайте этот пост.

2.Контекстные ссылки

Отлично работают, отлично учитываются, нужно просто хорошо выбирать ресурс. Контекстные ссылки сейчас есть возможность покупать в авторитетных СМИ, через новый сервис сапы pr.sape.ru.

В случае с вариантом нового сервиса сапы, то можно размещать ссылки в новых статьях, которые так же влетают моментально в индекс. И на начальном этапе продвижения получить вес с авторитетных сайтов будет только на руку, плюс ссылки размещаются навсегда.

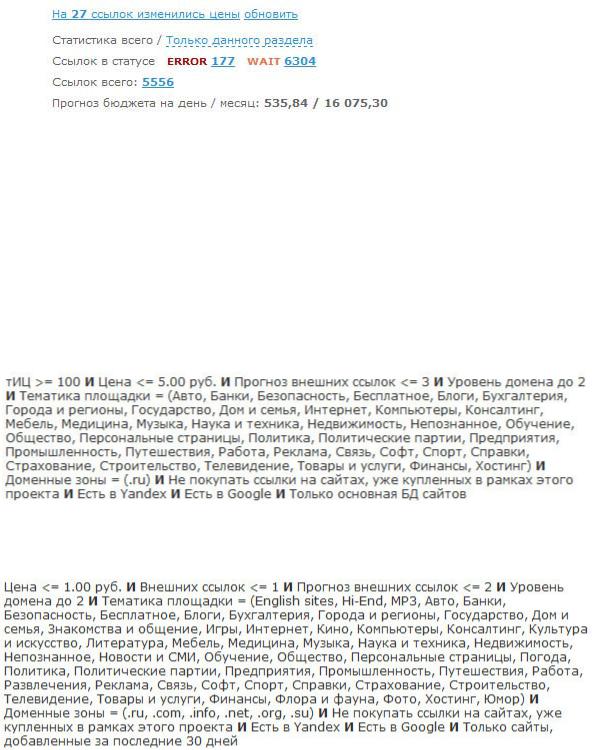

3.Sape ссылки

Тут понятное дело. Создание проекта, создания описаний, и закупка по определенным фильтрам. Сапа как рулила, так и будет рулить пока, в плане эффективности и цены. Так как если продвигаться только ссылками навсегда, то придется потратить в разы больше, и результат будет делаться дольше. Я давненько делал видео урок о том как покупать ссылки в sape, его можно посмотреть, лишним не будет. Кстати за все время видео просмотрели больше 7000 раз, что не так мало по тематике SEO.

4.Статьи навсегда

И на последок не забываем про биржи статей, так как там есть очень много толковых тематических сайтов. Хоть на многие цена и завышена, но иногда все равно стоит прикупить для перспективы. Статьи отлично работают, только по деньгам получаются гораздо дороже арендованных ссылок и постовых, так как нужно еще и статья, а контент так же стоит денег.

Вывод: нужно иметь множественные источники ссылок для продвигаемого сайта, и тогда все всегда будет хорошо. И не нужно зацикливаться на одной сапе и после очередной смене алгоритма Яндекса кричать почему сайт клиента в полной ж…

И еще, лучше иметь качественные ссылки (ссылки с качественных доноров), чем тысячи гавноссылок с гавносайтов, хоть ссылки с гавносайтов пока отлично работают.

http://www.seobuilding.ru/seo-forum/index.php стр. 297 из 536 30.11.2010 http://www.seobuilding.ru/

SEO: Поисковая Оптимизация от А до Я => Продвижение ссылками

Покупка ссылок: классификация параметров для отсева

Автор: Александр Люстик (MyOST)

Работа по покупке ссылок должна быть максимально автоматизирована, но для этого нужно провести большую подготовительную работу. Любой робот будет следовать вашим указаниям, но можно совершить ряд ошибок и испортить казалось бы конечную, отличную, идею.

Только кажется, что на бирже ссылок много ресурсов, на самом деле их нужно расходовать достаточно аккуратно. Поэтому вопрос о правильной классификации параметров для отсева ссылок встает довольно остро.

На самом деле, все фильтры, которые вы создаете – имеют довольно малую корреляцию с эффективностью, а если сказать точнее – то не выбор фильтра определяет его эффективность.

У меня в аккаунтах присутствует более 50 разных фильтров (если брать все аккаунты в сапе), включая клиентские, но при этом ни они определяют стратегию выбора донора.

Сайт с нулевыми показателями может сработать не хуже чем «с пузомерками», сайт не тематичный может сработать лучше, чем 100% верная тематика.

http://www.seobuilding.ru/seo-forum/index.php стр. 298 из 536 30.11.2010 http://www.seobuilding.ru/

SEO: Поисковая Оптимизация от А до Я => Продвижение ссылками

Если у вас нет большой выборки сайтов, по которой можно составить белые списки, то придется действовать немного иначе (кстати белые сайты часто становятся серыми и черными , их нужно проверять постоянно).

Основной упор – на формирование черных списков, для этого нужна четкая классификация параметров.

Я знаю достаточно людей, у которых за год-два работы черный список перевалил за 70 тысяч сайтов, при этом многие из них считают это абсолютно нормальным и они не заморачиваются с классификацией параметров.

Достаточно всего одного параметра для занесения площадки в черный список – это не правильный и не рациональный подход.

Чтобы собрать параметры для классификации – придется поработать руками и глазами, частично мозгом. А дальше все полученные результаты должны пойти в обработку автоматом, ведь автоматизация позволяет экономить кучу времени.

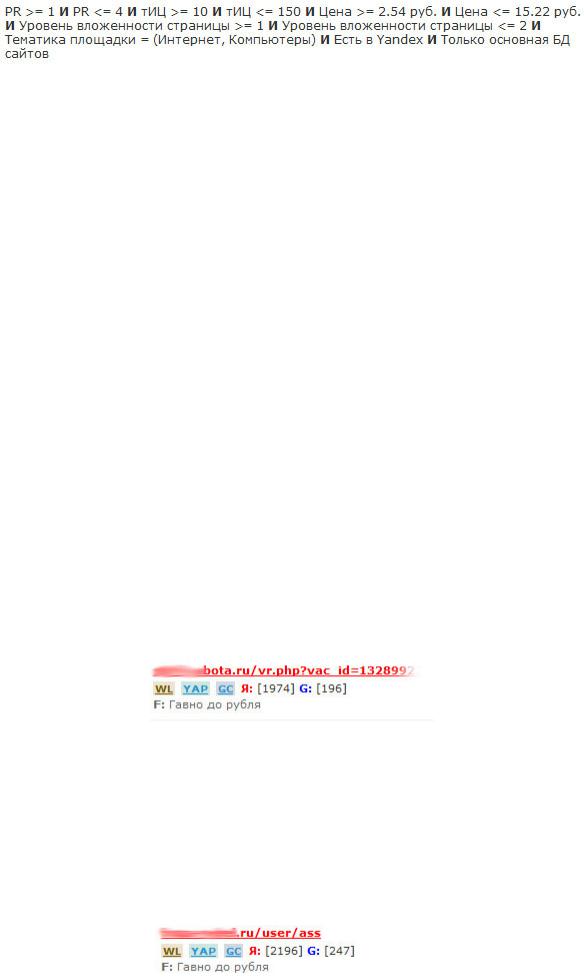

Методика отсева по плагину винка такова: LF, H, Cn, TF, ВС, УВ, YAP, YAC.

Первый барьер, который проходят сайты – это фильтр по URL (LF), которым мы пытаемся выявить заранее те сайты, которые имеют довольно большую вероятность к выпадению, а также не желательные страницы.

Как мы видим – у нас уже 2 классификатора:

•Вероятность бана/фильтра.

•Вероятность выпадения страницы.

Вероятность бана или фильтра могут иметь достаточное количество сайтов, например это может быть сайт-галерея, специально созданный под сапу, мы ввели параметры:

•Displayimage (галерея изображений)

•Thumbnails (галерея изображений)

•dn=photos (галерея изображений)

•.php?vac_id= (распарсенная база вакансий)

Отмечаем эти сайты и можем смело заносить их в глобальный черный список или черный список проекта.

Следующие параметры – не имеют четкой привязанности к характеристикам сайта, они имеют определенные характеристики страницы:

•User

http://www.seobuilding.ru/seo-forum/index.php стр. 299 из 536 30.11.2010 http://www.seobuilding.ru/

SEO: Поисковая Оптимизация от А до Я => Продвижение ссылками

•Tag

•Archive

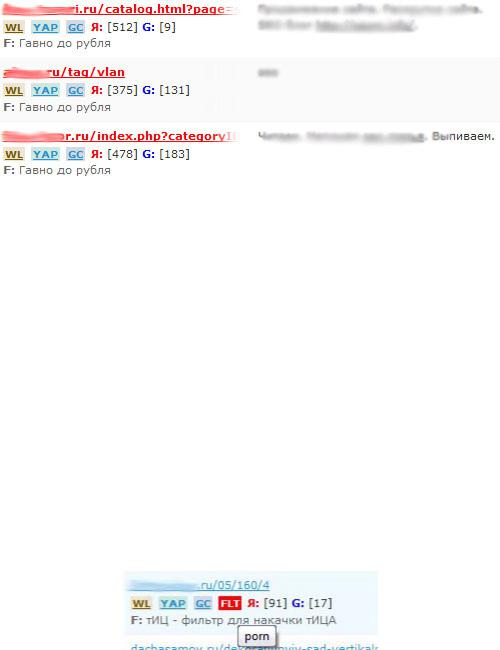

Этими параметрами мы можем отсеивать системные страницы, которые могут быть в индексе, но будут рано или поздно выпадать, как содержащие дублированный контент, если это страницы тегов или архивов, либо системные страницы профилей юзеров, регистраций и прочего.

Этот классификатор не дает нам права метить площадку черным списком, ведь это не характеристики целого сайта, поэтому мы отменяем эти страницы, не добавляя их в черные списки, в следующий раз нам придут другие страниц этого сайта.

Надеюсь я доступно объяснил, что есть признаки сайта и страницы, их нужно четко различать, иначе будете "расходовать доноров" не правильно.

Второй барьер – количество страниц в индексе, здесь нужно быть аккуратным. Основная его цель – отсеять сайты попавшие под АГС, по количеству проиндексированных страниц.

Я бы советовал не ориентироваться на показатели SAPE и перед кнопкой Cn (по количеству страниц) нажать H (проверка количества проиндексированных страниц), что позволить получить реальные данные на нынешний момент. В результате мы получим именно сегодняшние данные и сможем нажать заветную кнопку Cn, которая отметит сайты достойные черного списка (допустим содержащие менее 15 страниц в индексе Яндекса).

Третий барьер – контент фильтр или TF. Частично методику я уже описывал, мы можем фильтровать достаточно доноров по разным параметрам. Допустим на сайте есть "porno" и мы его заметили. Если не углубляться в детали – этот параметр достоин черного списка.

Но не каждый сайт содержащий параметры, перечисленные ниже, достоин черного списка:

•Keygen

•IFolde

•RapidShare

•Megaupload

Здесь мы можем либо отменить и нам предложат новые страницы, либо добавить в черный список конкретного проекта (BL), т.к. глобального он может быть и не достоин. TF я касался уже, поэтому не будем затрагивать его детально, отвечу на вопросы в комментариях, если будут.

http://www.seobuilding.ru/seo-forum/index.php стр. 300 из 536 30.11.2010 http://www.seobuilding.ru/