- •1. Информатика. Структура предметной области. Объекты изучения информатики. Основные задачи информатики.

- •4. Междисциплинарные направления информатики.

- •5. Формулировка предметной задачи. Задачная ситуация.

- •6. Формализация предметной задачи. Уровни формализации задач.

- •9. Представления о системном подходе.

- •10. Коммуникация как передача информации о модели.

- •11. Что такое информация, различие информации и данных.

- •12. Формы адекватности информации.

- •13. Классификация мер информации.

- •14. Синтаксические меры информации.

- •7. Общая схема постановки и решения предметных задач.

- •8. Понятие о модели. Типы моделей.

- •3. Социальная информатика. Объект и предмет исследований. Фундаментальная проблема социальной информатики. Основные проблемы научных исследований в социальной информатике.

- •15. Семантические меры информации.

- •16. Прагматические меры информации.

- •18. Системы классификации, основные идеи.

- •20. Информационные системы. Этапы развития информационных систем.

- •21. Основные процессы в информационной системе.

- •22. Свойства информационной системы. Что дает внедрение информационной системы.

- •23. Представления о жизненном цикле информационной системы.

- •24. Проблемы внедрения информационных систем.

- •25. Структура информационной системы.

- •19. Системы кодирования информации, классификация методов.

- •17. Показатели качества информации.

- •32. Роль структуры управления в информационной системе. Классификация информационных систем по функциональному признаку и уровням управления.

- •33. Классификация информационных систем по степени автоматизации.

- •34. Классификация информационных систем по характеру использования информации.

- •35. Классификация информационных систем по признаку структурированности задач.

- •38. Информационные технологии. Критерий эффективности информационных технологий.

- •39. Классификация информационных технологий по типу обрабатываемой информации.

- •40. Ит обработки данных. Классы задач. Основные компоненты.

- •41. Цель ит управления (иту). Классы задач, решаемые в рамках иту. Основные компоненты иту.

- •42. Характеристики и назначение ит автоматизации офиса. Основные компоненты.

- •36. Понятие информационной технологии. Функциональные и обеспечивающие информационные технологии.

- •37. Основные свойства информационных технологий, определяющие их роль в технологическом развитии современного общества.

- •43. Ит поддержки принятия решений. Основная цель итппр. Отличительные характеристики итппр. Основные компоненты итппр.

- •45. Классы задач, решаемые с помощью экспертных систем.

- •46. Информационные технологии в социальной сфере.

- •47. Современное состояние и основные тенденции развития информационных технологий.

- •48. Глобальные концепции развития информационных технологий. Концепция открытых систем. Концепция Глобальной информационной инфраструктуры.

- •49. Геоинформационные системы. Составные части гис.

- •50. Классы задач, решаемые с помощью гис.

- •44. Информационные технологии экспертных систем. Основные компоненты экспертной системы, специалисты-разработчики.

- •51. Основные функциональные возможности геоинформационных систем.

- •52. Основные возможности анализа данных в гис Grin View.

- •53. Компьютеры. Поколения эвм. Классификации компьютеров.

- •54. Техническое обеспечение компьютера.

- •55. Архитектура пк. Основные блоки пк и их назначение.

- •57. Интеллектуальное обеспечение компьютеров.

- •58. Программирование. Типы программирования. Классификация компьютерных языков по уровню.

- •59. Принципы создания компьютерных языков (логическое, функциональное, объектно-ориентированное, процедурное программирование).

- •56. Программное обеспечение компьютеров.

- •60. Основные принципы архитектуры фон Неймана.

- •61. Централизованная и распределенная обработка данных.

- •64. Классификации вычислительных сетей.

- •65. Локальные вычислительные сети (см.Выше).

- •66. Основные характеристики и требования к коммуникационной сети.

- •67. Глобальные сети. Internet. Способы передачи информации в internet.

- •68. Искусственный интеллект. Основные разделы искусственного интеллекта. Основные проблемы искусственного интеллекта.

- •62. Основные программные и аппаратные компоненты сети.

- •63. Функциональные группы устройств в сети.

- •72. Интеллектуальные информационные технологии.

- •73. Информационные ресурсы. Информационные продукты и услуги.

- •74. Информационный бизнес. Основные функции информационного бизнеса.

- •75. Информационные технологии в производстве. Основные проблемы. Основные виды.

- •76. Электронный бизнес. Преимущества электронного бизнеса. Основные модели электронного бизнеса. Ключевые проблемы электронного бизнеса.

- •77. Информационная безопасность человека и общества Основные цели обеспечения информационной безопасности.

- •78. Информационные войны.

- •80. Элементы системы защиты информации.

- •81. Технология использования цифровой подписи.

- •82. Анализ защищенности сети (сетевой аудит).

- •83. Основные виды информационных преступлений.

- •84. Вредоносные программы. Основные виды вредоносных программ и их жизненный цикл.

- •Другие вредоносные программы:

- •79. Представления о защите информации. Основные цели защиты информации.

- •85. Антивирусы. Основные технологии обнаружения вирусов. Основные виды антивирусных программ.

- •Поиск вирусов, выполняющих подозрительные действия.

- •87. Информационный кризис, его предпосылки, содержание, симптомы, последствия.

- •88. Информационное неравенство. Основные факторы, влияющие на цифровой разрыв.

- •89. Информатизация общества. Условия успешного развития информатизации общества.

- •90. Информационное общество. Основные характеристики информационного общества.

- •91. Информационное общество и Россия. Готовность к информационному обществу.

- •94. Информационный потенциал общества.

- •95. Информационная культура.

- •96. Информационная грамотность.

- •Карантин. Среди прочих вспомогательных средств во многих антивирусах есть специальные технологии, которые защищают от возможной потери данных в результате действий антивируса.

- •86. Информационные революции.

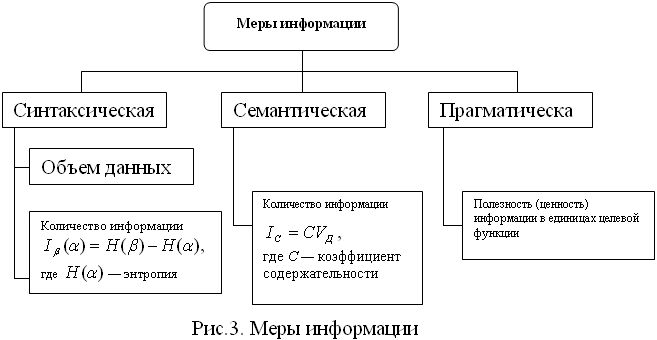

13. Классификация мер информации.

Кажется очевидным, что одни сообщения содержат мало информации, а другие — много. Для измерения информации вводятся два параметра: количество информации I и объем данных VД. Количество информации имеет разные выражения и интерпретацию в зависимости от рассматриваемой формы адекватности. Каждой форме адекватности соответствует своя мера количества информации.

14. Синтаксические меры информации.

В основе всей теории информации лежит открытие, сделанное в 1928 г. американским инженером Р.Хартли и состоящее в том, что информация, передаваемая по каналам связи, допускает количественную оценку. Завершенный и полный вид этой теории придал в конце 1940-х гг. К.Шеннон.

Количество информации I на синтаксическом уровне невозможно определить без рассмотрения понятия неопределенности состояния системы. Подход Хартли основан на фундаментальных теоретико-множественных, по существу комбинаторных основаниях, а также нескольких интуитивно ясных и вполне очевидных предположениях.

Хартли принял «количество информации», передаваемое по каналу связи относительно двух равноправных исходов и снимающее неопределенность путем оказания на один из них, за единицу информации, получившую название «бит» (bit –binary digit – двоичный разряд).

Создатель статистической теории информации Клод Шеннон обобщил результат Хартли и его предшественников. Его труды явились ответом на бурное развитие в середине века средств связи: радио, телефона, телеграфа, телевидения. Теория информации Шеннона позволяла ставить и решать задачи об оптимальном кодировании передаваемых сигналов с целью повышения пропускной способности каналов связи, подсказывала пути борьбы с помехами на линиях и т.д.

Получение информации о какой-либо системе всегда связано с изменением степени неосведомленности получателя о состоянии этой системы. Пусть до получения информации потребитель имеет некоторые предварительные (априорные) сведения о системе . Мерой его неосведомленности о системе является функция H(), которая в то же время служит и мерой неопределенности состояния системы.

После получения некоторого сообщения β получатель приобрел некоторую дополнительную информацию Iβ(α), уменьшившую его априорную неосведомленность так, что апостериорная (после получения сообщения β) неопределенность состояния системы стала Нβ(α). Тогда количество информации Iβ(α) о системе, полученной в сообщении β, определится как Iβ(α)= Н(α) - Нβ(α), т.е. количество информации измеряется изменением (уменьшением) неопределенности состояния системы.

Объем данных VД в сообщении измеряется количеством символов (разрядов) в этом сообщении. В различных системах счисления один разряд имеет различный вес и соответственно меняется единица измерения данных: в двоичной системе счисления единица измерения – бит, в десятичной – дит. Коэффициент (степень) информативности (лаконичность) сообщения определяется отношением количества информации к объему данных, т.е. У = I/ VД, причем 0<У<1. С увеличением У уменьшаются объемы работ по преобразованию информации (данных) в системе, поэтому стремятся к повышению информативности, для чего разрабатываются специальные методы оптимального кодирования информации.

результатов состоит в согласовании результатов с целью исследования, сформулированными требованиями к результату и принятии решения об использовании результатов либо об уточнении модельных представлений и формулировки задачи.