- •Н.Н. Куцый теория информации

- •1. О понятии "информация"

- •2. Этапы обращения информации

- •3. Информационные системы

- •4. Система передачи информации: основные понятия и определения

- •5. Уровни проблем передачи информации

- •6. Теория информации

- •7. Понятия сигнала и его модели

- •8. Формы представления детерминированных сигналов

- •9. Ортогональные представления сигналов

- •10. Временная форма представления сигнала

- •11. Частотная форма представления сигнала. Спектры периодических сигналов

- •12. Распределение энергии в спектре периодического сигнала

- •13. Частотная форма представления сигнала. Спектры непериодических сигналов

- •14. Распределение энергии в спектре непериодического сигнала

- •15.Соотношения между длительностью импульсов и шириной их спектра

- •16.Спектральная плотность мощности детерминированного сигнала

- •17.Функция автокорреляции детерминированного сигнала

- •18.Случайный процесс как модель сигнала

- •19.Стационарные и эргодические процессы

- •20.Спектральное представление случайных сигналов

- •21.Частотное представление стационарных случайных процессов (дискретный спектр)

- •22.Частотное представление стационарных случайных сигналов. Непрерывные спектры

- •23.Основные свойства спектральной плотности

- •24.Преимущества цифровой формы представления сигналов

- •25.Общая постановка задачи дискретизации

- •26.Способы восстановления непрерывного сигнала

- •27.Критерии качества восстановления

- •28.Методы дискретизации посредством выборок

- •29.Равномерная дискретизация. Теорема котельникова

- •30.Теоретические и практические аспекты использования теоремы котельникова

- •31.Дискретизация по критерию наибольшего отклонения

- •32.Адаптивная дискретизация

- •33.Квантование сигнала

- •34.Квантование сигналов при наличии помех

- •35.Геометрическая форма представления сигналов

- •36.Энтропия как мера неопределенности выбора

- •37.Свойства энтропии

- •38.Условная энтропия и её свойства

- •39.Энтропия непрерывного источника информации (дифференциальная энтропия)

- •40.Свойства дифференциальной энтропии

- •41.Количество информации как мера снятой неопределенности

- •42.Эпсилон-энтропия случайной величины

- •43.Информационные характеристики источника сообщений и канала связи. Основные понятия и определения

- •44.Информационные характеристики источника дискретных сообщений

- •45.Информационные характеристики дискретных каналов связи

- •46.Информационные характеристики источника непрерывных сообщений

- •47.Информационные характеристики непрерывных каналов связи

37.Свойства энтропии

Рассмотрим основные свойства энтропии, обратив внимание на то, что сформулированные условия для меры неопределенности выполняются.

1.Энтропия

является вещественной и неотрицательной

величиной, так как для любого

![]()

![]()

![]() изменяется в интервале от 0 до 1,

изменяется в интервале от 0 до 1,

![]() отрицателен и, следовательно,

отрицателен и, следовательно,

![]() положительна.

положительна.

2.Энтропия

– величина ограниченная. Для слагаемых

![]() в диапазоне

в диапазоне

![]() ограниченность очевидна. Остаётся

определить предел, к которому стремится

слагаемое

ограниченность очевидна. Остаётся

определить предел, к которому стремится

слагаемое

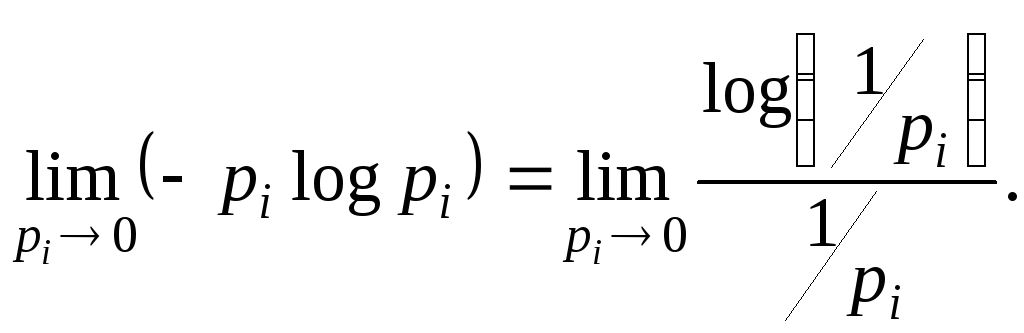

![]() при

при

![]() .

Так как

.

Так как

![]() при этом неограниченно возрастает:

при этом неограниченно возрастает:

Обозначив

![]() и воспользовавшись правилом Лопиталя,

получим

и воспользовавшись правилом Лопиталя,

получим

.

.

3.Энтропия обращается в нуль лишь в том случае, если вероятность одного из состояний равна единице; тогда вероятности всех остальных состояний, естественно равны нулю. Это положение соответствует случаю, когда состояние источника полностью определенно.

4.Энтропия максимальна, когда все состояния равновероятны, что можно доказать методом неопределенных множителей Лагранжа:

![]() .

.

5.Энтропия

источника

![]() с двумя состояниями

с двумя состояниями

![]() и

и

![]() изменяется от нуля до единицы, достигая

максимума при равенстве их вероятностей:

изменяется от нуля до единицы, достигая

максимума при равенстве их вероятностей:

![]() .

.

График

зависимости

![]() в функции

в функции

![]()

![]()

п риведен

на рис. ... При

риведен

на рис. ... При

![]() частная неопределенность, которая

приходится на состояние

частная неопределенность, которая

приходится на состояние

![]() ,

велика, однако такие состояния источника

весьма редки. Состояния

,

велика, однако такие состояния источника

весьма редки. Состояния

![]() реализуется часто, но неопределенность,

которая приходится на такое состояние,

очень мало. Поэтому энтропия, которая

характеризует среднюю неопределенность

на одно состояние ансамбля, также мала.

Аналогичная ситуация наблюдается при

реализуется часто, но неопределенность,

которая приходится на такое состояние,

очень мало. Поэтому энтропия, которая

характеризует среднюю неопределенность

на одно состояние ансамбля, также мала.

Аналогичная ситуация наблюдается при

![]() .

.

Отметим,

что энтропия непрерывно зависит от

вероятностей отдельных состояний, что

непосредственно вытекает из непрерывности

функции

![]() .

.

6.Энтропия объединения нескольких статистически независимых источников информации равна сумме энтропий исходных источников.

Не

теряя общности, ограничимся рассмотрением

объединения, которое включает два

источника информации

![]() и

и

![]() .

Под объединением двух источников

.

Под объединением двух источников

![]() и

и

![]() понимают обобщенный источник информации

понимают обобщенный источник информации

![]() ,

который характеризуется вероятностями

,

который характеризуется вероятностями

![]() всех возможных состояний

всех возможных состояний

![]() комбинаций источника

комбинаций источника

![]() и

и

![]() источника

источника

![]() .

Аналогично трактуется и объединение

ансамблей.

.

Аналогично трактуется и объединение

ансамблей.

В соответствии с определением энтропия объединения

![]() .

.

Здесь

![]() вероятность

совместной реализации состояний

вероятность

совместной реализации состояний

![]() и

и

![]() .

.

В

случае статистической независимости

источников информации

![]() и

и

![]() запишем

запишем

![]() .

.

Тогда

![]()

![]() .

.

Учитывая, что

![]() и

и

![]() ,

,

получим

![]() .

.

Соответственно

для энтропии объединения нескольких

независимых источников

![]() имеем

имеем

![]() .

.

В дальнейшем для придания общности получаемым результатам о неопределенности выбора будем говорить в основном применительно к математическим моделям источников информации в виде ансамблей.

7.Энтропия характеризует среднюю неопределенность выбора одного состояния из ансамбля. При её определении используют только вероятности состояний, полностью игнорируя их содержательную сторону. Поэтому энтропия не может служить средством решения любых задач, связанных с неопределенностью. Например, при использовании этой меры для оценки неопределенности действия лекарства, приводящего к полному выздоровлению больных в 90% и улучшению самочувствия в остальных 10% случаев, она получится такой же, как и у лекарства, вызывающего в 90% случаев смерть, а в 10% - ухудшение состояния больных.

8.Энтропия как мера неопределенности согласуется с экспериментальными данными, полученными при изучении психологических реакций человека, в частности реакции выбора. Установлено, что время безошибочной реакции на последовательность беспорядочно чередующихся равновероятных раздражителей (например, загорающихся лампочек) растёт с увеличением их числа так же, как энтропия. Это время характеризует неопределенность выбора одного раздражителя.

Замена равновероятных раздражителей неравновероятными приводит к снижению среднего времени реакции настолько, насколько уменьшается энтропия.