- •1 Семестр

- •1. Информатика, ее предмет и задачи. Основные понятия информатики. Информация и формы ее представления.

- •2. Информационный процесс. Фазы информационного процесса

- •3. Количество информации

- •3.1. Энтропийный способ

- •3.2. Объемный способ измерения информации

- •4. Качество информации

- •5. Системы счисления

- •5.1. Позиционные системы счисления

- •5.2. Перевод чисел из одной сс в другую

- •5.3. Смешанные сс

- •Преобразование чисел из двоичной системы в восьмеричную и шестнадцатеричную

- •6. Кодирование информации

- •6.1. Цели кодирования

- •6.2. Понятие о специальном кодировании

- •7. Внутреннее представление данных в памяти эвм

- •7.1. Числа с фиксированной точкой.

- •7.2. Числа с плавающей точкой

- •7.3. Символы

- •7.4. Кодирование графической информации

- •7.5. Кодирование звуковой информации

- •8. Понятие архитектуры и принципы устройства вычислительных систем

- •9. Базовая аппаратная конфигурация персонального компьютера (пк)

- •10. Внутренние устройства системного блока пк.

- •10.1. Устройства, расположенные на материнской плате

- •10.2. Внешняя память

- •11. Периферийные устройства пк

- •11.1. Устройства ввода данных

- •11.2. Устройства вывода данных

- •11.3. Устройства обмена данными

- •12. Файловая организация данных. Понятие таблицы размещения файлов. Таблицы размещения файлов fat, vfat, fat32, ntfs

- •12.1. Имена файлов

- •12.2. Каталоги

- •12.3. Физическая организация файловой системы

- •12.3. Примеры файловых систем

- •13. Понятие ос

- •13.1. Эволюция ос

- •13.2. Классификация ос

- •13.3. Основные функции ос

- •13.4. Оc Windows

- •13.5. Основные технологические принципы Windows

- •14. Прикладное программное обеспечение. Классификация пакетов прикладных программ

- •15. Прикладное по на примере текстовых редакторов и электронных таблиц

- •1. Таблицы и табличные процессоры

- •16. Вычислительные сети. Принципы построения и классификация

- •17. Локальные вычислительные сети(лвс). Топологии лвс, методы доступа, модели взаимодействия (файл-сервер и клиент сервер)

- •18. Глобальные вычислительные сети (Internet). Основные службы глобальной сети

- •19. Принципы функционирования Internet.

- •20. Технология www

- •21. Язык гипертекстовой разметки html

- •22. Электронная почта в Internet

- •23. Безопасность информации. Вирусы и антивирусные программы.

2. Информационный процесс. Фазы информационного процесса

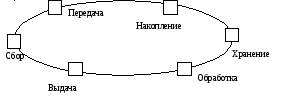

Процесс, возникающий в результате установления связи между объектами реального мира, один из которых является источником, а другой потребителем информации, называется информационным. В информационных процессах можно выделить отдельные части – фазы. Фазы информационного процесса образуют полный (замкнутый) цикл.

Сбор информации - деятельность субъекта, в ходе которой он получает сведения об интересующем его объекте. Сбор информации может проводиться или человеком или с помощью технических средств (аппаратно). Например, пользователь может получить информацию о движении поездов несколькими способами:

самостоятельно изучив расписание движения поездов;

спросить у другого человека;

через документы, составленные другим человеком;

с помощью технических средств (автоматическая справка).

Обмен информацией – процесс, в ходе которого источник информации ее передает, а получатель – принимает. Если в передаваемых сообщениях обнаружены ошибки, то организуется повторная передача информации. Передача может осуществляться различными способами: с помощью курьера, по почте, с помощью транспортных средств, передача по каналам данных. В результате обмена между источником и получателем устанавливается «информационный баланс», при котором в идеальном случае получатель будет располагать той же информацией, что и источник.

Принятую информацию получатель может использовать неоднократно. С этой целью он должен зафиксировать ее на материальном носителе (бумажном, магнитном, фото, видео и др.). Процесс формирования исходного несистематизированного массива информации называется накоплением информации. Среди записанных сигналов могут быть такие, которые отражают ценную или часто используемую информацию, а могут быть и такие, которые не представляют ценности в настоящее время, но потребуются в дальнейшем.

Хранение информации – это процесс поддержания исходной информации в виде обеспечивающем выдачу данных по запросам в установленные сроки.

Обработка информации – упорядоченный процесс ее преобразования в соответствии с алгоритмом решения задач.

После обработки информации результат должен быть выдан конечному пользователю в требуемом виде. Эта операция реализуется в ходе решения задачи выдачи информации. Информация может выдаваться в виде текстов, таблиц, рисунков, диаграмм, графиков.

3. Количество информации

Существуют следующие способы измерения информации:

энтропийный (вероятностный);

объемный;

3.1. Энтропийный способ

В теории информации и кодирования принят энтропийный или вероятностный подход к измерению информации. Количество информации– это числовая характеристика сигнала, которая отражает ту степень неопределенности (неполноту) знаний, которая исчезает после получения сообщения в виде данного сигнала. Меру неопределенности в теории информации называют энтропией, следовательно, метод называется энтропийным.

Неопределенность можно охарактеризовать количеством возможных выборов действий в конкретной ситуации, а полученную информацию величиной, на которую уменьшилась степень неопределенности. При полной информации выбора нет.

Пример 1.Необходимо найти дом, в котором на какой-то известной улице живет нужный человек. Информация о том, что номер дома четный уменьшит неопределенность в два раза.

Пример 2.Человек бросает монету и наблюдает какой стороной она упадет. Обе стороны монеты равноценны, поэтому вероятности того, что она упадет орлом или решкой одинаковы. Такой ситуации приписывается начальная неопределенность, характеризуемая двумя возможностями. Когда монета упадет, неопределенность равна 0.

Этот пример относится к группе событий, применительно к которым можно поставить вопрос типа «Да – Нет». Количество информации, которое можно получить при ответе на такой вопрос называется битом (binarydigit).

Бит - это минимальная единица количества информации, т. к. получить информацию меньше одного бита нельзя. При получении информации в один бит неопределенность уменьшается в два раза. Таким образом, бросание монеты дает информацию 1 бит.

Пример 3. Рассмотрим систему из 2 электрических лампочек, которые независимо друг от друга могут быть включены или выключены. Такая система может иметь следующие состояния:

|

Лампа А |

0 |

0 |

1 |

1 |

|

Лампа В |

0 |

1 |

0 |

1 |

Чтобы получить информацию об этой системе, надо задать два вопроса: о лампочке А и о лампочке В., т. е. количество информации, содержащейся в этой системе I=2бита, а количество возможных состояний системыN=4.

Если взять 3 лампочки , то количество информации Iбудет равно 3бита, а количество возможных состояний системыN=8.

Связь между количеством информации и числом состояний системы устанавливается формулой Хартли

![]() ,

,

где N- количество возможных состояний системы (или количество равновероятных событий),

I– количество бит в сообщении о том, что такое событие произошло.

Ту же формулу можно записать

![]() .

.

Если события не равновероятны, то количество бит в сообщении о том, что произошло данное событие будет равно

![]() ,

,

где

![]() - вероятность того, что произойдетj–е событие.

- вероятность того, что произойдетj–е событие.