- •Министерство образования Российской Федерации

- •1. Информация. Общие понятия

- •Символ источника сообщений - это любое мгновенное состояние источника сообщений.

- •2.Измерение информации

- •3.Структурное (комбинаторное) определение количества информации (по Хартли)

- •4.Статистическое определение количества информации (по Шеннону).

- •5.Свойства функции энтропии источника дискретных сообщений

- •Информационная емкость дискретного сообщения.

- •7.Информация в непрерывных сообщениях

- •8. Энтропия непрерывных сообщений.

- •9.Экстремальные свойства энтропии непрерывных

- •10.Информация в непрерывных сообщениях

- •Лабораторная работа №1 Информация в дискретных сообщениях

- •П.1.А. Используя формулу Хартли, найти энтропию указанного источника дискретных сообщений (н1).

- •Лабораторная работа №2 Информация в непрерывных сообщениях

- •Некоторые полезные сведения из теории Вероятности.

- •Случайные события.

- •2. Алгебра событий

- •Случайные величины

- •4.Статистические характеристики случайных величин

- •5.Случайные функции

- •Литература

- •Содержание

5.Свойства функции энтропии источника дискретных сообщений

Свойства функции энтропии наглядно можно продемонстрировать на примере источника дискретных сообщений с объемом алфавита m равного 2, т.е. m=2. В этом случае

![]() (20)

(20)

И выражение (17) может быть записано в виде

![]() (21)

(21)

![]() (бит/символ).

(бит/символ).

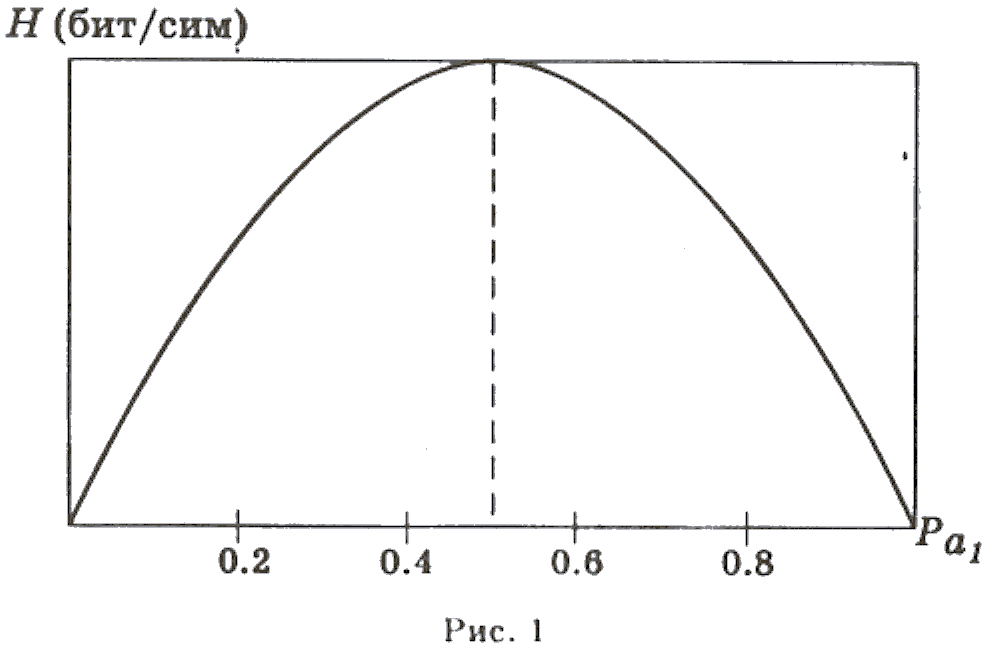

График этой функции имеет вид, представленный на рис. 1

Из графика (рис.

1) видно, что обращение вероятности

одного из

возможных состояний в 0 или

1 вносит полную определенность, и

сообщение о таком событии не содержит

в себе никакой информации.

При

![]() исход испытаний наиболее не определен

и количество информации, содержащееся

в поступившем символе, максимально.

Исходя из анализа формулы (17) и

графика (рис. 1) можно сформулировать

основные свойства функции энтропии.

исход испытаний наиболее не определен

и количество информации, содержащееся

в поступившем символе, максимально.

Исходя из анализа формулы (17) и

графика (рис. 1) можно сформулировать

основные свойства функции энтропии.

Энтропия источника дискретных сообщений есть величина вещественная, ограниченная и положительная.

Энтропия равна 0, если с вероятностью, равной единице, всегда выбирается один и тот же символ.

Энтропия максимальна, если все символы источника сообщений появляются независимо и равновероятно.

Интересно отметить, что сравнение (8), (17) и (18) показывает, что формула Хартли является частным случаем формулы Шеннона при условии независимости и равновероятности появления символов в со- общении, а формула Шеннона, в свою очередь, является частным случаем условной энтропии при условии, что символы сообщения независимы.

Таким образом, количество информации, определяемое по Хартли, т.е. при допущении полной независимости и равновероятности отдельных символов сообщения, определяет максимально возможное количество информации в сообщении заданной длины (n).

При неравновероятности появления символов (формула Шеннона) количество информации, содержащееся в сообщении заданной длины (n), снижается. Другим фактором, снижающим энтропию, а следовательно, и количество информации в сообщении, является наличие зависимости между символами – корреляции.

Из-за корреляционной связи между символами и неравновероятного их появления количество информации в реальных сообщениях падает. Количественно эти потери информации характеризуются коэффициентом избыточности (R)

![]() (22)

(22)

где

![]() —

максимальное количество информации,

которое может содержать один символ,

определяемое по формуле (8);

—

максимальное количество информации,

которое может содержать один символ,

определяемое по формуле (8);

Н —среднее количество информации, которое переносит один символ в реальных сообщениях;

m — число символов в алфавите источника сообщений.

Избыточность![]() говорит о том, что число символов в

сообщении больше, чем это требовалось

бы при полном их

использовании.

Например,

для европейских языков избыточность

составляет не менее 0.5.

говорит о том, что число символов в

сообщении больше, чем это требовалось

бы при полном их

использовании.

Например,

для европейских языков избыточность

составляет не менее 0.5.

Информационная емкость дискретного сообщения.

При описании информационных процессов часто пользуются следующими информационными характеристиками.

Производительность источника сообщений (P) — среднее количество информации, генерируемое источником в единицу времени

![]() (23)

(23)

Единицей измерения производительности источника сообщений является бот

![]()

Информационная емкость сообщения (R) — это среднее количество информации, содержащееся в сообщении единичной длительности:

![]()

где I — количество информации, содержащееся в сообщении;

t – длительность сообщения.

Скорость передачи информации (Q) — это среднее количество информации, передаваемое по каналу за единицу времени

![]() (24)

(24)

где W – скорость передачи символов (символ /с);

H–среднее количество информации приходящееся на один символ (бит /символ).

Пропускная способность (С) определяется как максимально возможное значение скорости передачи информации. При условии отсутствия помех имеем

![]() (25)

(25)

Единицей измерения скорости передачи информации, пропускной способности и информационной емкости сообщения служит бот. В качестве примера определим информационную емкость простейшего дискретного сообщения, состоящего из совокупности импульсов и пауз, причем длительность импульсов и пауз одинакова, а амплитуда импульсов постоянна, т.е. сообщение строится на использовании лишь двух символов (его объём алфавит равен 2).

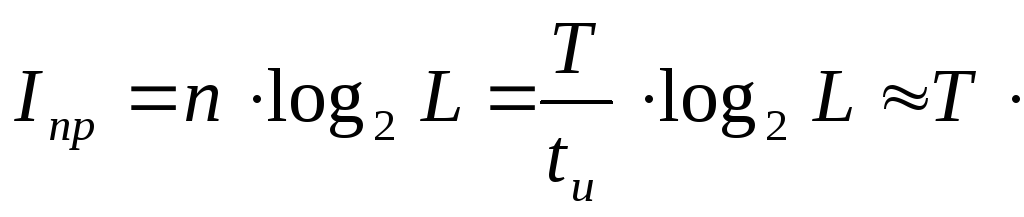

Очевидно, если избыточность отсутствует, то на каждый символ такого сообщения приходится одна двоичная единица информации (1 бит), а на все сообщение, состоящее из n символов, приходится n бит информации.

Пусть длительность

импульса и

паузы

одинакова и равна

![]() ,тогда

длительность всего сообщения (T)

будят равна

,тогда

длительность всего сообщения (T)

будят равна

![]() (26)

(26)

Из радиотехники

известно, что импульсу с длительностью

![]() со-ответствует

определенная полоса частот

со-ответствует

определенная полоса частот

![]() причем

причем

![]() (26)

(26)

где k —

коэффициент, зависящий от формы импульса

![]() .

.

Следовательно,

количество информации в рассматриваемом

двоичном сообщении длительностью Т

не может

превышать предельного значения

![]()

![]() (27)

(27)

И с учетом формулы (27) имеем

![]() =Tw

(бит) (28)

=Tw

(бит) (28)

Если

разделить![]() на

Т,

получим

предельную информационную

емкость

сообщения (R)

на

Т,

получим

предельную информационную

емкость

сообщения (R)

![]() w

(бот) (29)

w

(бот) (29)

T.е. информационная емкость двоичного дискретного сообщения численно равна полосе частот сигнала, с помощью которого передаются символы сообщения, выраженной в герцах.

Пусть

теперь дискретное сообщение состоит

из последовательности импульсов

длительностью

![]() ,причем

паузы между импульсами отсутствуют, а

амплитуда каждого импульса соответствует

одному из

L

заранее

установленных дискретных уровней.

Тогда можно считать,

что алфавит

источника сообщений состоит из L

равновероятных

и не-зависимых

символов и количество информации в

сообщении, состо-ящем

из n

таких символов (длительностью Т),

не

может превышать предельного значения

(

,причем

паузы между импульсами отсутствуют, а

амплитуда каждого импульса соответствует

одному из

L

заранее

установленных дискретных уровней.

Тогда можно считать,

что алфавит

источника сообщений состоит из L

равновероятных

и не-зависимых

символов и количество информации в

сообщении, состо-ящем

из n

таких символов (длительностью Т),

не

может превышать предельного значения

(![]() ),

определяемого как

),

определяемого как

w

w![]() (бит) (30)

(бит) (30)

Информационная емкость такого сообщения (сигнала) (R) равна:

w

w![]() (31)

(31)

Следует отметить, что полученные выражения имеют смысл только тогда, когда разность между двумя соседними символами значительно превышает уровень помехи и когда отсутствует избыточность. В противном случае, а также в случае, когда символы, формирующие сообщение имеют различную длительность, вычисление информаци-онной емкости сообщения является более сложной задачей.