- •Двунаправленная ассоциативная память.

- •Основные понятия генетических алгоритмов.

- •Классический генетический алгоритм.

- •Решение комбинаторных задач с помощью генетических алгоритмов.

- •Пример 5

- •Интеллектуальные информационные системы в условиях неопределенности и риска.

- •Основные понятия теории нечетких множеств.

- •Лингвистические переменные и нечеткие правила вывода.

- •Системы нечеткого вывода Мамдани-Заде.

- •Фазификатор и дефазификатор

- •Модель Мамдани-Заде как универсальный аппроксиматор.

Фазификатор и дефазификатор

Фазификатор.

Фазификатор преобразует n-мерный вектор X в нечеткое множество A, которое описывается функцией принадлежности . Наибольшей популярностью пользуется функция принадлежности следующих типов:

Гауссовская функция.

C – центр

-

коэф. Гауса

-

коэф. Гауса

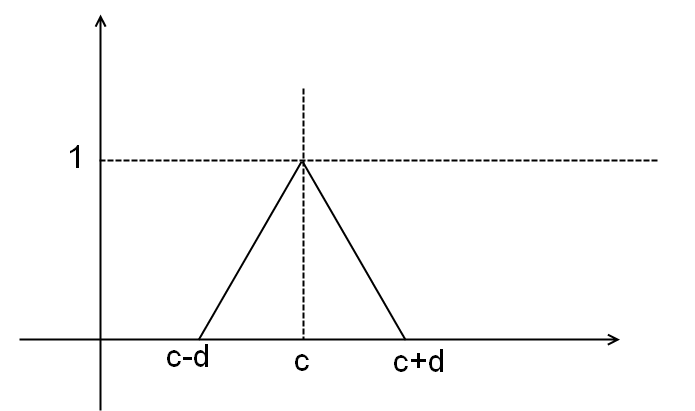

Симметричная треугольная функция.

Трапецеидальная функция

Дефазификатор.

Трансформировать

нечеткое множество

в точное решение y

можно многими способами:

в точное решение y

можно многими способами:

Дефазификация относительно центра области:

Дефазификация относительно среднего центра:

-

центр -ого нечеткого правила

-

центр -ого нечеткого правила

-

соответствующая функция принадлежности

-

соответствующая функция принадлежности

Дефазификация относительно среднего максимума:

– точка

максимума i-ого

правила

– точка

максимума i-ого

правила

Модель Мамдани-Заде как универсальный аппроксиматор.

Модели нечеткого

вывода позволяют описать выходной

сигнал многомерного процесса как

нелинейную функцию выходных переменных

и параметров нечеткой системы. Например,

при использовании в качестве агрегатора

оператора алгебраического произведения,

с последующей дефазификацией относительно

среднего центра. В модели Мамдани-Заде

каждое из M

правил определяется уровнем активации

и параметров нечеткой системы. Например,

при использовании в качестве агрегатора

оператора алгебраического произведения,

с последующей дефазификацией относительно

среднего центра. В модели Мамдани-Заде

каждое из M

правил определяется уровнем активации

,

где

,

где

- это значения y при котором

- это значения y при котором

достигает максимального значения.

достигает максимального значения.

- центр нечеткого множества заключения

j-ого

правила. Тогда дефазификация относительно

среднего центра даст значение

- центр нечеткого множества заключения

j-ого

правила. Тогда дефазификация относительно

среднего центра даст значение

.

.

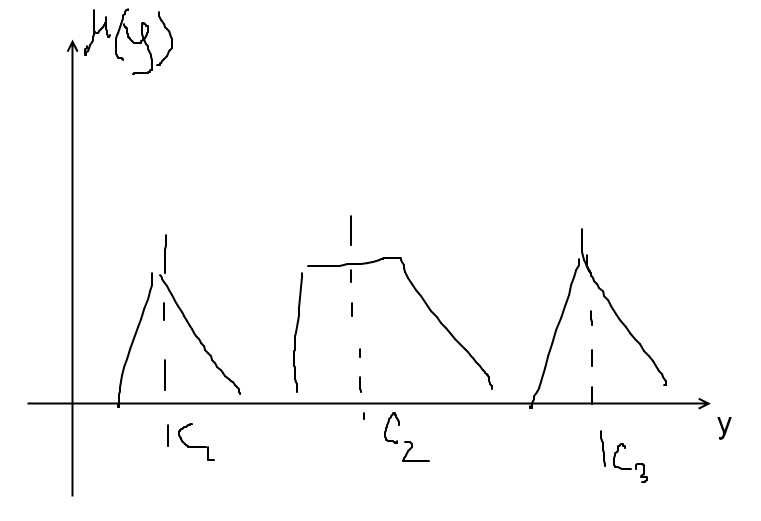

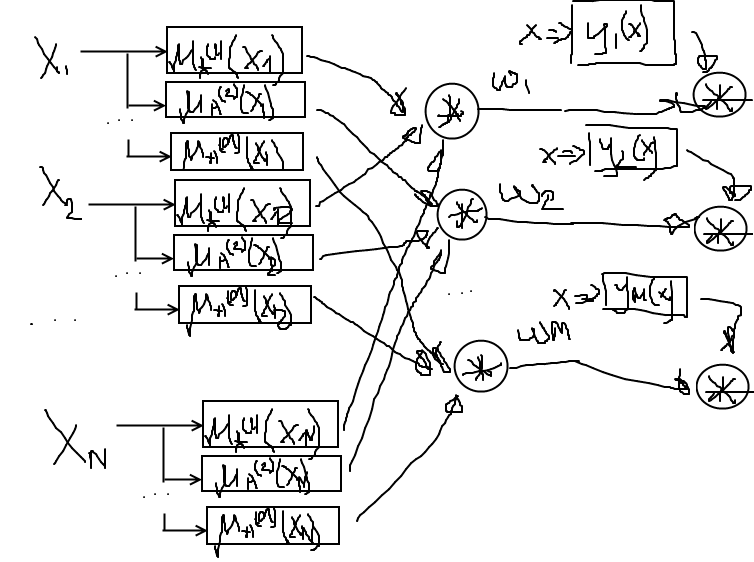

Приведенная формула модели Мамдани-Заде имеет модульную структуру, которая может быть представлена в виде многослойной структуры, напоминающей структуру классических нейронных сетей. Такие сети мы будем называть нечеткими нейронными сетями. Характерной их особенностью является возможность использования нечетких правил вывода для расчета выходного сигнала. Обучение таких сетей сводится к расчету параметров функции фазификации.

Нечеткая сеть TSK(Такаги-Сугено-Канга).

Схема вывода в модели TSK, при использовании M правил и N переменных, имеет вид:

Условие

реализуется функцией фазификции

реализуется функцией фазификции

.

.

При M правилах агрегированный выходной результат сети имеет следующий вид:

Где

- это значение

активности i-ого

правила.

- это значение

активности i-ого

правила.

Формуле (*) можно поставить в соответствие многослойную нейронную сеть, состоящую из пяти слоев

Первый слой

выполняет фазификацию каждой переменной.

Это параметрический слой с параметрами

подлежащими адаптации в процессе

обучения.

подлежащими адаптации в процессе

обучения.

Второй слой

выполняет агрегирование отдельных

переменных, определяет результирующее

значение коэффициента принадлежности

.

Это не параметрический слой.

.

Это не параметрический слой.

Третий слой это

генератор функций TSK.

Он рассчитывает значение

.

В этом же слое производится умножение

.

В этом слое адаптации подлежат веса

.

В этом слое адаптации подлежат веса

.

.

Четвертый слой включает в себя два нейрона-сумматора, один из которых рассчитывает взвешенную сумму сигналов , а второй сумму весов .

Пятый слой состоит из одного нейрона, в котором вычисляется выходной сигнал сети путем деления взвешенной суммы сигналов на сумму весов .

Таким образом,

чтобы обучить нечеткую нейронную сеть

TSK,

нужно настроить параметры функций

принадлежности первого слоя и коэффициенты

третьего слоя.

третьего слоя.

Гибридный алгоритм обучения нечетких сетей.

Уточнение параметров

нечеткой сети TSK

проводится в два этапа. На первом этапе,

при фиксации параметров функций

принадлежности рассчитываются параметры

третьего слоя путем решения системы

линейных уравнений. Реализуемое сетью

преобразование можно представить в

виде

,

где

,

где

.

.

При K

примерах вида

и замене выходного сигнала сети ожидаемым

сигналом

и замене выходного сигнала сети ожидаемым

сигналом

мы получим систему из K

линейных уравнений, которое в матричном

виде можно записать в следующем виде:

мы получим систему из K

линейных уравнений, которое в матричном

виде можно записать в следующем виде:

,

где

,

где

– это уровень активации i-ого

правила при предъявлении этого входного

вектора

– это уровень активации i-ого

правила при предъявлении этого входного

вектора

.

.

Размерность матрицы

при этом количество строк этой матрицы

гораздо больше количества столбцов

при этом количество строк этой матрицы

гораздо больше количества столбцов

.

.

Решение этой

системы уравнений имеет вид

,

где

,

где

это псевдоинверсия матрицы

это псевдоинверсия матрицы

и ищется она с помощью следующей задачи

минимизации:

и ищется она с помощью следующей задачи

минимизации:

,

где

,

где

- единичная матрица.

- единичная матрица.