- •2020 Год каждые 72 дня

- •3. Направления исследований в области ии

- •1939 Год Всемирная выставка в Нью-Йорке,

- •Вопрос 7. Представление знаний в виде продукций

- •Вопрос 8. Фреймы. Примеры фреймового представления знаний

- •Вопрос 9. Семантические методы представления знаний

- •10. Классификация задач

- •11. Признаки классификации иис

- •Вопрос 16. Экспертные системы (системы основанные на знаниях)(соз)

- •Вопрос 17. Архитектура эс. Базы знаний

- •Вопрос 18. Архитектура эс. Машина логического вывода (механизм)

- •19. Подсистема объяснения

- •20. Системы с интеллектуальным интерфейсом

- •21. Этапы создания эс

- •1. Структуризация общей задачи на связанные подзадачи

- •2. Структуризация предметной области на основе иерархии классов

- •3. Структуризация знаний на декларативные и процедурные

- •4. Структуризация приложения на основе иерархии «часть/целое»

- •Вопрос 25. Системы, использующие несколько источников знаний

- •Вопрос 26. Искусственные нейронные сети

- •Вопрос 27. Интеллектуальный анализ данных (Data Mining)

- •28. Системы управления знаниями

3. Структуризация знаний на декларативные и процедурные

По форме описания знания подразделяются на:

декларативные;

процедурные.

Декларативные знания – это знания, которые записаны в памяти интеллектуальной системы так, что они непосредственно доступны для использования после обращения к соответствующему полю памяти. Обычно декларативные знания используются для представления информации о свойствах и фактах предметной области. По форме представления декларативные знания противопоставляются процедурным знаниям.

Процедурные знания – это знания, хранящиеся в памяти интеллектуальной системы в виде описания процедур, с помощью которых их можно получить. Обычно процедурные знания используются для представления информации о способах решения задач в проблемной области, а также различные инструкции, методики и т.п.

4. Структуризация приложения на основе иерархии «часть/целое»

Модульный принцип создания приложения предоставляет разработчику различные возможности разбиения приложения на подсистемы, легче поддающиеся сопровождению и модификации. Разбиение приложения на модули упрощает процесс тестирования за счет использования групповой работы над тестируемой системой. Модульность также обеспечивает базовые возможности для повторного использования фрагментов системы.

Вопрос 25. Системы, использующие несколько источников знаний

Вопрос 26. Искусственные нейронные сети

Рамон-и-Кахаль 1911 год Исследование высокой эффективности мозга.Высказана идея о нейроне как структурной единице мозга.

Дж. Маккалок и У. Питс 1943 год В работе "Логическое исчисление идей, относящихся к нервной деятельности" сформулированы основные принципы построения искусственных нейронов и ИНС

Розенблатт 1958 год В работе, посвященной перцептрону, предложил новый подход к решению задачи распознания шаблонов.

Фон Мальсбург и Вильшоу 1976 год Опубликована первая работа по самоорганизующимся картам.

Продемонстрирована действующая самоорганизующаяся ИНС.

Хопфилд начало 80-х Разработка ИНС с полностью связанной структурой и оригинальным алгоритмом настройки весов.

Кохонен 1982 год выходит работа, посвященная самоорганизующимся картам. Работа является продолжением исследований фон Мальсбурга

Румельхарт, Хинтон и Вильямс 1986 год Описали алгоритм обратного распространения. Это первый эффективный алгоритм обучения многослойных перцептронов любой структуры (и, как оказалось позже, не только их).

Брумхед и Лоуе 1988 год Последнее на сегодняшний день крупное открытие в теории ИНС, связанное с введением РБФ-сетей.

Строение биологического нейрона

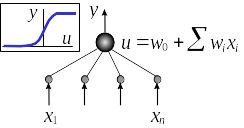

Математическая модель нейрона

Нейрон производит нелинейную операцию над линейной комбинацией входов

![]()

Активационная функция нейрона j (Ч)

Определяет нелинейное преобразование, осуществляемое нейроном.

Существует множество видов активационных функций, но более всего распространены:

— пороговая;

— линейная;

— сигмоидальная;

— тангенциальная;

— радиально-базисная.

Порговая активационная функция нейрона f(u)

![]()

Первая из введенных активационных функций.

Описана в работе Мак-Каллока и Питтса.

В честь этого модель нейрона с пороговой активационной функцией называется моделью Мак-Каллока-Питтса

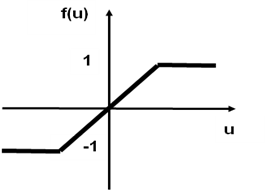

Кусочно-линейная активационная функция нейрона f(u)

![]()

В данном случае a=1, и коэффициент наклона линейного участка выбран единичным, а вся функция может интерпретироваться как аппроксимация нелинейного усилителя.

При бесконечно большом коэффициенте наклона линейного участка функция вырождается в пороговую.

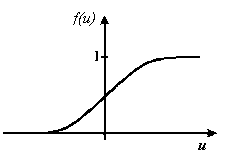

Сигмоидальная активационная функция нейрона f(u)

Наиболее широко используемый тип активационной функции.

![]()

где a — параметр, определяющий наклон функции.

Введена по аналогии с пороговой функцией, но везде является строго монотонно возрастающей, непрерывной и дифференцируемой.

Варьированием a получаются разные виды сигмоида.

Наиболее часто используется a=1.

В случае бесконечно большого a сигмоидальная функция вырождается в пороговую.

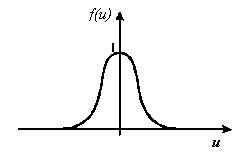

Радиально-базисная активационная функция нейрона f(u)

Во введенных Брумхеадом и Лоуе РБФ-сетях в качестве активационной применяется функция Гаусса

В теории ИНС активационные функции типа

f(z) = f(║z - c║)

где z — вектор входных сигналов нейрона,

c — вектор координат центра окна активационной функции,

норма ||.|| — евклидово расстояние,

называются радиально-базисными функциями (РБФ),

а основанные на них сети — РБФ-сетями (RBF — radial basis function).

Отличительные особенности НС (1)

состоит из простых нейропроцессорных элементов (НЭ), являющихся искусственными аналогами биологических нейронов;

НЭ связаны между собой направленными информационными каналами (ИК), для распространения сигналов, закодированных в скалярой форме;

каждый НЭ может быть связан посредством входных ИК с множеством других НЭ;

каждый НЭ имеет единственный выходной ИК, который впоследствии может разветвляться;

каждый НЭ может обладать собственной внутренней памятью (в основном в виде весовых параметров соединений) и может осуществлять локальную обработку приходящей к нему информации;

обработка информации НЭ осуществляется локально: она зависит только от значений, поступающих по входным ИК, и значений, хранящихся в его внутренней части.

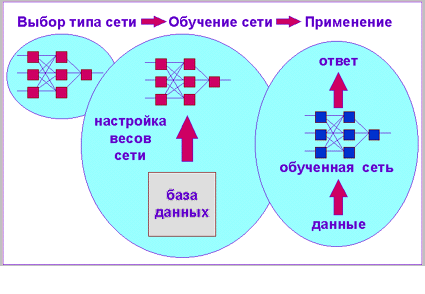

Искусственная нейронная сеть

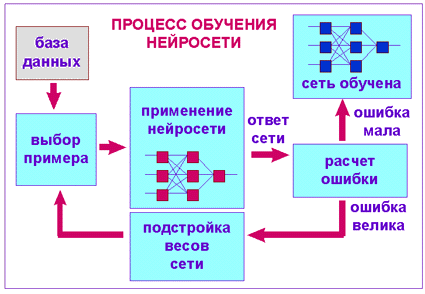

Процесс обучения нейросети

Алгоритм обратного распространения ошибки

Задать произвольно небольшие начальные значения весов связей нейронов

Выбрать очередную обучающую пару из обучающего множества; подать входной вектор на вход сети.

Вычислить выход сети.

Вычислить разность между выходом сети и требуемым выходом.

Подкорректировать веса сети так, чтобы минимизировать ошибку.

Повторять шаги с 1 по 4 для каждого вектора обучающего множества до тех пор, пока ошибка на всем множестве не достигнет приемлемого уровня.

Пример обучения ИНС

Достоинство нейронных сетей

Возможность решения (в сравнении с индуктивным выводом) не только классифицирующих, но и прогнозных задач.

Возможность строить более точные классификации за счет нелинейного характера функциональной зависимости выходных и входных признаков.

Сам процесс решения задач в силу проведения матричных преобразований проводится очень быстро.

Фактически имитируется параллельный процесс прохода по нейронной сети в отличие от последовательного в индуктивных системах.

ИНС могут быть реализованы аппаратно в виде нейрокомпьютеров с ассоциативной памятью.

Недостатки ИНС

Нет способа объяснить полученные с помощью ИНС результаты. Это подрывает доверие пользователя к ИНС.

ИНС представляется как «черный ящик». Нет возможности выяснить какие зависимости зафиксированы в сети, какой они сложности.

Сложно выявлять значимость отдельных входных факторов с помощью ИНС, на основе специальных методов анализа результатов их работы.

ИНС не способна к оценке принципиально новых, не изученных ранее ситуаций.

Нейронные сети

Имитируется работа нейронов в составе иерархической сети, где каждый нейрон более высокого уровня соединен своими входами с выходами нейронов нижележащего слоя.

На нейроны самого нижнего слоя подаются значения входных параметров, на основе которых нужно принимать какие-то решения, прогнозировать развитие ситуации и т. д

Для того чтобы сеть можно было применять в дальнейшем, ее прежде надо "натренировать" на полученных ранее данных, для которых известны и значения входных параметров, и правильные ответы на них.

Тренировка состоит в подборе весов межнейронных связей, обеспечивающих наибольшую близость ответов сети к известным правильным ответам.

Основным недостатком нейросетевой парадигмы является необходимость иметь очень большой объем обучающей выборки.

Другой существенный недостаток заключается в том, что даже натренированная ИНС представляет собой черный ящик. Знания, зафиксированные как веса нескольких сотен межнейронных связей, совершенно не поддаются анализу и интерпретации человеком.