- •Лекция 1. История развития нейронных сетей. Определение инс, свойства инс, достоинства, недостатки. Типовые постановки задач, решаемых инс, и области их применения. Исторический аспект

- •Определение инс, свойства инс, достоинства, недостатки

- •1. Обучение

- •2.Обобщение

- •3. Абстрагирование

- •4.Применимость

- •Типовые постановки задач

- •1. Распознавание образов

- •2. Кластеризация данных

- •2.Медицина:

- •3.Авионика:

- •4.Связь:

- •5.Интернет:

- •6.Автоматизация производства:

- •7.Политические технологии:

- •8.Безопасность и охранные системы:

- •9.Ввод и обработка информации:

- •10.Геологоразведка:

- •Лекция 2.Биологический прототип. Модель искусственного нейрона. Функции активации. Классификация нейронных сетей. Основные парадигмы нейронных сетей. Биологический прототип

- •Искусственный нейрон

- •Активационные функции

- •Однослойные искусственные нейронные сети

- •Многослойные искусственные нейронные сети

- •Классификация нейронных сетей

- •1. Типы обучения нейросети

- •2. Архитектура связей

- •Нейропарадигмы

- •Лекция 3.Персептрон. Персептронная представляемость. Проблема «Исключающее или». Преодоление ограничения линейной разделимости. Обучение персептрона. Дельта-правило. Персептроны

- •Персептронная представляемость

- •Проблема функции исключающее или

- •Линейная разделимость

- •Преодоление ограничения линейной разделимости

- •Обучение персептрона

- •Трудности с алгоритмом обучения персептрона

- •Лекция 4.Сети с обратным распространением ошибки. Основной элемент сети обратного распространения. Алгоритмы обучения и функционирования.

- •Обучение сети обратного распространения.

- •Проход вперед.

- •Обратный проход.

- •Подстройка весов скрытого слоя.

- •Импульс.

- •Экспоненциальное сглаживание.

- •Трудности обучения сети обратного распространения. Паралич сети

- •Локальные минимумы

- •Размер шага

- •Временная неустойчивость

- •Слой Гроссберга.

- •Режим обучения. Обучение слоя Кохонена.

- •Предварительная обработка входных сигналов.

- •Выбор начальных значений весовых векторов.

- •Обучение слоя Гроссберга.

- •Полная структура сети встречного распространения.

- •Лекция 7. Стохастические методы обучения. Больцмановское обучение.

- •Стохастические методы обучения

- •Больцмановское обучение

- •Лекция 8.Обучение Коши. Метод искусственной теплоемкости. Комбинированный метод обратного распространения и обучения Коши. Обучение Коши

- •Метод искусственной теплоемкости

- •Комбинированный метод обратного распространения и обучения Коши

- •Лекция 9. Ассоциативные сети. Сети Хопфилда. Свойства сети Хопфилда. Статистические сети Хопфилда. Сеть Хопфилда

- •Структура сети

- •Устойчивость сети Хопфилда

- •Непрерывные сети Хопфилда

- •Статистические сети Хопфилда

- •Алгоритм обучения

- •Свойства сети Хопфилда

- •Лекция 10. Сеть Хэмминга. Двунаправленная ассоциативная память. Емкость памяти. Сеть Хэмминга

- •Структура сети

- •Алгоритм функционирования

- •Сравнение с сетью Хопфилда

- •Двунаправленная ассоциативная память

- •Функционирование сети

- •Обучение сети

- •Емкость памяти

- •Непрерывная дап

- •Адаптивная дап

- •Лекция 11. Адаптивная резонансная теория. Проблема стабильности-пластичности в инс.

- •Архитектура apt

- •Лекция 12. Функционирование и обучения сети арт. Теоремы арт. Функционирование сетей apt

- •Характеристики (теоремы) сети арт

- •Лекции 13. Проблемы реализации инс. Нейрокомпьютеры. Основные направления реализации нейросетей. Оценка производительности нейрокомпьютеров.

- •Реализация инс аппаратными средствами

- •Особенности аппаратной реализации нейросетей

- •Лекции 14. Аппаратная реализация на примере нейрочипа NeuroMatrix nm6403. Пример аппаратной реализации (нейрочип NeuroMAtrix nm6403 нтц «Модуль») Выбор и обоснование принципов построения нейрочипа

- •Архитектура нейрочипа

- •Aрхитектурныe основы построения нейросистем на базе нейрочипа

- •Лекции 15. Программная реализация нейросетей . Программная реализация нейросетей

- •Основные функциональные возможности программ моделирования нейронных сетей.

- •Формирование (создание) нейронной сети

- •Обучение нейронной сети

- •Тестирование обученной нейронной сети

- •Лекции 16. Программная реализация нейросетей на примере модели процессорного элемента NeuralWorks. Модель процессорного элемента нейропакета NeuralWorks Professional II

- •Этапы функционирования процессорного элемента.

- •Литература

Обучение слоя Гроссберга.

Слой Гроссберга обучается сравнительно просто. Входной вектор, являющийся выходом слоя Кохонена, подается на слой нейронов Гроссберга, и выходы слоя Гроссберга вычисляются, как при нормальном функционировании. Далее, каждый вес корректируется лишь в том случае, если он соединен с нейроном Кохонена, имеющим ненулевой выход. Величина коррекции веса пропорциональна разности между весом и требуемым выходом нейрона Гроссберга, с которым он соединен. В символьной записи это выглядит так:

vijн=vijc + β (yj- vijc)ki,

где ki- выход i-го нейрона слоя Кохонена (только для одного нейрона Кохонена он отличен от нуля); yj - j-я компонента вектора желаемых векторов.

Первоначально β берется равным 0.1 и затем постепенно уменьшается в процессе обучения.

Отсюда видно, что веса слоя Гроссберга будут сходиться к средним величинам от желаемых выходов, тогда как веса Кохонена обучаются на средних значениях входов. Обучение слоя Гроссберга- это обучение с учителем. Обучающийся без учителя самоорганизующийся слой Кохонена дает выходы в недетерминированных позициях. Они отображаются в желаемые выходы слоем Гроссберга.

Полная структура сети встречного распространения.

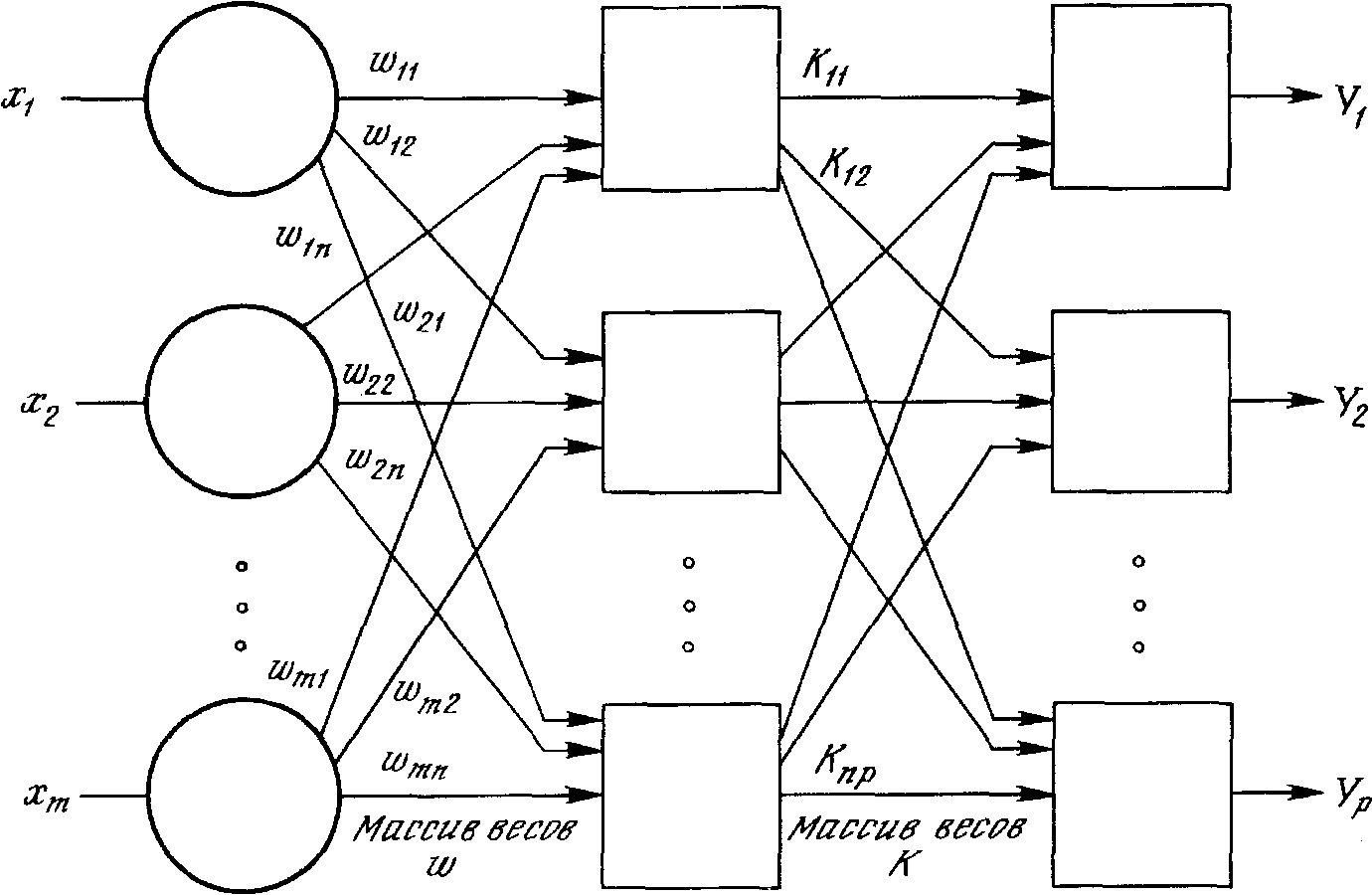

Рис. 19. Полная структура сети встречного распространения.

На рисунке 19 показана сеть встречного распространения целиком.

В режиме функционирования предъявляются входные векторы X и Y , и обученная сеть дает на выходе векторы X’ и Y’, являющиеся аппроксимациями X и Y, соответственно. Векторы X и Y предполагаются здесь нормализованными единичными векторами, следовательно, порождаемые на выходе векторы также будут иметь тенденцию быть нормализованными.

В процессе обучения векторы X и Y подаются одновременно и как входные векторы сети, и как желаемые выходные сигналы. Вектор Х используется для обучения выходов Х’, а вектор Y- для обучения выходов Y’ слоя Гроссберга. Сеть встречного распространения обучается с использованием того же самого метода, что и упрощенная структура сети. Нейроны Кохонена принимают входные сигналы как от векторов Х, так и от векторов Y. Но это неотличимо от ситуации, когда имеется один большой вектор, составленный из векторов X и Y, и не влияет на алгоритм обучения.

В качестве результирующего получается единичное отображение, при котором предъявление пары входных векторов порождает их пары на выходе. Это не представляется особенно интересным, если не заметить, что предъявление только вектора Х (с вектором Y, равным нулю) порождает как выходы Х’, так выходы и Y’. Если F- функция, отображающая Х в Y’, то сеть аппроксимирует ее. Также, если F обратима, то предъявление только вектора Y (приравнивая Х к нулю) порождает X’. Уникальная способность порождать функцию и обратную к ней делает сеть встречного распространения полезной в ряде приложений.

Лекция 7. Стохастические методы обучения. Больцмановское обучение.

Стохастические методы полезны как для обучения искусственных нейронных сетей, так и для получения выхода от уже обученной сети. Стохастические методы обучения приносят большую пользу, позволяя исключать локальные минимумы в процессе обучения. Но с ними также связан ряд проблем.

Стохастические методы обучения

Искусственная нейронная сеть обучается посредством некоторого процесса, модифицирующего ее веса. Если обучение успешно, то предъявление сети множества входных сигналов приводит к появлению желаемого множества выходных сигналов. Имеется два класса обучающих методов: детерминистский и стохастический.

Детерминистский метод обучения шаг за шагом осуществляет процедуру коррекции весов сети, основанную на использовании их текущих значений, а также величин входов, фактических выходов и желаемых выходов. Обучение персептрона является примером подобного детерминистского подхода.

Стохастические методы, обучения выполняют псевдослучайные изменения величин весов, сохраняя те изменения, которые ведут к улучшениям. Чтобы увидеть, как это может быть сделано, рассмотрим рис. 20, на котором изображена типичная сеть, в которой нейроны соединены с помощью весов. Выход нейрона является здесь взвешенной суммой его входов, которая, преобразована с помощью нелинейной функции. Для обучения сети может быть использована следующая процедура:

1. Предъявить множество входов и вычислить получающиеся выходы.

2. Сравнить эти выходы с желаемыми выходами и вычислить величину разности между ними. Общепринятый метод состоит в нахождении разности между фактическим и желаемым выходами для каждого элемента обучаемой пары, возведение разностей в квадрат и нахождение суммы этих квадратов. Целью обучения является минимизация этой разности, часто называемой целевой функцией.

3. Выбрать вес случайным образом и подкорректировать его на небольшое случайное значение. Если коррекция помогает (уменьшает целевую функцию), то сохранить ее, в противном случае вернуться к первоначальному значению веса.

4. Повторять шаги с 1 до 3 до тех пор, пока сеть не будет обучена в достаточной степени.

Рис. 20. Двухслойная сеть без обратных связей.

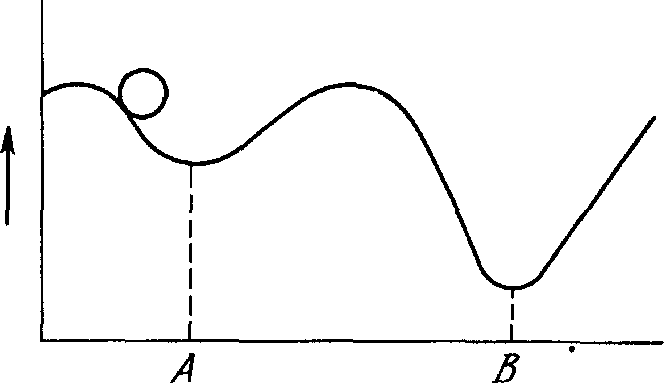

Этот процесс стремится минимизировать целевую функцию, но может попасть, как в ловушку, в неудачное решение. На рис. 21 показано, как это может иметь место в системе с единственным весом. Допустим, что первоначально вес взят, равным значению в точке А. Если случайные шаги по весу малы, то любые отклонения от точки А увеличивают целевую функцию и будут отвергнуты. Лучшее значение веса, принимаемое в точке В, никогда не будет найдено, и система будет поймана в ловушку локальным минимумом, вместо глобального минимума в точке В. Если же случайные коррекции веса очень велики, то как точка А, так и точка В будут часто посещаться, но то же самое будет иметь место и для каждой другой точки. Вес будет меняться так резко, что он никогда не установится в желаемом минимуме.

Целевая функция

Рис.21. Проблема локальных минимумов.

Полезная стратегия для избежания подобных проблем состоит в больших начальных шагах и постепенном уменьшении размера среднего случайного шага. Это позволяет сети вырываться из локальных минимумов и в то же время гарантирует окончательную стабилизацию сети.

Ловушки локальных минимумов досаждают всем алгоритмам обучения, основанным на поиске минимума, включая персептрон и сети обратного распространения, и представляют серьезную и широко распространенную трудность, которой часто не замечают. Стохастические методы позволяют решить эту проблему. Стратегия коррекции весов, вынуждающая веса принимать значение глобального оптимума в точке В, возможна.

Искусственные нейронные сети могут обучаться посредством случайной коррекции весов. Вначале делаются большие случайные коррекции с сохранением только тех изменений весов, которые уменьшают целевую функцию. Затем средний размер шага постепенно уменьшается, и глобальный минимум в конце концов достигается.

Это сильно напоминает отжиг металла, поэтому для ее описания часто используют термин «имитация отжига». В металле, нагретом до температуры, превышающей его точку плавления, атомы находятся в сильном беспорядочном движении. Как и во всех физических системах, атомы стремятся к состоянию минимума энергии (единому кристаллу в данном случае), но при высоких температурах энергия атомных движений препятствует этому. В процессе постепенного охлаждения металла возникают все более низкоэнергетические состояния, пока в конце концов не будет достигнуто низшее из возможных состояний, глобальный минимум. В процессе отжига распределение энергетических уровней описывается следующим соотношением:

Р(е)= ехр(- e/kT),

где Р(е) - вероятность того, что система находится в состоянии с энергией е; k - постоянная Больцмана; Т-температура по шкале Кельвина.

При высоких температурах Р(е) приближается к единице для всех энергетических состояний. Таким образом, высокоэнергетическое состояние почти столь же вероятно, как и низкоэнергетическое. По мере уменьшения температуры вероятность высокоэнергетических состояний уменьшается по сравнению с низкоэнергетическими. При приближении температуры к нулю становится весьма маловероятным, чтобы система находилась в высокоэнергетическом состоянии.