- •Лекция 1. История развития нейронных сетей. Определение инс, свойства инс, достоинства, недостатки. Типовые постановки задач, решаемых инс, и области их применения. Исторический аспект

- •Определение инс, свойства инс, достоинства, недостатки

- •1. Обучение

- •2.Обобщение

- •3. Абстрагирование

- •4.Применимость

- •Типовые постановки задач

- •1. Распознавание образов

- •2. Кластеризация данных

- •2.Медицина:

- •3.Авионика:

- •4.Связь:

- •5.Интернет:

- •6.Автоматизация производства:

- •7.Политические технологии:

- •8.Безопасность и охранные системы:

- •9.Ввод и обработка информации:

- •10.Геологоразведка:

- •Лекция 2.Биологический прототип. Модель искусственного нейрона. Функции активации. Классификация нейронных сетей. Основные парадигмы нейронных сетей. Биологический прототип

- •Искусственный нейрон

- •Активационные функции

- •Однослойные искусственные нейронные сети

- •Многослойные искусственные нейронные сети

- •Классификация нейронных сетей

- •1. Типы обучения нейросети

- •2. Архитектура связей

- •Нейропарадигмы

- •Лекция 3.Персептрон. Персептронная представляемость. Проблема «Исключающее или». Преодоление ограничения линейной разделимости. Обучение персептрона. Дельта-правило. Персептроны

- •Персептронная представляемость

- •Проблема функции исключающее или

- •Линейная разделимость

- •Преодоление ограничения линейной разделимости

- •Обучение персептрона

- •Трудности с алгоритмом обучения персептрона

- •Лекция 4.Сети с обратным распространением ошибки. Основной элемент сети обратного распространения. Алгоритмы обучения и функционирования.

- •Обучение сети обратного распространения.

- •Проход вперед.

- •Обратный проход.

- •Подстройка весов скрытого слоя.

- •Импульс.

- •Экспоненциальное сглаживание.

- •Трудности обучения сети обратного распространения. Паралич сети

- •Локальные минимумы

- •Размер шага

- •Временная неустойчивость

- •Слой Гроссберга.

- •Режим обучения. Обучение слоя Кохонена.

- •Предварительная обработка входных сигналов.

- •Выбор начальных значений весовых векторов.

- •Обучение слоя Гроссберга.

- •Полная структура сети встречного распространения.

- •Лекция 7. Стохастические методы обучения. Больцмановское обучение.

- •Стохастические методы обучения

- •Больцмановское обучение

- •Лекция 8.Обучение Коши. Метод искусственной теплоемкости. Комбинированный метод обратного распространения и обучения Коши. Обучение Коши

- •Метод искусственной теплоемкости

- •Комбинированный метод обратного распространения и обучения Коши

- •Лекция 9. Ассоциативные сети. Сети Хопфилда. Свойства сети Хопфилда. Статистические сети Хопфилда. Сеть Хопфилда

- •Структура сети

- •Устойчивость сети Хопфилда

- •Непрерывные сети Хопфилда

- •Статистические сети Хопфилда

- •Алгоритм обучения

- •Свойства сети Хопфилда

- •Лекция 10. Сеть Хэмминга. Двунаправленная ассоциативная память. Емкость памяти. Сеть Хэмминга

- •Структура сети

- •Алгоритм функционирования

- •Сравнение с сетью Хопфилда

- •Двунаправленная ассоциативная память

- •Функционирование сети

- •Обучение сети

- •Емкость памяти

- •Непрерывная дап

- •Адаптивная дап

- •Лекция 11. Адаптивная резонансная теория. Проблема стабильности-пластичности в инс.

- •Архитектура apt

- •Лекция 12. Функционирование и обучения сети арт. Теоремы арт. Функционирование сетей apt

- •Характеристики (теоремы) сети арт

- •Лекции 13. Проблемы реализации инс. Нейрокомпьютеры. Основные направления реализации нейросетей. Оценка производительности нейрокомпьютеров.

- •Реализация инс аппаратными средствами

- •Особенности аппаратной реализации нейросетей

- •Лекции 14. Аппаратная реализация на примере нейрочипа NeuroMatrix nm6403. Пример аппаратной реализации (нейрочип NeuroMAtrix nm6403 нтц «Модуль») Выбор и обоснование принципов построения нейрочипа

- •Архитектура нейрочипа

- •Aрхитектурныe основы построения нейросистем на базе нейрочипа

- •Лекции 15. Программная реализация нейросетей . Программная реализация нейросетей

- •Основные функциональные возможности программ моделирования нейронных сетей.

- •Формирование (создание) нейронной сети

- •Обучение нейронной сети

- •Тестирование обученной нейронной сети

- •Лекции 16. Программная реализация нейросетей на примере модели процессорного элемента NeuralWorks. Модель процессорного элемента нейропакета NeuralWorks Professional II

- •Этапы функционирования процессорного элемента.

- •Литература

Режим обучения. Обучение слоя Кохонена.

Слой Кохонена классифицирует входные векторы в группы схожих. Это достигается с помощью такой подстройки весов Кохонена, что близкие входные векторы активируют один и тот же нейрон данного слоя. Затем задачей слоя Гроссберга является получение требуемых выходов.

Обучение Кохонена является самообучением, протекающим без учителя. Поэтому трудно (и не нужно) предсказывать, какой именно нейрон Кохонена будет активизироваться для данного входного вектора. Необходимо лишь гарантировать, чтобы в результате обучения разделялись несхожие входные векторы.

Предварительная обработка входных сигналов.

Весьма желательно (хотя и не обязательно) нормализовать входные векторы перед тем, как предъявлять их сети. Это выполняется с помощью деления каждой компоненты входного вектора на длину вектора. В алгебраической записи

хi’=xi/√(x12+x22+...+xn2)

Это превращает входной вектор в единичный вектор того же направления в n- мерном пространстве.

При обучении слоя Кохонена на вход подается входной вектор, и вычисляются его скалярные произведения с векторами весов, связанными со всеми нейронами Кохонена. Вес нейрона с максимальным скалярным произведением выставляется в единицу. Так как скалярное произведение, используемое для вычисления величин NET, является мерой сходства между входным вектором и вектором весов, то процесс обучения состоит в выборе нейрона Кохонена с весовым вектором, наиболее близким к входному вектору, и дальнейшем приближении весового вектора к входному. Сеть самоорганизуется таким образом, что данный нейрон Кохонена имеет максимальный выход для данного входного вектора. Уравнение, описывающее процесс обучения имеет следующий вид:

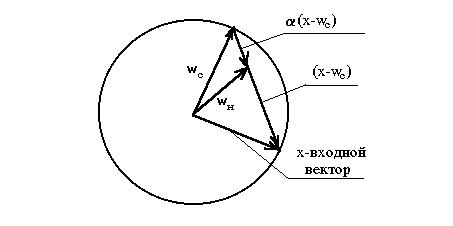

wн=wc+α (х-wс)

где wн- новое значение веса, соединяющего входную компоненту х с выигравшим нейроном; wc- предыдущее значение этого веса; α - коэффициент скорости обучения, который может изменяться в процессе обучения. Каждый вес, связанный с выигравшим нейроном Кохонена, изменяется пропорционально разности между его величиной и величиной входа, к которому он присоединен, направление изменения минимизирует разность между весом и его выходом. На рисунке 18 этот процесс показан геометрически.

Рис.18. Геометрическая интерпретация процесса обучения слоя Кохонена.

Переменная α является коэффициентом скорости обучения, который в начале равен 0.7, и может постепенно уменьшаться в процессе обучения. Это позволяет делать большие начальные шаги для быстрого грубого обучения и меньшие шаги при подходе к окончательной величине.

Выбор начальных значений весовых векторов.

Всем весам сети перед началом обучения следует придать начальные значения. Общепринятой практикой является присваивание весам небольших случайных значений. Однако рандомизация весов может породить некоторые проблемы при обучении. Наиболее желательное решение – распределение весовых векторов в соответствии с плотностью входных векторов.

Один из таких методов задания начальных значений носит название метода выпуклой комбинации. Он состоит в том, что все веса приравниваются одной и той же величине 1/(n)1/2 , где n- число входов и, следовательно, число компонент каждого вектора. Благодаря этому все весовые векторы совпадают и имеют единичную длину. Каждой же компоненте входа Х придается значение α xi+{[1/(n)1/2](1- α)}, где n- число входов. Вначале α очень мало, вследствие чего все входные векторы имеют длину, близкую к 1/(n)1/2, и почти совпадают с векторами весов. В процессе обучения сети α постепенно возрастает, приближаясь к единице. Это позволяет разделять входные векторы и окончательно приписывать им истинные значения. Весовые векторы отслеживают один или небольшую группу входных векторов и в конце обучения дают требуемую картину выходов. Метод выпуклой комбинации хорошо работает, но замедляет процесс обучения, так как весовые векторы подстраиваются к изменяющейся цели.

Третий метод начинает со случайных весов, но на начальной стадии обучающего процесса подстраивает все веса, а не только связанные с выигравшим нейроном Кохонена. Тем самым весовые векторы перемещаются ближе к области входных векторов. В процессе обучения коррекция весов начинает производиться лишь для ближайших к победителю нейронов Кохонена. Этот радиус коррекции постепенно уменьшается, так что в конце концов корректируются только веса, связанные только с выигравшим нейроном Кохонена.

Еще один метод наделяет каждый нейрон Кохонена “чувством справедливости”. Если он становится победителем чаще своей законной доли времени (примерно 1/k, где k- число нейронов Кохонена), он временно увеличивает свой порог, что уменьшает его шансы на выигрыш, давая тем самым возможность обучиться другим нейронам.