- •Лекция 1. История развития нейронных сетей. Определение инс, свойства инс, достоинства, недостатки. Типовые постановки задач, решаемых инс, и области их применения. Исторический аспект

- •Определение инс, свойства инс, достоинства, недостатки

- •1. Обучение

- •2.Обобщение

- •3. Абстрагирование

- •4.Применимость

- •Типовые постановки задач

- •1. Распознавание образов

- •2. Кластеризация данных

- •2.Медицина:

- •3.Авионика:

- •4.Связь:

- •5.Интернет:

- •6.Автоматизация производства:

- •7.Политические технологии:

- •8.Безопасность и охранные системы:

- •9.Ввод и обработка информации:

- •10.Геологоразведка:

- •Лекция 2.Биологический прототип. Модель искусственного нейрона. Функции активации. Классификация нейронных сетей. Основные парадигмы нейронных сетей. Биологический прототип

- •Искусственный нейрон

- •Активационные функции

- •Однослойные искусственные нейронные сети

- •Многослойные искусственные нейронные сети

- •Классификация нейронных сетей

- •1. Типы обучения нейросети

- •2. Архитектура связей

- •Нейропарадигмы

- •Лекция 3.Персептрон. Персептронная представляемость. Проблема «Исключающее или». Преодоление ограничения линейной разделимости. Обучение персептрона. Дельта-правило. Персептроны

- •Персептронная представляемость

- •Проблема функции исключающее или

- •Линейная разделимость

- •Преодоление ограничения линейной разделимости

- •Обучение персептрона

- •Трудности с алгоритмом обучения персептрона

- •Лекция 4.Сети с обратным распространением ошибки. Основной элемент сети обратного распространения. Алгоритмы обучения и функционирования.

- •Обучение сети обратного распространения.

- •Проход вперед.

- •Обратный проход.

- •Подстройка весов скрытого слоя.

- •Импульс.

- •Экспоненциальное сглаживание.

- •Трудности обучения сети обратного распространения. Паралич сети

- •Локальные минимумы

- •Размер шага

- •Временная неустойчивость

- •Слой Гроссберга.

- •Режим обучения. Обучение слоя Кохонена.

- •Предварительная обработка входных сигналов.

- •Выбор начальных значений весовых векторов.

- •Обучение слоя Гроссберга.

- •Полная структура сети встречного распространения.

- •Лекция 7. Стохастические методы обучения. Больцмановское обучение.

- •Стохастические методы обучения

- •Больцмановское обучение

- •Лекция 8.Обучение Коши. Метод искусственной теплоемкости. Комбинированный метод обратного распространения и обучения Коши. Обучение Коши

- •Метод искусственной теплоемкости

- •Комбинированный метод обратного распространения и обучения Коши

- •Лекция 9. Ассоциативные сети. Сети Хопфилда. Свойства сети Хопфилда. Статистические сети Хопфилда. Сеть Хопфилда

- •Структура сети

- •Устойчивость сети Хопфилда

- •Непрерывные сети Хопфилда

- •Статистические сети Хопфилда

- •Алгоритм обучения

- •Свойства сети Хопфилда

- •Лекция 10. Сеть Хэмминга. Двунаправленная ассоциативная память. Емкость памяти. Сеть Хэмминга

- •Структура сети

- •Алгоритм функционирования

- •Сравнение с сетью Хопфилда

- •Двунаправленная ассоциативная память

- •Функционирование сети

- •Обучение сети

- •Емкость памяти

- •Непрерывная дап

- •Адаптивная дап

- •Лекция 11. Адаптивная резонансная теория. Проблема стабильности-пластичности в инс.

- •Архитектура apt

- •Лекция 12. Функционирование и обучения сети арт. Теоремы арт. Функционирование сетей apt

- •Характеристики (теоремы) сети арт

- •Лекции 13. Проблемы реализации инс. Нейрокомпьютеры. Основные направления реализации нейросетей. Оценка производительности нейрокомпьютеров.

- •Реализация инс аппаратными средствами

- •Особенности аппаратной реализации нейросетей

- •Лекции 14. Аппаратная реализация на примере нейрочипа NeuroMatrix nm6403. Пример аппаратной реализации (нейрочип NeuroMAtrix nm6403 нтц «Модуль») Выбор и обоснование принципов построения нейрочипа

- •Архитектура нейрочипа

- •Aрхитектурныe основы построения нейросистем на базе нейрочипа

- •Лекции 15. Программная реализация нейросетей . Программная реализация нейросетей

- •Основные функциональные возможности программ моделирования нейронных сетей.

- •Формирование (создание) нейронной сети

- •Обучение нейронной сети

- •Тестирование обученной нейронной сети

- •Лекции 16. Программная реализация нейросетей на примере модели процессорного элемента NeuralWorks. Модель процессорного элемента нейропакета NeuralWorks Professional II

- •Этапы функционирования процессорного элемента.

- •Литература

Проход вперед.

Шаги 1 и 2 могут быть выражены в векторной форме следующим образом: подается входной вектор Х и на выходе получается вектор Y. Векторная пара вход-цель, Х и Т, берется из обучающего множества. Вычисления проводятся над вектором Х, чтобы получить выходной вектор Y.

Вычисления в многослойных сетях выполняются слой за слоем, начиная с ближнего к входу слоя. Величина NET каждого нейрона первого слоя вычисляется как взвешенная сумма входов нейрона. Затем активационная функция F “сжимает” NET и дает OUT для каждого нейрона в этом слое. Когда множество выходов слоя получено, оно является входным множеством для следующего слоя. Процесс повторяется слой за слоем, пока не будет получено заключительное множество выходов сети.

Этот процесс может быть выражен в векторной форме. Рассмотрим веса между нейронами как матрицу W. Например, вес от нейрона 8 в слое 2 к нейрону 5 в слое 3 обозначается как w8,5. Тогда NET- вектор слоя N может быть выражен как произведение X и W. В векторном обозначении: N=X*W. Покомпонентным применением функции F к NET- вектору получается выходной вектор О.

Таким образом, для данного слоя вычислительный процесс описывается следующим выражением:

O=F(X*W) (12)

Выходной вектор одного слоя является входным вектором для следующего, поэтому это выражение применяется несколько раз вплоть до вычисления выходного сигнала.

Обратный проход.

Так как для каждого нейрона выходного слоя задано целевое значение, то подстройка весов легко осуществляется с использованием модифицированного дельта-правила (δ-разность между целевым и реальным выходом). Внутренние слои назовем “скрытыми слоями”. Для их выходов не имеется целевых значений для сравнения. Поэтому обучение усложняется.

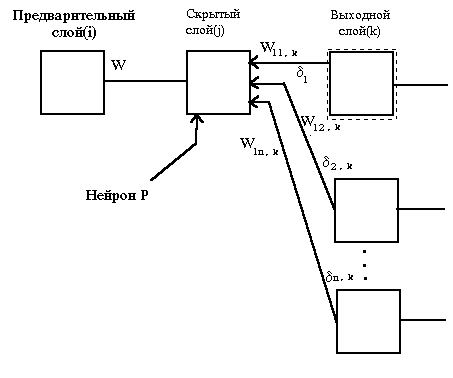

На рис. 15 показан процесс обучения для одного веса от нейрона р в скрытом слое j к нейрону q в выходном слое k.

Рис.15. Настройка веса в выходном слое.

Выход нейрона слоя k , вычитаясь из целевого значения (T), дает сигнал ошибки. Он умножается на производную сжимающей функции [OUT*(1-OUT)], вычисленную для этого нейрона слоя k, давая, таким образом, величину δqk.

δqk = OUT*(1-OUT)*(T-OUT). (13)

Затем δqk умножается на величину OUT нейрона j, из которого выходит рассматриваемый вес. Это произведение, в свою очередь, умножается на коэффициент скорости обучения η (обычно от 0.01 до 1), и результат прибавляется к весу. Такая же процедура выполняется для веса от нейрона скрытого слоя к нейрону в выходном слое.

Следующие уравнения иллюстрируют это вычисление:

Δwpq,k= η δqk OUTp,j, (14)

wpq,k(n+1)= wpq,k(n)+ Δwpq,k , (15)

где wpq,k(n) - величина веса от нейрона р в скрытом слое к нейрону q в выходном слое на шаге (до коррекции);

wpq,k(n+1) - величина веса на шаге n+1 (после коррекции);

Δwpq,- величина Δw для q в выходном слое k;

OUTp,j - величина OUT для нейрона p в скрытом слое j.

Подстройка весов скрытого слоя.

Рассмотрим один нейрон в скрытом слое, предшествующем выходному слою. При проходе вперед этот нейрон передает входной сигнал нейронам в выходном слое через соединяющие их веса. Во время обучения эти веса функционируют в обратном порядке, пропуская величину ошибки от выходного слоя назад к скрытому слою. Каждый из этих весов умножается на величину δqk нейрона, к которому он присоединен в выходном слое. Величина δpj, необходимая для нейрона скрытого слоя, получается суммированием всех таких произведений и умножением на производную сжимающей функции (см. рис. 16):

δ p,j=OUTp,j(1- OUTp,j)[ ∑ δ q,k wpq,k] (13)

Когда значение δ p,j получено, веса, питающие первый скрытый уровень, могут быть подкорректированы с помощью уравнений подстройки весов выходного слоя, где индексы модифицированы в соответствии со слоем.

Рис. 16. Настройка веса в скрытом слое.

Лекция 5. Разновидности сетей обратного распространения. Трудности обучения сетей обратного распространения. Сеть встречного распространения. Упрощенная структура сети встречного распространения.

Разновидности сети обратного распространения.

Добавление нейронного смещения.

Во многих случаях желательно наделять каждый нейрон обучаемым смещением. Это позволяет сдвигать начало отсчета логической функции, давая эффект, аналогичный подстройке порога персептронного нейрона, и приводит к ускорению процесса обучения. Эта возможность может быть легко введена в обучающий алгоритм с помощью добавляемого к каждому нейрону веса, присоединенного к +1. Этот вес обучается так же, как и все остальные веса, за исключением того, что подаваемый на него сигнал равен +1, а не выходу нейрона предыдущего слоя.