- •Исследование систем управления

- •Санкт-Петербург

- •Предисловие Цели и задачи дисциплины

- •1.Учебной программы дисциплины

- •1. Учебная программа дисциплины

- •Раздел 2. Системный анализ в ису.

- •Раздел 3 Методы принятия решений

- •Раздел 4. . Моделирование - инструмент исследования ису.

- •2. Содержание разделов программы

- •2.1 Введение

- •2.1.2 Системные концепции и развитие системного подхода

- •2.2 Научные исследования и их роль в деятельности человека

- •2.2.1 Иерархия системности и схема процесса ису

- •2.2.2 Сферы взаимодействия среды

- •2.2.3 Классификация систем

- •2.2.4 Свойства систем и принципы системного подхода

- •Принцип целеобусловленности

- •3. Принцип управляемости

- •6. Принцип симбиозности

- •2.3 Системный анализ в ису.

- •2.3.1 Сущность процесса управления

- •2.3.3 Информационные аспекты в процессах

- •Раздел 2.4 методы принятия решений

- •2.4.1 Прогнозирование и методы оценки поведения

- •2.4.2 Методы принятия решения

- •1. Критерий ожидаемого значения (коз).

- •Критерий "ожидаемого значения - дисперсия".

- •Критерий предельного уровня.

- •Критерий наиболее вероятного исхода.

- •2.4.3 Интеллектуальные экспертные системы

- •2.5 Моделирование - инструмент исследования систем управления

- •2.5.1 Аналитические модели описания ису

- •2.5.2 Имитационное моделирование

- •3. Темы курсовых или контрольных работ

- •4. Вопросы к зачету или экзамену

- •5. Рекомендуемая литература

- •Содержание

- •1. Учебная программа дисциплины……………………………………………...4

- •2. Содержание разделов программы……………………………………………5

- •3. Темы контрольных заданий…………………………………………………..80

- •4. Вопросы для экзамена или зачета…………………………………………81

- •5. Рекомендуемая литература…………………………………………………….82

2.3.3 Информационные аспекты в процессах

А. Информация.

Прежде чем говорить об использовании информационных технологий, необходимо уяснить ряд особенностей, связанных с понятием информация. Массовое внедрение в различные сферы жизни общества ЭВМ привели к двум принципиальным изменениям в трактовке информации:

1. Включен обмен информацией между человеком и автоматом (ЭВМ), автоматом и автоматом, обмен сигналами в животном и растительном мире. Так, вся генетика теперь построена на информационных признаках.

2. Предложена количественная мера информации, что привело к созданию информационной теории (работы К. Шеннона, Дж. Хартли, А.И. Берга, А.Н. Колмогорова). Правда, сам К. Шеннон в своих статьях предостерегал от повального увлечения информационными оценками, особенно в экономике, социологии, биологии и других областях, далёких от технических приложений.

С другой стороны, И.И. Юзвишин в своей монографии " Информациология... " вводит основные законы информациологии и утверждает их примат над другими философскими категориями , в том числе и над материей. Приведя полярные точки зрения, автор полагает, что истина находится внутри очерченного промежутка, перекинув мостик между философским представлением и естественнонаучным исследованием природы.

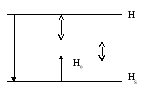

При информационном анализе необходимо оценить как информационную структуру, так и её функции, т.е. установить взаимосвязь объектов и процессов (рис.9 )

Рис.9 Взаимосвязь процессов и объектов

Взаимосвязь движения (потоков информации) с материей (структурами) приводит к понятию «отражения», т.е. к свойству материи запечатлевать и сохранять в своей структуре следы воздействия другой системы. Отражение - одно из свойств материи (пространство, время, движение), причём оно развивается вместе с развитием материи. По А. Урсулу, информация - отраженное разнообразие реального мира и чем разнообразнее система, тем более адекватно отображает она мир. Составляющие информации представлены на рис 10

Рис. 10 Составляющие информации

Физическая (геогенез) - отражается в движении материи (механическом, физическом, химическом и т.д.). Биологическая распадается на биогенез: генетика и физиология; и психогенез: психология и мышление человека. Социальная (ноогенез), чаще представляемая в форме научного прогнозирования, также делится на две группы:

- массовую информацию, обеспечивающую функции общения (масс-медиа, бытовая, религиозная),

- специальную информацию, обеспечивающую функции созидания (научную, технологическую, экономическую и т.д.) и переходящую в новые структуры, предназначенные для повышения эффективности информационных технологий (базы и банки знаний, искусственный интеллект).

На практике при проектировании и исследовании систем приходится сталкиваться с интегральным потоком информации, в котором присутствуют все указанные составляющие, которые реализуются в виде материальных носителей информации во времени и пространстве — сигналов:

-

сигналы воздействия среды;

-

сигналы, реализующие априорную информацию (овеществленные знания в виде результатов НИОКР, ППП; патенты; человеческий опыт и т.д. );

-

сигналы управления (команды ЭВМ, директивы ЛПР и т.д.).

Оперативная информация (рис.9) делится на:

- атрибутивную - тип сигнала, время поступления, вид контроля;

- адресную - места поступления и назначения;

- количественную - значения параметров, факторов;

-управленческую - известительную и распорядительную. Основные характеристики оперативной информации сведены в Таблице 4

Понятно, что в качестве сигнала выступает не сам объект, а его состояние, так на дискете можно записывать разнообразные файлы, не меняя основной функции хранения информации. Далеко не всякое состояние имеет сигнальные свойства, так как сигнал может быть забит помехами или шумами, а кроме того, может произойти рассогласование кодов взаимодействующих объектов []. Сигналы могут быть статические : книга, фотография, триангуляционная вышка и т.д.; динамические, зависящие от состояния силовых полей: свет, звук, радиосигнал и т. п. Поскольку сигнал - состояние физического объекта, то математической моделью этого состояния будет являться случайный процесс, дающий вероятностное представление о поведении сигнала во времени

Таблица 4

|

№ |

Название |

Формально-технические |

Социально-психологические |

|

1 |

Достоверность |

Безошибочность – отсутствие скрытых ошибок |

Истинность – не внесение ошибок человеком |

|

2 |

Своевременность |

Оперативность Время переработки информации = динамике процесса |

Срочность – Время представления данных ЛПР |

|

3 |

Старение |

Рассогласованность показателей во времени |

Моральное устаревание |

|

4 |

Безопасность |

Защищенность – невозможность изменения данных |

Конфиденциальность – несанкционированное использование |

Примечание: К особым характеристикам информации также следует отнести тиражирование и субстациональность - способность существовать в виде некоторой информационной системы.

Помехи сигналу в теории связи чаще всего представляются в виде стационарного нормального случайного процесса с нулевым математическим ожиданием.[] Превращение информации в ресурс всё более остро ставит вопрос её накопления, хранения и переработки. Современный производственный процесс порождает огромное количество информации на самых разных носителях: на бумажных (записи в рабочих журналах, бланки, рекламации и т.д. ) и машинных. Возникает двойственная картина: с одной стороны, информации много, а с другой, - её не хватает для принятия решения. Можно утверждать, что накопление пассивной не структурированной информации является одним из новых видов загрязнения среды. Стремление упорядочить потоки оперативной информации, свернуть её, обеспечить достоверность и своевременность привело к методам организации информационных массивов таким образом, чтобы они послужили основой безбумажного обмена в рамках используемой информационной технологии. Развитие средств вычислительной техники привело к возможности хранить и перерабатывать информацию в символьной форме. Представление априорной информации и результатов исследовательской и проектной деятельности в формализованном виде, пригодном для накопления, обработки и передачи средствами вычислительной техники назовем данными. В эрготехнической (человеко - машинной ) системе данные за счёт интеллектуальных возможностей человека приводят к получению новой информации, представляющей из себя знания. Любая эрготехническая система принятия решений в настоящее время включает в себя развитые базы данных - БД и банки знаний БЗ, корректируемых по мере получения новых данных или знаний.

Б. Количественная оценка характеристик информации.

Задача оценки информационных свойств системы и её структурных компонент является одной из самых сложных при исследовании систем из-за необходимости учёта как качественных, так и количественных характеристик информации. Причём, в большинстве случаев приходится решать задачу извлечения полезной для целей исследования информации из общего объёма имеющейся в наличии. Процесс извлечения и уяснения информации связан с процессом поиска и сравнения образа с эталонным образом или аналогом, хранящимся в памяти системы. Под образом (ситуацией) будем понимать отражение системы в одной из сфер среды, её окружающей. Тогда проблема, решаемая системой проецируется последовательно в разные сферы с целью выяснения, какие образы там возникают и насколько они важны для решения проблемы в целом В свете сказанного, информация, получаемая системой есть то, что извлекается из образа в процессе его восприятия системой [ ], тогда:

X

![]() Y

Y![]() S

S

Обозначим Y = f(X)

Где некоторый объект, отображающийся в систему S в виде образа Y.

Извлекая информацию из образа Y, система S делает обратное внутреннее отображение, создавая информационную копию Z объекта X, т.е.

Z = U ( Y )

При такой трактовке информация может существовать на физическом и идеальном уровнях. Так, принятая системой информация может быть на физическом уровне не понята и не извлечена системой, процесс уяснения информации (антиредукция) переводит её в сферу идеального, где она используется непосредственно для решения задач. Естественно, что существует и прямой путь получения информации непосредственно из сферы идеального с последующей редукцией в случае необходимости на физический уровень. В процессе получения информации имеет место неопределённость, и при принятии решения выводы делаются в интервале неопределённость - риск - определённость, при постепенном снятии неопределённости. Под уровнем неопределенности будем понимать показатель, характеризующий оставшуюся неопределённость. После того как вся существующая информация будет принята во внимание. Таким образом, уровень неопределённости выражается вероятностью, приписываемой исходам события, и имеет место тогда, когда нужно произвести выбор из совокупности возможных исходов. Формально уровень неопределённости с n дискретными исходами оцениваемых вероятностью рk определится как:

Hs

= -![]() (3)

(3)

Для простого события, которое оценивается двумя несовместимыми событиями р, q = 1- р в случае равенства исходов p = q = l/2, Hs приобретает максимальное значение (рис.11). Когда исход определён, Hs = 0.

Таким образом, уровень неопределённости можно связать с информацией о событии, которая где-либо имеется. Связывая неопределённость с информацией можно утверждать, что в случае двоичного кода максимальная неопределённость равна одной двоичной единице информации или одному биту. К. Шенноном введено понятие энтропии, оцениваемой математическим ожиданием случайной величины информации, содержащейся в сигнале.

Рис. 11 Зависимость неопределённости в случае двух исходов

Такая информация носит название собственной. Введённое понятие энтропии как меры неопределённости не путать с понятием энтропии в других областях знания:

-в термодинамике это мера необратимого рассеяния и энтропия равна нулю при нуле по Кельвину,

- в статистической физике это мера вероятности осуществления состояния.

Далее в тексте будем придерживаться энтропийных оценок по Шеннону. Иллюстрация снятия неопределённости дана на рис. 12

Рис. 12 Уровни неопределённости

Для остающейся неопределённости всегда справедливо неравенство Hs < Н где Н - начальная неопределённость, а H0 -конечная после проведения оценки Н - Hs характеризует максимальный объём информации, который может быть получен,

Н – Н0 объём новых знаний или информация о сигнале

Н0 – Hs объём недостающих знаний.

Ошибки могут быть вызваны рядом причин, среди которых можно назвать несовершенство источника информации , её двусмысленность, погрешности приёмника сигнала и алгоритма обработки и т.д. Необходимо также отметить, что в ряде случаев поступление дополнительной информации может не снизить, а повысить неопределённость. Теперь перейдём к определению количественных мер информации. Возможны три подхода к определению количества информации: комбинаторный, вероятностный и алгоритмический. В основе большинства используемых количественных мер лежит принцип разнообразия, в соответствии с которым считается, что количество информации об объекте Х тем больше, чем выше разнообразие его характеристик и чем полнее и точнее определяются характеристики системой S. [18] Вероятностная мера Шеннона определяется выражением

I = H(X) – H0(X)

где Н(Х) исходная, априорная неопределённость характеристики объекта, Н0(Х)- апостериорная неопределённость этой характеристики. В случае дискретной характеристики объекта

![]() (4)

(4)

где Pk, Pk0 - соответственно вероятности k-го значения характеристики объекта до приёма и преобразования образа объекта.

Комбинаторная мера Хартли определяется выражениями

![]() или

или

![]()

где mk - число возможных состояний по k-му значению характеристики образа. Обе эти меры тесным образом связаны между собой. Алгоритмическая мера информации связана с представлением о минимальной длине программы, с помощью которой осуществляется извлечение информации из сигнала. Характеристики информация при её практическом использовании можно разделить на три основные группы:

1. По отношению к получателю, характеризующаяся значимостью и интенсивностью

2. По отношению к источнику, характеризующаяся существенностью для функционирования системы .

3 . По отношению к самой себе (внутреннее качество информации), характеризующаяся достоверностью и количеством.

Значимость характеризует степень достижения целей системой получателем и оценивается из выражения:

U

= -![]() (5)

(5)

где

U

(x)

мера значимости

некоторого состояния х

![]() X. Интенсивность

поступления информации определяет

нагрузочную характеристику системы и

ценность информации (при

редких сообщениях ценность может

снизиться

). В процессе

оперативного управления при

умеренной интенсивности потока информации

(0,2 - 5 бит/сек

) человек обычно

определяет как более важную ту информацию,

которая поступает чаще, за исключением

единичных,

но обладающих высшим приоритетом

сообщений.

X. Интенсивность

поступления информации определяет

нагрузочную характеристику системы и

ценность информации (при

редких сообщениях ценность может

снизиться

). В процессе

оперативного управления при

умеренной интенсивности потока информации

(0,2 - 5 бит/сек

) человек обычно

определяет как более важную ту информацию,

которая поступает чаще, за исключением

единичных,

но обладающих высшим приоритетом

сообщений.

Достоверность

информации,

получаемой системой S,

зависит, прежде всего, от соответствия

состояния приёмника

(образа источника

в нём)

y

![]() Y

состоянию

источника х

Y

состоянию

источника х![]() Х и от правильности

формирования идеального прообраза z

Х и от правильности

формирования идеального прообраза z![]() Z,

тогда

Z,

тогда

I

(x,y)=

![]()

Отметим, что количественная оценка достоверности теперь выражена через условные вероятности того, что наблюдаемый образ y соответствует оригиналу х с учётом I ( х, у).

Прежде чем определить понятие максимума полезной информации рассмотрим возможные варианты между поступаемым на объект сигналом и состоянием самого объекта:

- в случае получения достоверного и своевременного сигнала объектом, находящимся в состоянии отказа, объект не может произвести никаких полезных действий;

- точно такая же ситуация возникнет в случае получения исправным объектом зашумленного и искажённого сигнала;

- очевидно, что в рассмотрении должны участвовать работоспособный объект и сигнал, из которого можно выделить полезную составляющую.

Информационные обмены предусматривают достаточный уровень согласованности между сигналами управления, целями и ресурсами систем, выражаемый принципом координации. Принцип координации приводит к принципу максимума полезной информации, генерируемой системой в течение одного полного технологического цикла:

I

![]() max

при

I0

=

const

,

IТ

=

const

max

при

I0

=

const

,

IТ

=

const

где I - объём генерируемой полезной информации, I0- объём перерабатываемой в процессе генерации информации, IТ - объём материализованной в данной системе информации. Приведём выражение, связывающее объём выходной информации с объёмом информации, перерабатываемой в процессе выполнения технологического цикла:

exp

![]() =

=

![]() exp

exp![]() +

+

![]() (6)

(6)

где

![]() -

среднеквадратичная погрешность

фиксации выходной переменной у,

обусловленная неопределённостью

неконтролируемых компонент вектора

входных переменных х,

n - число

управляемых компонент вектора х,

Ik

-

объём информации, перерабатываемой

системой относительно

k-ой компоненты

вектора х

:

-

среднеквадратичная погрешность

фиксации выходной переменной у,

обусловленная неопределённостью

неконтролируемых компонент вектора

входных переменных х,

n - число

управляемых компонент вектора х,

Ik

-

объём информации, перерабатываемой

системой относительно

k-ой компоненты

вектора х

:

Ik

= ln

![]()

![]()

![]() -

среднеквадратические погрешности

фиксации

k-ой

компоненты

вектора х

в начальный момент и в текущий

соответственно,

hk

=

-

среднеквадратические погрешности

фиксации

k-ой

компоненты

вектора х

в начальный момент и в текущий

соответственно,

hk

=

где

у

- выходная координата системы хk

![]() X.

X.

Уравнение информационных обменов может быть представлено в более удобном виде:

exp

![]() =

=

![]() (7)

(7)

С учётом (7) принцип максимума полезной информации может быть записан в виде:

exp

![]() =

=

![]()

![]()

Решение этой системы позволяет определить оптимальные значения информационных переменных Ik, а значит и оптимально необходимые уровни неопределённости фиксации переменных хk

![]() +

ln hk

-

+

ln hk

-

![]() hk

ln

hk

(8)

hk

ln

hk

(8)

Для величины I будет справедливо:

exp

![]() = exp

= exp![]()

Поведение

величины

I при I![]() показано на рис.12.

Из рисунка

видно, что

величина объёма полезной информации

стремится к конечному пределу, т.е.

очевидно, что при достаточно большом

объёме информации I0

его дальнейшее увеличение нецелесообразно.

показано на рис.12.

Из рисунка

видно, что

величина объёма полезной информации

стремится к конечному пределу, т.е.

очевидно, что при достаточно большом

объёме информации I0

его дальнейшее увеличение нецелесообразно.

Рис.12.Поведение

![]()

![]() ghbШIШ

ghbШIШ![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

Ограничимся изложенным, и вопросы кодирования, оценки энтропии непрерывных сообщений, скорости передачи, пропускной способности канала, избыточности информации оставим для специальных курсов.

Заключая этот раздел , сделаем следующие выводы:

1. Мерой информации является вероятностная оценка неопределённости.

2. Количество информации неотрицательно и стремится к конечному пределу.

3 Информация должна обладать характеристиками, позволяющими ЛПР принимать управляющие решения