- •«Мати»-Российский государственный технологический университет имени к.Э.Циолковского (мати)

- •Оглавление

- •Глава 1. Нейронные Сети 7

- •Глава 2. Самоорганизующиеся карты 23

- •Глава 3. Описание работы системы 45

- •Введение

- •Актуальность задачи

- •Глава 1. Нейронные Сети Нейронные сети

- •Искусственный нейрон и его биологический прототип

- •Аналогия с мозгом

- •Биологический нейрон

- •Зрительное и пространственное воображение

- •Глава 2. Самоорганизующиеся карты Основы теории

- •MnSom из mlp-модулей

- •Обобщенная теория mnSom

- •Как избежать локальных минимумов

- •Базовая версия

- •Связь между mnSom и som

- •Глава 3. Описание работы системы Работа сети и алгоритм

- •Модель движения в MathLab

- •Заключение

- •Список литературы

Глава 3. Описание работы системы Работа сети и алгоритм

-

Инициализация

-

Присваивание вектору веса значение случайного наблюдения из входных данных.

-

-

Цикл

Пусть t — номер итерации (инициализация соответствует номеру 0).

-

Выбрать произвольное наблюдение x(t) из множества входных данных.

-

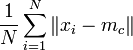

Найти расстояния от него до векторов веса всех узлов карты и определить ближайший по весу узел Mc(t). Это — BMU или Winner. Условие на Mc(t):

![]() ,

,

для любого mi(t), где mi(t) — вектор веса узла Mi(t). Если находится несколько узлов, удовлетворяющих условию, BMU выбирается случайным образом среди них.

-

Определить с помощью функции h (функции соседства) соседей Mi и изменение их векторов веса.

-

Задание h

-

Функция определяет "меру соседства" узлов Mi и Mc и изменение векторов веса. Она должна постепенно уточнять их значения, сначала у большего количества узлов и сильнее, потом у меньшего и слабее. Часто в качестве функции соседства используется гауссовская функция:

![]()

где 0 < α(t) < 1 — обучающий сомножитель, монотонно убывающий с каждой последующей итерацией (то есть определяющий приближение значения векторов веса BMU и его соседей к наблюдению; чем больше шаг, тем меньше уточнение);

ri, rc — координаты узлов Mi(t) и Mc(t) на карте;

σ(t) — сомножитель, уменьшающий количество соседей с итерациями, монотонно убывает.

Параметры α, σ и их характер убывания задаются аналитиком.

Более простой способ задания функции соседства:

hci(t) = α(t),

если Mi(t) находится в окрестности Mc(t) заранее заданного аналитиком радиуса, и 0 в противном случае.

Функция h(t) равна α(t) для BMU и уменьшается с удалением от BMU.

-

Изменение векторов веса

Изменить вектор веса по формуле:

![]()

Т.о. вектора веса всех узлов, являющихся соседями BMU, приближаются к рассматриваемому наблюдению.

-

Вычисление ошибки карты

Например, как среднее арифметическое расстояний между наблюдениями и векторами веса соответствующих им BMU:

где N - количество элементов набора входных данных.

Привлекательные черты обработки информации в искусственных нейронных сетях:

-

Параллелизм обработки информации – глобальность связей между нейронами. До обучения эти связи произвольны, но обучение на примерах «проявляет» конкретную структуру сети под конкретную задачу.

-

Высокая скорость. Она возможна вследствие внутреннего параллелизма сети и простой реализации в виде быстродействующих электронных микросхем.

-

Единый и эффективный принцип обучения нейронных сетей – минимизация эмпирической ошибки методом ее обратного распространения по сети. Извне задаются лишь цель обучения – то есть способ определения ошибки по выходам сети. Далее сеть постепенно модифицирует свою конфигурацию, минимизируя эту ошибку, то есть, все лучше справляясь с возложенной на нее задачей.

-

Надежность функционирования. Избыточность связей приводит к тому, что значения каждого веса по отдельности не играют решающей роли. Вывод из строя ограниченного числа нейронов или обрыв некоторых связей не сказываются критическим образом на качестве работы всей сети. В обычных компьютерах такие неисправности приводят к полному выходу из строя.

-

Способность решать неформализованные задачи – следует из способности нейронной сети самостоятельно вырабатывать весьма сложные алгоритмы обработки данных, формализовать которые самостоятельно зачастую не могут даже лучшие эксперты в данной предметной области. Отсюда – относительная дешевизна нейросетевых разработок.

-

Перепрограммируемость. Нейронные схемы легко адаптируются к новым условиям экспериментов.

К недостаткам нейронных сетей можно отнести их скрытный характер функционирования, т.к. иногда бывает трудно понять критерии, которые искусственная нейронная сеть использует при работе.