- •1 Роль связи в управлении железнодорожным транспортом. Виды связи, применяемые на железнодорожном транспорте.

- •2 Обобщенная структурная схема системы передачи информации, назначение блоков, принцип работы.

- •3 Классификация сигналов. Математические модели сигналов и их характеристики.

- •4 Энергия и мощность сигнала

- •5 Спектральный анализ периодических сигналов. Условия Дирихле. Ряд Фурье.

- •6 Спектральный анализ непериодических сигналов. Преобразование Фурье. Равенство Парсеваля.

- •7 Представление непрерывных сигналов выборками. Теорема Котельникова. Влияние частоты дискретизации на возможность восстановления сигнала с помощью фильтра.

- •8 Процесс интерполяции непрерывного сообщения. Простейшие виды интерполяции алгебраическими полиномами.

- •9 Корреляционный анализ. Корреляционная функция, ее свойства. Вычисление корреляционной функции одиночного импульса и периодического сигнала

- •10 Взаимная корреляционная функция, ее свойства. Вычисление взаимной корреляционной функции сигналов

- •11 Случайные процессы. Реализация случайного процесса. Законы распределения случайных процессов

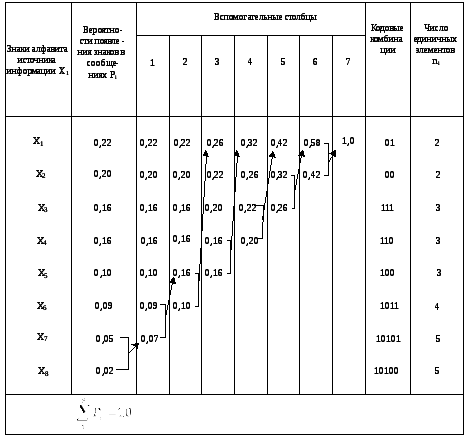

- •12 Статистическое кодирование. Кодирование алфавита источника информации кодом Фано-Шеннона и Хаффмена. Избыточность, коэффициент сжатия и информативность сообщений

- •13 Помехоустойчивое кодирование. Повышение верности в одностороннем и двустороннем каналах передачи

- •14 Блочные систематические коды, свойства и способы представления

- •15 Коды Хэмминга, свойства. Структурная схема кодера и декодера, принцип работы

- •16 Общие свойства и способы представления циклических кодов.

- •18 Аналоговые виды модуляции. Амплитудная модуляция. Амплитудно-модулированное колебание, временная и спектральная характеристики

- •19 Аналоговые виды модуляции. Амплитудный модулятор.

- •20 Аналоговые виды модуляции. Демодулятор ам-сигналов.

- •21. Аналоговые виды модуляции. Балансная модуляция. Балансно-модулированное колебание, временная и спектральная характеристики. Модулятор и демодулятор бмк.

- •22 Аналоговые виды модуляции. Однополосная модуляция. Методы формирования одной боковой полосы частот ам-колебания.

- •24 Спектры фазо-модулированных и частотно-модулированных колебаний.

- •25 Аналого-импульсные виды модуляции. Амплитудно-импульсная модуляция: аим-1 и аим-2. Модуляторы и демодуляторы аим сигналов.

- •26 Широтно-импульсная модуляция: шим-1 и шим-2. Спектральное представление шим-сигнала. Модуляторы шим-сигналов.

- •27 Фазо-импульсная модуляция. Модуляторы фим-сигналов.

- •28 Частотно-импульсная модуляция. Детекторы чим-сигналов.

- •29 Цифровые виды модуляции. Импульсно-кодовая модуляция. Дискретизация, квантование и кодирование.

- •30 Дифференциальная икм. Структурная схема системы передачи с предсказанием. Структурная схема линейного предсказателя, принцип работы. Адаптивная дифференциальная икм.

- •31 Дельта-модуляция. Принцип формирования сигнала дельта-модуляции. Адаптивная дельта-модуляция.

- •32 Дискретные виды модуляции. Способы двухпозиционной (однократной) модуляции. Позиционность сигнала, кратность модуляции.

- •33 Однократная абсолютная фазовая манипуляция. Фазовый манипулятор.

- •34 Детектор фмн-сигналов.

- •35 Манипулятор однократной относительной фазовой манипуляции.

- •35 Манипулятор однократной относительной фазовой манипуляции.

- •36 Демодулятор сигналов с однократной офмн.

- •38 Принципы построения многоканальных систем передачи. Теоретические предпосылки разделения каналов. Частотное разделение каналов.

- •39 Фазовое разделение каналов. Модулятор и демодулятор сигналов дофмн.

- •40 Временное разделение каналов. Структурная схема многоканальной системы передачи с временным разделением каналов.

- •41 Оптимальный прием сигналов. Задачи и критерии оптимального приема.

- •42 Структурная схема приемника при полностью известных сигналах, принцип работы.

12 Статистическое кодирование. Кодирование алфавита источника информации кодом Фано-Шеннона и Хаффмена. Избыточность, коэффициент сжатия и информативность сообщений

Энтропия источника максимальна и Hмакс = log2k, если знаки равновероятны и независимы. В остальных случаях энтропия Н < 1оg2k. Следовательно, количество информации, приходящееся на один знак, обычно меньше того количества информации, которое мог бы этот знак нести. Иными словами, информационная нагрузка на знак часто оказывается меньше максимально возможной. Степень недоиспользования информационных возможностей сообщения характеризуется избыточностью, то есть наличием в сообщении большего числа знаков, чем это минимально необходимо для передачи определенного количества информации.

Численно

избыточность

x

определяется относительной разностью

максимально возможной и реальной

энтропии:

![]() ,

(16) где отношение

,

(16) где отношение![]() ,

а

,

а![]() (17)

Ксж

– коэффициент сжатия.

(17)

Ксж

– коэффициент сжатия.

Избыточность изменяется от 0 до 1. Ее численное значение показывает, насколько можно сократить объем сообщения без потери информации за счет более рационального использования знаков источника. Причинами избыточности являются неравные вероятности появления знаков на выходе источника и наличие вероятностных связей между ними.

Для

сравнения между собой различных

источников сообщений применяется

система, содержащейся в сообщении,

определяется через изменение энтропии

рассматриваемой системы, обусловленное

получением сообщения:

![]() , (1),

гдеНapr

и Нaps

– соответственно априорная и апостериорная

энтропия системы. Априорная энтропия

полностью характеризуется распределением

вероятностей состояний системы с учетом

статистических связей.

, (1),

гдеНapr

и Нaps

– соответственно априорная и апостериорная

энтропия системы. Априорная энтропия

полностью характеризуется распределением

вероятностей состояний системы с учетом

статистических связей.

Апостериорная энтропия характеризует ту неопределенность системы, которая остается после приема сообщений. Если сообщение однозначно определяет состояние системы, то Нaps = 0, в противном случае Нaps > 0.

Количественной

мерой неопределенности состояния

системы служит энтропия,

которая полностью определяется законом

распределения вероятностей состояний

случайной системы. Если знаки на выходе

К-значного

источника встречаются равновероятно

и взаимонезависимо, то количество

информации, бит/знак, переносимое одним

знаком максимально, определяется из

соотношения

![]() .

Если знакиК

– значного источника встречаются на

выходе неравновероятно и независимо

друг от друга, то энтропия рассчитывается

по формуле

.

Если знакиК

– значного источника встречаются на

выходе неравновероятно и независимо

друг от друга, то энтропия рассчитывается

по формуле

![]() .

.

Код Фано-Шеннона

Кодирование

сообщений, при котором достигается

наибольшая скорость передачи информации,

называется эффективным или статистическим.

Эффективность кодирования тем выше,

чем меньше отличается средняя длина

кодовой комбинации

![]() от величиныH(x)/log2

m,

где m

– основание кода. Задача статистического

кодирования состоит в том, чтобы

преобразовать последовательность

знаков сообщения с избыточностью в

последовательность, не имеющую

избыточности, либо имеющую значительно

меньшую избыточность. Если отдельные

знаки сообщения следуют независимо

друг от друга, то избыточность может

быть уменьшена (или устранена полностью)

при кодировании путем представления

наиболее вероятных знаков сообщения

короткими кодовыми комбинациями, а

менее вероятных – более длинными.

Получаемый при этом код является

неравномерным, кодовые комбинации для

различных знаков имеют разные длины.

от величиныH(x)/log2

m,

где m

– основание кода. Задача статистического

кодирования состоит в том, чтобы

преобразовать последовательность

знаков сообщения с избыточностью в

последовательность, не имеющую

избыточности, либо имеющую значительно

меньшую избыточность. Если отдельные

знаки сообщения следуют независимо

друг от друга, то избыточность может

быть уменьшена (или устранена полностью)

при кодировании путем представления

наиболее вероятных знаков сообщения

короткими кодовыми комбинациями, а

менее вероятных – более длинными.

Получаемый при этом код является

неравномерным, кодовые комбинации для

различных знаков имеют разные длины.

При декодировании на приемной стороне поступающую последовательность необходимо однозначно разделить на кодовые комбинации. Для этого необходимо, чтобы ни одна более короткая комбинация не являлась началом более длинной комбинации (свойство неприводимости). Например, если один из знаков сообщения закодирован двоичным кодом в виде последовательности 01101, то ни один из ее префиксов, то есть 0110, 011, 01 и 0 не должен применяться для кодирования других знаков сообщения.

На возможность такого кодирования, учитывающего статистические свойства сообщений, указал К. Шеннон, а удобный алгоритм кодирования предложил Р. Фано. Алгоритм статистического кодирования Фано-Шеннона заключается в следующем:

1 Подлежащие кодированию знаки сообщений располагаются в порядке убывания вероятностей их появления (таблица 4).

|

Знаки алфавита источника информации хi |

Вероятности знаков в сообщениях Pi |

Единичные элементы кодовых комбинаций |

Кодовые комбинации |

Число единичных элементов ni |

Средняя длина кодовой комбинации

| ||||

|

1 |

2 |

3 |

4 |

5 | |||||

|

x1 |

0,30 |

0 |

1 |

|

|

|

01 |

2 |

|

|

x2 |

0,17 |

0 |

0 |

|

|

|

00 |

2 |

|

|

x3 |

0,15 |

1 |

1 |

1 |

|

|

111 |

3 |

|

|

x4 |

0,12 |

1 |

1 |

0 |

|

|

110 |

3 |

2,74 |

|

х5 |

0,11 |

1 |

0 |

0 |

|

|

100 |

3 |

|

|

х6 |

0,09 |

1 |

0 |

1 |

1 |

|

1011 |

4 |

|

|

х7 |

0,04 |

1 |

0 |

1 |

0 |

1 |

10101 |

5 |

|

|

x8 |

0,02 |

1 |

0 |

1 |

0 |

0 |

10100 |

5 |

|

|

| |||||||||

3 Знаки, входящие в каждую из групп, вновь разбиваются на две группы с примерно равными суммарными вероятностями.

Группе знаков сообщений с большей суммой вероятностей в качестве второго элемента кодовой комбинации приписывается 1, а группе знаков сообщений с меньшей суммой вероятностей – 0.

4 Этот

процесс продолжается, пока в каждой из

групп не останется по одному знаку.

Энтропия данного источника информации

Н

= 2,6948 бит/знак и меньше

![]() = 2,74 ед. элем./знак

(имп./знак).

= 2,74 ед. элем./знак

(имп./знак).

Это

получилось потому, что вероятности

появления знаков на выходе источника

не удовлетворяют условию

![]() .

При невыполнении этого условия разбитие

на строго равномерные группы и подгруппы

невозможно и тогда

.

При невыполнении этого условия разбитие

на строго равномерные группы и подгруппы

невозможно и тогда![]() >Н(х).

Особенно заметным может быть снижение

эффективности статистического кодирования

при небольшом числе знаков и значительном

отличии их вероятностей. В таких случаях

увеличение эффективности достигается

путем кодирования не отдельных знаков,

а укрупненных блоков, которые представляют

собой набор всех возможных комбинаций

из 2, 3 и более знаков.

>Н(х).

Особенно заметным может быть снижение

эффективности статистического кодирования

при небольшом числе знаков и значительном

отличии их вероятностей. В таких случаях

увеличение эффективности достигается

путем кодирования не отдельных знаков,

а укрупненных блоков, которые представляют

собой набор всех возможных комбинаций

из 2, 3 и более знаков.

Код Хаффмена

Статистический

код Хаффмена по своим идеям аналогичен

статистическому коду Фано-Шеннона.

Однако алгоритм кодирования иной. Знаки

алфавита сообщений выписываются в

основной столбец в порядке убывания

вероятностей. Два последних знака

объединяются в один вспомогательный,

которому присваивается суммарная

вероятность. Вероятность знаков, не

участвовавших в объединении, и полученная

суммарная вероятность снова располагаются

в порядке убывания вероятностей во

вспомогательном столбце, а два последних

знака опять объединяются. Процесс

продолжается до тех пор, пока не будет

получен единственный знак с вероятностью,

равной единице (таблица 6).