- •Введение

- •Лекция 1 Симплекс-метод

- •1.1 Общая постановка задачи линейного программирования

- •1.2 Некоторые свойства планов

- •1.3 Алгоритм симплекс-метода

- •Лекция 2 Двойственная задача. Двойственный симплекс-метод. Комбинированный метод решения злп

- •2.1 Постановка двойственной задачи

- •2.2 Основные теоремы о двойственности

- •2.3 Решение двойственных задач

- •2.4 Двойственный симплекс-метод

- •Лекция 3 Анализ чувствительности оптимального решения

- •3.1 Матричное представление симплекс-таблиц

- •Анализ чувствительности

- •3.2.1 Изменения, влияющие на допустимость решения

- •3.2.2 Изменения, влияющие на оптимальность решения

- •Лекция 4 Целочисленное линейное программирование

- •4.1 Метод ветвей и границ

- •4.2 Метод отсекающих плоскостей

- •Лекция 5 Методы решения транспортной задачи

- •5.1 Решение транспортной задачи

- •5.1.1 Постановка транспортной задачи

- •6.1.2 Интерпретация метода потенциалов как симплекс-метода

- •5.1.3 Определение начального решения

- •5.1.4 Метод потенциалов

- •5.2 Задача о назначениях

- •Лекция 6 Введение в нейронные сети

- •6.1 История нейронных сетей

- •6.2 Актуальность нейронных сетей

- •6.3 Свойства нейронных сетей

- •6.4 Классификация нейронных сетей

- •6.5 Представление знаний в нейронных сетях

- •Лекция 7 Биологическая и математическая модель нейрона. Персептрон

- •7.1 Модель нейрона

- •7.2 Функции активации в нейронных сетях

- •1 Единичный скачок или жесткая пороговая функция

- •2 Линейная пороговая функция

- •3 Сигмоидальная функция или сигмоид

- •4 Радиально-базисная функция

- •7.3 Обучение нейронной сети

- •7.4 Персептрон

- •Лекция 8 Алгоритм обратного распространения ошибки

- •8.1 Многослойные нейронные сети. Структура

- •8.2 Вывод основных формул алгоритма обратного распространения ошибки

- •Лекция 9 Рекуррентный метод наименьших квадратов

- •9.1 Применение рекуррентного метода наименьших квадратов для обучения нейронных сетей (rls)

- •Библиографический список

- •Заключение

- •Приложение а

7.2 Функции активации в нейронных сетях

Функция активации

(активационная функция, функция

возбуждения) – функция, вычисляющая

выходной сигнал искусственного нейрона.

В качестве аргумента принимает сигнал

![]() ,

получаемый на выходе входного сумматора

,

получаемый на выходе входного сумматора

![]() .

Результатом будет являться выходной

сигнал нейрона

.

Результатом будет являться выходной

сигнал нейрона ![]() .

Ниже приведен наиболее общий список

функций активации.

.

Ниже приведен наиболее общий список

функций активации.

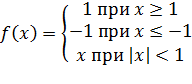

1 Единичный скачок или жесткая пороговая функция

Простая кусочно-линейная функция. Если входное значение меньше порогового, то значение функции активации равно минимальному допустимому, иначе – максимально допустимому (рисунок 7.2).

|

Единичная |

|

|

(7.5) | |

|

Знаковая (биполярная) |

|

|

(7.6) | |

|

|

|

|

| |

|

Единичная |

Знаковая (биполярная) | |||

|

|

| |||

|

Рисунок 7.2 – Единичный скачок или жесткая пороговая функция | ||||

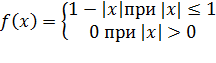

2 Линейная пороговая функция

Несложная кусочно-линейная функция. Имеет два линейных участка, где функция активации тождественно равна минимально допустимому и максимально допустимому значению и есть участок, на котором функция строго монотонно возрастает (рисунок 7.3).

|

Линейная |

|

|

(7.7) | |

|

Линейная с насыщением |

|

|

(7.8) | |

|

Полулинейная |

|

|

(7.9) | |

|

Полулинейная с насыщением |

|

|

(7.10) | |

|

Треугольная |

|

|

(7.11) | |

|

|

|

|

| |

|

Линейная |

Линейная с насыщением | |||

|

|

| |||

|

Полулинейная |

Полулинейная с насыщением | |||

|

|

| |||

|

Треугольная | ||||

|

| ||||

|

Рисунок 7.3 – Линейная пороговая функция | ||||

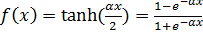

3 Сигмоидальная функция или сигмоид

Монотонно возрастающая всюду дифференцируемая -образная нелинейная функция с насыщением. Сигмоид позволяет усиливать слабые сигналы и не насыщаться от сильных сигналов. Гроссберг (1973 год) обнаружил, что подобная нелинейная функция активации решает поставленную им дилемму шумового насыщения.

Слабые сигналы нуждаются в большом сетевом усилении, чтобы дать пригодный к использованию выходной сигнал. Однако усилительные каскады с большими коэффициентами усиления могут привести к насыщению выхода шумами усилителей, которые присутствуют в любой физически реализованной сети. Сильные входные сигналы в свою очередь также будут приводить к насыщению усилительных каскадов, исключая возможность полезного использования выхода (рисунок 7.4).

|

Логистическая или экспоненциальная сигмоида |

|

(0,1) |

(7.12) |

|

Гиперболический тангенс |

|

(–1,1) |

(7.13) |

|

Рациональная сигмоида |

|

(–1,1) |

(7.14) |

где

![]() – параметр наклона сигмоидальной

функции активации. Изменяя этот

параметр, можно построить функции с

различной крутизной.

– параметр наклона сигмоидальной

функции активации. Изменяя этот

параметр, можно построить функции с

различной крутизной.

|

Логистическая или экспоненциальная сигмоида |

Гиперболический тангенс и рациональная сигмоида |

|

|

|

|

Рисунок 7.4 – Сигмоидальная функция или сигмоид | |

4 Радиально-базисная функция

Этот тип функций принимает в качестве аргумента расстояние между входным значением и некоторым наперед заданным центром активационной функции. Значение этой функции тем выше, чем ближе входной вектор к центру (рис 7.5).

|

Радиально-базисная |

|

(0,1) |

(7.15) |

где![]() – параметр определяет скорость спадания

функции при удалении вектора от центра

и называетсяшириной

окна;

– параметр определяет скорость спадания

функции при удалении вектора от центра

и называетсяшириной

окна; ![]() – параметр определяет сдвиг активационной

функции по оси абсцисс.

– параметр определяет сдвиг активационной

функции по оси абсцисс.

|

Радиально-базисная |

|

|

|

Рисунок 7.5 – Радиально-базисная функция |

В заключение отметим, что функции активации типа единичного скачка и линейного порога встречаются очень редко и, как правило, используются на учебных примерах. В практических задачах почти всегда применяется сигмоидальная функция активации.