- •Введение в операционные системы

- •Часть I. Общие сведения

- •Глава 1. Введение

- •1.1 Что такое операционная система.

- •1.1.1 Структура вычислительной системы

- •1.1.2 Что такое ос

- •1.2 Краткая история эволюции вычислительных систем

- •1.3 Основные понятия, концепции ос.

- •1.4 Классификация ос

- •Часть II. Процессы и их поддержка в операционной системе

- •Глава 2. Процессы

- •2.1. Понятие процесса

- •2.2. Состояния процесса

- •2.3. Операции над процессами и связанные с ними понятия

- •2.3.1. Набор операций

- •2.3.2. Process Control Block и контекст процесса

- •2.3.3. Одноразовые операции

- •2.3.4. Многоразовые операции

- •2.3.5. Переключение контекста

- •Глава 3. Планирование процессов

- •3.1. Уровни планирования

- •3.2. Критерии планирования и требования к алгоритмам

- •3.3. Параметры планирования

- •3.4. Вытесняющее и невытесняющее планирование

- •3.5. Алгоритмы планирования

- •3.5.1. First-Come, First-Served (fcfs)

- •3.5.2. Round Robin (rr)

- •3.5.3. Shortest-Job-First (sjf)

- •3.5.5. Приоритетное планирование

- •3.5.6. Многоуровневые очереди с обратной связью (Multilevel Feedback Queue)

- •Глава 4. Кооперация процессов и основные аспекты ее логической организации

- •4.1. Взаимодействующие процессы

- •4.2. Категории средств обмена информацией

- •4.3. Потоки исполнения

- •Глава 5. Алгоритмы синхронизации

- •5.1. Interleaving, race condition и взаимоисключения

- •5.2. Критическая секция

- •5.3. Программные алгоритмы организации взаимодействия процессов 5.3.1. Требования, предъявляемые к алгоритмам

- •5.3.2. Запрет прерываний

- •5.3.3. Переменная-замок

- •5.3.4. Строгое чередование

- •5.3.5. Флаги готовности

- •5.3.6. Алгоритм Петерсона

- •5.3. Аппаратная поддержка взаимоисключений

- •5.3.1. Команда Test-and-Set (Проверить и присвоить 1)

- •6.1. Семафоры

- •6.1.1. Концепция семафоров

- •6.1.2. Решение проблемы producer-consumer с помощью семафоров

- •6.2. Мониторы

- •Глава 7. Тупики

- •7.1 Введение

- •7.2 Концепция ресурса

- •7.3 Условия возникновения тупиков

- •7.4 Основные направления борьбы с тупиками.

- •7.5 Алгоритм страуса

- •7.6 Обнаружение тупиков

- •7.7 Восстановление после тупиков

- •7.7.1 Восстановление при помощи перераспределения ресурсов

- •7.7.2 Восстановление через откат назад

- •7.7.3 Восстановление через ликвидацию одного из процессов

- •7.8 Способы обхода тупиков путем тщательного распределения ресурсов.

- •7.8.1 Алгоритм банкира.

- •7.8.2 Недостатки алгоритма банкира

- •7.9 Предотвращение тупиков за счет нарушения условий возникновения тупиков.

- •7.9.1 Нарушение условия взаимоисключения

- •7.9.2 Hарушение условия ожидания дополнительных ресурсов

- •7.9.3 Нарушение принципа неперераспределяемости.

- •7.9.4 Нарушение условия кругового ожидания

- •7.10 Заключение.

- •Часть III. Управление памятью.

- •Глава 8. Введение. Простейшие схемы управления памятью.

- •8.1 Введение.

- •8.2 Связывание адресов.

- •8.3 Простейшие схемы управления памятью.

- •8.3.1 Схема с фиксированными разделами.

- •8.3.2 Свопинг

- •8.3.3 Мультипрограммирование с переменными разделами.

- •Глава 9. Виртуальная память. Архитектурные средства поддержки виртуальной памяти

- •9.1 Проблема размещения больших программ. Понятие виртуальной памяти.

- •9.2 Архитектурные средства поддержки виртуальной памяти.

- •9.2.1 Страничная память

- •9.2.2 Сегментная и сегментно-страничная организации памяти

- •9.2.3 Таблица страниц

- •9.2.4 Ассоциативная память.

- •9.2.5 Иерархия памяти

- •9.2.6 Размер страницы

- •Глава 10. Аппаратно-независимый уровень управления виртуальной памятью

- •10.1 Исключительные ситуации при работе с памятью.

- •10.2 Стратегии управления страничной памятью

- •10.3 Алгоритмы замещения страниц

- •10.3.1 Fifo алгоритм. Выталкивание первой пришедшей страницы.

- •10.3.2 Оптимальный алгоритм

- •10.3.3 Выталкивание дольше всего не использовавшейся страницы. Lru (The Least Recently Used) Algorithm .

- •10.3.4 Выталкивание редко используемой страницы. Nfu (Not Frequently Used) алгоритм.

- •10.3.5 Другие алгоритмы

- •10.4. Thrashing. Свойство локальности. Модель рабочего множества.

- •Часть IV. Файловые системы

- •Глава 11. Файлы с точки зрения пользователя

- •11.1 Введение

- •11.3 Структура файлов

- •11.4 Типы и атрибуты файлов

- •11.5 Доступ к файлам

- •11.6 Операции над файлами.

- •11.7 Директории. Логическая структура файлового архива.

- •11.8 Операции над директориями

- •11.9 Защита файлов.

- •11.9.1 Контроль доступа к файлам

- •11.9.2 Списки прав доступа

- •Глава 12. Реализация файловой системы

- •12.1 Интерфейс файловой системы.

- •12.2 Общая структура файловой системы

- •12.3 Структура файловой системы на диске.

- •12.3.1 Методы выделения дискового пространства

- •12.3.2 Управление свободным и занятым дисковым пространством.

- •12.3.3 Размер блока

- •12.4 Надежность файловой системы.

- •12.4.1 Целостность файловой системы.

- •12.4.2 Управление плохими блоками.

- •12.5 Производительность файловой системы

- •Часть V. Ввод-вывод

- •Глава 13. Система управления вводом-выводом

- •13.1 Физические принципы организации ввода-вывода.

- •13.1.1. Общие сведения об архитектуре компьютера.

- •13.1.2. Структура контроллера устройства.

- •13.1.3. Опрос устройств и прерывания. Исключительные ситуации и системные вызовы

- •13.1.4. Прямой доступ к памяти (Direct Memory Access – dma).

- •13.2. Логические принципы организации ввода-вывода.

- •13.2.1. Структура системы ввода-вывода.

- •13.2.2. Систематизация внешних устройств и интерфейс между базовой подсистемой ввода-вывода и драйверами.

- •13.2.3. Функции базовой подсистемы ввода-вывода.

- •13.2.3.1. Блокирующиеся, не блокирующиеся и асинхронные системные вызовы.

- •13.2.3.2. Буферизация и кэширование.

- •13.2.3.3. Spooling и захват устройств.

- •13.2.3.4. Обработка прерываний и ошибок.

- •13.2.3.5. Планирование запросов.

10.3.4 Выталкивание редко используемой страницы. Nfu (Not Frequently Used) алгоритм.

Другое название этого алгоритма - LFU (The Least Frequently Used).

Программная реализация алгоритма, близкого к LRU.

Рассмотренные варианты LRU в принципе реализуемы, но, как уже отмечалось, они требуют специальной аппаратной поддержки, которой большинство современных процессоров не предоставляет. Поэтому хотелось бы иметь алгоритм, достаточно близкий к LRU, но не требующий сложной специальной поддержки.

Один из таких возможных алгоритмов - это алгоритм NFU.

Для него требуются программные счетчики, по одному на каждую страницу, которые сначала равны нулю. При каждом прерывании по времени (а не после каждой инструкции) операционная система сканирует все страницы в памяти и у каждой страницы с установленным флагом обращения увеличивает на единицу значение счетчика, а флаг обращения сбрасывает.

Таким образом, кандидатом на освобождение оказывается страница с наименьшим значением счетчика, как страница, к которой реже всего обращались. Главным недостатком алгоритма NFU является то, что он никогда ничего не забывает. Например, страница, к которой очень много обращались некоторое время, а потом обращаться перестали, все равно не будет удалена из памяти, потому что ее счетчик содержит большую величину. Например, в многопроходных компиляторах страницы, которые активно использовались во время 1-го прохода, могут надолго сохранить большие значения счетчика, мешая загрузке полезных в дальнейшем страниц.

К счастью, возможна небольшая модификация алгоритма, которая реализует "забывание". Достаточно, чтобы при каждом прерывании по времени содержимое каждого счетчика сдвигалось вправо на 1 бит, а уже затем производилось бы его увеличение для страниц с установленным флагом обращения (рис. 3-27 Таненбаум).

Другим, уже не так просто устранимым недостатком алгоритма является длительность процесса сканирования таблиц страниц.

10.3.5 Другие алгоритмы

Для полноты картины можно упомянуть еще несколько алгоритмов.

Например, алгоритм Second-Chance - модификации FIFO, которая позволяет избежать потери часто используемых страниц - анализ бита r (reference) для самой старой страницы. Если бит 1, то страница в отличие от FIFO не выталкивается, а очищается бит и страница становится в конец очереди. Если на все страницы ссылались, он превращается в FIFO. Данный алгоритм использовался в BSD Unix.

В компьютере Макинтош использован алгоритм NRU(Not Recently-Used), где страница жертва выбирается на основе анализа битов модификации и ссылки.

Имеется также и много других алгоритмов замещения. Объем этого курса не позволяет рассмотреть их подробно. Подробное описание различных алгоритмов замещения имеется в монографиях Дейтела, Цикритиса, Таненбаума и др.

10.4. Thrashing. Свойство локальности. Модель рабочего множества.

Что делать, если в распоряжении процесса имеется недостаточное число кадров? Следует ли его приостановить с освобождением всех его кадров. Что нужно понимать под достаточным количеством кадров?

Хотя теоретически возможно уменьшить число кадров процесса до минимума, существует какое-то число активно используемых страниц, без которого процесс часто генерирует faltы. Эта высокая частота страничных нарушений называется трешинг (trashing, иногда употребляется русский термин пробуксовка). Процесс находится в состоянии трешинга, если он больше времени занимается подкачкой страниц, нежели выполнением. Критическая ситуация такого рода возникает вне зависимости от конкретных алгоритмов замещения.

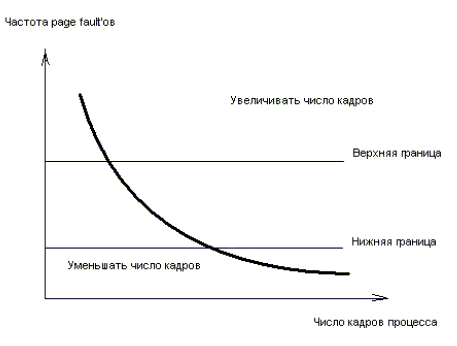

Рис. 10.2 Частота page fault'ов

Часто результатом трешинга является снижение производительности. Один из нежелательных сценариев развития событий может выглядеть следующим образом. При глобальном алгоритме замещения, процесс, которому не хватает кадров, начинает отбирать их у других процессов, а те в свою очередь начинают заниматься тем же. В результате все процессы попадают в очередь запросов к устройству вторичной памяти, а очередь процессов в состоянии готовности пустеет. Загрузка процессора снижается. Процессор видит это и увеличивает степень мультипрограммирования. Таким образом, пропускная способность системы падает из-за трешинга.

Эффект трешинга, возникающий при использовании глобальных алгоритмов, может быть ограничен за счет использования локальных алгоритмов замещения. Если даже один из процессов попал в трешинг, это не сказывается на других процессах. Однако он много времени проводит в очереди к устройству выгрузки, затрудняя подкачку страниц остальных процессов.

Критическая ситуация типа трешинга возникает вне зависимости от конкретных алгоритмов замещения. Единственным алгоритмом, теоретически гарантирующим отсутствие thrashing, является рассмотренный выше не реализуемый на практике оптимальный алгоритм.

Итак, трешинг - высокая частота страничных нарушений. Необходимо ее контролировать. Когда она высока, процесс нуждается в кадрах. Можно, устанавливая желаемую частоту fault'ов, регулировать размер процесса, добавляя или отнимая у него кадры. Как и в случае с рабочим множеством (см. ниже) может оказаться целесообразным придержать процесс, освободив его кадры. Освободившиеся кадры выделяются другим процессам с высокой частотой fault'ов.

Для предотвращения трешинга нужно выделить процессу столько кадров, сколько ему нужно. Но как узнать, сколько ему нужно. Существует несколько подходов. Необходимо попытаться выяснить, как много кадров процесс реально использует. Этот подход определяет модель локальности выполнения процесса.

Концепция локальности

Суть концепции локальности изложена во введении. Изучая свойства локальности в пейджинговых системах, Деннинг (1968) сформулировал теорию рабочего множества программ (см. ниже).

Модель локальности состоит в том, что когда процесс выполняется, он двигается от одной локальности к другой. Локальность - набор страниц, которые активно используются вместе. Программа обычно состоит из нескольких различных локальностей, которые могут перекрываться. Например, когда вызвана процедура, она определяет новую локальность, состоящую из инструкций процедуры, ее локальных переменных, и множества глобальных переменных. После ее завершения процесс оставляет эту локальность, но может вернуться к ней вновь. Таким образом, локальность определяется кодом и данными программы. Заметим, что модель локальности - принцип, положенный в основу работы кэша. Если бы доступ к любым типам данных был случайным, кэш был бы бесполезным.

Если процессу выделять меньше кадров, чем ему нужно для поддержки его локальности он будет находиться в состоянии трешинга.

Модель рабочего множества (Working Set)

В варианте чистого пейджинга процессы стартуют без необходимых страниц в памяти. Первая же машинная инструкции генерирует page fault. Другой page fault происходит при локализации глобальных переменных и тут же при выделении памяти для стека. После того как процесс собрал большинство страниц, page fault'ы далее редки. Эта все происходит в соответствии с выборкой по запросу (требованию) в отличие от выборки с упреждением. Конечно, легко написать тестовую программу, которая систематически работает с большим адресным пространством. К счастью, большинство процессов не ведут себя подобным образом, а проявляют свойство локальности. В течение любой фазы вычислений процесс работает с небольшим количеством страниц. Этот набор называется рабочим множеством. (Denning 1968,1980).

В некотором смысле предложенный Деннингом подход является практически реализуемой аппроксимацией оптимального алгоритма (см. также [28]. Принцип локальности ссылок (недоказуемый, но подтверждаемый на практике) состоит в том, что если в период времени (T-t, T) программа обращалась к страницам (P1, P2, ..., Pn), то при надлежащем выборе t с большой вероятностью эта программа будет обращаться к тем же страницам в период времени (T, T+t). Другими словами, принцип локальности утверждает, что если не слишком далеко заглядывать в будущее, то можно хорошо его прогнозировать исходя из прошлого. Набор страниц (P1, P2, ..., Pn) и есть рабочее множество программы (или, правильнее, соответствующего процесса) в момент времени T. Понятно, что с течением времени рабочий набор процесса может изменяться (как по составу страниц, так и по их числу).

Идея алгоритма подкачки Деннинга (иногда называемого алгоритмом рабочих наборов) состоит в том, что операционная система в каждый момент времени должна обеспечивать наличие в основной памяти текущих рабочих наборов всех процессов, которым разрешена конкуренция за доступ к процессору. Полная реализация алгоритма Деннинга практически гарантирует отсутствие thrashing. Алгоритм реализуем (известна, по меньшей мере, одна его полная реализация, которая, однако, потребовала специальной аппаратной поддержки). На практике применяются облегченные варианты алгоритмов подкачки, основанных на идее рабочего набора.